OpenAI租用谷歌TPU:算力布局調整,首次嘗試非“英偉達”芯片

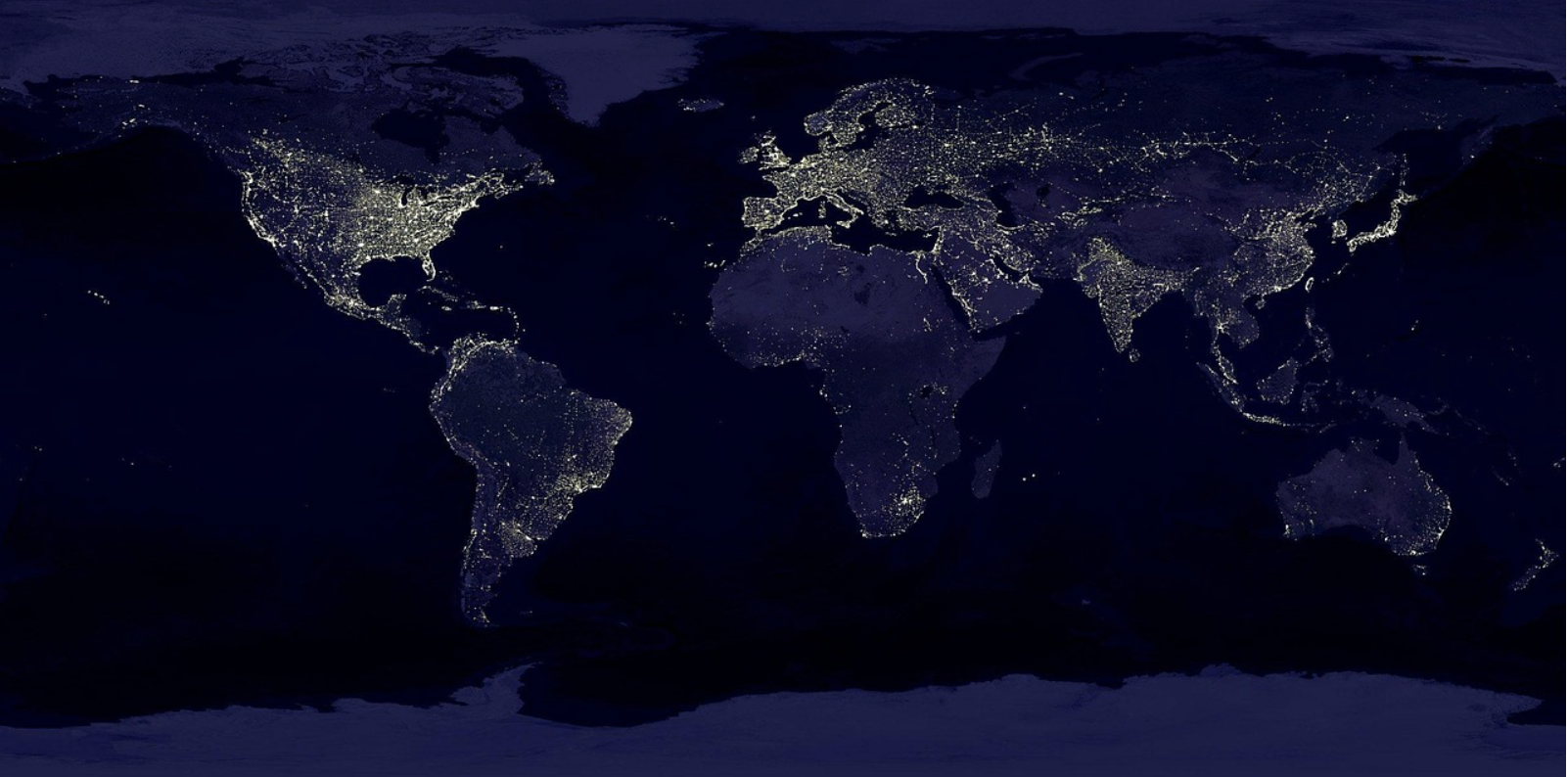

近日消息,OpenAI首次使用“非英偉達”芯片,租用谷歌TPU,以降低推理計算成本并減少對微軟數據中心的依賴。這一舉措標志著OpenAI在算力布局上的戰略調整,也反映了其在AI芯片市場中逐步擺脫對英偉達的依賴。

OpenAI長期以來一直是英偉達GPU的重要客戶,用于模型訓練和推理任務。然而,隨著AI模型的復雜性增加,以及對算力需求的激增,OpenAI在微軟的推理服務器上面臨巨大壓力。特別是ChatGPT圖像生成工具的爆紅,使得OpenAI在推理計算上的成本大幅上升。

據悉,OpenAI去年在服務器上的支出超過40億美元,其中訓練和推理成本各占一半,預計2025年在AI芯片服務器上的支出將接近140億美元。因此,OpenAI尋求更高效、更經濟的算力解決方案。

谷歌TPU的引入是OpenAI降低推理成本的重要舉措。谷歌TPU在能效比方面具有優勢,尤其在大規模并行計算任務中,單位算力成本更低。此外,通過引入異構算力架構,OpenAI正逐步降低對微軟云基礎設施的依賴,這不僅有助于分散供應鏈風險,也為未來可能的云服務商切換預留了空間。

盡管存在競爭關系,谷歌仍與OpenAI合作,以推動TPU的商業化進程。不過,谷歌并未向OpenAI提供其最高性能的TPU。谷歌云員工透露,谷歌保留了最強大的TPU用于內部開發,如Gemini模型。

除了OpenAI,蘋果、Safe Superintelligence和Cohere等公司也一直租用谷歌云的TPU,部分原因是這些公司的一些員工曾在谷歌工作,熟悉TPU的運作方式。此外,據知情人士透露,同樣是全球最大AI芯片客戶之一的Meta近期也考慮使用TPU。

這一趨勢表明,越來越多的科技公司正在尋找替代英偉達的解決方案,以降低對英偉達芯片的依賴并減少成本。而TPU的設計目標是為深度學習任務提供更高效的計算能力,尤其在大規模語言模型和推薦系統的訓練中表現出色。

OpenAI此次租用谷歌TPU,不僅是對算力成本的優化,更是其在AI芯片市場中尋求多元化的重要一步。通過引入非英偉達芯片,OpenAI有望提升谷歌TPU的知名度,使其成為英偉達GPU的經濟高效替代方案。這表明OpenAI正在逐步擺脫對微軟的依賴,轉向更廣泛的云基礎設施。

此外,OpenAI還計劃在未來幾個月內完成首款自研AI芯片的設計,并計劃送往臺積電進行制造。這一芯片將采用臺積電先進的3納米工藝,具備高帶寬內存和廣泛的網絡功能,旨在減少對英偉達芯片的依賴。

OpenAI的這一系列舉措,不僅反映了其在AI芯片領域的野心,也預示著AI算力基礎設施的進一步多元化和競爭格局的重塑。

*博客內容為網友個人發布,僅代表博主個人觀點,如有侵權請聯系工作人員刪除。