如何使用SAS Switch 技術(shù)(第二部分優(yōu)化服務(wù))

共享啟動(dòng)盤的服務(wù)

本文引用地址:http://www.104case.com/article/283643.htm在基于SAS Switch的硬件構(gòu)架之上易于實(shí)現(xiàn)一系列的優(yōu)化服務(wù)。比如共享啟動(dòng)盤的管理。在機(jī)群上的每個(gè)服務(wù)器都需要一個(gè)裝有該機(jī)器應(yīng)該運(yùn)行的操作系統(tǒng)的盤卷,此外通常還需要提供虛存對(duì)換空間以及根文件系統(tǒng)。前者作為操作系統(tǒng)的軟件映像通常是只讀的,且在大型數(shù)據(jù)中心中,不同機(jī)器之間采用重復(fù)的操作系統(tǒng)的映像的可能性很高。后者通常需要可寫,并且機(jī)器之間共享的可能性不大,但后者通常所需的空間較小。要為成百上千的服務(wù)器結(jié)點(diǎn)管理這些盤卷,既需要硬件成本,又是個(gè)運(yùn)維的負(fù)擔(dān)。提供低成本,便利,有可靠的啟動(dòng)盤卷服務(wù),是一個(gè)有價(jià)值的挑戰(zhàn)。

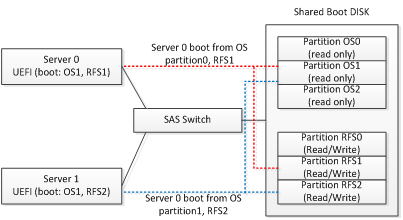

有了SAS Switch我們可以試圖在物理盤的層次支持共享啟動(dòng)盤卷的。 采用把一個(gè)(或采用一對(duì)共享盤來提供熱備份)高性能的盤(例如SAS SSD) 在物理上創(chuàng)建多個(gè)分區(qū)。可有兩類分區(qū),第一類存放共享的操作系統(tǒng)的靜態(tài)映像,不同分區(qū)對(duì)應(yīng)于機(jī)群上可能要使用的不同的操作系統(tǒng)版本,第二類分區(qū),是用于存放單臺(tái)機(jī)器的根文件系統(tǒng),因此需要為每臺(tái)單獨(dú)服務(wù)器創(chuàng)建一個(gè)根文件系統(tǒng)分區(qū)。把這個(gè)共享啟動(dòng)盤連接到SAS Switch的拓?fù)渖希缓罂赏ㄟ^SAS Switch 把該盤共享給所有需要通過它來啟動(dòng)的服務(wù)器結(jié)點(diǎn)。在服務(wù)器側(cè),需要安裝一個(gè)UEFI BIOS應(yīng)用,用以負(fù)責(zé)接受SAS Switch的管理配置(包括使用SAS Switch所指定的盤,特定分區(qū)上找到操作系統(tǒng)映像,并用另一個(gè)所指定的分區(qū)上找到根文件系統(tǒng))來進(jìn)行物理服務(wù)器的啟動(dòng)操作。

在上圖所展示的例子中,兩臺(tái)服務(wù)器(server 0, server 1)通過SAS Switch共享了一個(gè)啟動(dòng)盤。 其中服務(wù)器0 采用了OS分區(qū)1上的操作系統(tǒng),并把自己的根文件系統(tǒng)放在私有的RFS1分區(qū)上,而服務(wù)器1同樣采用了OS分區(qū)1上的操作系統(tǒng),而把根文件系統(tǒng)放在了私有的RFS2分區(qū)上,因此兩太服務(wù)器在運(yùn)行時(shí)不會(huì)互相干擾。

這樣的簡單方法,會(huì)導(dǎo)致系統(tǒng)的可靠性下降。如果共享的啟動(dòng)盤發(fā)生硬件故障,會(huì)導(dǎo)致整個(gè)機(jī)群的不能啟動(dòng)。可以通過在系統(tǒng)中配置兩個(gè)或多個(gè)共享啟動(dòng)盤來提高系統(tǒng)可靠性。比如通過SAS Switch為每臺(tái)服務(wù)器結(jié)點(diǎn)配置3個(gè)共享啟動(dòng)盤以及在啟動(dòng)盤上的相應(yīng)分區(qū)。在服務(wù)器的UEFI 啟動(dòng)應(yīng)用上,當(dāng)發(fā)現(xiàn)第一個(gè)啟動(dòng)盤正常工作時(shí),切換到使用第二或第三個(gè)啟動(dòng)盤。并且還需要把3個(gè)共享啟動(dòng)盤安裝在不同的故障域內(nèi)(例如:位于不同的JBOD當(dāng)中,甚至在不同的機(jī)架中)。這樣,單個(gè)共享啟動(dòng)盤的故障不會(huì)導(dǎo)致整個(gè)機(jī)群的故障。

采用共享的啟動(dòng)盤,除了可以消除每臺(tái)服務(wù)器內(nèi)安裝兩個(gè)啟動(dòng)盤的成本,還帶來其他運(yùn)維上的便利性。操作系統(tǒng)和應(yīng)用的升級(jí)可以通過在共享的啟動(dòng)盤上更新操作系統(tǒng)映像分區(qū)的數(shù)據(jù)來完成,而不需要對(duì)每臺(tái)服務(wù)器結(jié)點(diǎn)的映像進(jìn)行逐一更新。而當(dāng)服務(wù)器結(jié)點(diǎn)硬件發(fā)生故障時(shí),只需更新服務(wù)器,而不需重新安裝操作系統(tǒng)和軟件。這些可在大規(guī)模數(shù)據(jù)中心中節(jié)約大量的運(yùn)維成本。

動(dòng)態(tài)業(yè)務(wù)的彈性遷移和保護(hù)

在一個(gè)SAS Switch構(gòu)成的域內(nèi)由于所有服務(wù)器結(jié)點(diǎn)都能訪問到所有存儲(chǔ)資源,這為動(dòng)態(tài)業(yè)務(wù)的彈性遷移和保護(hù)提供了基礎(chǔ)。

以一個(gè)Hadoop大數(shù)據(jù)分析的業(yè)務(wù)機(jī)群為例。 在該例子中,初始配置了10臺(tái)服務(wù)器和20個(gè)數(shù)據(jù)盤。每個(gè)服務(wù)器上分配了2個(gè)HDFS數(shù)據(jù)盤。通過機(jī)群管理系統(tǒng)對(duì)系統(tǒng)的運(yùn)行狀態(tài)進(jìn)行性能評(píng)測(cè)和監(jiān)控,這包括了動(dòng)態(tài)測(cè)量每臺(tái)服務(wù)器的CPU使用效率,IOPS, 帶寬等,并且對(duì)每個(gè)盤的IOPS和帶寬也進(jìn)行檢測(cè)。動(dòng)態(tài)檢測(cè)的結(jié)果發(fā)現(xiàn)Hadoop結(jié)點(diǎn)上CPU的使用效率只有18%。 管理調(diào)度層 (通過人工干預(yù)或自動(dòng)調(diào)度的策略)決定對(duì)該Hadoop 機(jī)群進(jìn)行資源的重新配置,并決定把計(jì)算服務(wù)器結(jié)點(diǎn)減少到2個(gè),并把原有的20個(gè)HDFS數(shù)據(jù)盤重新分配到剩余的2個(gè)服務(wù)器上,每個(gè)服務(wù)器接管10個(gè)HDFS 數(shù)據(jù)盤。新的資源配置通過管理接口配置到SAS Switch上。這個(gè)重新配置可在Hadoop業(yè)務(wù)在線的情況下完成。被釋放的8個(gè)空閑的CPU可重新分配給機(jī)群上的其他業(yè)務(wù)使用。即使在沒有其他業(yè)務(wù)可利用這8個(gè)CPU的情況下,也可以把把它們?cè)O(shè)置到睡眠等節(jié)省電能的狀態(tài)。而剩余的2個(gè)CPU在重新配置完成后繼續(xù)執(zhí)行原有的Hadoop計(jì)算業(yè)務(wù)。重新配置后剩余的CPU可基本達(dá)到接近100%的利用效率。

對(duì)需要高可靠性的業(yè)務(wù),也可通過SAS Switch實(shí)現(xiàn)業(yè)務(wù)保障。例如采用1:1或N:1的保護(hù)倒換的方法,在一個(gè)服務(wù)器結(jié)點(diǎn)發(fā)生故障時(shí),把該結(jié)點(diǎn)承擔(dān)的業(yè)務(wù)調(diào)度到機(jī)群內(nèi)一個(gè)空閑的服務(wù)器結(jié)點(diǎn),并且把原有分配給發(fā)生故障的服務(wù)器的存儲(chǔ)資源重新分配給替換的服務(wù)器結(jié)點(diǎn),這樣的動(dòng)態(tài)替換可在業(yè)務(wù)在線的情況下完成,從而保證業(yè)務(wù)的持續(xù)性。

超融合存儲(chǔ)

目前存儲(chǔ)業(yè)界對(duì)超融合存儲(chǔ)(例如: Nutanix, VMWare VSan)或稱 Server SAN的技術(shù)有很多關(guān)注。這類技術(shù)正在經(jīng)歷高速增長的發(fā)展。對(duì)傳統(tǒng)的SAN和存儲(chǔ)系統(tǒng)造成了嚴(yán)重的沖擊。

該技術(shù)有3個(gè)突出的特點(diǎn):1)采用標(biāo)準(zhǔn)服務(wù)器而不采用專門的硬件系統(tǒng)來實(shí)現(xiàn)存儲(chǔ)業(yè)務(wù)層的功能。2)完全采用軟件技術(shù)來實(shí)現(xiàn)機(jī)群內(nèi)的所有服務(wù)器直接連接的存儲(chǔ)(DAS)資源的池化。3)采用機(jī)群內(nèi)的服務(wù)器結(jié)點(diǎn)既運(yùn)行存儲(chǔ)業(yè)務(wù),也運(yùn)行用戶的應(yīng)用。即用戶的業(yè)務(wù)應(yīng)用程序和超融合的存儲(chǔ)業(yè)務(wù)共生在同一服務(wù)器結(jié)點(diǎn)上。

表面看來,該技術(shù)應(yīng)該可消除專門用于連接存儲(chǔ)資源的存儲(chǔ)交換網(wǎng)絡(luò)(如SAN等Storage Fabric),還可消除傳統(tǒng)的專用存儲(chǔ)系統(tǒng)硬件。而完全采用通用服務(wù)器的硬件系統(tǒng)。但是,生產(chǎn)服務(wù)器的廠商卻有不同的看法:超融合存儲(chǔ)軟件極大地催生了對(duì)SAS Switch 這類簡單的后端存儲(chǔ)Fabric技術(shù),以及存儲(chǔ)資源解耦合的硬件構(gòu)架在刀片和機(jī)架服務(wù)器上的應(yīng)用,即采用高密度刀片或機(jī)架服務(wù)器+SAS Switch+JBOD的硬件構(gòu)架來實(shí)現(xiàn)超融合系統(tǒng)。

歸納下來有如下原因:

1)通過把盤從刀片或機(jī)架服務(wù)器內(nèi)部挪到更便宜的JBOD上,優(yōu)化了“地價(jià)”成本,從而使得服務(wù)器計(jì)算結(jié)點(diǎn)密度提高,成本降低。這個(gè)優(yōu)化的思路在本文的第一部分已有論述。

2)由于用戶應(yīng)用程序和存儲(chǔ)業(yè)務(wù)共生在同一個(gè)CPU上,而用戶應(yīng)用對(duì)硬件資源的需求最優(yōu)配比千差萬別,難以向所有用戶推薦統(tǒng)一的集成了CPU和存儲(chǔ)資源的磚塊服務(wù)器型號(hào)。而要根據(jù)用戶的具體應(yīng)用來進(jìn)行優(yōu)化,這就需要把存儲(chǔ)和計(jì)算解耦合。

3)在公有云,VDI等許多應(yīng)用場(chǎng)景,需要支持在同一個(gè)機(jī)群硬件設(shè)施上支持多個(gè)房客(Multi-Tenant),而出于數(shù)據(jù)安全的考慮,許多客戶要求服務(wù)提供方保證他們的私有數(shù)據(jù)和其他訪客的數(shù)據(jù)在物理上隔離(即存放在物理隔離的盤上,物理上保障其他用戶的虛擬機(jī)不可能訪問到他們的私有數(shù)據(jù))。這樣的物理隔離在SAS Switch上很方便就可實(shí)現(xiàn)。

綜上所述,我們十分欣慰地看到,SAS Switch 在大型數(shù)據(jù)中心以及企業(yè)存儲(chǔ)領(lǐng)域的許多應(yīng)用場(chǎng)景已經(jīng)開始進(jìn)入大規(guī)模部署的階段。我們過去幾年所提倡的解耦合,存儲(chǔ)資源池化的設(shè)想也隨之變成現(xiàn)實(shí)。在中國數(shù)據(jù)中心的天蝎2.0的機(jī)架上,我們看到了基于SAS Switch的產(chǎn)品日趨成熟。這催生了中國數(shù)據(jù)中心在這個(gè)技術(shù)路線上的超越美國率先進(jìn)入了存儲(chǔ)池化的時(shí)代,讓云技術(shù)更先進(jìn),更有彈性,更經(jīng)濟(jì),更環(huán)保。而在國際市場(chǎng)上,我們也看到了主流服務(wù)器廠商以及各類數(shù)據(jù)中心的積極跟進(jìn)。2015年 SAS Switch 正當(dāng)時(shí)。

評(píng)論