AI PC新突破 端側首次支持128K上下文窗口 實現2.2倍推理優化

從協同設計到首日落地:面壁智能大模型如何在酷睿Ultra上實現2.2倍推理優化

近日,面壁智能正式發布并開源了「面壁小鋼炮」端側系列最新力作——MiniCPM 4.0模型,實現了端側可落地的系統級軟硬件稀疏化的高效創新。英特爾與面壁智能從模型開發階段就緊密合作,實現了長短文本多重推理效率的提升,端側AI PC 在Day 0全面適配,128K長上下文窗口等多方面突破。

雙方開展了深度技術協同,基于英特爾硬件架構定制投機解碼配置。通過硬件感知的草稿模型優化策略,結合英特爾加速套件與KV Cache內存增強技術,實現端到端推理效率的2.2倍提升1,攜手為業界帶來了全新的模型創新和端側性能體驗。

此次,面壁推出的MiniCPM 4.0系列LLM模型擁有 8B、0.5B 兩種參數規模,針對單一架構難以兼顧長、短文本不同場景的技術難題,MiniCPM 4.0-8B 采用「高效雙頻換擋」機制,能夠根據任務特征自動切換注意力模式:在處理高難度的長文本、深度思考任務時,啟用稀疏注意力以降低計算復雜度,在短文本場景下切換至稠密注意力以確保精度,實現了長、短文本切換的高效響應。

目前,具有CPU、GPU、NPU三個AI運算引擎的英特爾酷睿Ultra處理器已迅速對此適配,并借助OpenVINO? 工具套件為MiniCPM 4.0系列模型提供優化的卓越性能表現。英特爾再次在NPU上對模型發布提供第零日(Day 0)支持,為不同參數量模型和應用場景提供更多樣化的、更有針對性的平臺支持。

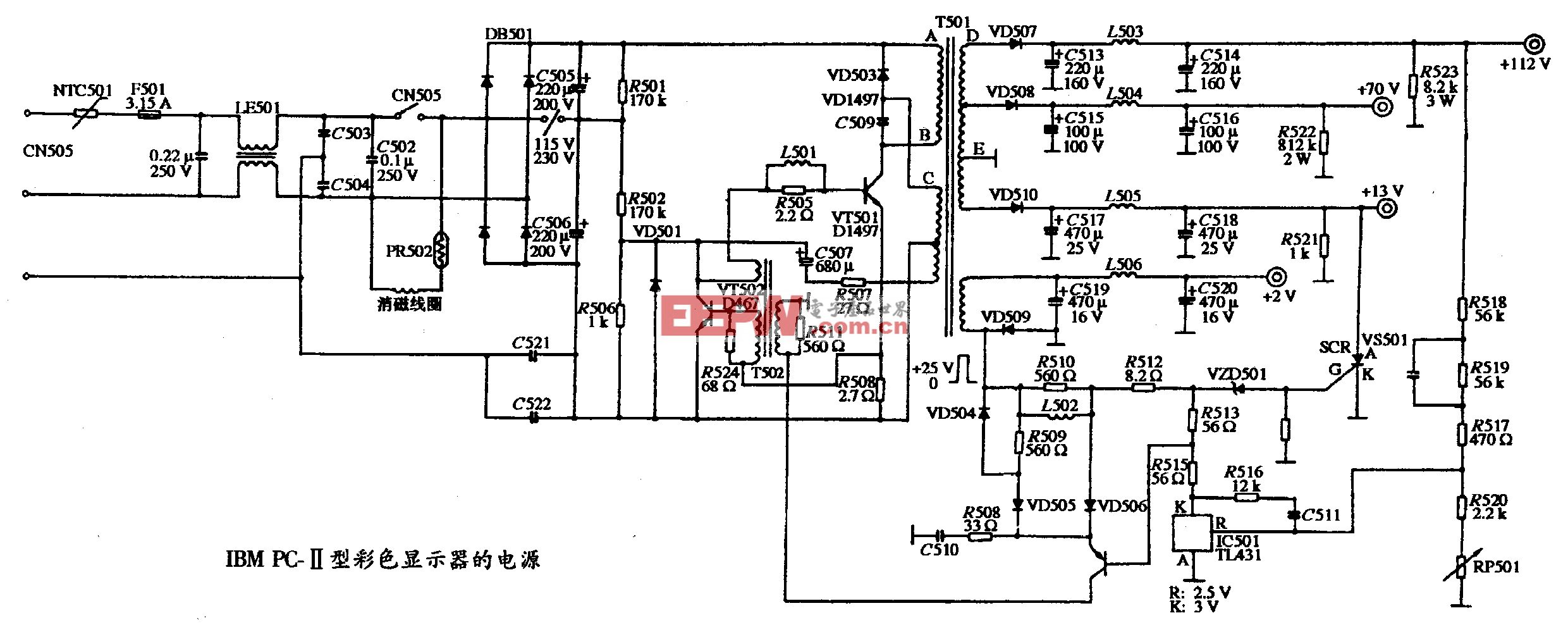

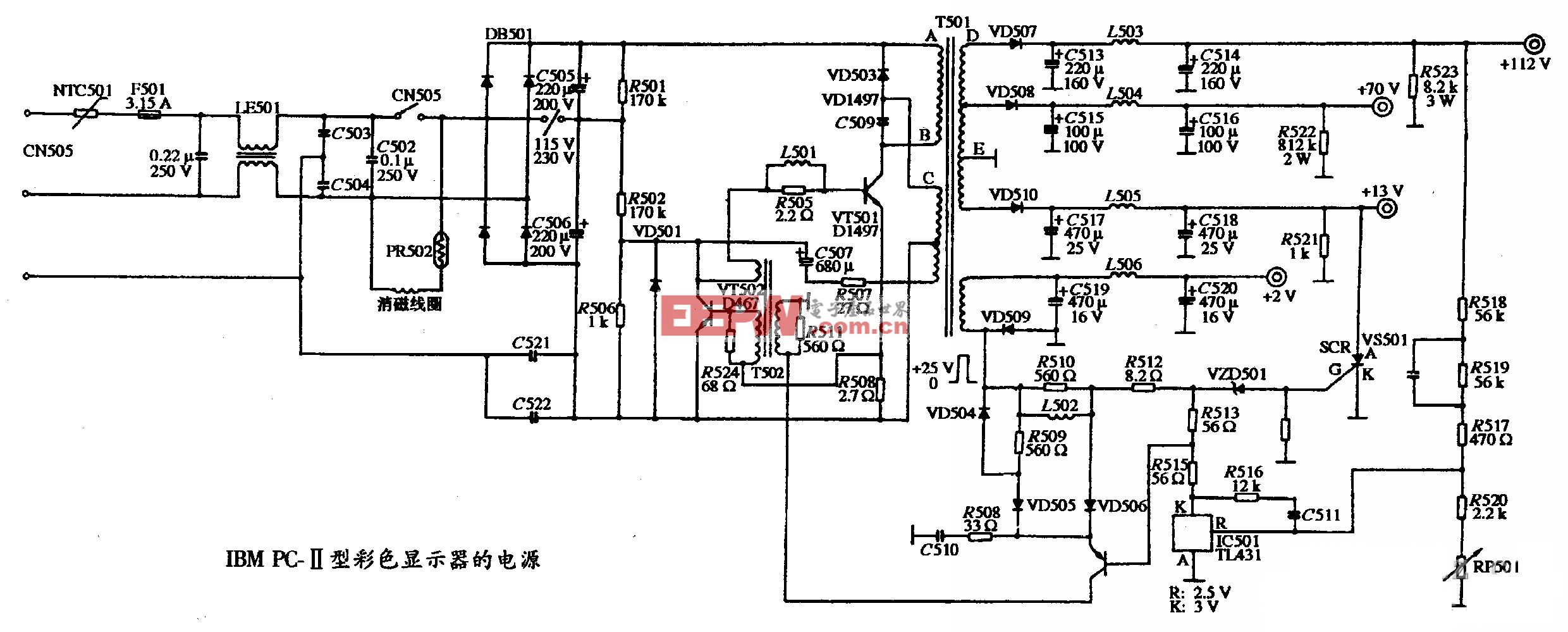

CPU及AI處理引擎 | ? 模型 | 精度 | 1st Token延遲(毫秒) | 2nd Token(每秒) |

Intel? Core? Ultra 7 258V(iGPU) | MiniCPM4-0.5B | FP16 | 59.94 | 87.62 |

Intel? Core? Ultra 7 258V(NPU) | MiniCPM4-0.5B | FP16 | 141.99 | 67.46 |

Intel? Core? Ultra 7 258V(iGPU) | MiniCPM4-8B | INT4-MIXED-ASYM | 694.60 | 21.3 |

Intel? Core? Ultra 7 258V(NPU) | MiniCPM4-8B | INT4-MIXED-CW-SYM | 1315.89 | 17.65 |

Intel? Core? Ultra 9 285H(iGPU) | MiniCPM4-0.5B | FP16 | 65.32 | 83.67 |

Intel? Core? Ultra 9 285H(iGPU) | MiniCPM4-8B | INT4-MIXED-ASYM | 645.63 | 21.39 |

* 上述測試評估了在int4混合精度和fp16精度設置下1K輸入的首詞元延遲和平均吞吐量。每項測試在預熱階段后執行三次,選取平均值作為報告數據。性能結果基于以下SKU1或SKU2配置2

在長上下文窗口的技術創新方面,英特爾也有了新的突破。依托分塊稀疏注意力機制,結合深度算子融合與硬件驅動的算法優化,實現了長文本緩存的大幅銳減,和推理效率的進一步提升。 在保證輸出質量的前提下,我們首次在基于英特爾銳炫? Pro B60上將長上下文窗口擴展至128K。相較于稠密模型,首Token延遲降低了38%3,Token速率提升多達3.8倍3。經過這樣的提升,一整部300多頁的哈利波特小說,可以在90秒內完成閱讀、分析和總結。這不僅極大地提升了AI PC的用戶體驗,也為解鎖更多端側AI新應用建立了強大的基礎。未來,英特爾將持續保持與面壁的深度合作和協同研發,進一步提升長上下文窗口應用的性能。對128K的文本輸入進行處理的效果請參考視頻演示。

在當今數字化時代,人工智能技術正以前所未有的速度發展,英特爾作為全球領先的科技企業和AI PC的發起和倡導者,始終致力于推動端側AI模型的創新發展。

此次合作不僅彰顯了英特爾在AI領域的強大技術實力,也體現了其對創新生態系統的堅定承諾。通過整合雙方的技術優勢和資源,英特爾平臺和MiniCPM 4.0系列模型聯合解決方案的廣泛應用和落地部署已經奠定了堅實的基礎,有望在智能生活、生產力提升等多個場景中發揮關鍵作用。

展望未來,英特爾將繼續與面壁智能保持緊密合作,同時積極拓展合作關系,不斷探索AI技術的新邊界。英特爾致力于通過持續創新,推動人工智能技術的普及與發展,構建更加智能、高效的未來社會。

評論