初創公司的模擬AI承諾為PC提供強大功能

Naveen Verma 在普林斯頓大學的實驗室就像一個博物館,展示了工程師們試圖通過使用模擬現象而不是數字計算來提高 AI 超高效的所有方法。一個工作臺上是有史以來最節能的基于磁記憶的神經網絡計算機。在另一個位置,您會發現一個基于電阻存儲器的芯片,它可以計算迄今為止任何模擬 AI 系統中最大的數字矩陣。

本文引用地址:http://www.104case.com/article/202506/471048.htmVerma 表示,兩者都沒有商業前景。不那么仁慈的是,他實驗室的這一部分是一個墓地。

多年來,Analog AI 一直吸引著芯片架構師的想象力。它結合了兩個關鍵概念,這兩個概念應該會大大降低機器學習的能源密集度。首先,它限制了存儲芯片和處理器之間昂貴的位移動。其次,它不是邏輯的 1 和 0,而是使用電流的物理學來有效地進行機器學習的關鍵計算。

盡管這個想法很有吸引力,但各種模擬 AI 方案并沒有以一種可以真正消除 AI 令人震驚的能源胃口的方式實現。維爾瑪會知道的。他都試過了。

但是,當 IEEE Spectrum 一年前訪問時,Verma 實驗室后面有一個芯片,它代表了模擬 AI 和使 AI 有用和無處不在所需的節能計算的一些希望。芯片不是用電流計算,而是對電荷求和。這似乎是一個無關緊要的差異,但它可能是克服阻礙所有其他模擬 AI 方案的噪聲的關鍵。

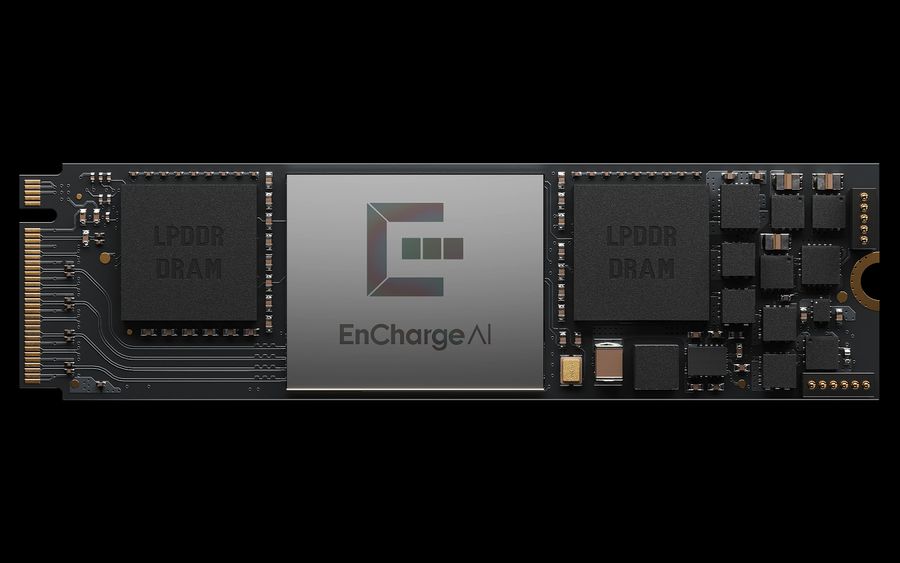

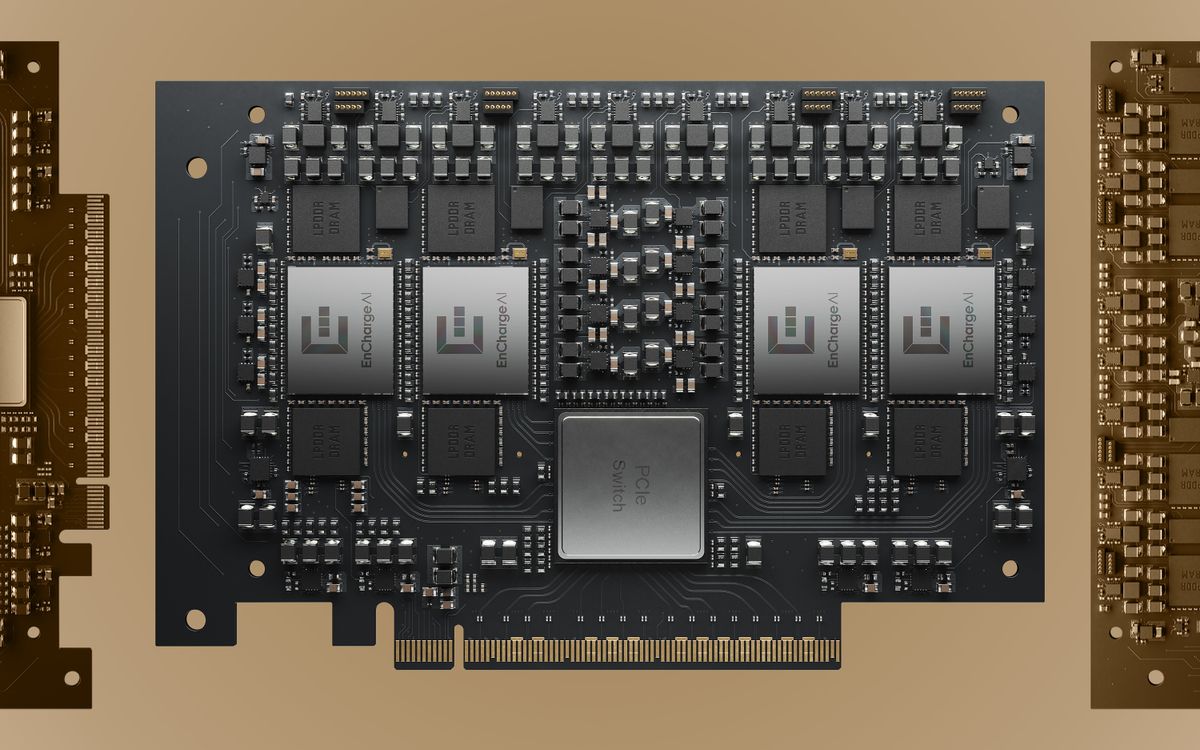

本周,Verma 的初創公司 EnCharge AI 推出了第一款基于這種新架構的芯片 EN100。這家初創公司聲稱,該芯片可以處理各種 AI 工作,每瓦性能比競爭對手的芯片高 20 倍。它被設計到單個處理器卡中,以 8.25 瓦的功率每秒增加 200 萬億次作,旨在延長支持 AI 的筆記本電腦的電池壽命。最重要的是,一個 4 芯片、每秒 1000 萬億次作的卡面向 AI 工作站。

當前和巧合

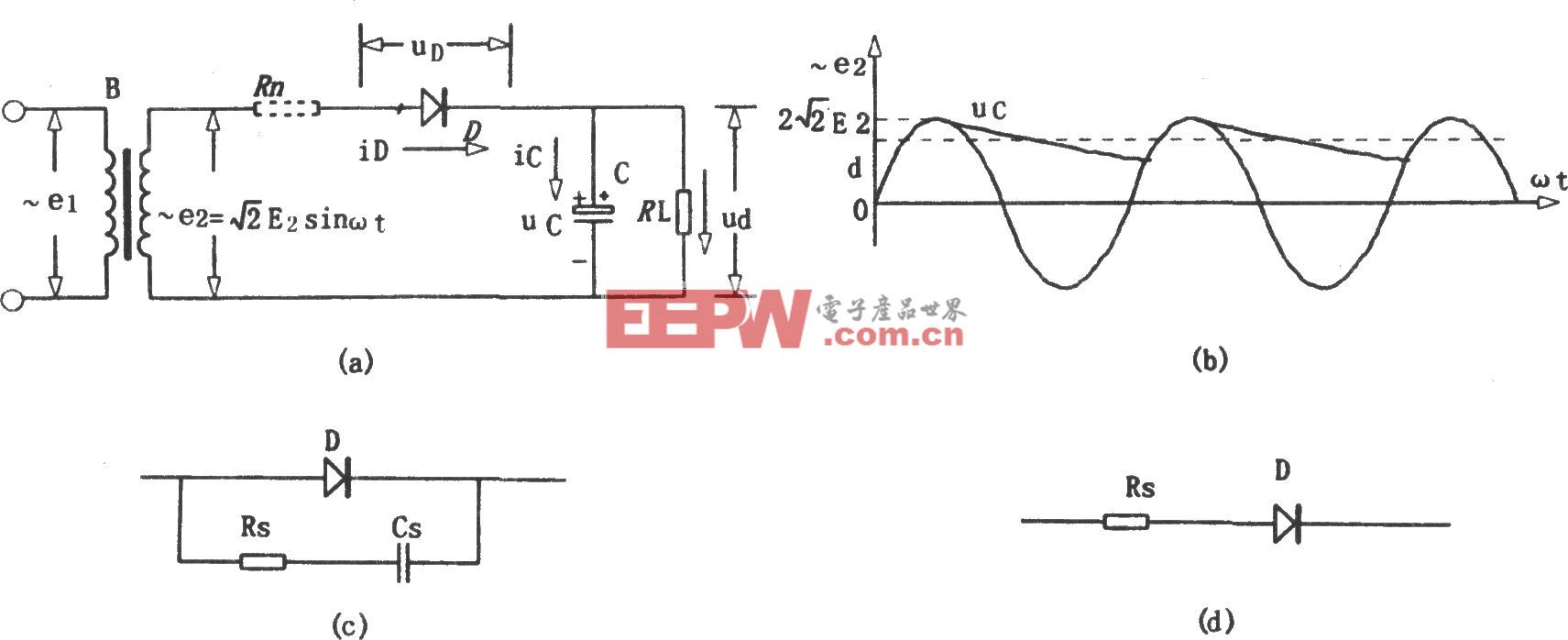

在機器學習中,“事實證明,憑著愚蠢的運氣,我們所做的主要作是矩陣乘法,”Verma 說。這基本上是取一個數字數組,將其乘以另一個數組,然后將所有這些乘法的結果相加。很早,工程師們就注意到了一個巧合:電氣工程的兩條基本規則可以準確地完成這一作。歐姆定律說,您可以通過乘以電壓和電導來獲得電流。基爾霍夫電流定律說,如果有一堆電流從一堆電線進入一個點,那么這些電流的總和就是離開該點的。所以基本上,一堆輸入電壓中的每一個都推動電流通過一個電阻(電導是電阻的倒數),乘以電壓值,所有這些電流加起來產生一個值。數學,完成。

聽起來不錯?嗯,它會變得更好。構成神經網絡的大部分數據都是 “權重”,即輸入乘以的數據。將這些數據從內存移動到處理器的邏輯中來完成這項工作,這占了 GPU 消耗的很大一部分能量。相反,在大多數模擬 AI 方案中,權重作為電導值(上面的電阻)存儲在幾種類型的非易失性存儲器之一中。因為重量數據已經在需要執行計算的位置,所以它不必移動那么多,從而節省了大量能源。

自由數學和穩態數據的結合有望實現只需要萬億分之一焦耳能量的計算。不幸的是,這并不是模擬 AI 工作所帶來的好處。

電流的麻煩

任何類型的模擬計算的根本問題始終是信噪比。Analog AI 一卡車都有。信號(在本例中為所有這些乘法的總和)往往會被許多可能的噪聲源所淹沒。

“問題是,半導體器件是雜亂無章的東西,”Verma 說。假設你有一個模擬神經網絡,其中權重作為電導存儲在單個 RRAM 單元中。通過在 RRAM 單元上設置相對較高的電壓來存儲此類權重值,并持續一段規定的時間。問題是,您可以在相同的時間內在兩個電池上設置完全相同的電壓,而這兩個電池最終的電導值會略有不同。更糟糕的是,這些電導值可能會隨溫度而變化。

差異可能很小,但請記住,該運算會加很多乘法,因此噪聲會被放大。更糟糕的是,產生的電流隨后會轉化為電壓,作為下一層神經網絡的輸入,這一步驟會進一步增加噪聲。

研究人員從計算機科學和設備物理學的角度解決了這個問題。為了補償噪聲,研究人員發明了將設備物理弱點的一些知識融入到他們的神經網絡模型中的方法。其他公司則專注于制造行為盡可能可預測的設備。IBM 在這一領域進行了廣泛的研究,兩者兼而有之。

此類技術在較小規模的系統中即使尚未在商業上取得成功,也具有競爭力,這些芯片旨在為 IoT 網絡邊緣的設備提供低功耗機器學習。早期進入者 Mythic AI 已經生產了不止一代的模擬 AI 芯片,但它正在低功耗數字芯片取得成功的領域競爭。

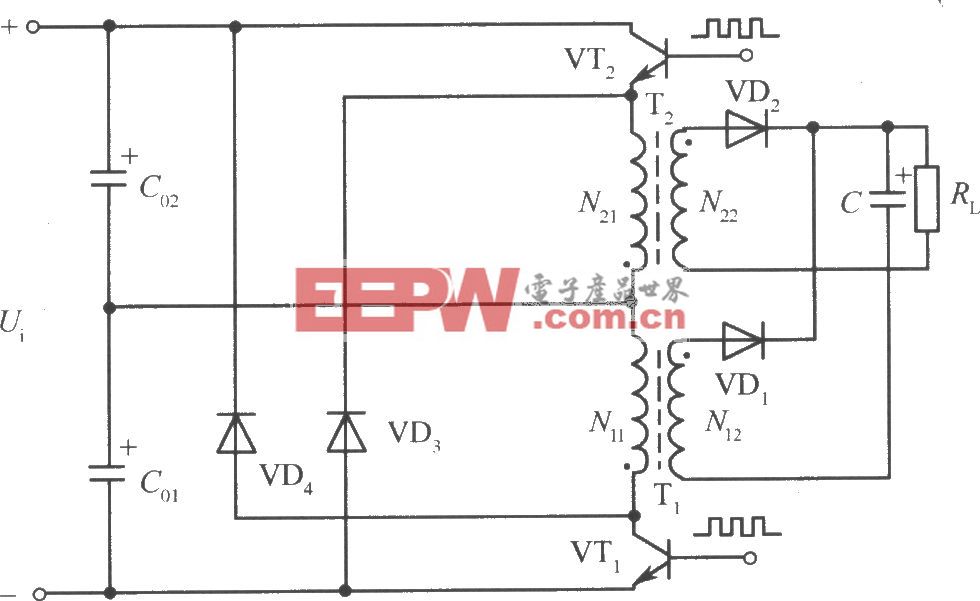

用于 PC 的 EN100 卡是一種新的模擬 AI 芯片架構。EnCharge 人工智能

電容器一路向下

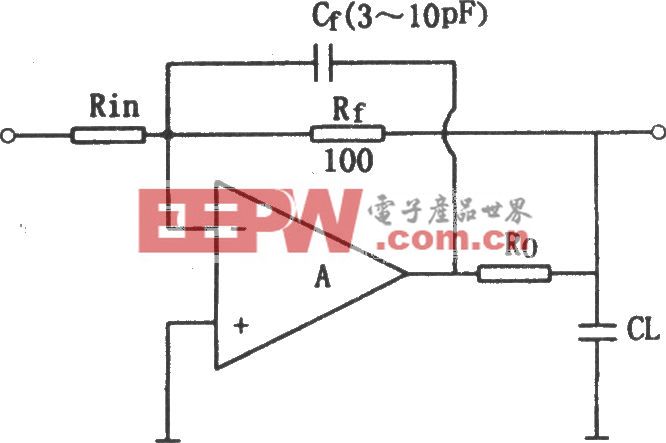

EnCharge 的解決方案通過測量電荷量而不是機器學習乘法累加法中的電荷流來消除噪聲。在傳統的模擬 AI 中,乘法取決于電壓、電導和電流之間的關系。在這個新方案中,它取決于電壓、電容和電荷之間的關系,其中基本上,電荷等于電容乘以電壓。

為什么這種差異很重要?這歸結為執行乘法運算的組件。EnCharge 沒有使用像 RRAM 這樣挑剔、易受攻擊的設備,而是使用電容器。

電容器基本上是夾在絕緣體中的兩個導體。導體之間的電壓差會導致電荷在其中一個導體上積聚。對于機器學習而言,它們的關鍵是它們的值(電容)由它們的大小決定。(更大的導體面積或導體之間的空間更小意味著更大的電容。

“他們唯一依賴的是幾何形狀,基本上是電線之間的空間,”Verma 說。“這是 CMOS 技術中可以非常非常好地控制的一件事。”EnCharge 在其處理器硅片上方的銅互連層中構建了一系列精確計算的電容器。

構成神經網絡模型大部分的數據(權重)存儲在數字存儲單元陣列中,每個存儲單元都連接到一個電容器。然后使用單元內置的簡單邏輯將神經網絡正在分析的數據乘以權重位,結果以電荷的形式存儲在電容器上。然后數組切換到一種模式,其中乘法結果的所有電荷都累積起來,結果被數字化。

雖然最初的發明可以追溯到 2017 年,對 Verma 的實驗室來說是一個重要的時刻,但他表示,基本概念已經相當古老了。“這被稱為開關電容器作;事實證明,我們已經這樣做了幾十年,“他說。例如,它用于商用高精度模數轉換器。“我們的創新是弄清楚如何在執行內存計算的架構中使用它。”

競爭

Verma 的實驗室和 EnCharge 花了數年時間證明該技術是可編程和可擴展的,并將其與適合 AI 需求的架構和軟件堆棧進行協同優化,這與 2017 年大不相同。由此產生的產品現在由早期訪問開發人員提供,該公司(最近從 Samsung Venture、Foxconn 和其他公司籌集了 1 億美元)計劃進行另一輪早期訪問合作。

但 EnCharge 正在進入一個競爭激烈的領域,競爭對手中就有大 kahuna,Nvidia。 在 3 月份的大型開發者活動 GTC 上,Nvidia 宣布計劃圍繞其 GB10 CPU-GPU 組合構建 PC 產品,并圍繞即將推出的 GB300 構建工作站。

在 EnCharge 所追求的低功耗領域將存在大量競爭。其中一些甚至使用某種形式的內存計算。例如,D-Matrix 和 Axelera 繼承了模擬 AI 的承諾,將內存嵌入到計算中,但以數字方式完成所有工作。他們各自開發了定制的 SRAM 存儲單元,這些單元既可以存儲和乘法,也可以以數字方式進行求和運算。甚至至少還有一家更傳統的模擬 AI 初創公司 Sagence。

不出所料,維爾馬很樂觀。他在一份聲明中說,這項新技術“意味著先進、安全和個性化的人工智能可以在本地運行,而無需依賴云基礎設施”。“我們希望這將從根本上擴展您可以使用 AI 的功能。”

EnCharge AI 的工作站和邊緣計算機主板集成了四個 EN100 芯片。

原始圖片:EnCharge AI

評論