巨頭搶奪戰,HBM被徹底引爆

在英偉達一步步站穩萬億市值腳根的道路上,少不了兩項關鍵技術支持,其中之一是由臺積電主導的 CoWoS 先進封裝,另一個便是席卷當下的 HBM(高帶寬存儲)。

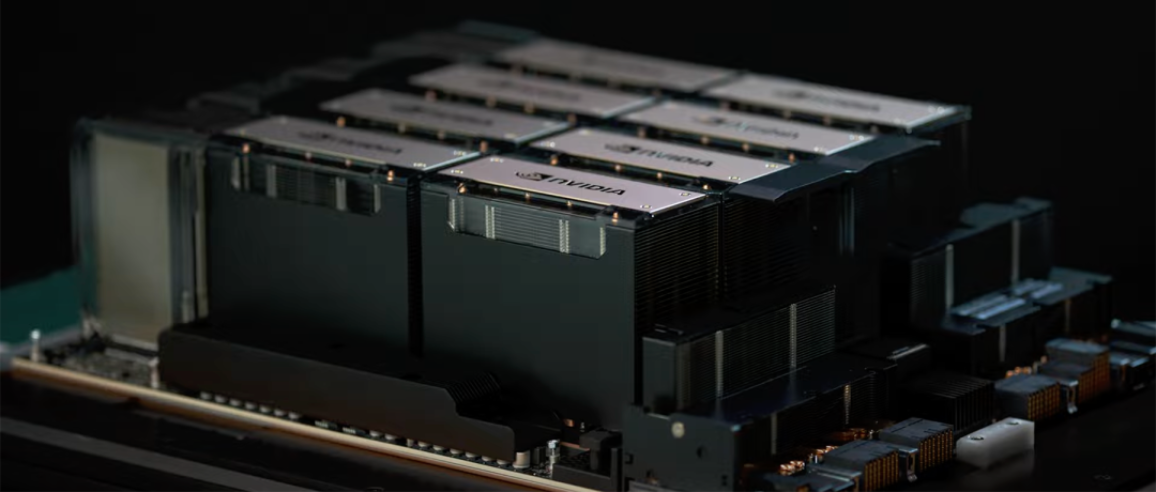

本文引用地址:http://www.104case.com/article/202407/461090.htm英偉達 H200 是首次采用 HBM3E 存儲器規格的 AI 加速卡。借助內存速度更快、容量更大的 HBM3e,英偉達 H200 以每秒 4.8TB 的速度提供 141GB 的內存,與 A100 相比,容量幾乎是其兩倍,帶寬也提升了 43%,從而加速生成式 AI 和大語言模型,提高高性能計算(HPC)的工作負載。

隨著人工智能的興起,HBM 成為巨頭們搶占的高地。三星、SK 海力士、美光等存儲巨頭紛紛將 HBM 視為重點生產產品之一。

HBM 的火熱,給市場掀起巨大波瀾。一起看看 HBM 這股熱潮給市場帶來了哪些轉折?

HBM 走紅,帶來三大影響

HBM 成為力挽行業下行的關鍵詞之一

數個季度的持續低迷下,頭部存儲廠商相繼展現出季度收入環比增長趨勢,其中以 SK 海力士的表現最為亮眼,背后就離不開由 HBM 拉動對 DRAM 的需求提升。

今年 Q1,SK 海力士收入創歷史同期新高,營業利潤也創下了市況最佳的 2018 年以來同期第二高,公司將其視為擺脫了長時間的低迷期,開始轉向了全面復蘇期。SK 海力士表示:「憑借 HBM 等面向 AI 的存儲器技術領導力,公司提升了面向 AI 服務器的產品銷量,同時持續實施以盈利為主的經營活動,從而實現了營業利潤環比增長 734% 的業績。」

三星電子曾表示生成式 AI 市場應用將帶來 HBM 等支持大規模數據處理的內存產品需求快速增長,公司接到了大量客戶需求。預計 2024 年 HBM 的需求可能出現陡峭增長。

美光表示,AI 服務器的 DRAM 容量是普通服務器的 6 倍到 8 倍,NAND 容量是普通服務器的 3 倍。英偉達 DGX GH200 所需的 DRAM 容量是普通服務器的數百倍。

通用 DRAM 恐缺貨漲價

通用型 DRAM 內存芯片面臨的供應短缺,主要源于業界對 HBM 等類型的 DRAM 進行了大量的投資,而通用型 DRAM 的產能利用率相對較低。目前,三星和 SK 海力士的產能利用率僅為 80% 到 90%,遠低于 NAND 閃存的全速生產狀態。

自 2024 年初以來,通用型 DRAM 的產能僅提升了大約 10%,但智能手機、PC 和服務器市場的增長率預計僅為 2% 到 3%。全球云計算和科技公司在 AI 基礎設施上的投資削減,并未能顯著推動 DRAM 需求的復蘇。

然而,在同一時期內,企業級固態硬盤(eSSD)的需求卻因人工智能的普及而激增。因此,三星、SK 海力士等主要制造商在第二季度滿負荷運行其 NAND 生產線。此外,鎧俠也在市場條件改善后結束了減產,NAND 產能利用率恢復至 100%。

由于通用 DRAM 內存芯片在消費市場,如個人電腦和移動終端等領域發揮著巨大作用,而隨著市場需求的放大,可能會出現大范圍的短缺。根據摩根士丹利最新報告,全球內存市場在 2025 年將迎來一次前所未有的供需失衡,2025 年 HBM 的供應不足率將達到-11%,而整個 DRAM 市場的供應不足率將高達-23%。

爭奪戰,不只是技術

存儲巨頭在 HBM 技術領域的爭奪戰日益激烈,從 HBM1 到 HBM2、HBM3,再到最新的 HBM3e,每一代技術的演進都標志著存儲性能的顯著提升和市場競爭的加劇。

HBM1 最早于 2014 年由 AMD 與 SK 海力士共同推出,作為 GDDR 競品,為 4 層 die 堆疊,提供 128GB/s 帶寬,4GB 內存,顯著優于同期 GDDR5。

HBM2 于 2016 年發布,2018 年正式推出,為 4 層 DRAMdie,現在多為 8 層 die,提供 256GB/s 帶寬,2.4Gbps 傳輸速度,和 8GB 內存。

HBM2E 于 2018 年發布,于 2020 年正式提出,在傳輸速度和內存等方面均有較大提升,提供 3.6Gbps 傳輸速度,和 16GB 內存。

HBM3 于 2020 年發布,2022 年正式推出,堆疊層數及管理通道數均有增加,提供 6.4Gbps 傳輸速度,傳輸速度最高可達 819GB/s,和 16GB 內存。

HBM3E 由 SK 海力士發布 HBM3 的增強版,提供高達 8Gbps 的傳輸速度,24GB 容量,2024 年開始大規模量產。

然而這不僅僅是一場單純的技術較量,更是一場激烈無比的產能競賽。

根據存儲三巨頭表示,今年的 HBM 供應能力已全部耗盡,明年的產能也已經大部分售罄。據專業機構分析,今明兩年 HBM 需求的動態缺口約為產能的 5.5% 和 3.5%。因此,三大廠商紛紛開啟產能沖刺競賽。比如 SK 海力士正在大幅擴產第 5 代 1b DRAM,以應對 HBM 與 DDR5 DRAM 的需求增加。按照晶圓投入量看,公司計劃將 1b DRAM 月產能從今年一季度的 1 萬片增加到年末的 9 萬片,到明年上半年進一步提升至 14 萬-15 萬片,是今年一季度產能的 14-15 倍。三星 3 月底曾表示,預計今年 HBM 產能將增至去年的 2.9 倍。美光正在美國建設先進的 HBM 測試生產線,并考慮首次在馬來西亞生產 HBM,以抓住 AI 熱潮帶來的更多需求。

相比 GDDR,HBM 強在哪兒?

根據產品分類,DRAM 可以分為 DDR、LPDDR、GDDR、HBM。前三類產品主要用于傳統周期領域,HBM 則主要是 AI 市場的帶動。其中 DDR 主要用于消費電子、服務器、PC 領域;LPDDR 主要用于移動設備、手機及汽車領域;GDDR 主要用于圖像處理方面的 GPU 等。

隨著數據量越發龐大加之 AI 芯片的加速發展,馮氏計算架構問題凸顯:「存」「算」之間性能失配,使得計算機的計算能力增長遇到瓶頸,雖然多核并行加速技術可以提高算力,但存儲帶寬的限制仍對計算系統的算力提升產生了制約。GDDR 是目前應用較為廣泛的顯存技術,但在 AI 計算領域 GDDR 也難堪重任,于是制造商將目光投向 HBM 技術。

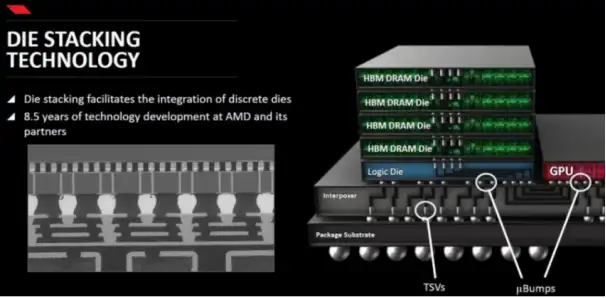

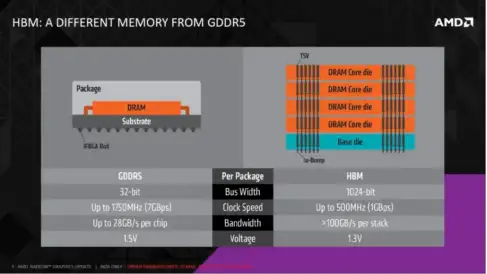

HBM 具備高帶寬的優勢。通過多層堆疊,HBM 能達到更高的 I/O 數量,使得顯存位寬達到 1024 位,幾乎是 GDDR 的 32 倍,顯存帶寬顯著提升。顯存帶寬顯著提升解決了過去 AI 計算「內存墻」的問題,HBM 逐步提高在中高端數據中心 GPU 中的滲透比率。

HBM 具備高密度、小體積等優勢。相比傳統 DRAM,HBM 在相同的物理空間內能夠容納更多的存儲單元,從而提供更高的存儲容量。這對于存儲千億參數乃至更大規模的大模型至關重要。此外,HBM 通過 3D 封裝工藝實現 DRAM die 的垂直方向堆疊封裝,可以較大程度節約存儲芯片在片上占據的面積。HBM 芯片的尺寸比傳統的 DDR4 芯片小 20%,比 GDDR5 芯片節省了 94% 的表面積。根據三星電子的統計,3D TSV 工藝較傳統 POP 封裝形式節省了 35% 的封裝尺寸。

受構造影響,GDDR 的總帶寬上限低于 HBM。總帶寬=I/O 數據速率(Gb/s)*位寬/8。為解決 DDR 帶寬較低的問題,本質上需要對單 I/O 的數據速率和位寬(I/O 數*單 I/O 位寬)進行提升,可分為 GDDR 單體式方案和 HBM 堆疊式方案。單體式 GDDR 采取大幅提升單 I/O 數據速率的手段來改善總帶寬,GDDR5 和 GDDR6 的單 I/O 數據速率已達到 7 Gb/s 到 16Gb/s,超過 HBM3 的 6.4 Gb/s。HBM 利用 TSV 技術提升 I/O 數和單 I/O 位寬,從而大幅提升位寬,雖然維持較低的單 I/O 數據速率,但總帶寬遠優于 GDDR。

HBM 的綜合功耗也低于 GDDR。HBM 通過增加 I/O 引腳數量來降低總線頻率,從而實現更低的功耗。盡管片上分布的大量緩存能提供足夠的計算帶寬,但由于存儲結構和工藝制約,片上緩存占用了大部分的芯片面積(通常為 1/3 至 2/3),限制了算力提升。

如今,HBM 已經成為超級計算機、數據中心等核心設施中不可或缺的關鍵組件,為大規模并行計算提供了堅實的內存基礎。尤其在圖形處理領域,HBM 的高帶寬特性使得 GPU 能夠更快速地訪問和處理圖像數據,從而為用戶帶來更加流暢、逼真的視覺體驗。

即便是業界領先的英偉達,也對這一產品展現出了高度的依賴性。據悉,英偉達近幾年發布的多款旗艦產品(如 A100、H100、H200)均搭配了不同數量的 HBM。HBM 已然是英偉達 AI 芯片的必備搭檔。然而全球約九成的 HBM 市場被 SK 海力士和三星兩家韓系企業壟斷。

2024 年末,HBM 是持續短缺?還是供過于求?

在存儲三巨頭的競爭中,由于海力士 HBM3 產品性能領先,率先拿下英偉達訂單,成為其服務器 GPU 的主要供應商。

三星主攻一些云端客戶的訂單,美光則直接跳過了 HBM3,將主要精力放在了 HBM3E 產品上。僅從當下來看,美光的市場占有率和前面兩個玩家有一些差距。

但不管怎樣,三位存儲芯片的大佬都在擴產能上不留余力。比如海力士已經放下豪言壯語,計劃到 2028 年投資高達 748 億美元,其中 80% 將用于 HBM 的研發和生產,而且將下一代 HBM4 芯片的量產時間提前到 2025 年。

據專業機構分析,今明兩年 HBM 需求的動態缺口約為產能的 5.5% 和 3.5%。

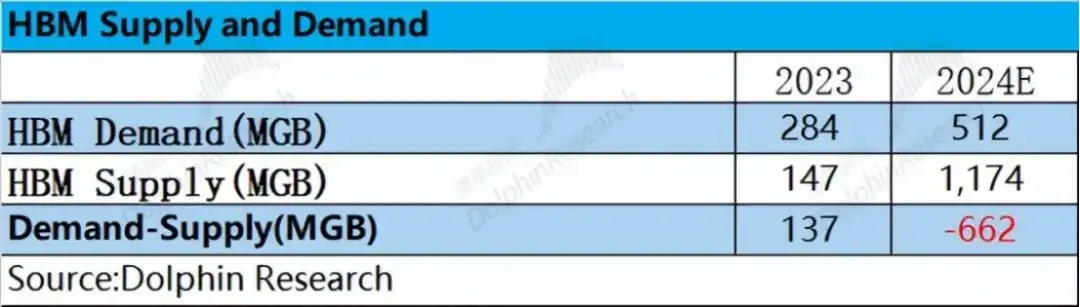

不過根據海豚投研的數據顯示,HBM 有望從 2023 年末的「供不應求」轉為 2024 年末的「供大于求」。

海豚投研比較了 2023—2024 年 HBM 的供需關系情況。 從需求端來看,結合云服務廠商的資本開支和 AI 出貨量情況,市場對 HBM 的需求有望從 2023 年的 284MGB 提升至 512MGB; 從供給端來看,結合存儲主流廠商的產能計劃,HBM 的供給端更可能從 2023 年的 147MGB 快速提升至 1000MGB 以上。

在此供需關系中,2023 年供給端僅能滿足需求的 1/2,嚴重供不應求。供不應求的局面,推動各家廠商大幅提升產能計劃。如果產能規劃如實落地,2024 年的 HBM 供需關系可能會出現明顯反轉,供給端反而會超出整體的市場需求。

對于 HBM 的價格,當前由于供給仍相對緊張,因此整體價格在 2024 年將有所上漲。但隨著三星產品通過認證和產能端的釋放,HBM 的產品價格也可能出現回落。

國產廠商加速突破

隨著 AIGC 技術應用的快速發展,AI 服務器和高端 GPU 的需求持續增長,將進一步推動 HBM 市場的高速增長。據預計,到 2025 年,中國 HBM 的需求量規模有望超過 100 萬顆。

而中國,在這一賽道還屬于后來者。

不久前,國家集成電路產業投資基金三期橫空出世。大基金三期注冊資本高達 3440 億元,這一規模遠超前兩期基金,顯示出國家對集成電路產業的重視和大力支持。如此龐大的資金注入,無疑將為集成電路產業的發展提供強大的動力。

目前,大基金三期對外投資重點還未正式披露。據悉,大基金三期有望增加覆蓋人工智能芯片環節,在 HBM 產業鏈扶持大型晶圓廠。

今年 3 月,武漢新芯發布了《高帶寬存儲芯粒先進封裝技術研發和產線建設》招標項目,這一行動標志著該公司正式進軍 HBM 市場。通過利用三維集成多晶圓堆疊技術,武漢新芯旨在打造更高容量、更大帶寬、更小功耗的存儲解決方案,以滿足市場對高性能存儲芯片的需求。面對海外大廠對于 HBM3E 的量產,國內存儲廠商也在 HBM 技術上進行著加速突破,有望在 AI 大浪潮的需求下提升競爭實力。

面對海外大廠對于 HBM3E 的量產,國內存儲廠商也在 HBM 技術上進行著加速突破,有望在 AI 大浪潮的需求下提升競爭實力。

封測龍頭長電科技在投資者互動中表示,其 XDFOI 高密度扇出封裝解決方案也同樣適用于 HBM 的 Chip to Wafer 和 Chip to Chip TSV 堆疊應用;通富微電此前表示,南通通富工廠先進封裝生產線建成后,公司將成為國內最先進的 2.5D/3D 先進封裝研發及量產基地,實現國內在 HBM(高帶寬內存)高性能封裝技術領域的突破,對于國家在集成電路封測領域具有重要意義。

中國主要的存儲芯片公司也在與封測廠商通富微電合作開展 HBM 相關項目。

然而總體來看,國內廠商在 HBM 技術上的發展仍處于早期階段。盡管國際上已經有了更先進的 HBM3 和 HBM3E 產品,但國內存儲廠商目前還處于 HBM2 的研發和產業化階段。

面對海外大廠在 HBM3E 等先進技術上的量產優勢,國內廠商仍需加快追趕步伐,克服技術壁壘,實現從技術跟隨到技術引領的轉變。在此過程中,客戶對于 AI 服務器性能、內存帶寬及內存大小的持續高要求,既是對 HBM 技術的巨大挑戰,也是推動其不斷前行的動力源泉。

值得注意的是,盡管 HBM 在帶寬性能上占據優勢地位,但其高昂的成本與功耗也促使行業探索更多元化的解決方案。GDDR、LPDDR 等內存技術的快速發展,為 AI 處理器提供了更多選擇,尤其是在成本、性能與功耗之間尋求最佳平衡點的應用場景中。例如,GDDR7 的推出不僅顯著提升了內存容量與數據傳輸率,還因其相對較低的復雜度成為部分 AI 應用的理想之選。

綜上所述,隨著 AI 技術的不斷演進與市場需求的日益多樣化,HBM 作為高性能存儲技術的代表,將繼續在特定領域發揮關鍵作用。同時,國內廠商需緊抓機遇,加速技術創新與產業升級,以更加靈活多樣的內存解決方案,滿足 AI 時代對高性能計算的多元化需求。

評論