一只蝴蝶揮了揮翅膀,于是有了AI讀心術

“我的身體沉重如潛水鐘,內心卻渴望像蝴蝶般自由飛翔。”這句來自電影《潛水鐘與蝴蝶》的臺詞,也是前《ELLE》雜志主編、記者讓·多米尼克的真實經歷。讓多米尼克中風癱瘓后,身體的語言和運動功能都喪失了,他不能說話,不能自主呼吸,只剩下一只眼睛和意識可以自由活動。在這種情況下,他還是“寫”出了一部散文集。

本文引用地址:http://www.104case.com/article/201901/396721.htm書是這樣完成的:助手把一個個字母依次念給讓·多米尼克,直到他眨一下眼,就把那個字母記下來……如此循環進行,直到字母形成單詞、句子、片段,最終付梓成冊。顯然,這個還原思維的過程十分艱辛且原始,但至少給他的靈魂留下了一絲自由遨游的可能。而對于更多缺乏發聲能力的普通人(比如中風患者、植物人等)來說,無法與正常人交流的他們,生命已然停滯。

技術能幫助他們“言其所不能言”,提高生活質量嗎?答案是肯定的。科學家們正試圖讓看不見摸不著的思維活動自動“顯形”。

通過計算機,將大腦中的所思所想轉換成語音說出來,這種“讀心術”距離現實究竟還有多遠?

《潛水鐘與蝴蝶》(2007)劇照

AI讀心術:計算機是如何還原腦電波的?

先來潑一盆冷水,那就是想要將人想象中的單詞和句子轉換成語音,目前的計算機還做不到如此鬼斧神工的地步。不過,已經有研究人員成功利用AI復原了人聽到或超小聲說話時的句子。

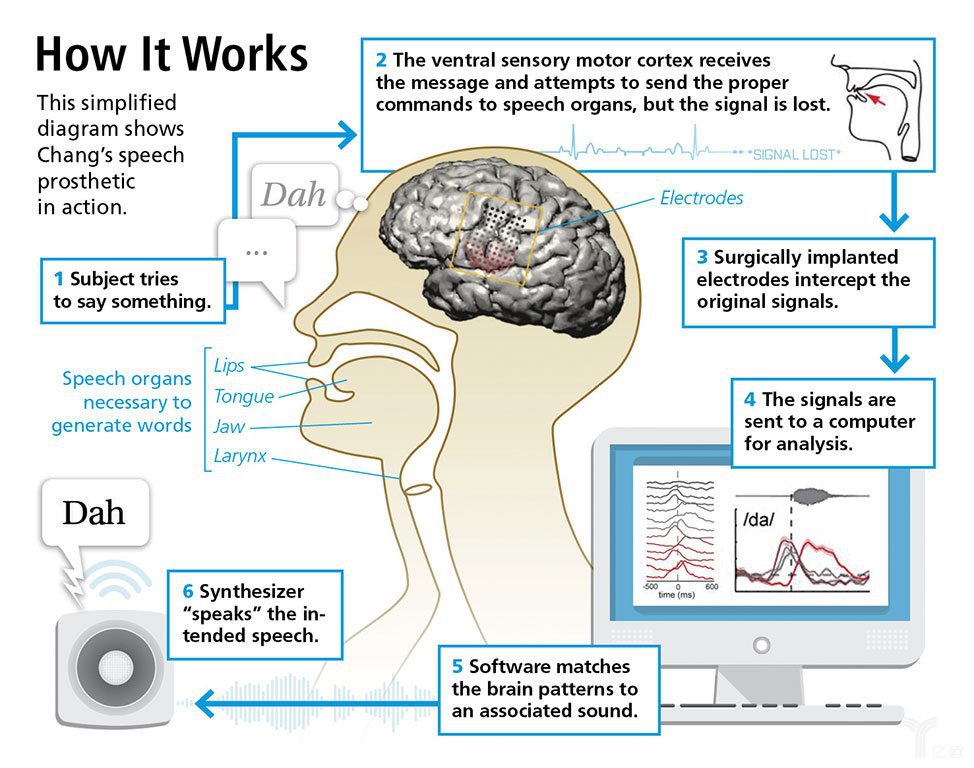

技術的實現原理也并不復雜。人類的發聲運動是靠大腦神經元電信號刺激下頜、嘴唇、聲帶等部位形成的。因此,只要將相關腦區的神經運動信號輸送給AI系統,深度學習網絡就會根據信號與相對應的語言文字或嘴部運動進行層層匹配,推斷出具體說了什么,再由語音合成器將這些信號轉換成能被聽到的語音。

那么,這項技術的靠譜程度如何呢?

哥倫比亞大學計算機科學家Nima Mesgarani做了一項實驗,讓聽眾“收聽”一組與故事和數字有關的聽覺皮層數據,有75%的人能夠正確識別出該數字。類似的實驗在加州大學舊金山分校的研究組也成功了。癲癇患者大聲朗讀句子時的大腦活動被記錄下來,借助深度學習網絡重建為書面語句。結果顯示,AI重現的句子有80%都是正確的。

既然神經信號轉譯為書面語言被證明是可行的,下一步就是要走出實驗室,真正幫助失聲人群“說出心里話”了。麻省理工學院的研發人員就開發了一種植入型智能增強設備,由可穿戴裝置和相關計算系統構成。

設備中的電極可以截取由內部語言所觸發的下頜和面部肌肉運動信號,被反饋到機器學習系統,再由該系統將神經信號與特定的文字相關聯。使用者還可以通過骨傳導耳機,在不中端對話的前提下通過面部振動,將外部信息傳遞到內耳。目前,根據聽眾自身定制的這種可穿戴設備,平均轉錄識別準確率已經達到92%以上!

如果說前面還屬于輔助醫療范疇,到這里就有點開掛的苗頭了。比如在國際象棋比賽中,選手要是戴上這樣一副耳機,不就可以不被察覺地“聽”到計算機給支招嗎?

麻省理工學院媒體實驗室Fluid Interfaces小組的研究員Arnav Kapur演示了AlterEgo項目

評論