語義分割綜述(2)

通過擴張卷積進行多尺度上下文聚合

論文:Multi-Scale Context Aggregation by Dilated Convolutions (ICLR, 2016)

代碼:https://github.com/fyu/dilation

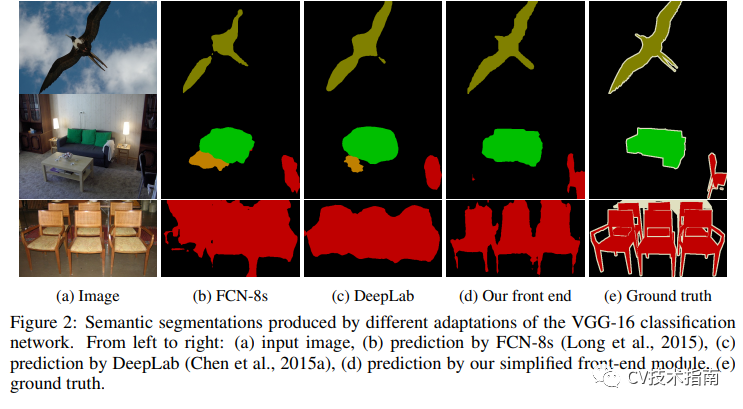

在本文中,開發了一種融合多尺度上下文信息而不損失分辨率的卷積網絡模塊。然后可以將該模塊插入到任何分辨率的現有架構中。該模塊基于擴張卷積。

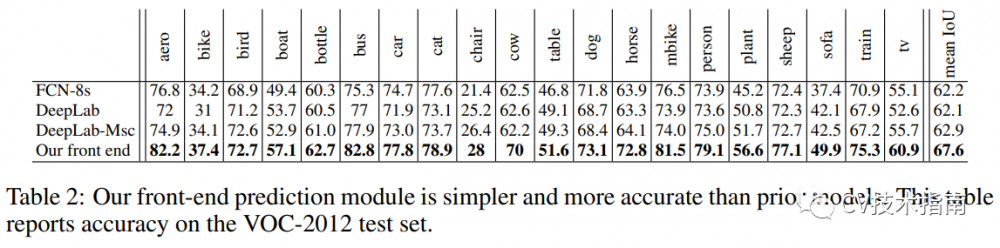

該模塊在 Pascal VOC 2012 數據集上進行了測試。它證明向現有語義分割架構添加上下文模塊可以提高其準確性。

在實驗中訓練的前端模塊在 VOC-2012 驗證集上實現了 69.8% 的平均 IoU,在測試集上實現了 71.3% 的平均 IoU。該模型對不同物體的預測精度如下圖

DeepLab:使用深度卷積網絡、Atrous 卷積和全連接 CRF 進行語義圖像分割

論文:DeepLab: Semantic Image Segmentation with Deep Convolutional Nets, Atrous Convolution, and Fully Connected CRFs (TPAMI, 2017)

代碼:https://github.com/tensorflow/models (非官方)

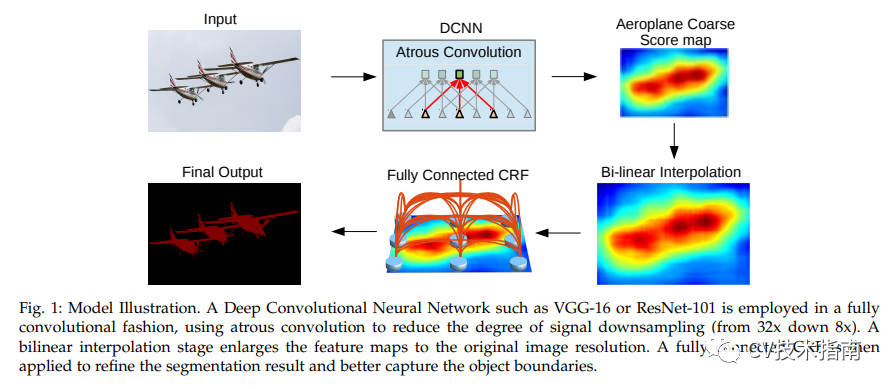

在本文中,作者對深度學習的語義分割任務做出了以下貢獻:

用于密集預測任務的帶有上采樣濾波器的卷積

用于多尺度分割目標的多孔空間金字塔池化 (ASPP)

通過使用 DCNN 改進對象邊界的定位。

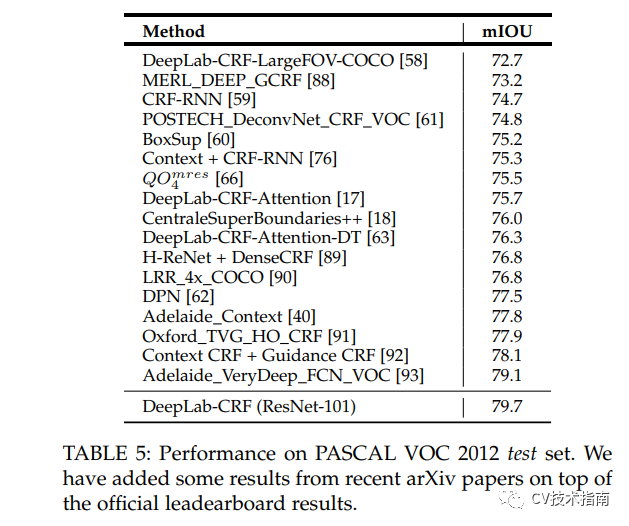

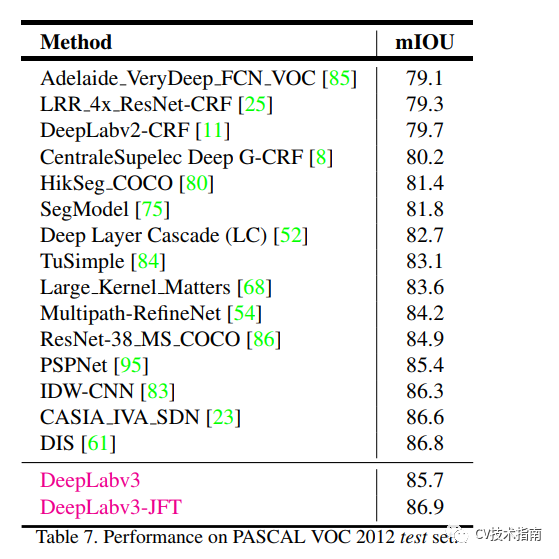

論文提出的 DeepLab 系統在 PASCAL VOC-2012 語義圖像分割任務上實現了 79.7% mIOU。

該論文解決了在語義分割中使用深度 CNN 的主要挑戰,其中包括:

重復組合最大池化和下采樣導致的特征分辨率降低。

多尺度目標的存在。

由于以目標為中心的分類器需要空間變換的不變性,因此 DCNN 的不變性導致定位精度降低。

Atrous 卷積是通過插入零對濾波器進行上采樣或對輸入特征圖進行稀疏采樣來應用的。第二種方法需要對輸入特征圖進行一個等于多孔卷積率 r 的子采樣,并對其進行去隔行掃描以生成 r^2 個降低分辨率的圖,每個 r×r 可能的移位一個。在此之后,標準卷積應用于直接特征圖,將它們與圖像的原始分辨率交錯。

重新思考語義圖像分割的 Atrous 卷積

論文:Rethinking Atrous Convolution for Semantic Image Segmentation (2017)

代碼:https://github.com/pytorch/vision (非官方)

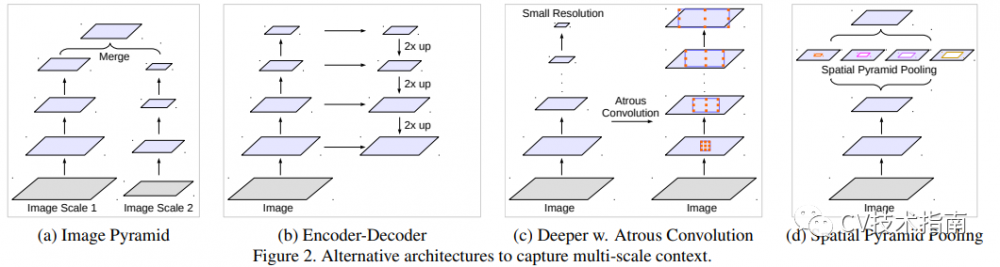

本文解決了使用 DCNN 進行語義分割的兩個挑戰(前面提到過);應用連續池化操作和多個尺度對象的存在時發生的特征分辨率降低。

為了解決第一個問題,論文建議使用atrous卷積,也稱為擴張卷積。它提出使用多孔卷積來擴大視野并因此包括多尺度上下文來解決第二個問題。

該論文的“DeepLabv3”在沒有 DenseCRF 后處理的 PASCAL VOC 2012 測試集上實現了 85.7% 的性能。

用于語義圖像分割的具有 Atrous 可分離卷積的編碼器-****

論文:Encoder-Decoder with Atrous Separable Convolution for Semantic Image Segmentation (ECCV, 2018)

代碼:https://github.com/tensorflow/models

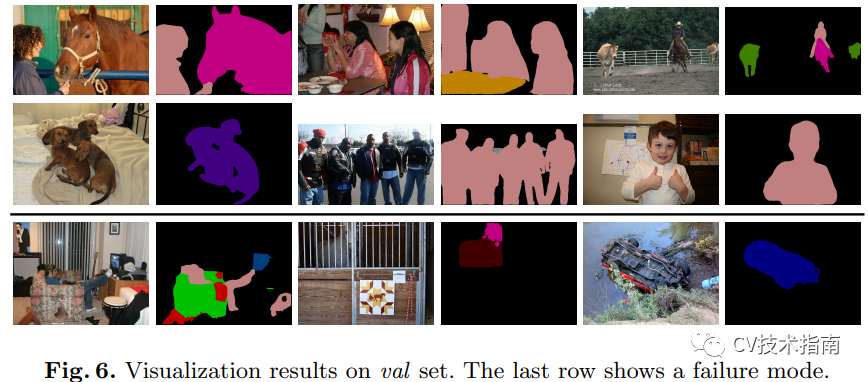

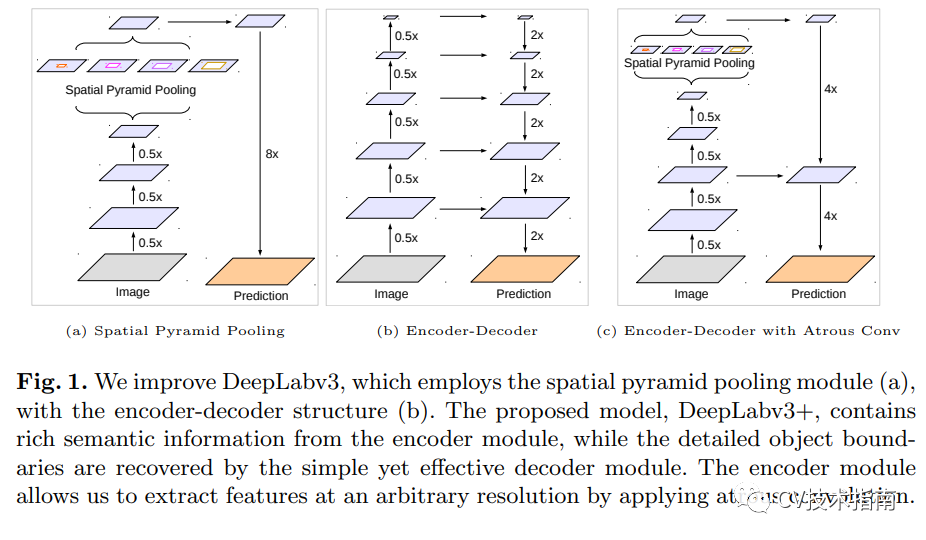

本文的方法“DeepLabv3+”在沒有對 PASCAL VOC 2012 和 Cityscapes 數據集進行任何后處理的情況下實現了 89.0% 和 82.1% 的測試集性能。該模型是 DeepLabv3 的擴展,通過添加一個簡單的****模塊來細化分割結果。

該論文實現了兩種類型的神經網絡,它們使用空間金字塔池化模塊進行語義分割。一種通過匯集不同分辨率的特征來捕獲上下文信息,而另一種則獲得清晰的對象邊界。

*博客內容為網友個人發布,僅代表博主個人觀點,如有侵權請聯系工作人員刪除。