語義分割綜述(3)

FastFCN:重新思考語義分割主干中的擴張卷積

論文:FastFCN: Rethinking Dilated Convolution in the Backbone for Semantic Segmentation (2019)

代碼:https://github.com/wuhuikai/FastFCN

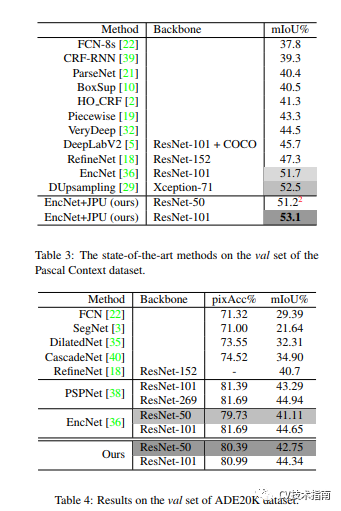

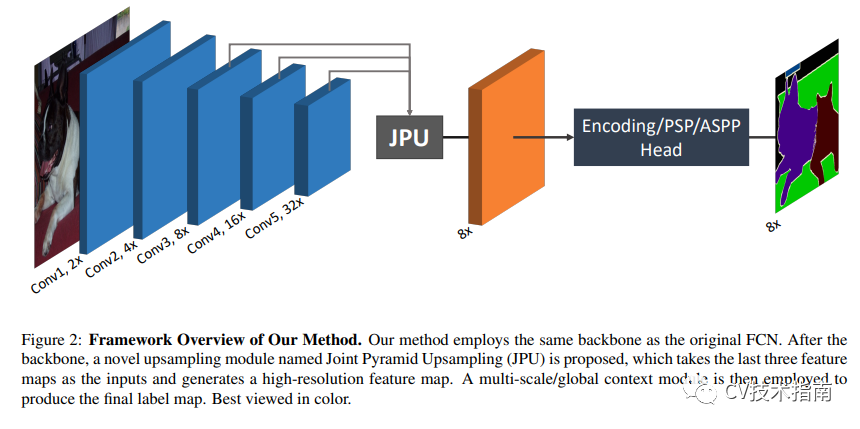

本文提出了一個名為Joint Pyramid Upsampling(JPU)的聯(lián)合上采樣模塊來代替消耗大量時間和內存的擴張卷積。它的工作原理是將提取高分辨率地圖的功能制定為聯(lián)合上采樣問題。

該方法在 Pascal Context 數據集上實現(xiàn)了 53.13% 的 mIoU 性能,并且運行速度提高了 3 倍。

該方法實現(xiàn)了一個全連接網絡(FCN)作為主干,同時應用 JPU 對低分辨率的最終特征圖進行上采樣,從而產生高分辨率的特征圖。用 JPU 替換擴張卷積不會導致任何性能損失。

聯(lián)合采樣使用低分辨率目標圖像和高分辨率引導圖像。然后通過傳輸引導圖像的結構和細節(jié)來生成高分辨率的目標圖像。

通過視頻傳播和標簽松弛改進語義分割

論文:FastFCN: Rethinking Dilated Convolution in the Backbone for Semantic Segmentation (2019)

代碼:https://github.com/NVIDIA/semantic-segmentation

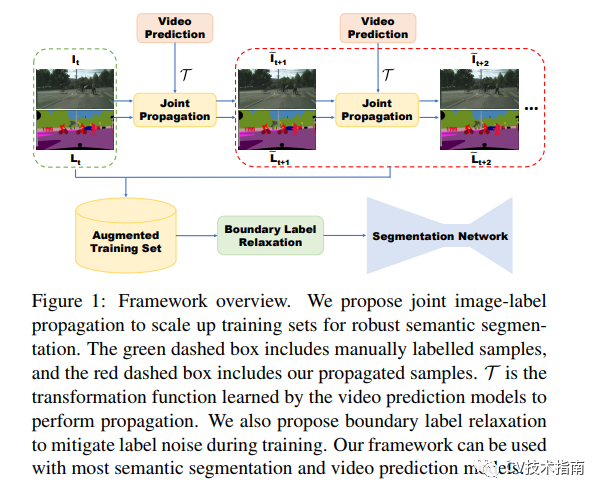

本文提出了一種基于視頻的方法,通過合成新的訓練樣本來擴展訓練集。這旨在提高語義分割網絡的準確性。它探索了視頻預測模型預測未來幀以預測未來標簽的能力。

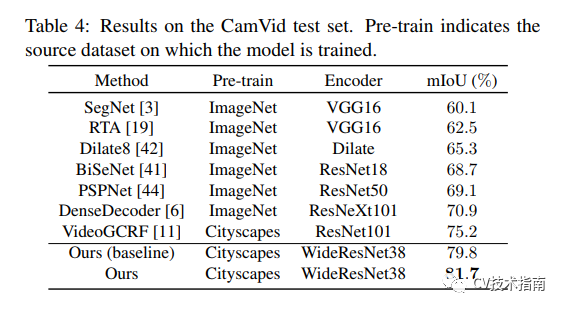

該論文表明,在來自合成數據的數據集上訓練分割網絡可以提高預測精度。本文提出的方法在 Cityscapes 上實現(xiàn)了 83.5% 的 mIoU,在 CamVid 上實現(xiàn)了 82.9%。

論文提出了兩種預測未來標簽的方法:

標簽傳播 (Label Propagation, LP) 通過將傳播的標簽與原始未來幀配對來創(chuàng)建新的訓練樣本

聯(lián)合圖像標簽傳播 (Joint image-label Propagation, JP) 通過將傳播標簽與相應的傳播圖像配對來創(chuàng)建新的訓練樣本

該論文有三個主要命題;利用視頻預測模型將標簽傳播到直接相鄰幀,引入聯(lián)合圖像標簽傳播來處理未對齊問題,并通過最大化沿邊界的類概率并集的可能性來放松單熱標簽訓練。

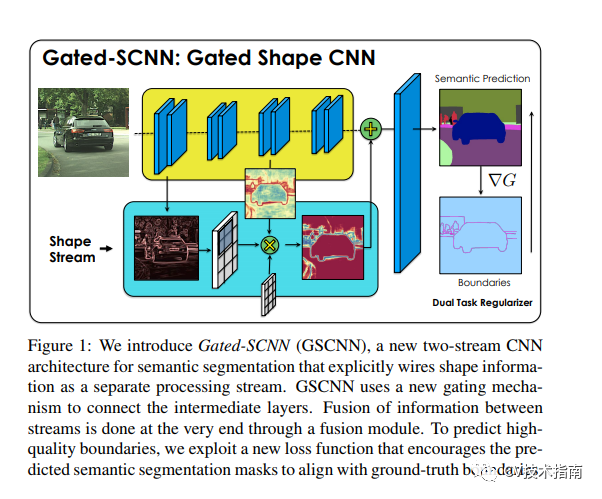

Gated-SCNN:用于語義分割的門控形狀 CNN

論文:Gated-SCNN: Gated Shape CNNs for Semantic Segmentation (2019)

代碼:https://nv-tlabs.github.io/GSCNN/

這篇論文是語義分割塊上的最新成果。作者提出了一種雙流 CNN 架構。在此架構中,形狀信息作為單獨的分支進行處理。此形狀流僅處理與邊界相關的信息。這是由模型的門控卷積層 (GCL) 和本地監(jiān)督強制執(zhí)行的。

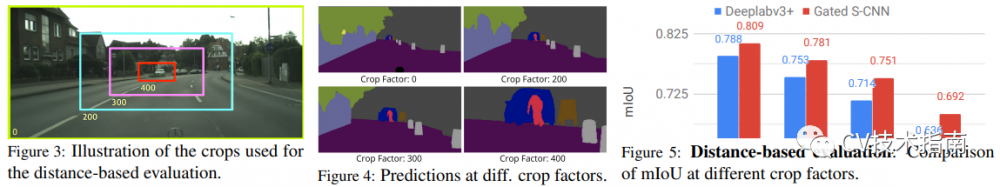

該模型在 mIoU 上比 DeepLab-v3+ 高 1.5%,在 F 邊界得分上高出 4%。該模型已使用 Cityscapes 基準進行評估。在更小更薄的物體上,該模型在 IoU 上實現(xiàn)了 7% 的改進。

下表顯示了 Gated-SCNN 與其他模型相比的性能。

結論

我們現(xiàn)在應該掌握一些最常見的——以及一些最近的——技術,用于在各種上下文中執(zhí)行語義分割。

在公眾號后臺回復關鍵字 “0009” 即可獲取以上論文

原文鏈接:

https://heartbeat.comet.ml/a-2019-guide-to-semantic-segmentation-ca8242f5a7fc

本文僅做學術分享,如有侵權,請聯(lián)系刪文。

*博客內容為網友個人發(fā)布,僅代表博主個人觀點,如有侵權請聯(lián)系工作人員刪除。