dnn 文章 最新資訊

基于自適應軟掩模的語音混合特征增強分析

- 為了提高語音混合特征增強效果,設計了一種以自適應軟掩模與混合特征共同分析算法來實現(xiàn)。以混合特征分析可以消除單一梅爾域濾波器無法提供高頻特征的缺陷。研究結(jié)果表明:選擇融合相位自適應軟掩模方式時,能夠最大程度去除背景噪聲。以本文融合相位差自適應軟掩模可以獲得比IRM更顯著優(yōu)勢,經(jīng)過優(yōu)化處理的語音特征與學習目標構(gòu)建得到的語音增強算法能夠促進語音質(zhì)量的明顯提升。以自適應軟掩模與混合特征訓練神經(jīng)網(wǎng)絡處理獲得優(yōu)秀的信 噪比,達到更優(yōu)的算法性能。

- 關(guān)鍵字: 202308 語音增強 自適應軟掩模 DNN 混合特征

直覺有害!Facbook最新研究:易于解釋的神經(jīng)元會誤導DNN的學習

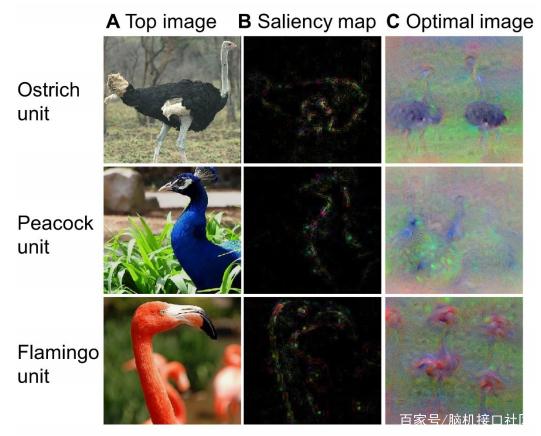

- 編譯|蔣寶尚 關(guān)于AI是什么,學界和業(yè)界已經(jīng)給出了非常多的定義,但是對于AI理解,探討尚不足。換句話說,計算機科學家解釋深度神經(jīng)網(wǎng)絡(DNNs)的能力大大落后于我們利用其取得有用結(jié)果的能力。 當前理解深度神經(jīng)網(wǎng)絡的常見做法是在單個神經(jīng)元特性上“折騰”。例如,激活識別貓圖像的神經(jīng)元,而關(guān)閉其他神經(jīng)元的“控制變量法”。這種方法的學術(shù)術(shù)語叫做“類選擇性”。 由于直觀和易理解,“類選擇性”在學界廣泛應用。誠然,在訓練過程中,這類可解釋的神經(jīng)元確實會“選擇性地”出現(xiàn)在各種不同任務網(wǎng)絡中。例如,預測產(chǎn)品評論

- 關(guān)鍵字: DNN 深度神經(jīng)網(wǎng)絡 深度學習

為什么深度學習如此容易被愚弄?AI研究員正努力修復神經(jīng)網(wǎng)絡缺陷

- 來源:nature 編譯:張大筆茹、小七 假設一輛自動駕駛汽車看到停車標志時并沒有減速,而是加速駛?cè)肓朔泵Φ氖致房冢瑥亩鴮е铝私煌ㄊ鹿省J鹿蕡蟾骘@示,停車標志的表面粘了四個小的矩形標志。這說明一些微小擾動就能愚弄車載人工智能(AI),使其將“停止”一詞誤讀為“限速45”。 目前,此類事件還未發(fā)生,但是人為擾動可能影響AI是非常現(xiàn)實的。研究人員已經(jīng)展示了如何通過粘貼紙來欺騙AI系統(tǒng)誤讀停車標志,或者通過在眼鏡或帽子上粘貼印刷圖案來欺騙人臉識別系統(tǒng),又或者通過在音頻中插入白噪聲使語音識別系統(tǒng)產(chǎn)生錯

- 關(guān)鍵字: DNN 深度神經(jīng)網(wǎng)絡 深度學習

DNNBrain:北師大團隊出品的用于映射深層神經(jīng)網(wǎng)絡到大腦的工具箱

- 導讀深度神經(jīng)網(wǎng)絡(DNN)通過端到端的深度學習策略在許多具有挑戰(zhàn)性的任務上達到了人類水平的性能。深度學習產(chǎn)生了具有多層抽象層次的數(shù)據(jù)表示;然而,它沒有明確地提供任何關(guān)于DNNs內(nèi)部運作的解釋,換句話說它的內(nèi)部運作是一個黑盒子。深度神經(jīng)網(wǎng)絡的成功吸引了神經(jīng)科學家,他們不僅將DNN應用到生物神經(jīng)系統(tǒng)模型中,而且還采用了認知神經(jīng)科學的概念和方法來理解DNN的內(nèi)部表示。盡管可以使用諸如PyTorch和TensorFlow之類的通用深度學習框架來進行此類跨學科研究,但是使用這些框架通常需要高級編程專家和全面的數(shù)學知

- 關(guān)鍵字: DNN 深度神經(jīng)網(wǎng)絡 深度學習 腦機接口

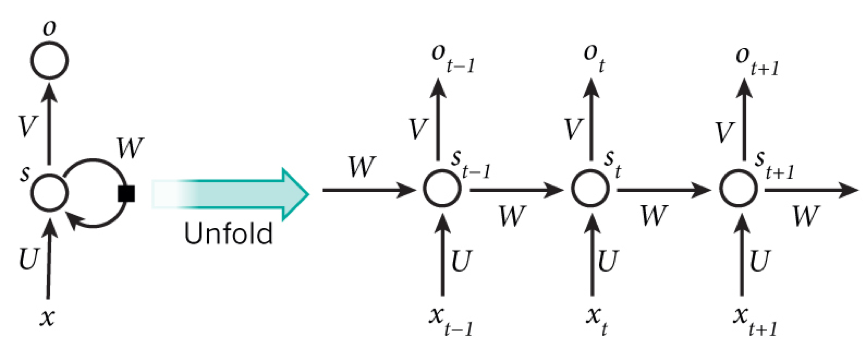

CNN(卷積神經(jīng)網(wǎng)絡)、RNN(循環(huán)神經(jīng)網(wǎng)絡)、DNN(深度神經(jīng)網(wǎng)絡)的內(nèi)部網(wǎng)絡結(jié)構(gòu)的區(qū)別

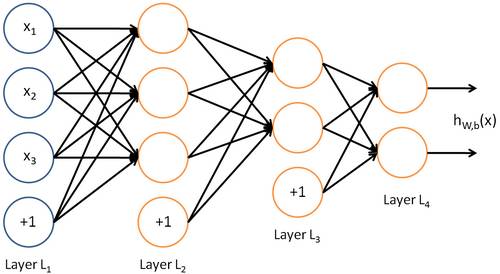

- 先說DNN,從結(jié)構(gòu)上來說他和傳統(tǒng)意義上的NN(神經(jīng)網(wǎng)絡)沒什么區(qū)別,但是神經(jīng)網(wǎng)絡發(fā)展時遇到了一些瓶頸問題。一開始的神經(jīng)元不能表示異或運算,科學家通過增加網(wǎng)絡層數(shù),增加隱藏層可以表達。并發(fā)現(xiàn)神經(jīng)網(wǎng)絡的層數(shù)直接決定了它對現(xiàn)實的表達能力。但是隨著層數(shù)的增加會出現(xiàn)局部函數(shù)越來越容易出現(xiàn)局部最優(yōu)解的現(xiàn)象,用數(shù)據(jù)訓練深層網(wǎng)絡有時候還不如淺層網(wǎng)絡,并會出現(xiàn)梯度消失的問題。我們經(jīng)常使用sigmoid函數(shù)作為神經(jīng)元的輸入輸出函數(shù),在BP反向傳播梯度時,信號量為1的傳到下一層就變成0.25了,到最后面幾層基本無法達到調(diào)節(jié)參數(shù)

- 關(guān)鍵字: DNN 深度神經(jīng)網(wǎng)絡 深度學習 CNN RNN

深度神經(jīng)網(wǎng)絡(DNN)模型與前向傳播算法

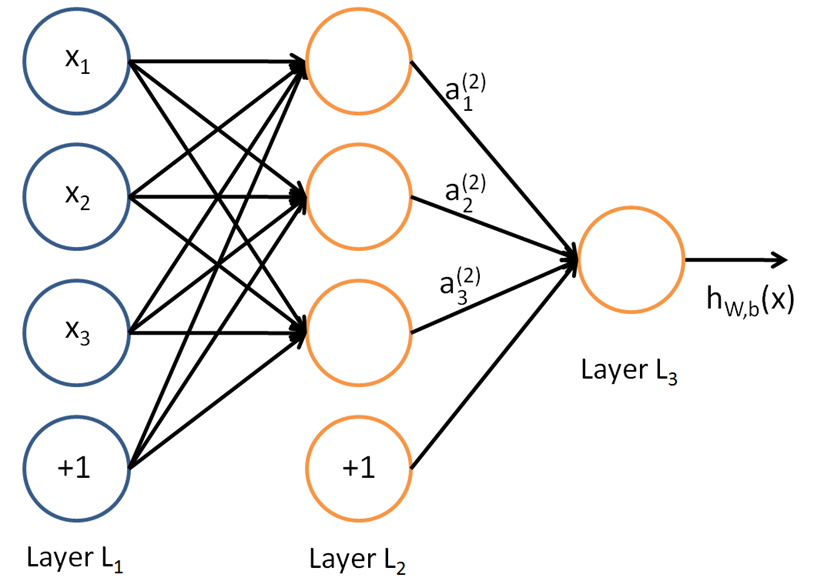

- 深度神經(jīng)網(wǎng)絡(Deep Neural Networks,以下簡稱DNN)是深度學習的基礎,而要理解DNN,首先我們要理解DNN模型,下面我們就對DNN的模型與前向傳播算法做一個總結(jié)。 1.從感知機到神經(jīng)網(wǎng)絡 在感知機原理小結(jié)中,我們介紹過感知機的模型,它是一個有若干輸入和一個輸出的模型,如下圖: 輸出和輸入之間學習到一個線性關(guān)系,得到中間輸出結(jié)果: z=∑i=1mwixi+bz=∑i=1mwixi+b 接著是一個神經(jīng)元激活函數(shù): sign(z)={?11z<0z≥0sign(z)={

- 關(guān)鍵字: DNN 深度神經(jīng)網(wǎng)絡 深度學習

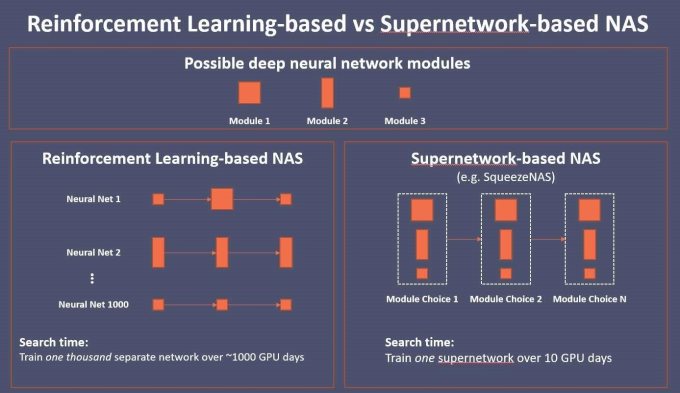

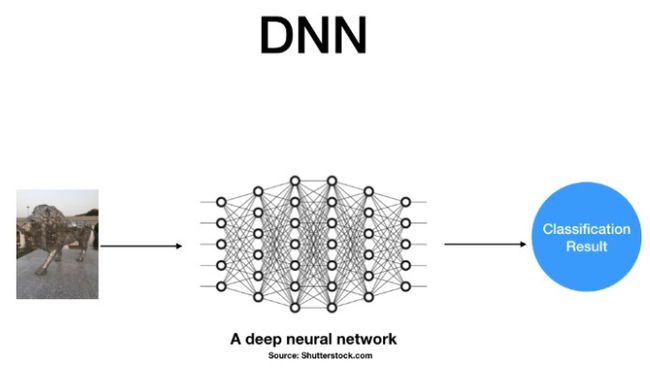

什么是DNN?它對AI發(fā)展意味著什么

- 為了讓AI加速器在最短延遲內(nèi)達到最佳精準度,特別是在自動駕駛車中,TFLOP已經(jīng)成為許多所謂大腦芯片的關(guān)鍵指針,然而,有專家認為這種野蠻處理方式并不可持續(xù)…… 為了讓人工智能(AI)加速器在最短延遲內(nèi)達到最佳精準度,特別是在自動駕駛車(AV)中,TFLOP(兆次浮點運算)已經(jīng)成為許多所謂大腦芯片的關(guān)鍵指針。這場競賽的選手包括Nvidia的Xavier、Mobileye的EyeQ5、特斯拉(Tesla)的全自動駕駛(FSD)計算機芯片,以及NXP-Kalray芯片。然而,有專家認為這種野蠻處理方式

- 關(guān)鍵字: DNN 深度神經(jīng)網(wǎng)絡 深度學習

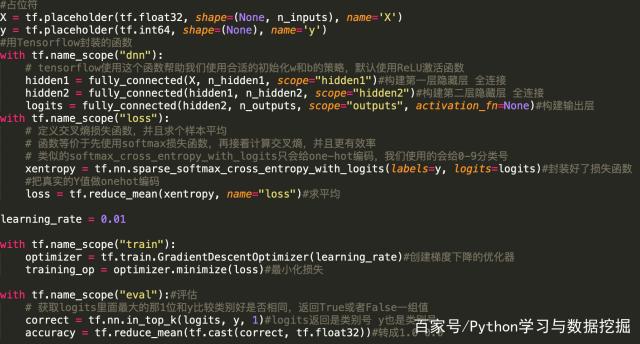

深度學習干貨|基于Tensorflow深度神經(jīng)網(wǎng)絡(DNN)詳解

- 深度神經(jīng)網(wǎng)絡(Deep Neural Networks,簡稱DNN)是深度學習的基礎,想要學好深度學習,首先我們要理解DNN模型。DNN的基本結(jié)構(gòu)神經(jīng)網(wǎng)絡是基于感知機的擴展,而DNN可以理解為有很多隱藏層的神經(jīng)網(wǎng)絡。多層神經(jīng)網(wǎng)絡和深度神經(jīng)網(wǎng)絡DNN其實也基本一樣,DNN也叫做多層感知機(MLP)。DNN按不同層的位置劃分,神經(jīng)網(wǎng)絡層可以分為三類,輸入層,隱藏層和輸出層,如下圖示例,一般來說第一層是輸入層,最后一層是輸出層,而中間的層數(shù)都是隱藏層。網(wǎng)絡結(jié)構(gòu)層與層之間是全連接的,也就是說,第i層的任意一個神經(jīng)

- 關(guān)鍵字: DNN 深度神經(jīng)網(wǎng)絡 深度學習

Facebook AI新研究:可解釋神經(jīng)元或許會阻礙DNN的學習

- Facebook AI 近期更新博客介紹了一篇新論文,即研究人員通過實驗發(fā)現(xiàn)「易于解釋的神經(jīng)元可能會阻礙深層神經(jīng)網(wǎng)絡的學習」。為了解決這些問題,他們提出了一種策略,通過可偽造的可解釋性研究框架的形式來探討出現(xiàn)的問題。 人工智能模型到底「理解」了什么內(nèi)容,又是如何「理解」的呢? 回答這個問題對于改進人工智能系統(tǒng)來說至關(guān)重要。而不幸的是,計算機科學家解釋深層神經(jīng)網(wǎng)絡(DNN)的能力遠遠落后于我們用它們實現(xiàn)有用結(jié)果的能力。 一種常見的理解DNN的方法集中在單個神經(jīng)元的屬性上,例如,尋找出一個單獨的神經(jīng)元,

- 關(guān)鍵字: Facebook AI DNN

Gartner公布十大戰(zhàn)略物聯(lián)網(wǎng)技術(shù)和趨勢

- Gartner今天強調(diào)了最重要的幾大戰(zhàn)略物聯(lián)網(wǎng)(IoT)技術(shù)趨勢,并稱這些趨勢將推動2018年至2023年期間的數(shù)字業(yè)務創(chuàng)新。 Gartner研究副總裁Nick Jones表示:“物聯(lián)網(wǎng)將繼續(xù)為未來十年的數(shù)字業(yè)務創(chuàng)新提供新的機遇,其中很多創(chuàng)新將通過新技術(shù)或改進技術(shù)實現(xiàn)。那些掌握了創(chuàng)新物聯(lián)網(wǎng)趨勢的CIO們才有機會在其業(yè)務中領導數(shù)字化創(chuàng)新。” 此外,CIO們應該確保他們擁有必要的技能和合作伙伴,以支持關(guān)鍵的新興物聯(lián)網(wǎng)趨勢和技術(shù),因為到2023年CIO們負責的端點數(shù)量將是今年的3倍多。 Gartner

- 關(guān)鍵字: DNN 物聯(lián)網(wǎng)(

人類和DNN的目標識別穩(wěn)健性比較

- 深度神經(jīng)網(wǎng)絡在很多任務上都已取得了媲美乃至超越人類的表現(xiàn),但其泛化能力仍遠不及人類。德國蒂賓根大學等多所機構(gòu)近期的一篇論文對人類和 DNN 的目標識別穩(wěn)健性進行了行為比較,并得到了一些有趣的見解。機器之心對該論文進行了編譯介紹。 摘要 我們通過 12 種不同類型的圖像劣化(image degradation)方法,比較了人類與當前的卷積式深度神經(jīng)網(wǎng)絡(DNN)在目標識別上的穩(wěn)健性。首先,對比三種著名的 DNN(ResNet-152、VGG-19、GoogLeNet),我們發(fā)現(xiàn)不管對圖像進行怎樣的操

- 關(guān)鍵字: DNN 深度神經(jīng)網(wǎng)絡

深度神經(jīng)網(wǎng)絡(DNN)是否模擬了人類大腦皮層結(jié)構(gòu)?

- 概要:人工智能交融了諸多學科,而目前對人工智能的探索還處于淺層面,我們需要從不同角度和層次來思考,比如人工智能和大腦的關(guān)系。 神經(jīng)元 在深度學習領域,神經(jīng)元是最底層的單元,如果用感知機的模型, wx + b, 加上一個激活函數(shù)構(gòu)成了全部,輸入和輸出都是數(shù)字,研究的比較清楚。別的不說,在參數(shù)已知的情況下,有了輸入可以計算輸出,有了輸出可以計算輸入。 但在神經(jīng)科學領域,神經(jīng)元并不是最底層的單位。 舉例來說,有人在做神經(jīng)元膜離子通道相關(guān)的工作。一個神經(jīng)元的輸入,可以分為三部分,從其他

- 關(guān)鍵字: DNN 深度學習

| 共13條 1/1 1 |

dnn介紹

深度神經(jīng)網(wǎng)絡(Deep Neural Networks,簡稱DNN)是深度學習的基礎。DNN的基本結(jié)構(gòu) 神經(jīng)網(wǎng)絡是基于感知機的擴展,而DNN可以理解為有很多隱藏層的神經(jīng)網(wǎng)絡。多層神經(jīng)網(wǎng)絡和深度神經(jīng)網(wǎng)絡DNN其實也基本一樣,DNN也叫做多層感知機(MLP)。 DNN按不同層的位置劃分,神經(jīng)網(wǎng)絡層可以分為三類,輸入層,隱藏層和輸出層,如下圖示例,一般來說第一層是輸入層,最后一層是輸出層,而中間的層 [ 查看詳細 ]

關(guān)于我們 -

廣告服務 -

企業(yè)會員服務 -

網(wǎng)站地圖 -

聯(lián)系我們 -

征稿 -

友情鏈接 -

手機EEPW

Copyright ?2000-2015 ELECTRONIC ENGINEERING & PRODUCT WORLD. All rights reserved.

《電子產(chǎn)品世界》雜志社 版權(quán)所有 北京東曉國際技術(shù)信息咨詢有限公司

京ICP備12027778號-2 北京市公安局備案:1101082052 京公網(wǎng)安備11010802012473

京ICP備12027778號-2 北京市公安局備案:1101082052 京公網(wǎng)安備11010802012473

Copyright ?2000-2015 ELECTRONIC ENGINEERING & PRODUCT WORLD. All rights reserved.

《電子產(chǎn)品世界》雜志社 版權(quán)所有 北京東曉國際技術(shù)信息咨詢有限公司