語義分割綜述(1)

作者:Derrick Mwiti

編譯:CV技術指南

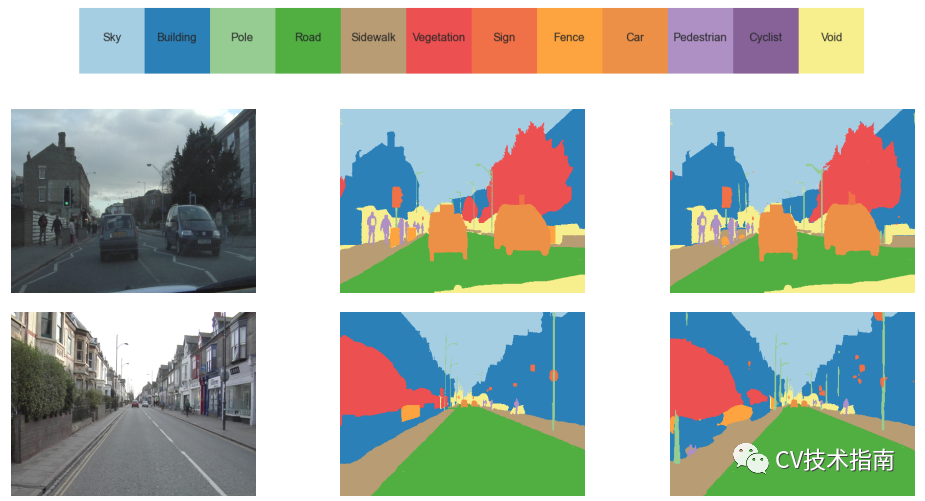

語義分割 (Semantic segmentation) 是指將圖像中的每個像素鏈接到類標簽的過程。這些標簽可能包括人、車、花、家具等。

我們可以將語義分割視為像素級別的圖像分類。例如,在有很多汽車的圖像中,分割會將所有對象標記為汽車對象。然而,稱為實例分割 (instance segmentation) 的單獨類別的模型能夠標記對象出現在圖像中的單獨實例。這種分割在用于計算目標數量的應用中非常有用,例如計算商場中的人流量。

它的一些主要應用是自動駕駛汽車、人機交互、機器人技術和照片編輯/創意工具。例如,語義分割在自動駕駛汽車和機器人技術中非常重要,因為模型理解其運行環境中的上下文非常重要。

"Two men riding on a bike in front of a building on the road. And there is a car."

本文將介紹一些關于構建語義分割模型的最新方法的研究論文,即:

Weakly- and Semi-Supervised Learning of a Deep Convolutional Network for Semantic Image Segmentation

Fully Convolutional Networks for Semantic Segmentation

U-Net: Convolutional Networks for Biomedical Image Segmentation

The One Hundred Layers Tiramisu: Fully Convolutional DenseNets for Semantic Segmentation

Multi-Scale Context Aggregation by Dilated Convolutions

DeepLab: Semantic Image Segmentation with Deep Convolutional Nets, Atrous Convolution, and Fully Connected CRFs

Rethinking Atrous Convolution for Semantic Image Segmentation

Encoder-Decoder with Atrous Separable Convolution for Semantic Image Segmentation

FastFCN: Rethinking Dilated Convolution in the Backbone for Semantic Segmentation

Improving Semantic Segmentation via Video Propagation and Label Relaxation

Gated-SCNN: Gated Shape CNNs for Semantic Segmentation

文末附以上論文的下載方式

用于語義圖像分割的深度卷積網絡的弱監督和半監督學習

論文:Weakly- and Semi-Supervised Learning of a Deep Convolutional Network for Semantic Image Segmentation (ICCV, 2015)

代碼:https: //bitbucket.org/deeplab/deeplab-public

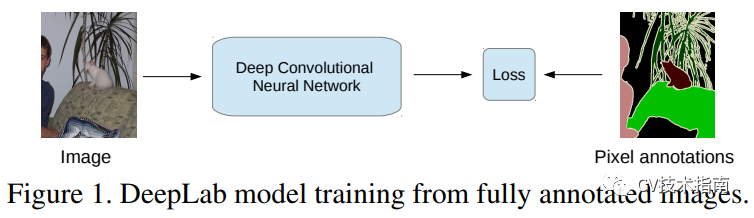

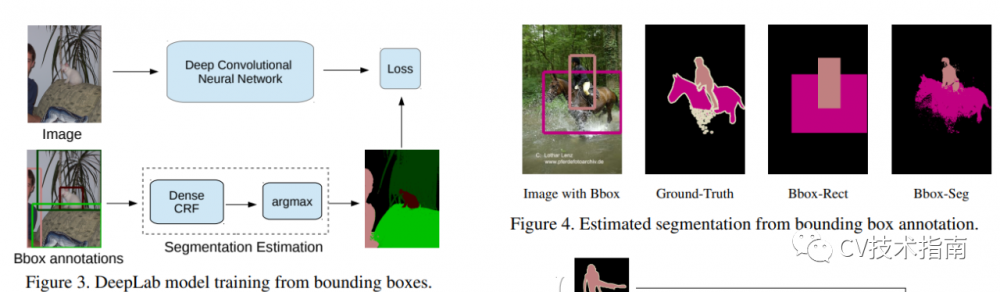

本文針對在深度卷積神經網絡 (CNN) 中處理弱標記數據以及標記良好的數據和未正確標記的數據的組合提出了一種解決方案。

在論文中,應用了深度 CNN 與全連接條件隨機場的組合。

在 PASCAL VOC 分割基準上,該模型給出了高于 70% 的平均交并比 (mean intersection-over-union, IOU) 分數。這種模型面臨的主要挑戰之一是它需要在訓練期間在像素級別進行注釋的圖像。

本文的主要貢獻是:

引入可應用于弱監督和半監督設置的邊界框或圖像級訓練的期望最大化算法。

證明結合弱注釋和強注釋可以提高性能。在合并來自 MS-COCO 數據集和 PASCAL 數據集的注釋后,本文作者在 PASCAL VOC 2012 上達到了 73.9% 的 IOU 性能。

證明他們的方法通過合并少量像素級注釋圖像和大量邊界框或圖像級注釋圖像來實現更高的性能。

用于語義分割的全卷積網絡

論文:Fully Convolutional Networks for Semantic Segmentation(PAMI,2016)

代碼:http://fcn.berkeleyvision.org

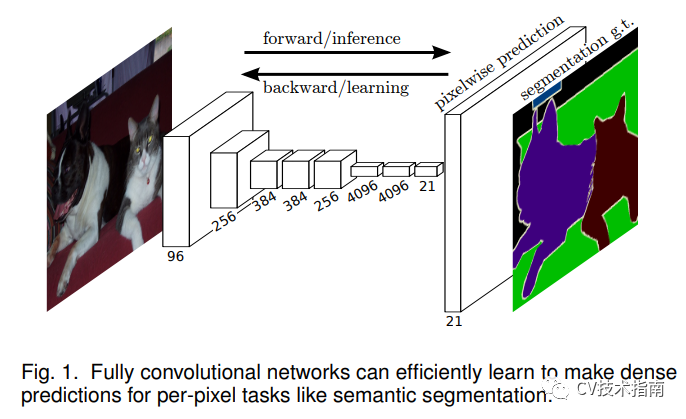

本文提出的模型在 PASCAL VOC 2012 上實現了 67.2% 平均 IU 的性能。

全連接網絡獲取任意大小的圖像并生成相應空間維度的輸出。在這個模型中,ILSVRC 分類器被投射到完全連接的網絡中,并使用像素級損失和網絡內上采樣來增強密集預測。然后通過微調完成分割訓練。微調是通過在整個網絡上的反向傳播來完成的。

U-Net:用于生物醫學圖像分割的卷積網絡

論文:U-Net: Convolutional Networks for Biomedical Image Segmentation (MICCAI, 2015)

代碼:http://lmb.informatik.uni-freiburg.de/people/ronneber/u-net

在生物醫學圖像處理中,為圖像中的每個細胞獲得一個類別標簽是非常重要的。生物醫學任務中最大的挑戰是難以獲取數千張用于訓練的圖像。

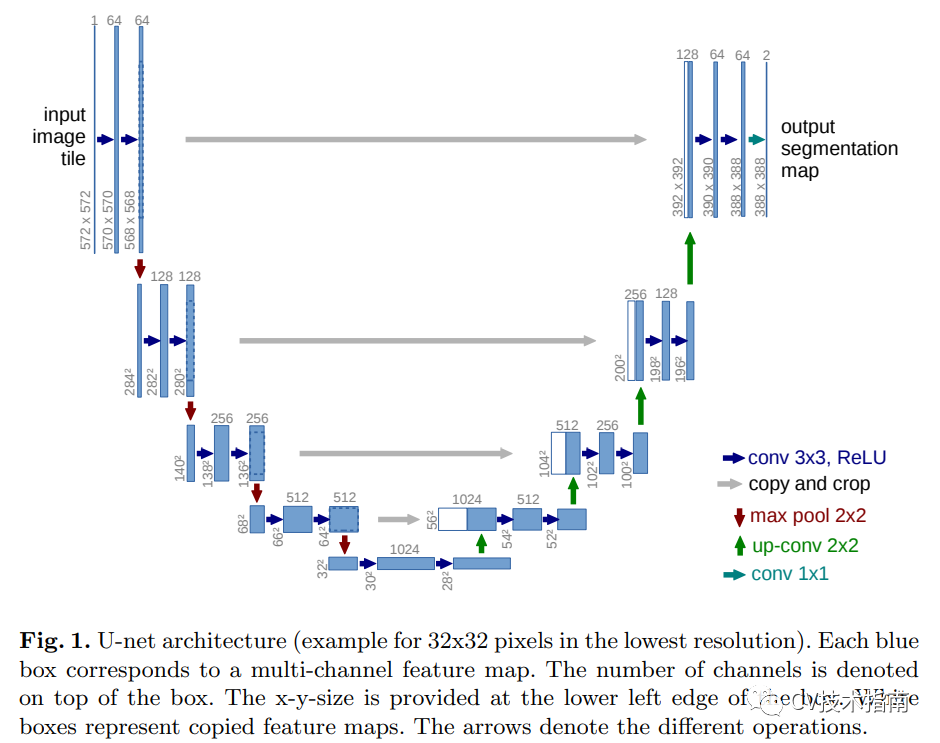

本文建立在完全卷積層的基礎上并對其進行修改以處理一些訓練圖像并產生更精確的分割。

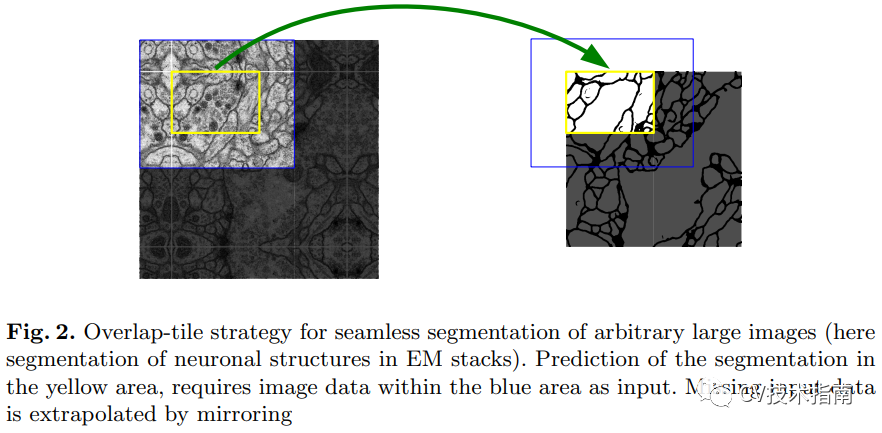

由于可用的訓練數據很少,因此該模型通過對可用數據應用彈性變形來使用數據增強。如上圖 1 所示,網絡架構由左側的收縮路徑和右側的擴展路徑組成。

收縮路徑由兩個 3x3 卷積組成。每個卷積之后是一個整流線性單元和一個用于下采樣的 2x2 最大池化操作。每個下采樣階段都會使特征通道的數量增加一倍。擴展路徑步驟包括特征通道的上采樣。接著是 2x2 上卷積,將特征通道的數量減半。最后一層是 1x1 卷積,用于將組件特征向量映射到所需數量的類。

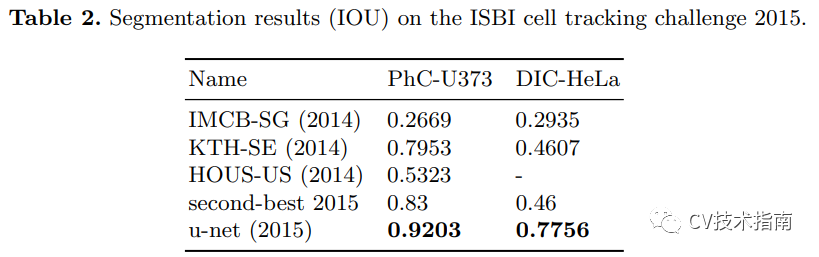

在這個模型中,訓練是使用輸入圖像、它們的分割圖和 Caffe 的隨機梯度下降實現來完成的。當使用很少的訓練數據時,數據增強用于教導網絡所需的魯棒性和不變性。該模型在其中一項實驗中取得了 92% 的平均 IOU 分數。

一百層Tiramisu:用于語義分割的全卷積 DenseNets

論文:The One Hundred Layers Tiramisu: Fully Convolutional DenseNets for Semantic Segmentation (2017)

代碼:https://github.com/SimJeg/FC-DenseNet

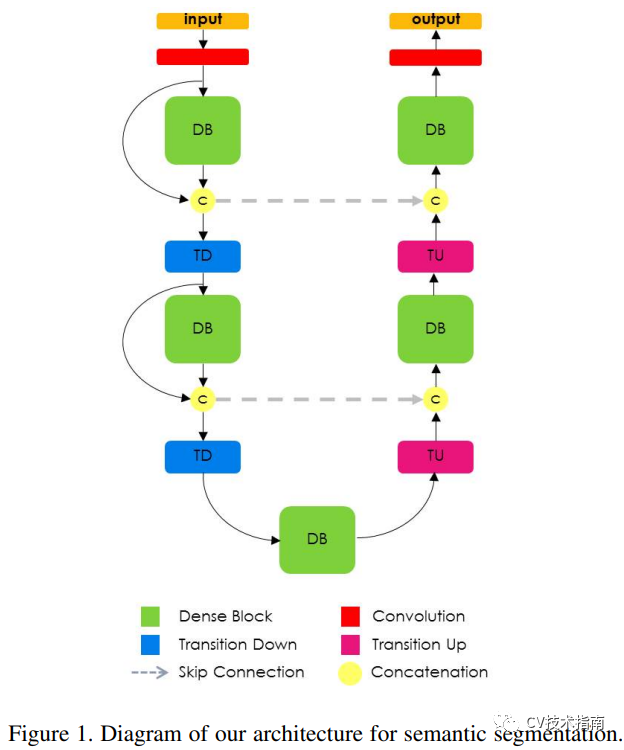

DenseNets 背后的想法是讓每一層以前饋方式連接到每一層,使網絡更容易訓練和更準確。

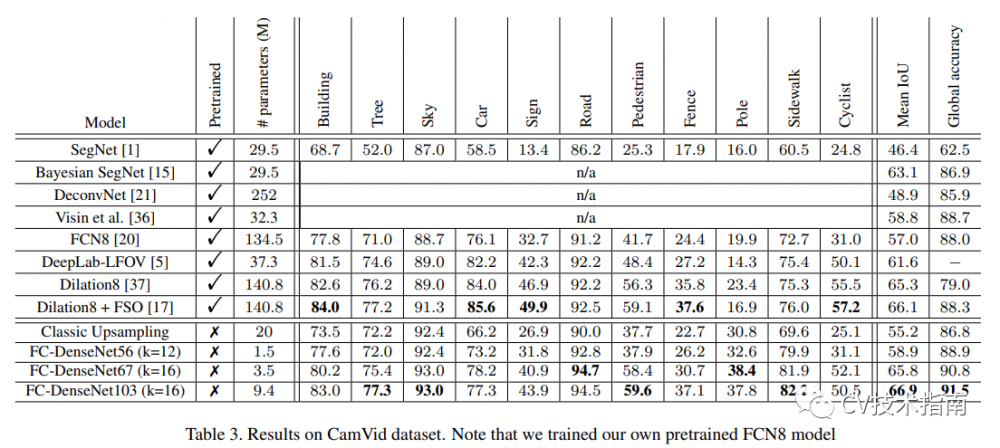

該模型的架構建立在密集的下采樣和上采樣路徑塊中。下采樣路徑有 2 個向下轉換 (TD),而上采樣路徑有 2 個向上轉換 (TU)。圓圈和箭頭代表網絡內的連接模式。

本文的主要貢獻是:

將 DenseNet 架構擴展到完全卷積網絡,用于語義分割。

從密集網絡中提出比其他上采樣路徑表現更好的上采樣路徑。

證明該網絡可以在標準基準測試中產生SOTA結果。

該模型在 CamVid 數據集上實現了 88% 的全局準確率。

*博客內容為網友個人發布,僅代表博主個人觀點,如有侵權請聯系工作人員刪除。