英偉達最強AI芯片H200性能翻倍 AMD出師未捷身先死?

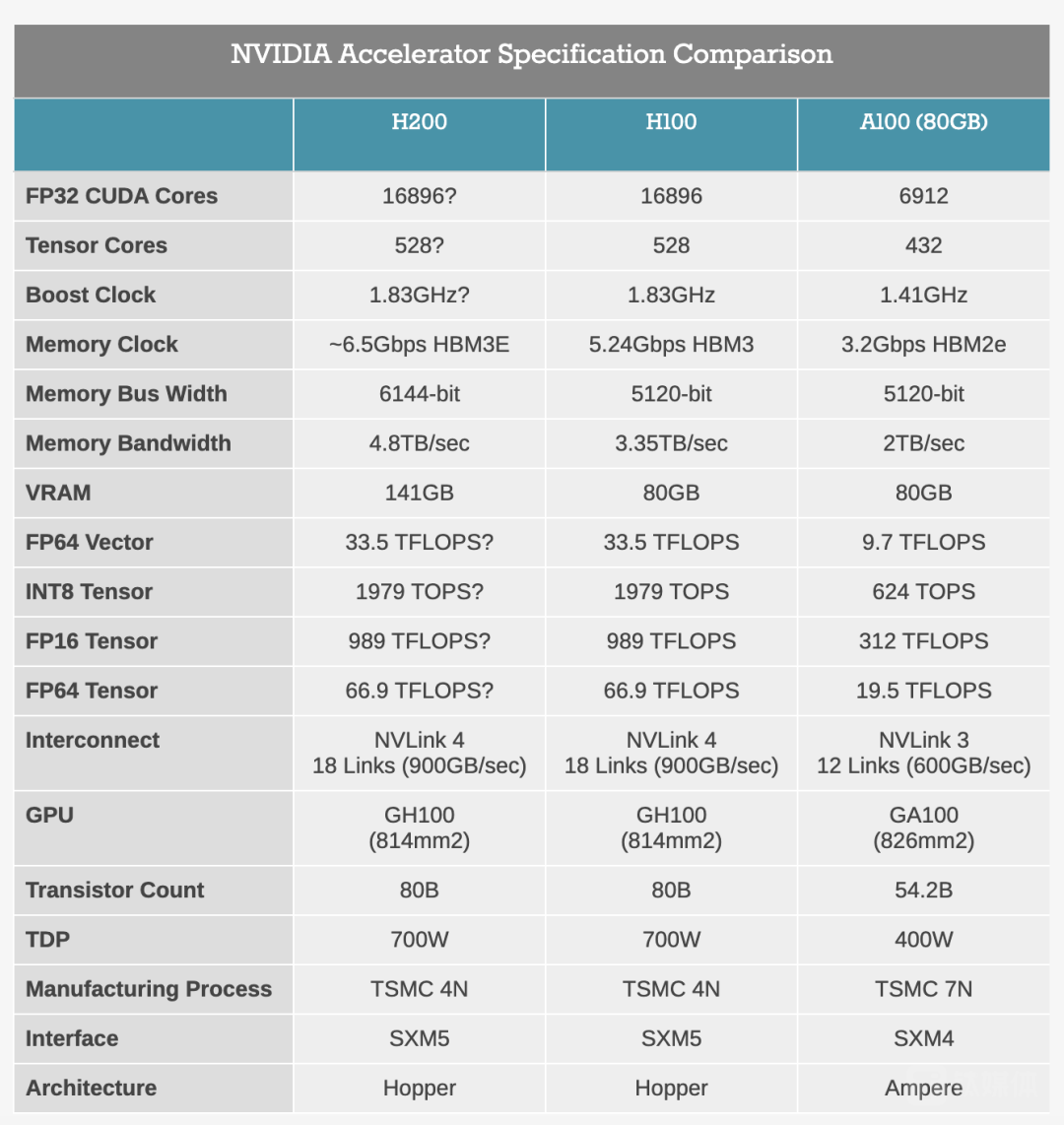

11月13日,英偉達推出新一代AI旗艦芯片H200,是在目前市場上最強AI芯片H100的基礎上進行了大升級。H200擁有141GB的內存幾乎是H100最高80GB內存的2倍,4.8TB/s的帶寬也顯著高于H100的3.35TB/s。

本文引用地址:http://www.104case.com/article/202311/453385.htm在推理速度上H200幾乎達到了H100的兩倍,英偉達表示根據使用Meta的70B大模型Llama 2進行測試,H200的輸出速度幾乎是H100的兩倍。根據官方發布的圖片,H200在大模型Llama 2、GPT-3.5的輸出速度上分別是H100的1.9倍和1.6倍,在高性能計算HPC方面的速度更是達到了雙核x86 CPU的110倍。

因為使用基于與H100相同的Hopper架構,H200將具有H100的一切功能,例如可以用來加速基于Transformer架構搭建的深度學習模型的Transformer Engine功能。這意味著那些已經在使用H100進行訓練的AI公司無需更改他們的服務器系統或軟件即可適應H200。

卷內存?H200最大升級HBM3

H200最大的變化就是內存 —— 首次搭載“世界上最快的內存”HBM3e,在性能上得到了直接提升,速度更快、容量更大,使其更適用于大型語言模型。

什么是HBM?

由于處理器與存儲器的工藝、封裝、需求的不同,過去20年中二者之間的性能差距越來越大,硬件的峰值計算能力增加了90000倍,但是內存/硬件互連帶寬卻只是提高了30倍。當存儲的性能跟不上處理器時,對指令和數據搬運(寫入和讀出)的時間是處理器運算所消耗時間的幾十倍乃至幾百倍,內存帶寬就是處理器可以從內存讀取數據或將數據存儲到內存的速率。可以想象一下,數據傳輸就像處在一個巨大的漏斗之中,不管處理器灌進去多少,存儲器都只能“細水長流”。

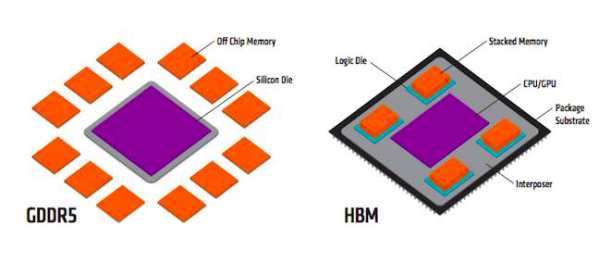

GDDR采用傳統方法是將標準PCB和測試的DRAMs與SoC連接在一起,以較窄的通道提供更高的數據速率,進而實現必要的吞吐量,具有一定的帶寬和良好的能耗效率。而隨著AI等新需求的出現以及風靡,為了讓數據傳輸更快,對帶寬的要求更高了,GDDR開始不夠用了。按照GDDR現有的模式很難有突破性的帶寬進展,于是,HBM出現了。

HBM其實就是將DDR芯片堆疊在一起后和GPU封裝在一起,實現大容量、高位寬的DDR組合陣列。超高的帶寬讓HBM成為了高性能GPU的核心組件,讓更大的模型、更多的參數留在離核心計算更近的地方,從而減少內存和存儲解決方案帶來的延遲。自從去年ChatGPT出現以來,HBM作為AI服務器的“標配”,更是開始狠刷存在感。

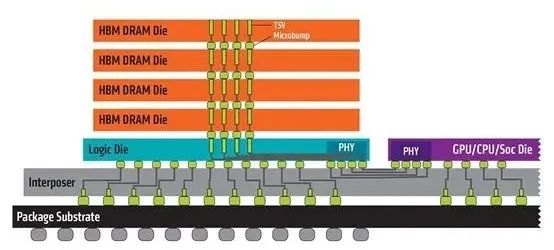

3D堆疊技術的出現才讓HBM能夠實現這樣的布局:將DRAM裸片像摩天大樓一樣垂直堆疊,并通過硅通孔(ThroughSiliconVia,簡稱“TSV”)技術將“每層樓”連接在一起,貫通所有芯片層的柱狀通道傳輸信號、指令、電流,以增加吞吐量并克服單一封裝內帶寬的限制。采用3D堆疊技術之后,其直接結果就是接口變得更寬,其下方互聯的觸點數量遠遠多于DDR內存連接到CPU的線路數量。

不過,這也意味著更高的成本,在沒有考慮封測成本的情況下,HBM的成本是GDDR的三倍左右。HBM發展制約因素正是高成本,一些高級計算引擎上的HBM內存成本往往比芯片本身還要高,因此自然面臨很大的阻力。

“半代”升級?算力提升并不明顯

在同架構之下,H200的浮點運算速率基本上和H100相同,核心GPU運算數據與H100完全一致。客觀來說,H200相較H100在算力方面提升并不明顯,可能只算“半代”升級。然而,在大模型推理表現上,H200提升卻極其明顯。

英偉達H200、H100和A100的性能規格對比(來源:anandtech)

H200重點放在提升推理方面的能力,再次證明英偉達的刀法依舊精準。隨著AI技術的不斷發展和應用,AI芯片市場的競爭越來越激烈,H200芯片的發布,進一步鞏固了英偉達在AI芯片市場的領先地位。英偉達只有通過不斷推出更高性能的AI芯片,增強市場競爭力,才能夠在市場競爭中持續保持領先地位。那么,為什么英偉達突然選擇卷起內存了呢?

AMD緊隨其后:搶先推出Instinct MI300X

隨著ChatGPT的橫空出世,全球掀起了AI大模型熱潮,以GPU為代表的算力芯片供不應求。在全球GPU主要廠商中,英偉達市場占有率高達86%,而僅次于英偉達的就是AMD。AMD雖然在GPU市場名列第二,但其產品主要應用于圖形處理、消費級產品等傳統GPU應用場景,在AI和高性能計算領域始終沒有什么存在感。

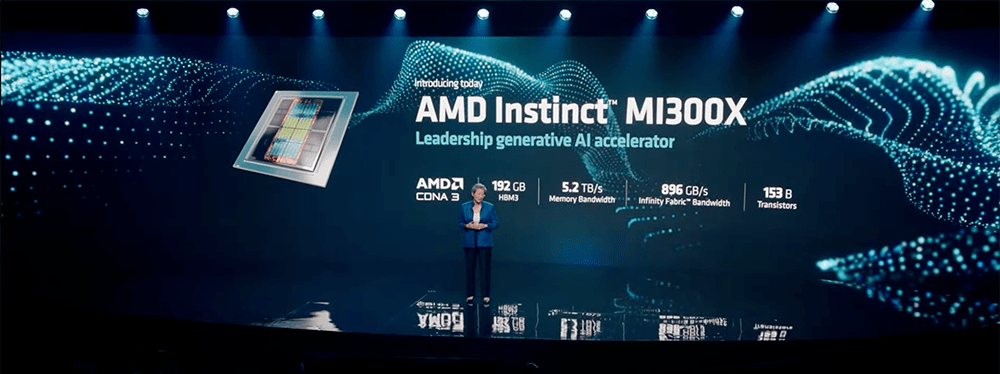

大模型時代,AMD等來了一個翻身機遇。在今年6月,AMD專門針對AI大模型訓練需求,在英偉達之前搶先推出了大殺器 —— Instinct MI300。相比前代產品,MI300X擁有高達192GB的HBM3內存以及5.2TB/s帶寬。MI300X提供的HBM密度是英偉達H100的2.4倍,HBM帶寬是H100的1.6倍,意味著在MI300X上可以訓練比H100更大的模型,單張加速卡可運行一個400億參數的模型。

其實早在2016年,AMD就推出Radeon Instinct系列產品線,旨在加速深度學習、神經網絡和高性能計算等方面應用。然而AMD顯然不夠“上心”,在之后的4年間時間里,Radeon Instinct系列雖然不斷更新,但卻始終與AMD的消費級顯卡Radeon公用基礎架構,在計算方面缺乏針對性和高效率,難以滿足AI訓練的需求。

直到2020年,AMD將AI芯片產品線更名為“Instinct”,并首次拋棄了以往的消費級顯卡架構,采用了專門設計的CNDA計算架構。在此之后,AMD連續更新了三代產品MI100、MI200以及最新發布的MI300。憑借全新的技術路線,以及高性價比的市場策略,AMD才開始在AI訓練市場中有人問津。

目前AMD正在搶抓英偉達缺席后的空白,試圖憑借空前強大的芯片新品和難得的產業機遇,攻入英偉達的腹地。為了保證不被超越,這也許就是H200突然卷起內存的原因吧。此前,AMD表示MI300正在今年第三季度向客戶提供樣品,產量將在第四季增加。如果AMD真的能夠在第四季度提高產量并成功推出MI300芯片,那么它有望迎來強勁的需求。因為英偉達H100芯片的供不應求,大公司需要“第二供應商”的戰略將為AMD提供機遇,AMD可以有效填補供需缺口,憑借可得性贏得業務。

甲骨文公司就計劃采用雙源采購策略,即同時從英偉達和AMD兩家公司購買AI芯片。在明年,甲骨文公司將優先考慮購買AMD的產品,這是因為英偉達因市場需求巨大而未能達到甲骨文公司預定的采購目標。在此前的發布會上蘇姿豐表現得十分有信心:“我們認為,數據中心人工智能加速器將以超過50%的復合年增長率,從今年的300億美元左右增長到2027年的1500億美元以上。”MI300被寄予厚望,將成為該公司“有史以來最快達成10億美元銷售額的產品”。

從MI300的性能指標而言,AMD已經幾乎具備了與英偉達叫板的能力,直到H200橫空出世。在未來,AMD想要在如火如荼的AI技術市場中搶得一席之地,面前的壓力仍毋庸多言。至今AMD尚未公布MI300的官方定價,市場預計為了增加與英偉達的競爭籌碼,AMD MI300或許不得不延續其在傳統GPU市場的性價比路線。

潛在的壟斷消失?CUDA生態壁壘很難打破

最關鍵的問題在于英偉達能否為市場提供足夠的H200,或者它們是否會像H100一樣在供應量上受到限制,并沒有明確的答案。考慮到目前高性能GPU服務器仍然緊缺,在AMD發布更便宜且性能不差的競品后,英偉達的壟斷還能維持多久?

英偉達在2006年推出的通用并行計算架構CUDA,借助CUDA提供的編程接口和工具集等,開發者可以基于GPU芯片編程、運行復雜的AI算法等等。雖然H100的壟斷地位導致服務器間兼容性問題,但英偉達在AI領域樹立的最大優勢還是從語言設計到開發者工具這些構成的生態壁壘,周邊工具一旦被用戶所接受,客戶技術遷移的成本將會是難以想象的。

即使AMD MI300的官方性能指標相比英偉達H100體現出優勢,后者的生態壁壘仍舊難以逾越,更別提H200展現出了更強的性能指標。這樣的背景下,AMD想要逆風翻盤,還是要著力補上生態差距。2016年,AMD推出了對標英偉達CUDA的ROCm架構,但由于ROCm平臺起步晚,其對于GPU加速庫的支持沒有英偉達CUDA全面:CUDA的應用場景基本能夠覆蓋全場景,ROCm更多用于高性能計算領域,對AI的覆蓋稍顯不足。

至今,AMD ROCm平臺的工具鏈已經相對完善,并且能夠兼容英偉達的CUDA平臺。此外,為了進一步優化軟件生態,AMD還在2023年10月份官宣收購了AI軟件企業Nod.ai。

AMD高性價比的市場策略將是其在AI領域的另一大優勢。CNBC報告稱,上一代H100估計每顆售價在2.5萬美元到4萬美元之間,鑒于采用了HBM3e內存,H200的售價可能會更貴。另一方面從亮相開始,H100就迎頭趕上了“百模大戰”的風口,成為了被各方力量爭奪的寶貴算力資源,大模型產業疾速發展帶來了巨大的算力缺口:根據OpenAI數據, 模型計算量增長速度遠超人工智能硬件算力增長速度,兩者之間存在萬倍差距。對于長期在AI領域缺乏存在感的AMD而言,它正迎來了最好時機。

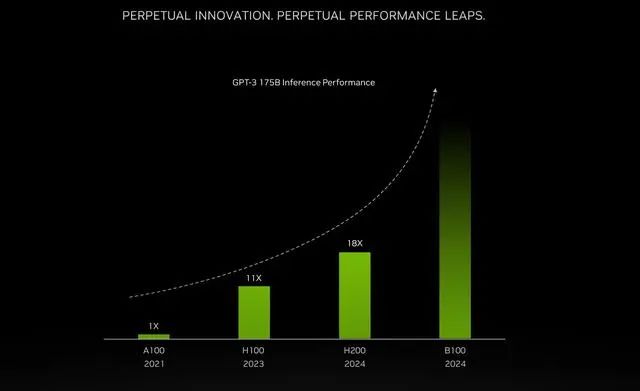

據了解,英偉達H200將于2024年第二季度開始向全球客戶和云服務廠商供貨。英偉達還透露,下一代新架構Blackwell B100 GPU也將在2024年推出,性能已經“望不到頭”。

英偉達官網顯示H200將為40多臺AI超級計算機提供支持。包括CoreWeave、亞馬遜AWS、谷歌云、微軟Azure、甲骨文云等公司將成為首批部署基于H200實例的云服務商;同時,華碩、戴爾科技、惠普、聯想、Supermicro、緯創資通等系統集成商也會使用H200更新其現有系統。此外,在新的H200加持之下,GH200超級芯片也將為全球各地的超級計算中心提供總計約200 Exaflops的AI算力:在SC23大會上,多家頂級超算中心紛紛宣布,即將使用GH200系統構建自己的超級計算機;德國尤里希超級計算中心將在超算JUPITER中使用GH200超級芯片。

值得注意的是,如果沒有獲得出口許可證,H200將無法在中國市場銷售。原因是H200參數高于美國商務部10月17日公布的性能紅線:多個數字處理單元的集成電路(用于數據中心)總處理性能為2400-4800,“性能密度”大于1.6且小于5.92。

評論