用于邊緣設備的AI為設備制造商營造機會

作者 Werner Goertz Annette Jump Gartner個人科技團隊研究總監 Alan Priestley Gartner研究總監

本文引用地址:http://www.104case.com/article/201802/376155.htm摘要:在持續完善機器學習模型和訓練過程中,各種個人設備(如:移動設備、汽車和物聯網)發揮著不可或缺的作用。著重闡述了個人設備在優化深度學習架構中發揮的關鍵作用。

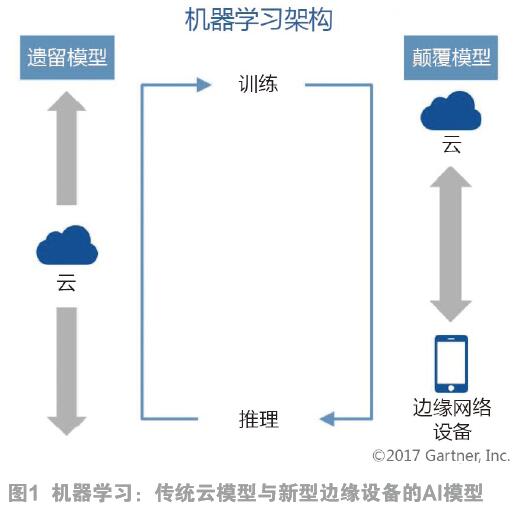

傳統的機器學習包括兩個功能:訓練和推理(運行時間)。訓練模型(參見圖1)通過對比真實事件(例如,捕捉圖像中的對象)實現持續改進和完善。在傳統模型中,訓練和推理完全在云中運行(圖1中左側的垂直箭頭)。然而,這種模式最終會遇到可擴展性問題,如:不可接受的延遲,依賴永遠在線的帶寬和數據隱私問題等。因此,一種新的機器學習架構正在興起,處于網絡邊緣的設備在機器學習中扮演一定角色,尤其是在推理(右側垂直箭頭所示)方面。

對于各種設備制造商而言,這種新的分布式架構是很好的選擇。科技產品管理領導者必須了解這一新興趨勢,掌握能夠啟動設備,將推理放在邊緣上或設備中的組件和框架知識。現在,制定路線圖成為了必要條件,它將本地AI(人工智能)處理和價值創造考慮到其中。下列設備將受益于新架構結構的開發,并成為設備層面的推理備選項:

● 支持虛擬個人助理的揚聲器(VPA-enabled speakers);

● 家庭網關(home gateways);

● 智能手機;

● 平板電腦/個人電腦;

● 家庭傳感器(home sensors)。

在持續完善機器學習模型和訓練過程中,各種個人設備(如:移動設備、汽車和物聯網)發揮著不可或缺的作用。

在本文中,我們著重闡了個人設備在優化深度學習架構中發揮的關鍵作用。

領先的AI框架組合已經成形,并正在支持AI組件的無縫集成。這些框架包括:

● TensorFlow/TensorFlow Lite:TensorFlow是Google的開源工具和軟件庫,旨在加速機器學習應用的開發過程。2017年5月,TensorFlow Lite在Google I/O上推出。

● Caffe:Caffe是加州大學伯克利分校開發的獨立框架。Caffe也是一種開源框架,由全球貢獻者網絡提供支持。

● MXNet:Nvidia和Amazon是MXNet背后的推動力。Amazon Web Services(AWS)的客戶對該開源框架推崇有加。

2 運行中的邊緣AI

如今,技術供應商,特別是在智能家居領域的供應商都在面向邊緣AI的未來格局設計相關產品,而基于機器學習的智能數據分析就是不錯的開端。此類典型產品包括:

● 聯網家庭中樞和Wi-Fi接入點的制造商Securifi已經將其機器學習功能應用于高端Almond路由器系列,“學習”聯網家庭設備的典型行為和流量模式;

● Speechmatics正在開發最終可以完全在設備上運行的自然語言處理技術;

● Mojo Networks提供基于AI的工具以檢測Wi-Fi或有線網絡問題。

3 AI解決方案的開發需要個人設備供應商考慮兩個發展階段

除了確定AI解決方案的使用目的,在評估AI解決方案的部署情況時,技術產品管理領導者必須考慮兩個關鍵的開發階段,具體如下。

3.1 開發和訓練AI模型/神經網絡

許多基于AI的項目利用基于數據中心的資源,開發和訓練用戶與其個人設備互動的模型和神經網絡,從而從AI解決方案中獲益。利用數據中心資源的原因在于神經網絡的初始模型必須經過訓練和“提升”,才能承擔預期的特定任務,包括語音識別/響應、語音翻譯或圖像識別。這通常要求模型能夠訪問大量的“已知”數據和運行模型的連續迭代,來確保提供正確結果。訓練神經網絡需要高性能的服務器驅動系統,該系統能夠實現極高的數據吞吐量,以保證模型的多次迭代在可控時間段內運行。這些系統通常基于高性能x86微處理器,并輔以一系列圖形處理器(GPU),來加速神經網絡算法的高度并行元素。

在很大程度上,經過訓練的神經網絡的可靠性取決于訓練網絡的已知優良數據。這將要求設備供應商的技術產品管理領導者評估目前哪些數據可用,或能夠訪問哪些數據訓練神經網絡;在可用數據不足的情況下,可以授權第三方數據集,或獲得預訓練神經網絡模型的訪問權限。使用預訓練的神經網絡可以最大限度地減少對高性能服務器基礎架構的投資,而在訓練階段處理大型數據集離不開這些基礎架構。

在開發和訓練模型或神經網絡之后,開發人員通常會優化模型,以便在基于“未知”數據推斷新結果,即在供客戶使用之時,減少費用和等待時間。

3.2 確定如何有效地為客戶部署AI解決方案

用于部署AI解決方案,根據未知數據推斷結果的選擇有多種:

(1)云端部署

對于許多開發人員而言,這將是很簡單的部署方案。開發人員能夠利用與開發神經網絡相同的系統和技術,這些系統已經成為許多云服務中的“標準”產品。

這種方法面臨的挑戰是大量原始數據必須傳遞到云端,以便神經網絡做出響應。這需要一個連續的高帶寬通信連接到云端,使用具有有線互聯網連接的設備,這一切將成為可能(例如智能家居設備和VPA)。然而,當無法保證云端連接或帶寬有限時,此方法并不適用(例如蜂窩連接)。

另一個必須考慮的因素是云服務處理輸入數據,以及在合理時間內做出響應的能力,這就是所謂的延遲。人們對于在用戶心生不滿、轉而采用其它方法之前的合理系統響應時間內已開展了諸多研究。而且隨著AI系統被用于任務關鍵型/生命關鍵型決策,延遲將越來越重要(例如自主駕駛系統)。

在很多情況下,應用程序延遲將是數據傳輸時間與神經網絡原始執行時間共同的結果。在任何時候,這兩種情況都會受到用戶數量的影響。在高峰期,網絡帶寬或云計算能力可能會限制性能。

(2)個人設備

通過訓練神經網絡和優化推理模型,運行模型所需的處理資源一般遠遠少于訓練階段所需的資源。這能夠使模型在更簡單的設備上運行,如:FPGA、專用神經網絡芯片,甚至今天許多個人設備中使用的Arm處理器內核。

在個人設備中部署神經網絡模型可以幫助開發人員解決依賴云服務造成的延遲和連接性挑戰。

然而,將神經網絡模型遷至設備本身也存在挑戰。首先,個人設備必須有足夠的資源運行神經網絡模型和數據存儲,保存參考數據,使其能夠根據新的未知輸入推斷答案。

個人設備有各種設計限制。這些限制可能包括外形規格、電池壽命、功能性或大批量可制造性。因此,許多設備都采用定制AP(應用處理器)設計,這些AP將設備的大部分功能集成到單個芯片上。定制AP的典型示例包括蘋果公司在其智能手機和平板電腦中使用的A系列處理器,以及用于智能手機的高通Snapdragon AP。專用微控制器也常用于外形尺寸較大的個人設備。所有這些半導體器件都旨在平衡性能要求與延長的電池壽命,即最低的設備功耗。

許多開發AP的半導體供應商正在評估能夠運行神經網絡的額外功能模塊。其中一些模塊專用于特定的神經網絡功能,例如圖像識別。其他模塊則提供更多的靈活性,以便開發人員根據自己的需求優化神經網絡。

現在,許多IP公司提供可集成到AP設計中的數字信號處理器(DSP)、GPU和FPGA IP模塊——所有這些都可以提供運行神經網絡模型所需的并行性。

此外,一些公司正在開發專用的AI處理器。但大部分都還沒有上市,不過在此期間,這些公司還提出了將AI功能添加到個人設備上的另一個選項。但是,由于這些AI處理器通常基于專有的處理器架構,提供完全集成的軟件堆棧可能具有挑戰性。因此,應該進行全面的評價,評估收益與替代設計決策對比。

使用標準個人電腦架構的更復雜的個人設備可以選擇使用基于周邊設備互連高速(Peripheral Component Interconnect Express)的GPU或FPGA附加卡(FPGA add-in card)執行神經網絡功能。

(3)兩者兼具

對于許多應用而言,由于性能、功耗和外形規格因素的限制,完全在個人設備上運行神經網絡模型可能并不可行。在這種情況下,最好分離推理操作,在設備和云中的其它設備上進行操作。

本文來源于《電子產品世界》2018年第3期第5頁,歡迎您寫論文時引用,并注明出處。

評論