4萬億個晶體管,90萬個AI核心,Cerebras第三代晶圓級AI芯片來了

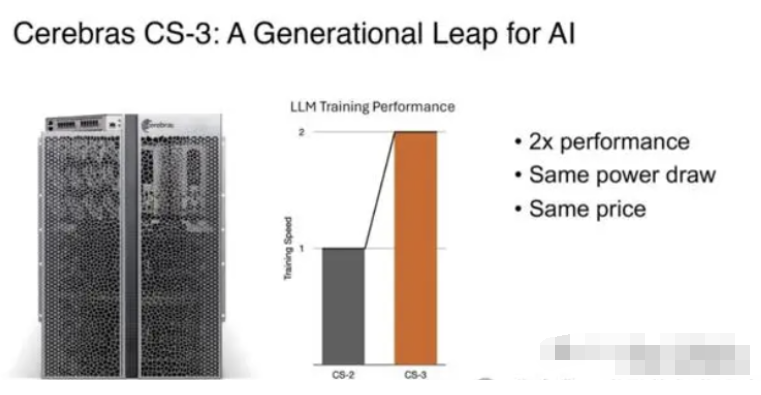

3月14日消息,面對火爆的AI市場,新創AI芯片公司Cerebras Systems近日推出了其第三代的晶圓級AI芯片WSE-3,性能達到了上一代WSE-2的兩倍,將用于訓練業內一些最大的人工智能模型。

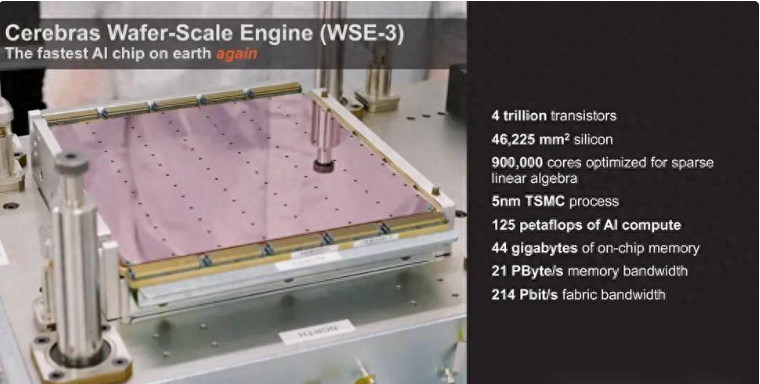

據介紹,WSE-3依然是采用了一整張12英寸晶圓來制作,基于臺積電5nm制程,芯片面積為46225平方毫米,擁有的晶體管數量達到了4萬億個,擁有90萬個AI核心,44GB片上SRAM,整體的內存帶寬為21PB/s,結構帶寬高達214PB/s。使得WSE-3具有125 FP16 PetaFLOPS的峰值性能,相比上一代的WSE-2提升了1倍。

作為對比,WSE-2芯片面積同樣是46225平方毫米,基于臺積電7nm制程,晶體管數量為2.6萬億個,AI內核數量為85萬個,片上內存SRAM為40GB,內存帶寬為20PB/s,結構帶寬高達220PB/s。

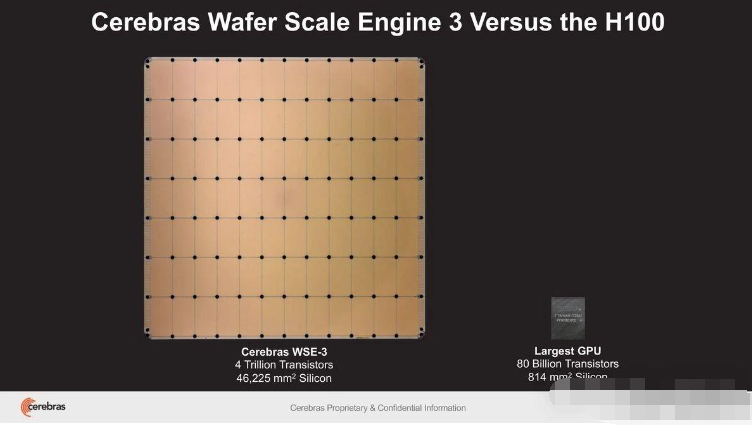

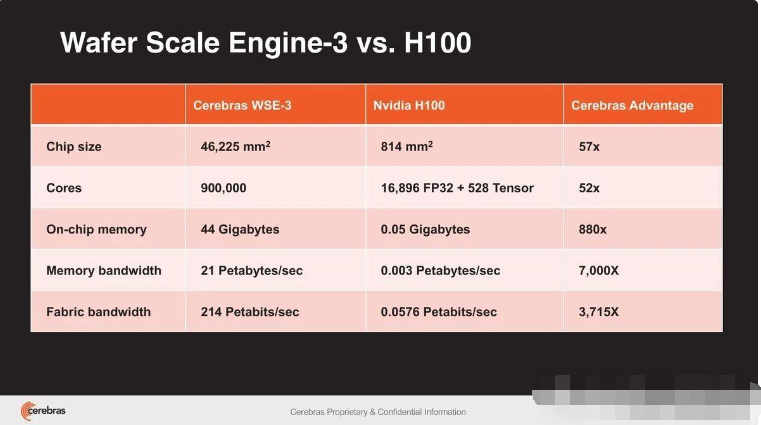

如果將其與英偉達的H100相比,WSE-3面積將是H100的57倍,內核數量是H100的52倍,片上內存是H100的880倍,內存帶寬是H100的7000倍,結構帶寬是H100的3715倍。

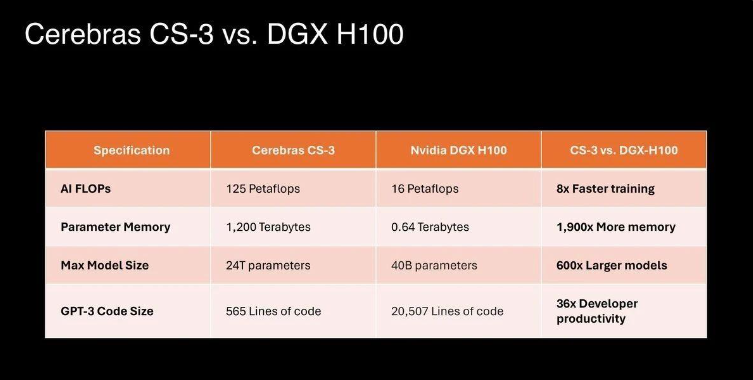

與此同時,Cerebras還推出了基于WSE-3的CS-3超級計算機,可用于訓練參數高達24萬億的人工智能模型,這比相比基于WSE-2和其他現代人工智能處理器的超級計算機有了重大飛躍。該超級計算機可以支持1.5TB、12TB或1.2PB的外部內存,這使它能夠在單個邏輯空間中存儲大量模型,而無需分區或重構,從而簡化了訓練過程,提高了開發人員的效率。

最新的 Cerebras 軟件框架可以為PyTorch 2.0 和最新的 AI 模型和技術(如多模態模型、視覺轉換器、專家混合和擴散)提供原生支持。Cerebras 仍然是唯一為動態和非結構化稀疏性提供本機硬件加速的平臺,相比英偉達的DGX-100計算機系統,將訓練速度提高了8 倍。

Cerebras還強調了CS-3卓越的電源效率和易用性。盡管性能翻了一番,CS-3仍保持著與前代產品相同的功耗。它還簡化了大型語言模型(LLM)的訓練,與GPU相比,所需代碼減少了97%。例如,該公司表示,GPT-3大小的模型在Cerebras平臺上只需要565行代碼。

就可擴展性而言,CS-3可以配置在多達2048個系統的集群中。這種可擴展性使其能夠在四個系統的設置下,在一天內微調700億個參數模型,并在同一時間段內全面從頭開始訓練Llama 70B模型。

Cerebras表示,該公司已經看到了外界對CS-3的巨大興趣,并有來自各個行業的大量訂單積壓,包括企業、政府和公有云廠商。Cerebras還與美國阿貢國家實驗室和梅奧診所等機構合作,強調了CS-3在醫療保健方面的潛力。

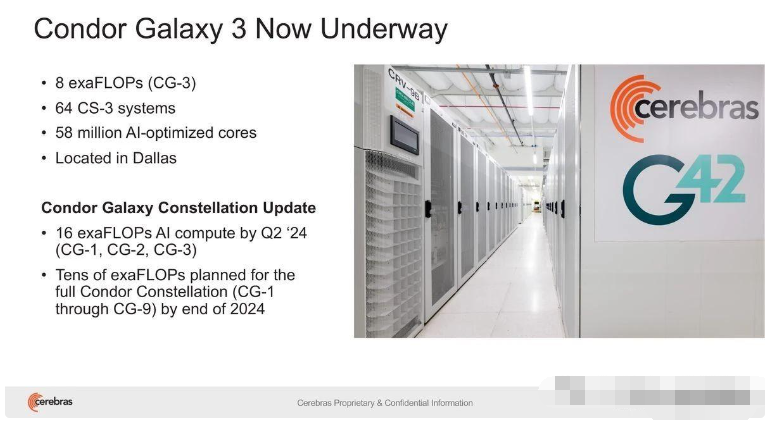

Cerebras和G42之間的戰略合作伙伴關系也將隨著Condor Galaxy 3的建設而擴大,這是一款人工智能超級計算機,擁有64個CS-3系統(擁有57600000個核心)。這兩家公司已經共同創建了世界上最大的兩臺人工智能超級計算機:Condor Galaxy 1 (CG-1)和Condor Galaxy 2(CG-2),它們位于加利福尼亞州,綜合性能為8個ExaFLOP。這一合作伙伴關系的目標是在全球范圍內提供數十個exaFLOP的人工智能計算。

G42集團首席技術官Kiril Evtimov表示:“我們與Cerebras的戰略合作伙伴關系有助于推動G42的創新,并將有助于加速全球范圍內的人工智能革命。”。“Condor Galaxy 3是我們的下一臺人工智能超級計算機,擁有8個exaFLOP,目前正在建設中,很快將使我們系統的人工智能計算總產量達到16個exafloP。”

相關文章:《Cerebras推出全球最強AI超算:5400萬個AI內核,算力高達4 exaFLOPS!》

編輯:芯智訊-浪客劍

*博客內容為網友個人發布,僅代表博主個人觀點,如有侵權請聯系工作人員刪除。