谷歌發(fā)布第五代TPU:訓練性能提高2倍,推理性能提升2.5倍!

8月30日消息,谷歌在29日舉行的 Cloud Next 2023 大會上,公開了Google Cloud新款自研AI芯片TPU v5e,并推出了搭配英偉達(NVIDIA)H100 GPU “A3超級計算機”GA(通用版) ,A3 VM實例將于下個月上線。谷歌還宣布與AI芯片龍頭英偉達擴大合作伙伴關系。

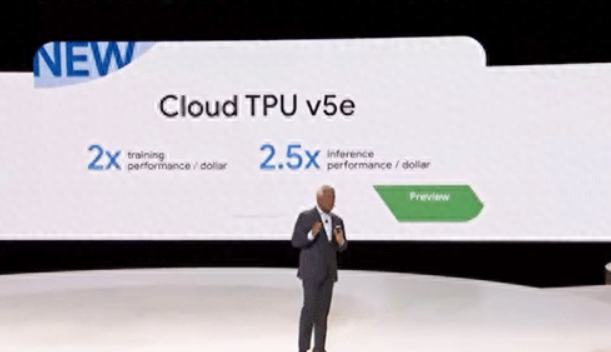

第五代TPU:訓練性能提高2倍,推理性能提升2.5倍,成本降低50%!

TPU是谷歌專門為機器學習(ML)/深度學習(DL)設計的專用AI加速芯片,比CPU、GPU等通用處理器對于AI計算效率更高。谷歌第一代 TPU(TPU v1)是 2016 年在 Google I/O 大會上發(fā)布的,隨后在2017 年作為 Google Cloud 基礎設施“Cloud TPU”推出,通常使用 FP32 和 FP16 等精度數(shù)據(jù),如果降低 ML 的精度/DL計算到8位(INT8)等,則將使得在ML/DL中的處理能力得到進一步提高。此外,通過僅合并專門用于 ML/DL 的算術單元,谷歌減少了 CPU 和 GPU 所需的高速緩存、分支預測和亂序執(zhí)行等復雜算術單元,可以以低功耗執(zhí)行專門針對 ML/DL 的計算。

之后,谷歌TPU又經(jīng)過了數(shù)次迭代,比如第二代TPU v2于2017年發(fā)布,第三代TPU v3于2018年發(fā)布,第四代TPU v4于去年發(fā)布,目前已開始服務和提供。

而最新的第五代TPU,即TPU v5e 則是谷歌專為提升大中型模型的訓練、推理性能以及成本效益所設計,并且其內部張量處理單元的最新版本。與與 2021 年發(fā)布的 TPU v4 相比,TPU v5e 的大型語言模型提供的訓練性能提高了 2 倍、推理性能提高了2.5 倍。但是TPU v5e 的成本卻不到上一代的一半,使企業(yè)能夠以更低的成本,訓練和部署更大、更復雜的 AI 模型。

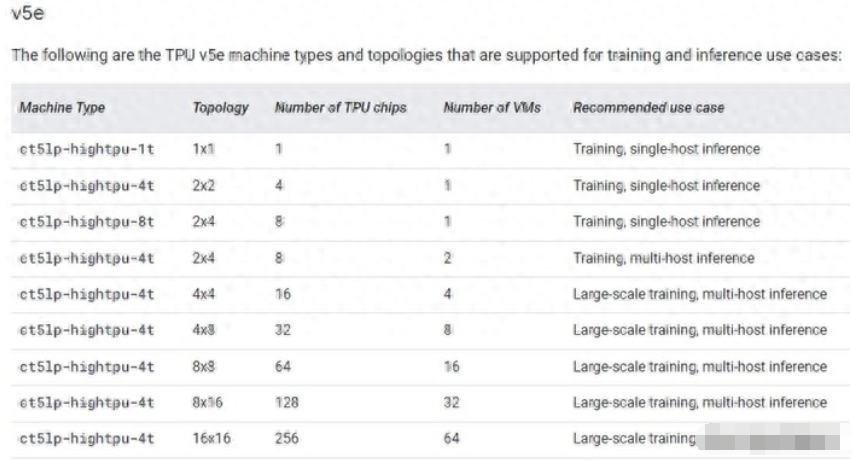

需要指出的是,從第三代TPU v3開始,谷歌就專注于增強可擴展性,以便能夠更大規(guī)模地并行處理。最新的TPU v5e ,可以通過采用400 TB/s互連來配置多達256個芯片。使得進行更大規(guī)模的學習和推理成為可能。谷歌表示,在 256 個芯片配置下,INT8 的算力將達到 100 PetaOps。

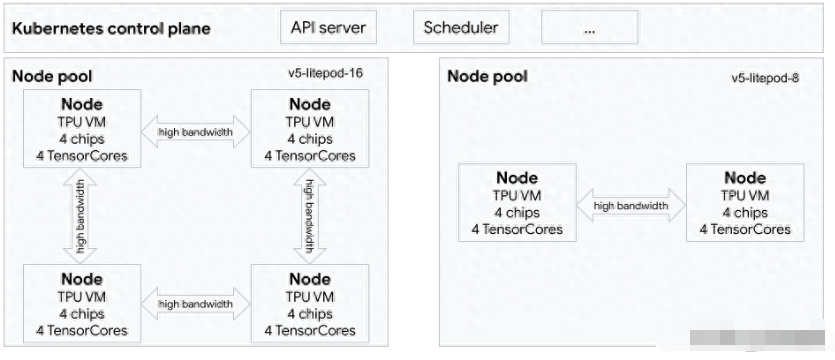

據(jù)介紹,TPU v5e將提供了多種不同的虛擬機配置,范圍從一個 TPU 芯片到單個切片內 256 個 TPU 芯片。對于那些需要更多算力的用戶,谷歌也正在推出“Multislice”,這是一種將模型交給數(shù)萬個TPU芯片計算的服務。

△上圖顯示了一個包含 1 個 TPU (v5e) 切片(拓撲:4x4)和 1 個 TPU v5litepod-8(v5e) 切片(拓撲:2x4)的GKE 集群

谷歌機器學習、系統(tǒng)和云AI 副總裁 Amin Vahdat 表示:“到目前為止,使用 TPU 的訓練作業(yè)僅限于單個 TPU 芯片切片,TPU v4 的最大作業(yè)切片大小為 3,072 個芯片。”

谷歌計算和機器學習基礎設施副總裁 Mark Lohmeyer在聯(lián)合博客文章中表示,“借助 Multislice,開發(fā)人員可以在單個 Pod 內通過芯片間互連 (ICI) 或通過數(shù)據(jù)中心網(wǎng)絡 (DCN) 跨多個 Pod 將工作負載擴展到數(shù)萬個芯片。”

AssemblyAI 技術副總裁Domenic Donato表示:“在我們的生產(chǎn) ASR 模型上運行推理時,TPU v5e 的性價比始終比市場上同類解決方案高出 4 倍。Google Cloud 軟件堆棧非常適合生產(chǎn) AI 工作負載,我們能夠充分利用 TPU v5e 硬件,該硬件專為運行高級深度學習模型而構建。這種強大的硬件和軟件組合極大地提高了我們?yōu)榭蛻籼峁┙?jīng)濟高效的人工智能解決方案的能力。”

Gridspace 機器學習主管Wonkyum Lee表示:“我們的速度基準測試表明,在 Google Cloud TPU v5e 上訓練和運行時,AI 模型的速度提高了 5 倍。我們還看到推理指標的規(guī)模有了巨大改進,我們現(xiàn)在可以在一秒內實時處理 1000 秒的內部語音到文本和情緒預測模型,性能提高了 6 倍。”

與英偉達合作推出A3 虛擬超級計算機

隨著生成式人工智能和大型語言模型 (LLM) 不斷推動創(chuàng)新,訓練和推理的計算需求以驚人的速度增長。為了滿足這一需求,Google Cloud 今天宣布全面推出由 NVIDIA H100 Tensor Core GPU 提供支持的全新 A3 虛擬超級計算機 (VM) 實例將于9月全面上市。

A3將會配備 8 個NVIDIA H100 GPU、兩個第四代 Intel Xeon 可擴展處理器、 2TB 內存以及定制的Intel 200G IPU(基礎設施處理單元)網(wǎng)絡組成。與使用傳統(tǒng)NVIDIA A100 GPU的A2相比,學習和推理過程中的性能提升了3倍,帶寬提升了10倍。這些實例最初于 5 月份宣布,可以增加到 26,000 個 Nvidia H100 Hopper GPU。 鑒于NVIDIA GPU 持續(xù)短缺,目前尚不清楚谷歌將擁有多少個NVIDIA H100。

在 Google Cloud Next 大會上,NVIDIA 創(chuàng)始人兼首席執(zhí)行官黃仁勛與 Google Cloud 首席執(zhí)行官 Thomas Kurian 一起發(fā)表了活動主題演講,慶祝 NVIDIA H100 GPU 驅動的 A3 實例全面上市,并談論了谷歌如何使用 NVIDIA H100 和 A100 GPU 進行內部部署DeepMind 和其他部門的研究和推理。

在討論中,黃仁勛指出了更深層次的合作,使 NVIDIA GPU 能夠為 PaxML 框架加速,從而創(chuàng)建大規(guī)模的法學碩士。這個基于 Jax 的機器學習框架是專門為訓練大型模型而構建的,允許高級且完全可配置的實驗和并行化。目前PaxML 已被 Google 用于構建內部模型,包括 DeepMind 以及研究項目,并將使用 NVIDIA GPU。兩家公司還宣布 PaxML 可立即在 NVIDIA NGC 容器注冊表中使用。

谷歌表示,生成式人工智能初創(chuàng)公司 Anthropic 是新 TPU v5e 和 A3 VM 的早期用戶。雖然谷歌向這家初創(chuàng)公司投資了 3 億美元,但它同時也是亞馬遜網(wǎng)絡服務的用戶。

Anthropic 聯(lián)合創(chuàng)始人 Tom Brown 表示:“我們很高興能與 Google Cloud 合作,我們一直在與 Google Cloud 合作高效地訓練、部署和共享我們的模型。由 A3 和 TPU v5e 以及 Multislice 提供支持的谷歌下一代 AI 基礎設施將帶來性價比優(yōu)勢,將助力我們繼續(xù)構建下一波人工智能浪潮所需的工作負載。”

支持100款AI模型

為了支持企業(yè)云端服務,Google Cloud 還整合加入了 20 個 AI 模型,使其支持的總數(shù)達到 100 個,通過其 AI 基礎設施,可讓客戶使用包括 Meta Llama 2 模型、Anthropic Claude 2 聊天機器人等,可以自由選擇最能滿足營運需求的 AI 模型。

Google Cloud 也對既有 AI 模型提高性能并添加功能,例如文字處理方面的 PaLM 模型可支援用戶輸入更多文字量,以便處理篇幅較長的報導、書籍文章或者法院判決文件等。

同時,Google Cloud 這次也推出企業(yè)級新工具,包括“SynthID”可為 AI 產(chǎn)生的圖片加上****浮水印,以人眼看不見的方式更改數(shù)字圖片,即使 AI 圖片被編輯或篡改也能保有完整性。

Google Workspace 辦公套件將為用戶提供 Duet AI 新產(chǎn)品,預計今年稍晚向所有用戶開放,可在 Google 文件、試算表、簡報中運用 AI 助手幫助更快完成工作。

編輯:芯智訊-浪客劍

*博客內容為網(wǎng)友個人發(fā)布,僅代表博主個人觀點,如有侵權請聯(lián)系工作人員刪除。