多視圖立體匹配論文分享CasMVSNet

論文題目:Cascade Cost Volume for High-Resolution Multi-View Stereo and Stereo Matching

0、引言

CasMVSNet[1]是CVPR2020的工作,在開始介紹這篇文章之前,我們首先回顧一下之前的工作。基于學習的MVS算法可以分為四個模塊:

·特征提取模塊

·特征匹配和代價聚合模塊

·深度圖回歸模塊

·深度圖細化模塊[可選項]

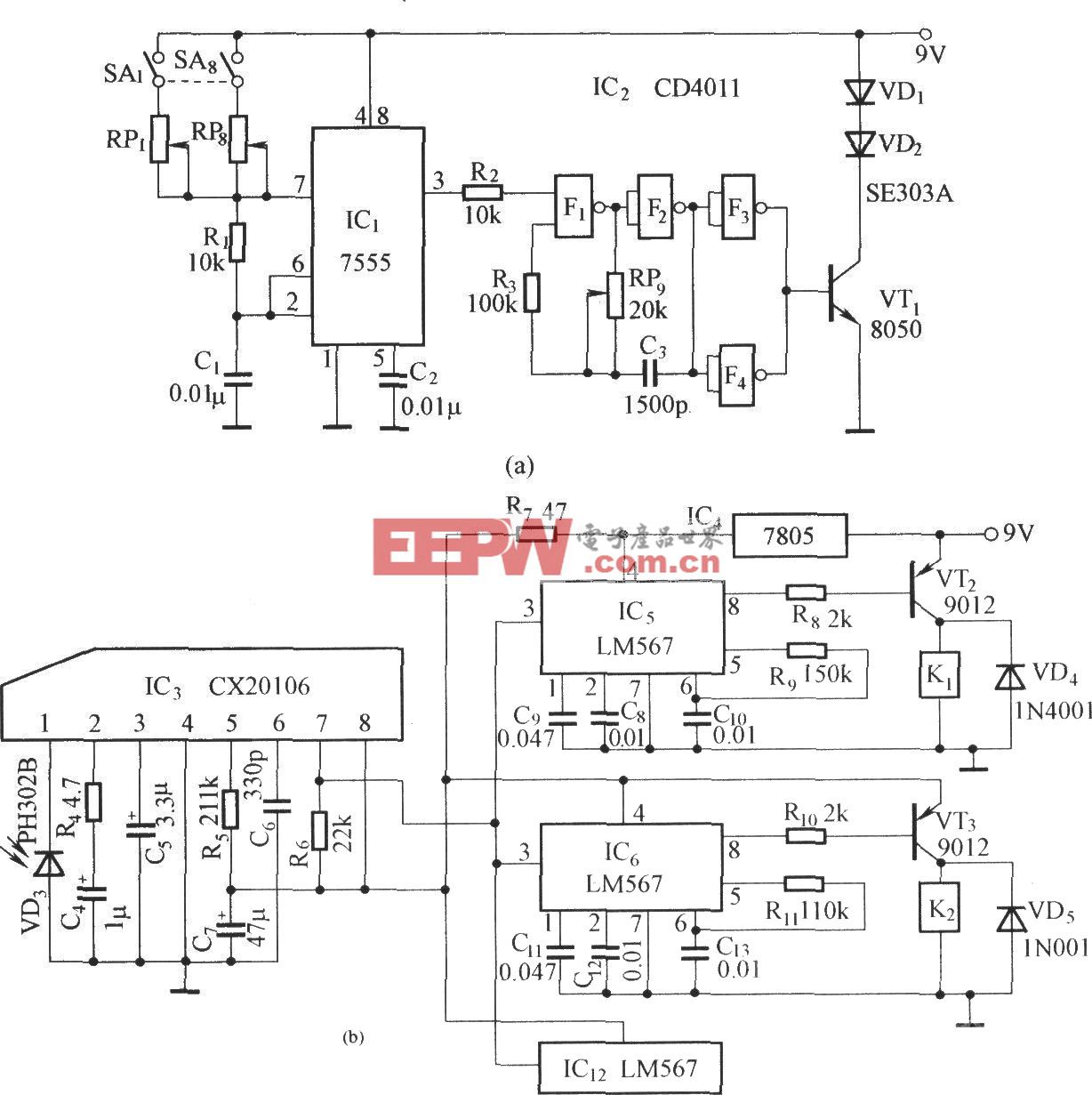

圖 1 MVSNet網絡架構圖

以ECCV2018的MVSNet[2]為例,這里簡單介紹每個模塊的實現方式,具體細節可參考論文或之前的推文。

·特征提取模塊:8層的2D卷積操作,除最后一層外,卷積操作后跟隨BatchNorm層和ReLU;

·特征匹配和代價聚合模塊:

※特征匹配:通過單應變換將源圖像的特征圖變換到參考視圖下,并基于方差指標將多視圖的特征體聚合為一個代價體。

※代價聚合:4個尺度的3DCNN網絡

·深度圖回歸:soft-argmin操作。

1、文章動機

基于學習的MVS算法因為受到顯存的限制,輸出的深度圖的空間分辨率只有輸入圖像的1/16大小(長寬均為輸入圖像的1/4大小)。以MVSNet為例,對于1600×1184大小的輸入圖像,需要構建h×w×D×F=400×296×256×8大小的代價體,16GB的顯卡才可以勝任。之前的方法限制了高分辨率MVS算法的發展。

那么問題來了,為什么要得到高分辨率的深度圖呢?我們知道,MVS算法的評測是對最后生成的點云進行評測。同等情況下,深度圖分辨率越高,得到的空間3D點數目越多,那么點云的完整性會更高,重建質量則更佳。

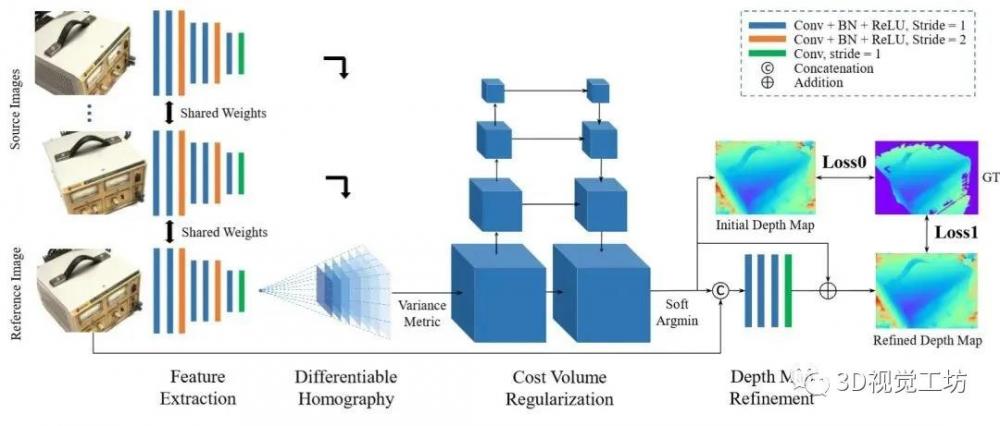

圖 2 代價體,其中H和W為空間分辨率,D為平面假設數,I為深度間隔

關于代價體:代價體(Cost Volume)是三維的,存儲時為4D的tensor。我們可以理解為:代價體每一個位置存儲的是一個F維的向量而不是標量。如圖2所示,空間分辨率H×W越高,平面假設數D越多,深度間隔I越小,那么得到的深度圖質量越高;同時顯存占用越大、耗時越長。那么,有沒有一種可以權衡精度和效率的方法呢?

2. 方法

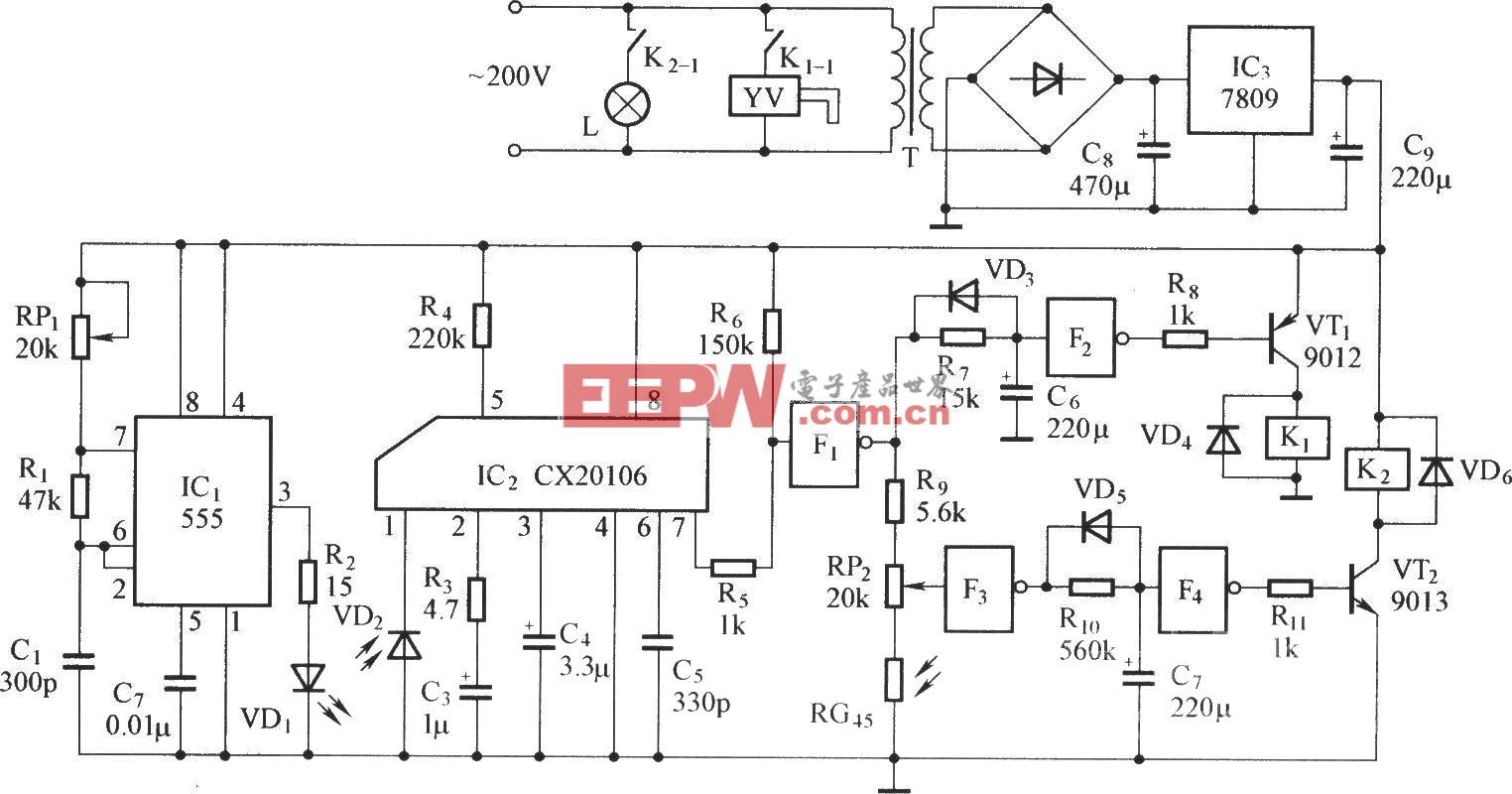

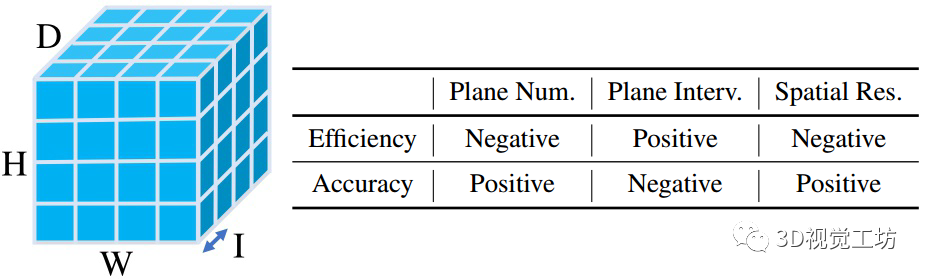

圖 3 CasMVSNet網絡架構圖

整體思路:CasMVSNet使用級聯的代價體來實現coarse-to-fine的深度估計。具體地,首先通過一個較小的代價體估計低分辨率的深度圖,然后我們可以根據上一級輸出的深度圖,縮減當前尺度的深度假設范圍。CasMVSNet使用3級的代價體來實現深度圖估計,包括兩級的中間結果和一個最終的深度輸出。

· 特征提取模塊:CasMVSNet需要在每個尺度上都進行特征提取和代價體構建,所以需要輸入圖像的多尺度特征。文章使用了三個尺度的FPN(Feature Pyramid Network)網絡。三個尺度的特征圖空間分辨率分別為輸入圖像的{1/16, 1/4, 1}大小。和之前的方法一樣,不同輸入圖像之間共享權重。

·特征匹配和代價聚合:同MVSNet

·深度圖回歸:同MVSNet

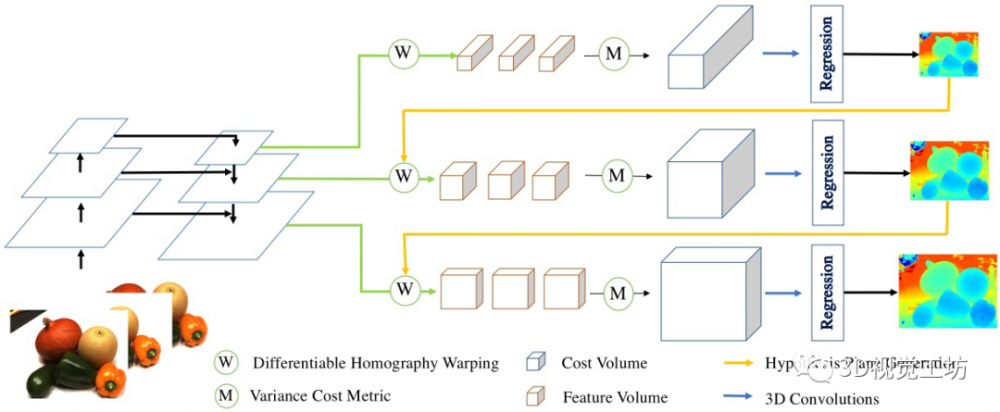

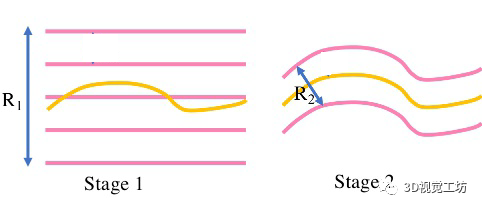

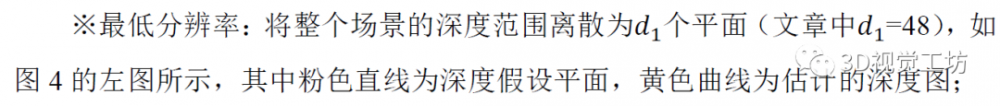

圖 4 深度范圍的確定

·深度范圍的確定:

3、實驗結果

3.1 DTU數據集

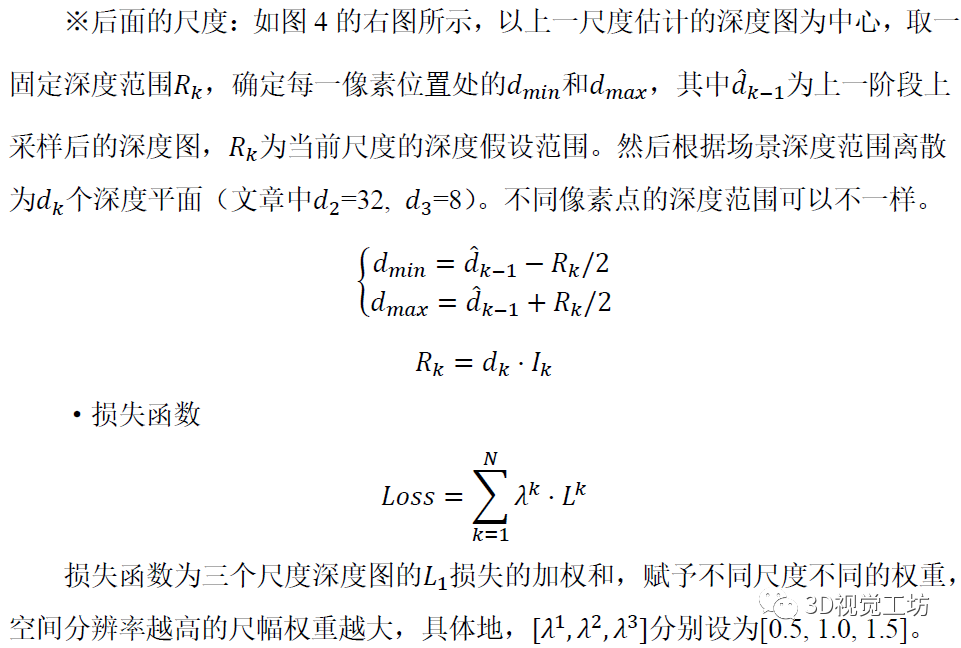

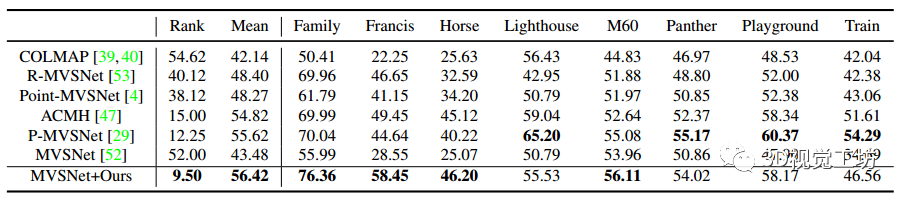

CasMVSNet在DTU[3]數據集的實驗結果如表1所示,和Baseline方法MVSNet相比,重建質量有35.6% 的提升,顯存占用降低了50.6%,運行時間有59.3%的提升。點云重建質量也超過了2019年的R-MVSNet、P-MVSNet和Point-MVSNet等方法。

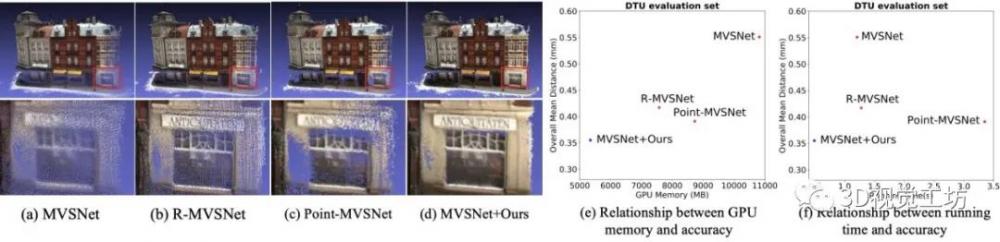

圖5中(a)~(d)是不同方法的DTU scan9的可視化結果,我們可以看到CasMVSNet重建的點云更加稠密,點云質量更佳,這也說明了高分辨深度估計的優勢所在。圖5中(e)為不同方法的GPU占用和精度對比圖;圖5中(f)為不同方法的運行時間和精度對比圖。

表 1 DTU數據集實驗結果

圖 5 與SOTA方法的實驗效果對比圖

3.2 Tanks and Temples 數據集

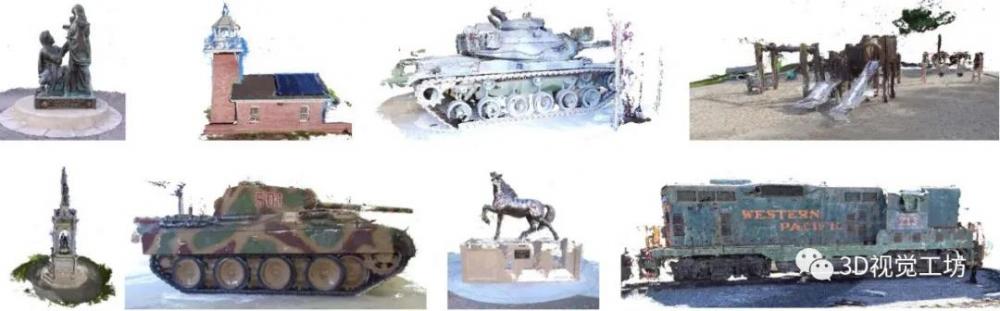

CasMVSNet在Tanks and Temple[4]數據集的實驗結果如圖2所示,重建點云的可視化結果如圖6所示。

表 2 Tanks and Temples數據集實驗結果

圖 6 Tanks and Temples數據集的重建點云

參考文獻

1.Gu X, Fan Z, Zhu S, et al. Cascade cost volume for high-resolution multi-view stereo and stereo matching[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2020: 2495-2504.

2.Yao Y, Luo Z, Li S, et al. Mvsnet: Depth inference for unstructured multi-view stereo[C]//Proceedings of the European Conference on Computer Vision (ECCV). 2018: 767-783.

3.Aan?s H, Jensen R R, Vogiatzis G, et al. Large-scale data for multiple-view stereopsis[J]. International Journal of Computer Vision, 2016, 120(2): 153-168.

4.Knapitsch A, Park J, Zhou Q Y, et al. Tanks and temples: Benchmarking large-scale scene reconstruction[J]. ACM Transactions on Graphics (ToG), 2017, 36(4): 1-13.

*博客內容為網友個人發布,僅代表博主個人觀點,如有侵權請聯系工作人員刪除。