收購Arm,推出80G超級A100:2020年,英偉達(dá)還有一招沒出

400 億美元收購 Arm,把業(yè)界頂級顯卡性能一次提升 20 倍,市值超越英特爾成為第一大芯片公司……2020 年的科技界大新聞,英偉達(dá)一家就占了好幾條。

說起英偉達(dá),很多人都知道這家公司最新推出的消費級顯卡 RTX 3080,以及它一卡難求的火爆景象。實際上,由于 GPU 在高性能計算、AI 等領(lǐng)域的大規(guī)模應(yīng)用,英偉達(dá)出品已經(jīng)成為了很多工作中不可或缺的一部分。

英偉達(dá)快速發(fā)展的技術(shù),為人們帶來了近乎無窮的算力,也讓其自身業(yè)績節(jié)節(jié)攀升。在過去 20 個季度中,英偉達(dá)已有 18 個季度的財務(wù)業(yè)績超過了華爾街分析師們的預(yù)期。

當(dāng)然不斷的成功并沒有讓英偉達(dá)放緩?fù)瞥鲂驴ǖ牟椒ァ?/p>

今年英偉達(dá)發(fā)布的新顯卡,幾乎都是由黃仁勛自家烤爐中「出爐」的。

就在自家消費級 GPU RTX 3080 顯卡搶占「最強 AI 計算芯片」的名頭后不久,11 月份英偉達(dá)又為旗下的最強 AI 訓(xùn)練計算卡 A100 系列進(jìn)行了升級。

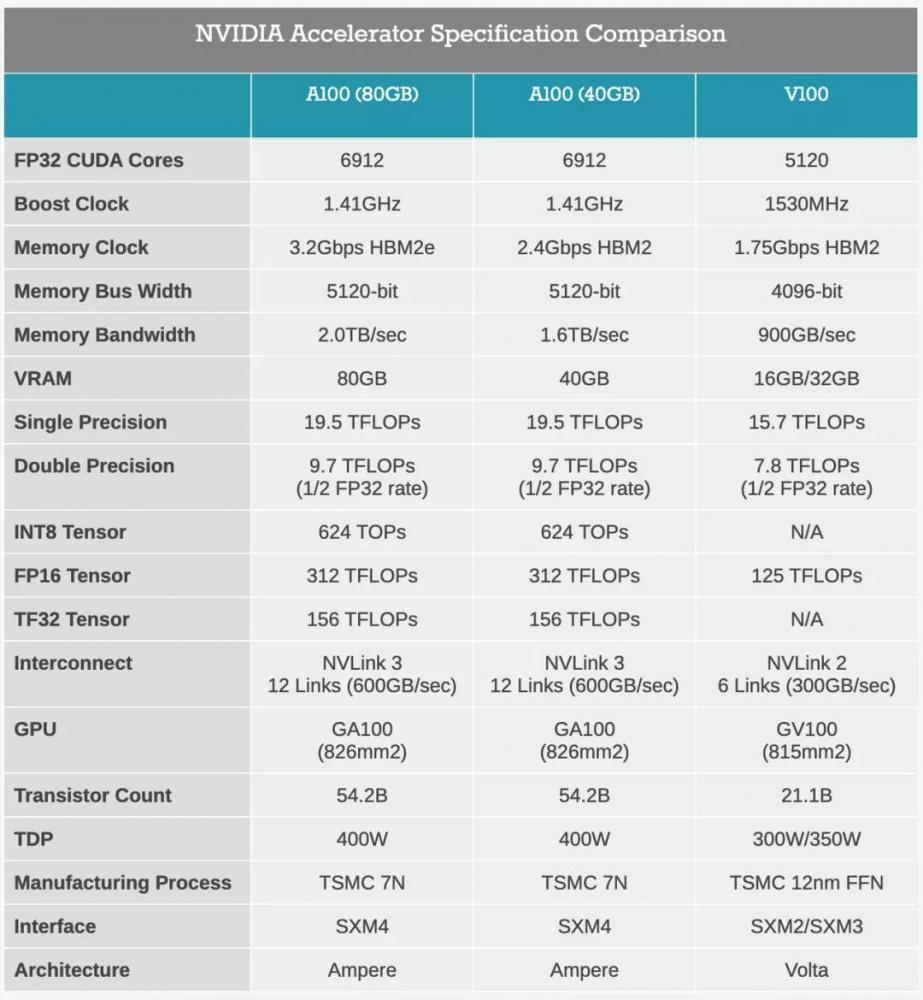

回想今年五月份,英偉達(dá)在 GTC 大會上發(fā)布了 7nm 安培架構(gòu)(NVIDIA Ampere)的 A100 GPU 產(chǎn)品,其中 40GB,帶寬為 1.6TB/s 的 HBM2 顯存令人印象深刻。11 月 16 日,競爭對手 AMD 帶來了 7nm CDNA 架構(gòu)的 MI100 加速卡,英偉達(dá)繼續(xù)出招,推出了 A100 80GB GPU,顯存翻倍,性能大幅提升。

時隔僅半年,英偉達(dá)推出的新卡有哪些具體的提升?首先在芯片的計算性能上,A100 80GB 的數(shù)據(jù)沒有變化,依然采用了基于 7nm 工藝的安培架構(gòu),集成 542 億晶體管、6912 個 CUDA 核心、加速頻率 1.41GHz,F(xiàn)P32 性能 19.5TFLOPS,F(xiàn)P64 性能 9.7TFLOPS,INT8 性能 624TOPS,額定功耗 400W。

A100 搭載了英偉達(dá)特有的第三代 Tensor Core 人工智能計算單元,對稀疏張量運算進(jìn)行了特別加速,執(zhí)行速度提高了一倍,也支持 FP64、 TF32、FP16、BFLOAT16、INT8 和 INT4 等精度的加速。通過全新的 TF32,A100 將上一代 Volta 架構(gòu)的 AI 吞吐量提高多達(dá) 20 倍。

新款 A100 計算卡的主要升級之處在于 HBM2 顯存:從之前的 40GB 直接翻倍達(dá)到 80GB,顯存類型升級為更先進(jìn)的 HBM2e。同時顯存頻率從之前的 2.4Gbps 提升到 3.2Gbps,帶寬也從 1.6TB/s 提升到史無前例的 2TB/s。通過配合英偉達(dá)多實例 GPU(MIG)技術(shù),每個實例在訓(xùn)練時獲得的內(nèi)存可以增加一倍,單卡最多可提供七個 MIG(每個 10 GB)。

英偉達(dá)最新幾代 AI 訓(xùn)練卡性能的對比,圖片來自 AnandTech。

在 A100 上應(yīng)用的技術(shù)還包括第三代 NVLink 和 NVSwitch 功能,相比上代,它們提供了兩倍的 GPU 到 GPU 帶寬,并將數(shù)據(jù)密集型工作負(fù)載到 GPU 的數(shù)據(jù)傳輸加速到每秒 600 GB。

通過硬件與軟件的優(yōu)化提升,A100 80G 可以在大型仿真系統(tǒng)中提供相比六個月前剛剛發(fā)布的 A100「標(biāo)準(zhǔn)版」1.8 倍性能的提升。在材料模擬軟件 Quantum Espresso 上,單節(jié)點 A100 80GB 也實現(xiàn)了近 2 倍的吞吐量提升。

這使得數(shù)據(jù)可以快速傳輸?shù)饺蜃羁斓臄?shù)據(jù)中心 GPU A100 上,使研究人員能夠更快地加速其應(yīng)用,處理最大規(guī)模的模型和數(shù)據(jù)集,如類似 GPT-3 這樣的大規(guī)模預(yù)訓(xùn)練模型,很大程度上避免了對于數(shù)據(jù)或模型并行架構(gòu)的需求。

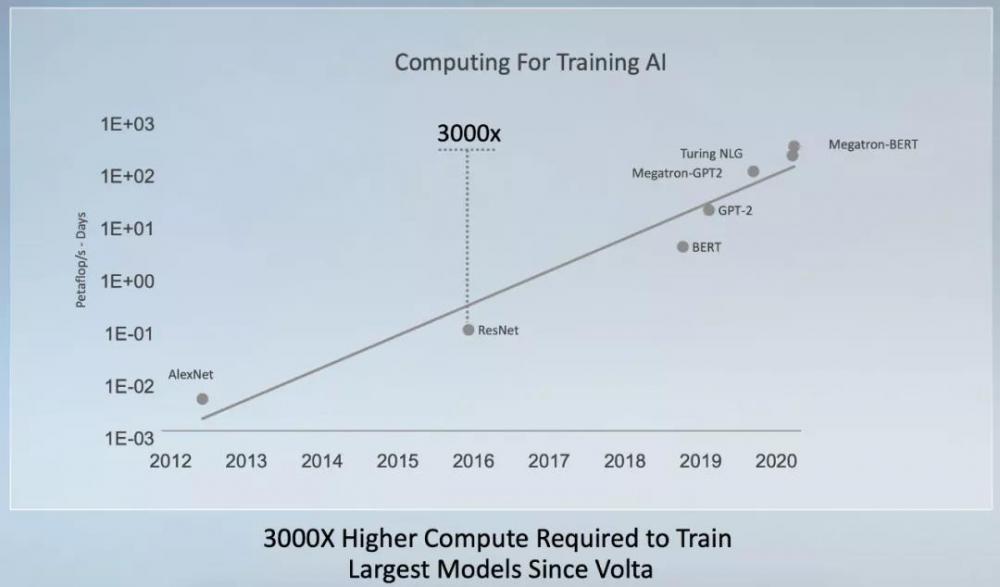

在深度學(xué)習(xí)等很多領(lǐng)域中,研究人員對于 AI 算力的需求幾乎是無止境的,據(jù)英偉達(dá)在今年 5 月的統(tǒng)計,自 2017 年底發(fā)布 V100 之后,訓(xùn)練業(yè)界機器學(xué)習(xí)模型的算力需求增長了 3000 倍。在五月底 Open AI 的 GPT-3 推出以后,這一數(shù)字再次被抬高了不少。

機器學(xué)習(xí)先驅(qū) Richard S. Sutton 在《苦澀的教訓(xùn)》中曾表示,70 年的人工智能研究史告訴我們,利用計算能力的一般方法最終是最有效的方法。

這種思想獲得了很多人的贊同,也引來了爭議。雖然一直有人認(rèn)為,找到與人類思考方式類似的因果推理范式才能真正地通往強人工智能,但基于深度學(xué)習(xí)的方法在近年來已掌握了國際象棋、圍棋,實現(xiàn)了不少人類專家也難以企及的能力。除了前沿探索之外,更多的深度學(xué)習(xí)應(yīng)用正在路上。

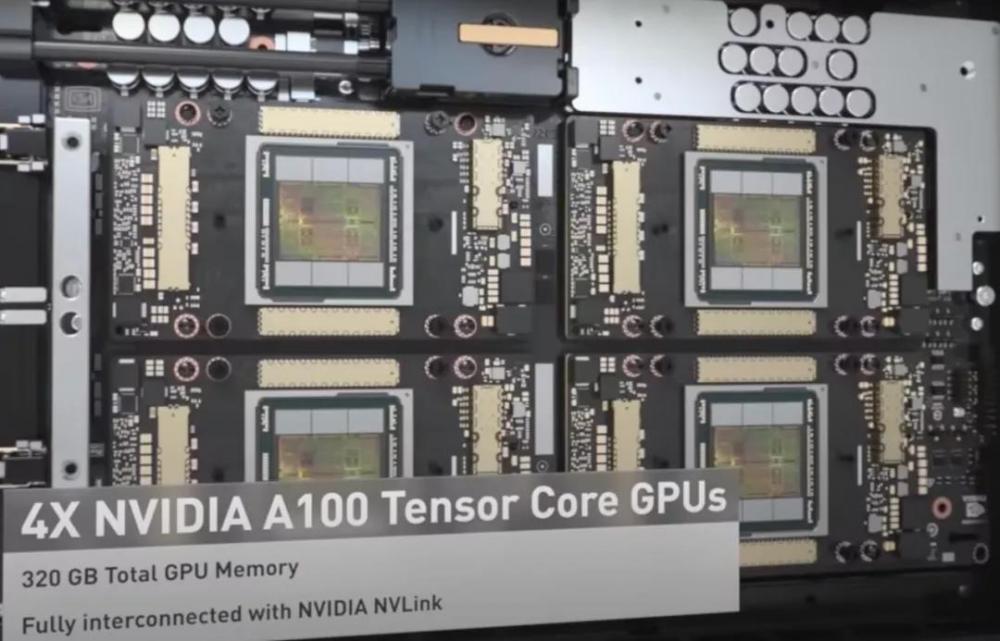

與此同時,英偉達(dá)還發(fā)布了「全球唯一」的千萬億次級工作組服務(wù)器 NVIDIA DGX Station A100,其配備四塊新款 A100 GPU,具有高達(dá) 320GB 的 GPU 內(nèi)存,輸出算力 2.5 petaflops。在執(zhí)行 BERT 等大模型時,新一代設(shè)備的效率相比過去提高了三倍。

雖然有超算級別的能力,但 DGX Station A100 無需配備數(shù)據(jù)中心級電源或散熱系統(tǒng),而且年底即開始供貨。搭載 A100 80GB 的第三方成套系統(tǒng)則預(yù)計會在 2021 年上半年出貨。

通過新計算卡和與之配合的架構(gòu),英偉達(dá)可以向更廣泛的人群輸出以往僅存在于超級計算機的 AI 算力。而說到超級計算機,英偉達(dá)也是目前業(yè)內(nèi)的領(lǐng)先者,在 11 月全球超算大會 SC2020 公布的 TOP500 榜單數(shù)據(jù)來看,近 70%的機器(包括排在前 10 名中的 8 臺)均采用了英偉達(dá)技術(shù)。

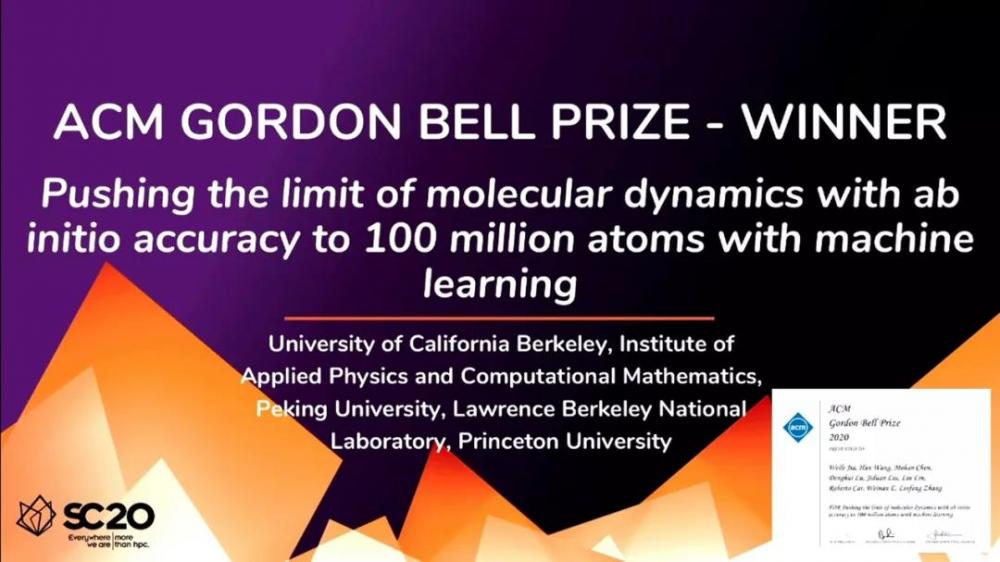

GPU 在高性能計算領(lǐng)域能有如今的覆蓋率,顯然是因為有很大需求:在 SC2020 大會上,有超算界諾貝爾獎美稱的「戈登 · 貝爾獎」頒給了由 UC Berkeley、北京大學(xué)、普林斯頓大學(xué)組成的研究團(tuán)隊,他們的研究被認(rèn)為是當(dāng)今計算科學(xué)中最令人興奮領(lǐng)域的重大進(jìn)展。

研究團(tuán)隊引入基于機器學(xué)習(xí)的分子動力學(xué)方法模擬原子運動,每天能夠模擬 1 億原子超過 1 納秒的軌跡。該研究是在美國橡樹嶺國家實驗室的前世界第一超算 Summit 兩萬八千塊英偉達(dá) V100 上完成的。

戈登貝爾獎旨在表彰研究者們在高性能計算方面的成就,入圍者必須證明他們提出的算法可以在世界上最強大的超級計算機上高效運行。中美獲獎團(tuán)隊開發(fā)了一系列高度優(yōu)化的代碼(GPU Deep MD-Kit)并在 Summit 超算上順利運行,在雙精度下實現(xiàn)了 91 PFLOPS 的速度,在混合單 / 半精度下實現(xiàn)了 162/275 PFLOPS 的速度。

將人工智能算法引入到 HPC 領(lǐng)域,并將邊界拓展至數(shù)據(jù)中心之外,是高性能計算領(lǐng)域里正在進(jìn)行的一項重大變革。而在這個過程中,英偉達(dá)將會繼續(xù)扮演舉足輕重的角色。

今年 5 月份的 GTC 2020 大會上,黃仁勛發(fā)布了 7nm 安培架構(gòu)和 A100;9 月份的 GTC 大會上,又為我們揭曉了「PC 游戲領(lǐng)域自 1999 年以來最大突破」——RTX 30 系列顯卡。

這還沒有完,在今年 12 月,GTC 大會還有一站。

*博客內(nèi)容為網(wǎng)友個人發(fā)布,僅代表博主個人觀點,如有侵權(quán)請聯(lián)系工作人員刪除。