人工智能與無人機的組合如何撕開俄空天軍的 “核心“

關注俄烏局勢的讀者應該已經知道,俄羅斯空軍遭遇了重大變故,且事發地點極具敏感性,正是其位于摩爾曼斯克州的奧列尼亞基地。該基地絕非等閑之地,它堪稱俄羅斯戰略轟炸機的 “核心”。

本文引用地址:http://www.104case.com/article/202506/471163.htm烏克蘭第一時間宣布擊毀了41架戰略轟炸機,占俄空天軍戰略轟炸機機隊總數的34%(據悉,俄空天軍一共121架各型戰略轟炸機)。而現在可以確認的戰果是,9 架圖 - 95MS 戰略轟炸機、2 架圖 - 22M3 遠程轟炸機以及好幾架其他戰機遭受重創,這些代表著俄空軍最為貴重且堅不可摧的實力家底,更是俄羅斯三位一體核打擊力量最最重要的的一環。在短短的數十秒內,就慘遭重創,從昔日的空中威懾力量淪為一堆冰冷的鋼鐵殘骸。

最令人感到諷刺的是,這場精準打擊的元兇并非傳統意義上的航母、戰斗機或導彈,而是一群外形宛如兒童玩具的自殺式無人機。它們并非零星來襲,而是多達117架,猶如洶涌海潮般從地平線涌來。在這場非對稱戰爭的縮影中,象征核威懾力量的戰略轟炸機像待宰的羔羊般被逐一摧毀,無人機的集群攻擊,用極低的制造成本換取了價值數十億美元的軍事資產的徹底癱瘓。

在本次名為“蛛網行動”襲擊事件中的主力,除了在明處的無人機之外,還有一個隱藏的“殺手”,那就是用于軍事的“人工智能”。

據悉,這場襲擊烏克蘭已經策劃了多年,其利用了烏克蘭國內波爾塔瓦州遠程戰略航空兵博物館中收藏的圖 - 95MS 和圖 - 22M3 轟炸機進行 AI 建模,(別忘了烏克蘭曾經也是蘇聯的一員,也有大量蘇聯時期的武器裝備)進而訓練無人機開展 AI 自主攻擊行動。利用人工智能圖像識別技術,無人機就能精準識別轟炸機的翼根和機身。翼根是機翼與機身連接的關鍵部位,內部結構復雜,匯聚了眾多的燃油管道、電線以及承力構件,若被擊中,飛機的平衡將被打破,飛行控制系統可能失靈,且修復難度極大,往往需要對整個機身結構進行大規模的拆解和重建,耗費大量的人力、物力和時間。而且,就現在俄羅斯的“考古式”軍事研究以及裝備,還能不能修好、能不能建造補充新的戰略轟炸機入列,還是一個巨大的未知數。

在此前,我們的公眾號就報道過歐美媒體擔心我國機器人、無人機等等人工智能產品發展被用于軍事用途的新聞。現在這個時間點再回頭看,也不能說他們的擔心完全不無道理。

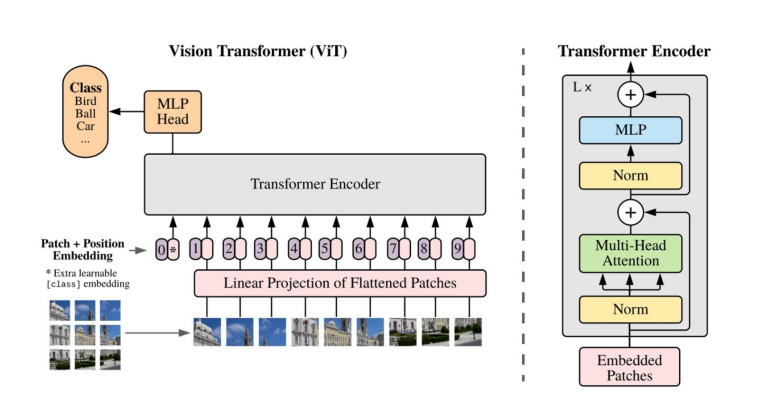

人工智能在軍事中的應用近幾年來一直都是各方關注的重點。其中,又以基于機械視覺的圖像識別技術為發展的重點之一,就像本次“蛛網行動”中的烏克蘭使用飛機模型來訓練無人機準備通過圖像識別飛機,就是該技術發展的一次歷史性實踐。那么,機械視覺在軍事上是如何實現的呢?這就不得不提基于Transformer的物體檢測模型——Vision Transformer(ViT)

在機械視覺中,CNN長期以來是圖像分析的支柱,利用卷積層提取局部特征并構建層次化表征,其歸納偏差(如局部性和平移不變性)使其在數據和計算資源有限的任務中有效。而ViT從一開始就使用自注意力機制建模圖像塊之間的全局關系,能捕捉長距離依賴關系和整體上下文,在大規模數據集和需要全面理解視覺內容的任務上表現優于 CNN。對于戰場上復雜的地形和瞬息萬變的環境來說,ViT模型從中有效地提取重要特征,特別是在從各個角度和環境探測敵方裝備或部隊時具有巨大優勢。

Vision Transformer(ViT)革新了圖像處理與理解模式,它引入 Transformer 架構這一強大力量至計算機視覺范疇。有別于傳統的基于卷積來提取特征的方式,ViT 將圖像當作由一系列圖像塊構成的序列來處理,借助自注意力機制,能夠把握整幅圖像里各元素間的關系,進而對局部以及全局的依賴關系開展有效建模,在眾多視覺任務中收獲了亮眼的成果。

在ViT的操作流程中,首先,會依據固定大小,例如 16x16 像素這樣的規格,把輸入圖像劃分成一個個小塊所組成的網格架構。隨之,將每個小塊進行展平操作,轉化成一維向量的形式,借此巧妙地把具有二維特性的圖像轉換為由多個塊向量構成的序列。

接下來,每個塊向量經由一個線性層,也就是一種簡單的神經網絡層,將其映射至更高維度的空間范疇。經此步驟,便生成了一個嵌入序列,序列里的每個嵌入分別對應著各個圖像塊,其原理與 NLP(自然語言處理)領域中 Transformer 對句子中單詞進行嵌入的方式有著異曲同工之妙。

不過,由于Transformer本身并不具備識別圖像塊順序以及位置的能力,所以需要在每個圖像塊嵌入當中融入位置編碼。這些位置編碼承擔著注入每個圖像塊空間位置信息的重任,助力模型留存原始圖像所蘊含的結構特征。

此時,攜帶了位置信息的圖像塊嵌入序列被輸入到標準的Transformer編碼器之中。該編碼器包含多層多頭自注意力以及前饋神經網絡等組成部分。憑借自注意力機制,模型得以學習不同圖像塊相互間的關聯性,進而捕捉圖像中存在的局部和全局模式。

在塊嵌入序列的前端,會添加一個特殊的可學習標記,一般被命名為 “分類標記” 或者 [CLS] 標記。待經過Transformer各層的處理之后,與這個特殊標記相對應的輸出,就充當了圖像整體的表征角色,可用于諸如分類等后續任務的開展。

值得一提的是,在ViT模型剛剛誕生之時,其計算量巨大,需要大量數據集進行預訓練,而近年來隨著像Swin Transformer、LaViT等等高效架構的蓬勃發展,引入了分層的多尺度特征提取結構以及使用非重疊窗口中的自注意力機制來減少計算復雜度,進一步降低了內存和計算需求,從而是得其在無人機等等設備上也可以被輕松部署。

落實到軍事實踐中,將ViT模型搭載于無人機、地面車輛等無人作戰平臺,可精準識別敵方的位置與運動軌跡。ViT在軍事行動中意義重大,其出色的物體探測能力,使其在面對偽裝或低能見度環境時,依然能保持高效運作。此外,基于ViT的系統具備高度靈活性,可迅速適應作戰環境的快速變化,通過簡單地重新訓練,即可適配多種戰場場景。ViT模型還具有學習和預測敵方模式的能力。通過對海量戰場圖像的分析,ViT能夠解析敵方的移動路徑與戰術行動模式,進而為指揮官提供前瞻性預測信息。在復雜多變的戰場環境中,ViT通過同時分析圖像的多個特征,能夠為指揮中心提供更全面、更深入的信息,從而助力軍事決策的制定。

基于ViT的地面物體檢測

在這場俄烏沖突中的 “蛛網行動”,更加印證了人工智能與無人機在戰爭中的重要性。無人機與 Vision Transformer(ViT)技術的深度耦合,已然成為未來戰爭之中的重大變數。

它們撬動了傳統軍事力量的平衡,用極低的成本讓強大的戰略轟炸機群瞬間折戟。不得不說,從各種意義上來看,不論是之前的蘇聯還是現在的俄羅斯對于我國來說一直都是一個好老師。

在未來的戰爭舞臺上,誰能率先掌握并駕馭這些前沿技術,誰就能在瞬息萬變的戰局中搶占先機,掌控主動權。而對于世界而言,如何在人工智能軍事化的大潮中確保和平與穩定,避免技術濫用引發新的沖突與災難,也將成為各國必須共同面對和亟待解決的重大課題。這場 “蛛網行動”,或許只是一個開始,但它的影響必將深遠而持久,持續推動著軍事領域乃至整個人類社會向著未知的未來加速邁進。

評論