研華正式發(fā)布國產(chǎn)化昇騰AI Box與Deepseek R1模型部署全流程!

隨著深度求索(DeepSeek)大模型的發(fā)布引發(fā)行業(yè)熱議,研華科技基于昇騰Atlas平臺邊緣AI Box MIC-ATL3S正式發(fā)布與Deepseek R1模型的部署流程。該平臺依托昇騰芯片的強大異構(gòu)計算能力,結(jié)合研華邊緣AI Box高可靠特點,通過模型輕量化、算子適配等技術(shù)實現(xiàn)大模型邊緣端部署。

本文引用地址:http://www.104case.com/article/202502/467131.htm硬件部署

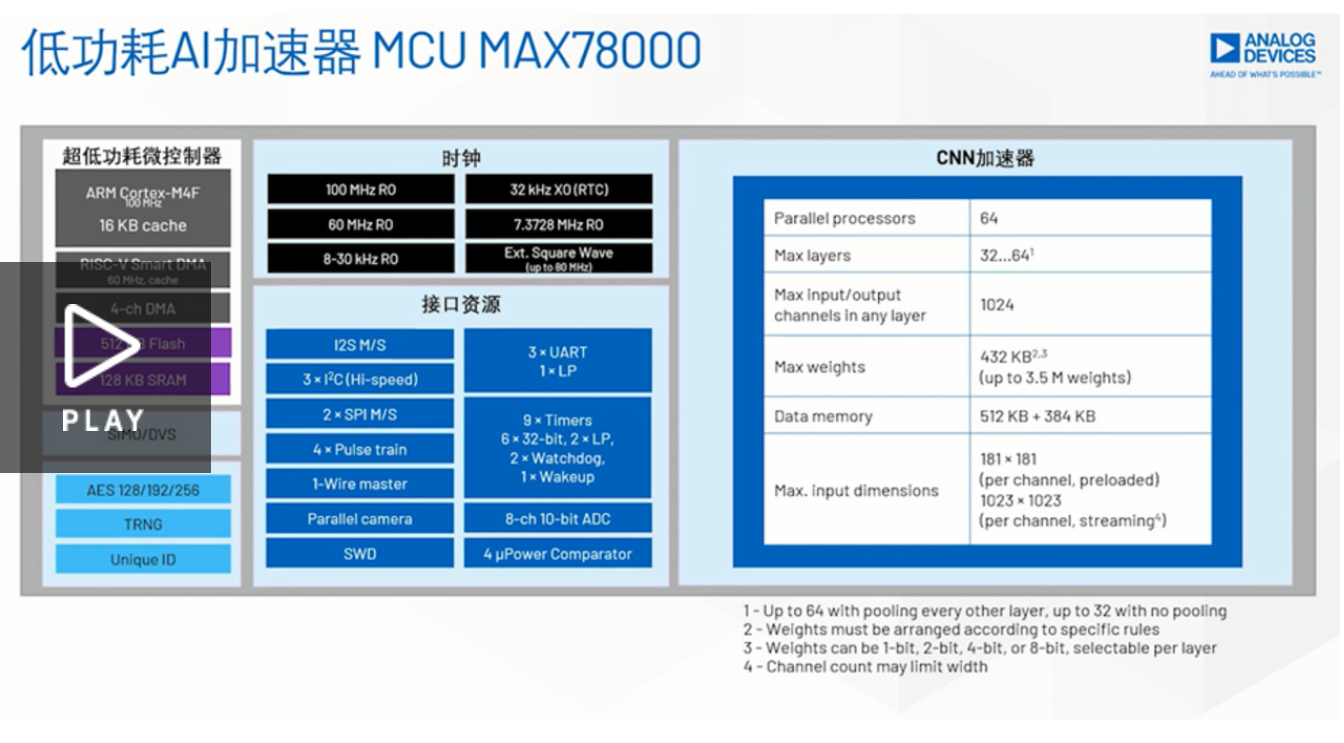

■ CPU:Atlas 310P

□ 10個DaVinciV200 AI core,主頻最高達1.08GHz

□ 16個64位TaishanV200M處理器核,核主頻最高1.9GHz

□ 8個DaVinciV200 Vector core,主頻最高達1GHz

■ 內(nèi)存:24G LPDDR4

■ AI算力:176TOPS INT8

■ 操作系統(tǒng):OpenEuler

■ 模型:DeepSeek-R1

推理模型

根據(jù)MIC-ATL3S硬件規(guī)格,我們選取了DeepSeek-R1-Distill-Qwen-1.5B這個精度和對硬件配置要求相對平衡的蒸餾模型進行適配和部署。

部署步驟

昇騰310P + openEuler22.03部署deepseek-R1

1. 安裝驅(qū)動包以及CANN

前往昇騰社區(qū)獲當前芯片版本的驅(qū)動、FW、以及CANN(昇騰異構(gòu)計算架構(gòu))

driver:Ascend-hdk-310p-npu-driver_xxxxx_linux-aarch64_chip-enable.runFirmware:Ascend-hdk-310p-npu-firmware_xxxxx_chip-enable.runCANN:Ascend-cann-toolkit_xxxxx_linux-aarch64.run

2. 安裝依賴組件

3. 安裝mindspore (昇思模型框架)

4. DeepSeek-R1模型拉取

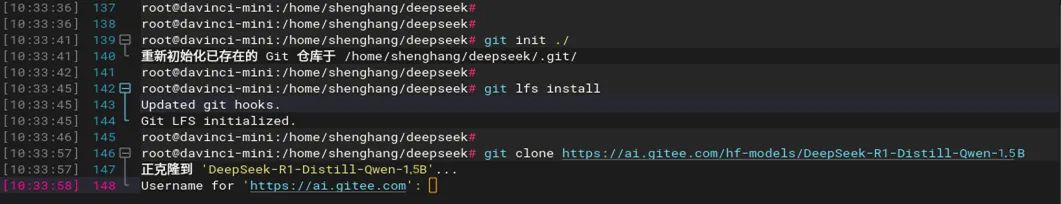

拉取模型指令,以1.5B為例

yum install git-lfs -ygit lfs installgit clone https://ai.gitee.com/hf-models/DeepSeek-R1-Distill-Qwen-1.5B

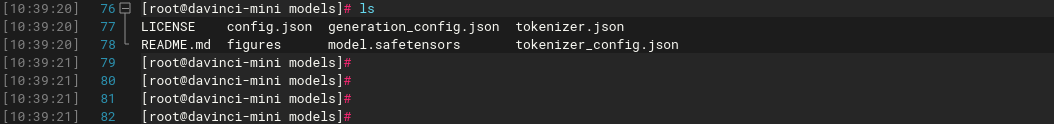

克隆完成示例如下,包含HF完整的倉庫:

5. 模型轉(zhuǎn)換

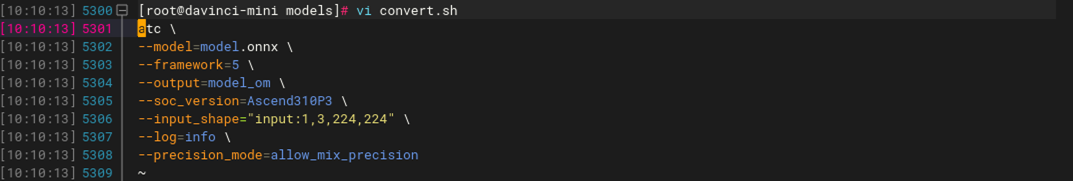

下載后的模型為safetensors格式,還不能直接使用,先用transformers轉(zhuǎn)換為ONNX格式,再使用atc轉(zhuǎn)換為OM(昇騰)格式才能使用。

創(chuàng)建python腳本將safetensors格式轉(zhuǎn)換為ONNX格式,最終轉(zhuǎn)換為OM格式。

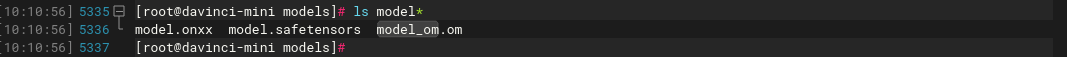

執(zhí)行腳本后會生成對應(yīng)模型文件,生成對應(yīng)格式模型文件 執(zhí)行:

Python3 convert.py./convert.sh

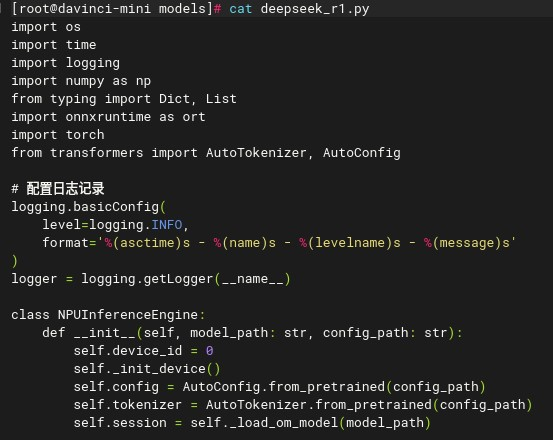

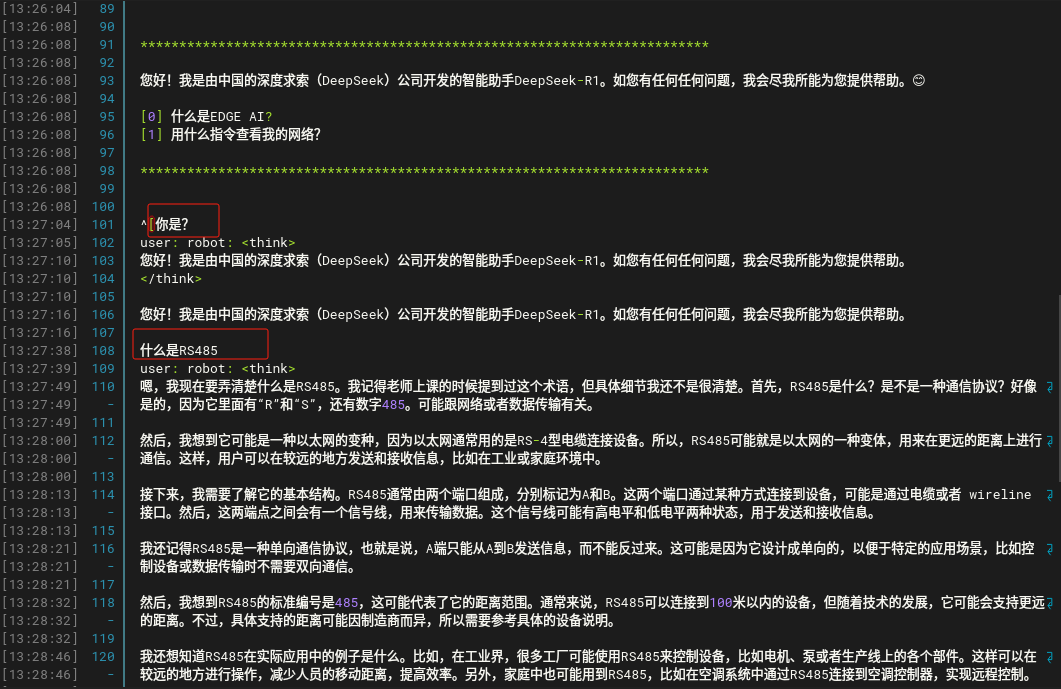

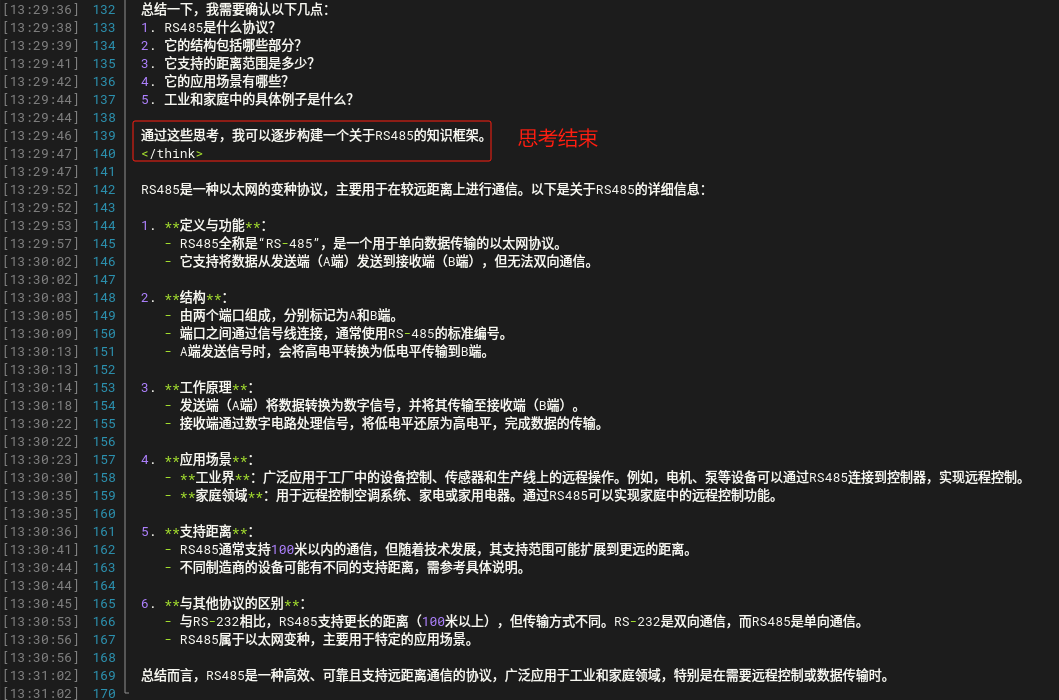

最后,需要用一個簡單的python腳本去做互動窗口,運行指令:python3 deepseek_r1.py

示例:

總結(jié):目前研華進行MIC-ATL3S適配更多Deepseek模型,以及與生態(tài)伙伴展開具體應(yīng)用場景測試,后續(xù)我們會持續(xù)公布研華邊緣AI平臺產(chǎn)品的部署&測試內(nèi)容,敬請關(guān)注。

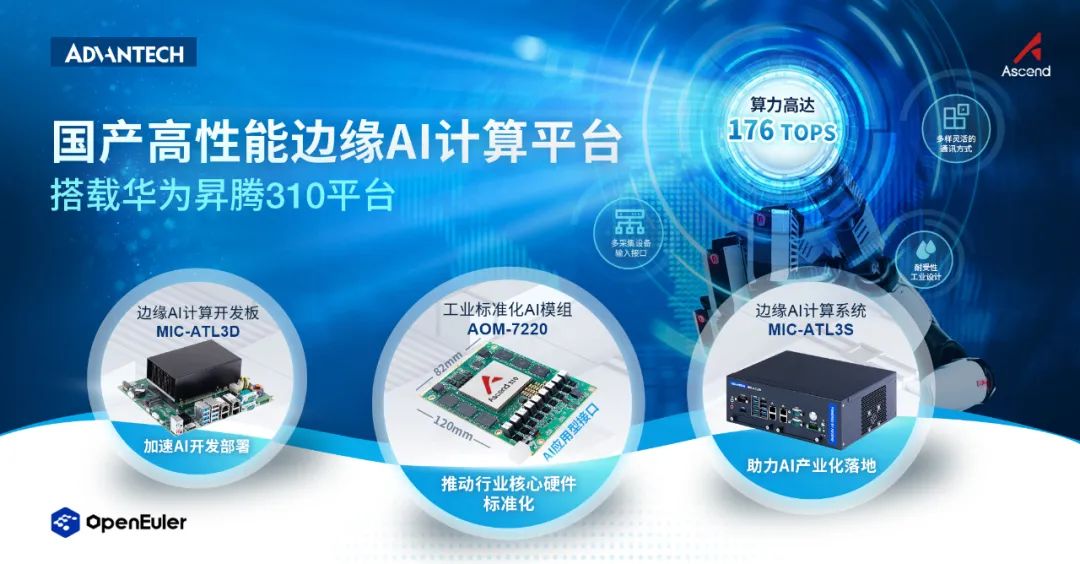

研華昇騰310系列邊緣AI平臺

研華基于昇騰Atlas 310系列平臺開發(fā)出三款不同形態(tài)的邊緣AI產(chǎn)品:工業(yè)標準化AI模組、邊緣AI開發(fā)套件以及邊緣AI盒子。此系列產(chǎn)品算力高達176 Tops,專注于工業(yè)場景下的細分應(yīng)用。同時,在軟件方面,研華聚焦底層開發(fā),定期更新SDK套件以滿足客戶的開發(fā)需求,并自主研發(fā)工業(yè)領(lǐng)域遠程部署和管理工具。

評論