從?模型到 AI 應(yīng)?落地,工程實(shí)現(xiàn)有多復(fù)雜?

眾所周知,?模型代表了??智能技術(shù)的前沿發(fā)展。它以強(qiáng)?的語(yǔ)?理解和?成能?,正在重塑許多領(lǐng)域。但是從獲得?模型的 API 接?,到將模型應(yīng)?于實(shí)際?產(chǎn)之間,存在巨?的鴻溝,到底要解決哪些問(wèn)題才能實(shí)現(xiàn)真正的跨越?

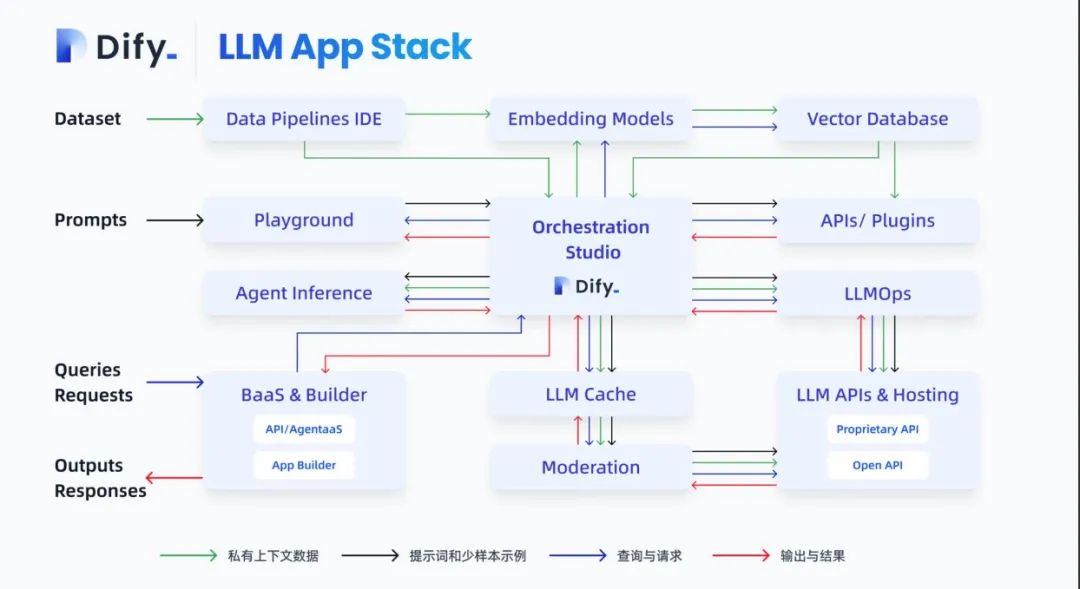

本文整理自 8 月 12 日「NPCon:AI模型技術(shù)與應(yīng)用峰會(huì)」上,來(lái)自 Dify.AI 創(chuàng)始人張路宇《LLM 應(yīng)用技術(shù)棧與Agent全景解析》的分享,介紹了當(dāng)前大模型技術(shù)應(yīng)用技術(shù)棧以及 Agent 技術(shù)的應(yīng)用場(chǎng)景和發(fā)展趨勢(shì)。

二、私有化數(shù)據(jù)接?:持續(xù)更新與調(diào)整三、Agent 的演進(jìn):自動(dòng)化編排四、我們最終會(huì)丟掉 LangChain 這本教科書(shū)

五、LLMOps 是如何解決這些問(wèn)題的?

備注:現(xiàn)場(chǎng)視頻請(qǐng)查閱「CSDN視頻號(hào)」,直播回放(56:30處起)

Prompt?程化:代碼與模型解耦

獲得?個(gè)?模型 API 之后,開(kāi)發(fā)者需要通過(guò)編寫(xiě)代碼對(duì) Prompt 進(jìn)?不斷調(diào)試和迭代優(yōu)化。

LLM應(yīng)用工程的演進(jìn)路線(xiàn)

LLM應(yīng)用工程的演進(jìn)路線(xiàn)

但是這種?式存在以下兩個(gè)核?問(wèn)題:

1、Prompt 與代碼?度耦合。?個(gè)好的 Prompt 需要?時(shí)間的調(diào)試和優(yōu)化才能達(dá)到預(yù)期效果,但與此同時(shí),實(shí)現(xiàn) Prompt 的代碼通常很簡(jiǎn)單,只是起到?個(gè)邏輯串聯(lián)的作?。這導(dǎo)致 Prompt ?程師和開(kāi)發(fā)者的?作?法有效分離,整個(gè)開(kāi)發(fā)過(guò)程效率低下。

2、對(duì)?技術(shù)?員完全不友好。Prompt 的調(diào)試實(shí)際上需要語(yǔ)?和領(lǐng)域?qū)<疫M(jìn)?語(yǔ)義上的迭代優(yōu)化。但是傳統(tǒng)的代碼開(kāi)發(fā)?式將 Prompt 封裝在代碼邏輯中,使得語(yǔ)?專(zhuān)家和?技術(shù)?員?法參與 Prompt 開(kāi)發(fā)和優(yōu)化過(guò)程,?法發(fā)揮他們的專(zhuān)?。

這樣的開(kāi)發(fā)?式導(dǎo)致 Prompt ?程很難落地。我們需要實(shí)現(xiàn) Prompt 與代碼的解耦,以更好地發(fā)揮語(yǔ)?專(zhuān)家和?技術(shù)專(zhuān)家的作?,讓 Prompt ?程像其他軟件?程流程?樣實(shí)現(xiàn)??分?、協(xié)作開(kāi)發(fā)。同時(shí),我們還需要使?更易?的界?與?具,降低?技術(shù)?員的使??檻,讓他們也能參與 Prompt 開(kāi)發(fā)和持續(xù)優(yōu)化,發(fā)揮各?的專(zhuān)業(yè)價(jià)值。

私有化數(shù)據(jù)接?:持續(xù)更新與調(diào)整

?模型都是通過(guò)公開(kāi)可?的數(shù)據(jù)集進(jìn)?預(yù)訓(xùn)練的,對(duì)單次輸??度也存在限制,?般在 4000 個(gè) Token 左右。這使得開(kāi)發(fā)者?法直接利?企業(yè)內(nèi)部的專(zhuān)有數(shù)據(jù)來(lái)豐富模型的應(yīng)?語(yǔ)境,構(gòu)建針對(duì)業(yè)務(wù)場(chǎng)景優(yōu)化的 AI 應(yīng)?。

要實(shí)現(xiàn)私有化數(shù)據(jù)的有效利?存在以下困難:

微調(diào)整個(gè)模型需要?量標(biāo)注數(shù)據(jù)、GPU 算?和時(shí)間成本。這對(duì)?部分?來(lái)說(shuō)不現(xiàn)實(shí)也不可?。

簡(jiǎn)單的?本匹配?式效果很有限。將??問(wèn)題與?檔?段簡(jiǎn)單匹配,容易產(chǎn)?語(yǔ)義偏差,?法精準(zhǔn)理解??意圖。

??本 Inputs 也難以直接接?模型,需要切分嵌?。

?法進(jìn)?持續(xù)數(shù)據(jù)接?和更新,模型語(yǔ)境脫離最新業(yè)務(wù)。

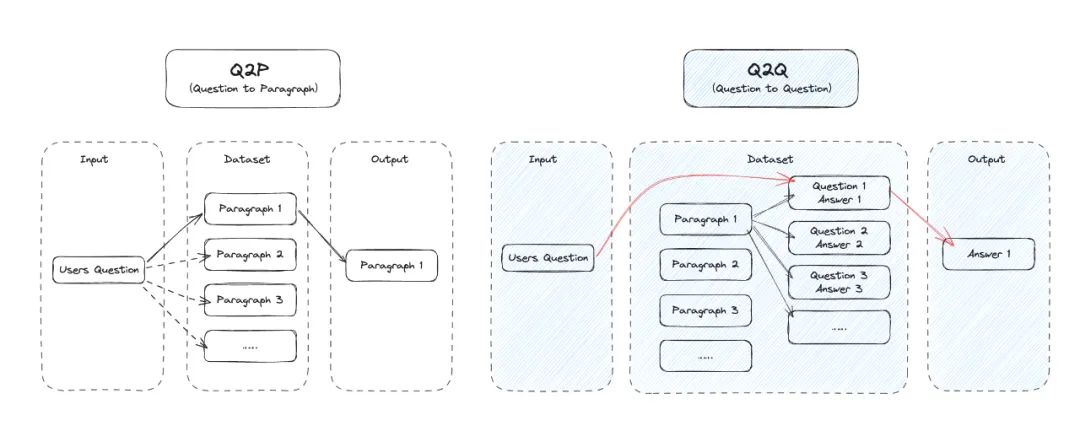

?如利?問(wèn)答對(duì)進(jìn)?匹配,?不是簡(jiǎn)單的上下??段,具體步驟是:

1.使?語(yǔ)義匹配技術(shù)對(duì)?檔庫(kù)進(jìn)?劃分,?成問(wèn)答對(duì)

2.將??查詢(xún)與問(wèn)答對(duì)庫(kù)匹配,找到匹配程度最?的問(wèn)答對(duì)

3.提取該問(wèn)答對(duì)的答案作為回復(fù)

這種匹配?式充分利?了問(wèn)答對(duì)的雙向互證關(guān)系,能?幅提升匹配精確度,使模型理解??意圖的能?上?個(gè)臺(tái)階。與此同時(shí),還需要?動(dòng)化處理??本的分割和向量嵌?,以便?效輸?模型。

然?即使這樣?個(gè)?常簡(jiǎn)單的能?,在實(shí)際開(kāi)發(fā)中都會(huì)有很多?程細(xì)節(jié)。

Agent 的演進(jìn):?動(dòng)化編排

AI 提?效率的進(jìn)程,是從輔助你更快地完成?件事?直接幫你完成?件事?替代?個(gè)?。也是 Agnet 從純??編排到?主編排的演進(jìn)過(guò)程。

要實(shí)現(xiàn)?個(gè)真正智能且?動(dòng)化的 Agent,需要解決多輪復(fù)雜對(duì)話(huà)中的?動(dòng)化推理和執(zhí)?問(wèn)題。主要?臨以下挑戰(zhàn):

1、?動(dòng)化規(guī)劃:分解對(duì)話(huà)?標(biāo)及完成任務(wù)所需的多個(gè)步驟,進(jìn)?動(dòng)態(tài)規(guī)劃。

2、提?記憶?:合理利??期記憶知識(shí)庫(kù)和多輪對(duì)話(huà)短期記憶,?不是單輪獨(dú)?推理。

3、?具使?:?縫調(diào)?外部?具和服務(wù),實(shí)現(xiàn)復(fù)雜任務(wù)?標(biāo)。

4、不斷總結(jié)反思:關(guān)注對(duì)話(huà)過(guò)程,總結(jié)經(jīng)驗(yàn),改進(jìn)下?輪回復(fù)。

5、多輪細(xì)致推理:進(jìn)?跨輪的深度推理,?不只是淺層次單輪推理。

6、?動(dòng)執(zhí)?:根據(jù)推理結(jié)果,完成真實(shí)世界的任務(wù)和?動(dòng)。

要實(shí)現(xiàn)這些能?,關(guān)鍵是以特定格式組織對(duì)話(huà)過(guò)程,引導(dǎo)模型進(jìn)?結(jié)構(gòu)化推理。包括??語(yǔ)句、過(guò)往對(duì)話(huà)記憶、?具調(diào)?以及反思等知識(shí)。還需要不斷學(xué)習(xí)和優(yōu)化這種過(guò)程表?,以產(chǎn)出更?質(zhì)量的對(duì)話(huà)與?動(dòng)執(zhí)?。

我們最終會(huì)丟掉 LangChain 這本教科書(shū)

LangChain 在?模型應(yīng)?開(kāi)發(fā)學(xué)習(xí)中?疑是教科書(shū)級(jí)的存在,它提供了完善的模型連接器、Prompt 模板、Agent 抽象概念等?檔。但從產(chǎn)品化應(yīng)??度,它也存在?些局限:

LangChain 更偏向代碼庫(kù),與業(yè)務(wù)系統(tǒng)集成困難,?法直接應(yīng)?于產(chǎn)品。

復(fù)雜的概念需要?量學(xué)習(xí)成本,?檻較?。

?具集成脆弱,直接應(yīng)?效果有限,模型?持存在鴻溝。

缺乏運(yùn)營(yíng)管理功能,不適合?技術(shù)?員使?。

?法進(jìn)?持續(xù)優(yōu)化和數(shù)據(jù)迭代。

LangChain 讓我們充分認(rèn)識(shí)到?模型應(yīng)?開(kāi)發(fā)的復(fù)雜性。但從代碼庫(kù)到產(chǎn)品,還需要進(jìn)?步的框架和?具?持。每個(gè)?都要學(xué)習(xí) LangChain,但最終都會(huì)丟掉它。

LLMOps是如何解決這些問(wèn)題的?

?對(duì)上述種種難題,是否存在?個(gè)?具或平臺(tái),可以幫助我們簡(jiǎn)化基于?模型構(gòu)建應(yīng)?的過(guò)程呢?

LLMOps(LargeLanguageModelOperations) 應(yīng)運(yùn)??。

LLMOps 是?個(gè)涵蓋?模型開(kāi)發(fā)、部署、優(yōu)化等全流程的最佳實(shí)踐。它的?標(biāo)是通過(guò)流程化和?具化,簡(jiǎn)化和降低基于?模型應(yīng)?開(kāi)發(fā)的?檻,解決數(shù)據(jù)、Prompt、Agent ?動(dòng)化等難題,使任何組織和開(kāi)發(fā)者都可以?效地利??模型技術(shù)。

?如 Dify,它作為 LLMOps 理念的具體實(shí)踐產(chǎn)品,成功地解決了從?模型到實(shí)際應(yīng)?之間的鴻溝,實(shí)現(xiàn)了理論到現(xiàn)實(shí)的轉(zhuǎn)化。

在 Prompt ?程化??,Dify 通過(guò)可視化編輯實(shí)現(xiàn)了 Prompt 與代碼的解耦,降低了學(xué)習(xí)?檻,提?了協(xié)作效率,讓更多??也能參與 Prompt ?程。

在私有化數(shù)據(jù)利???,Dify 通過(guò)?動(dòng)化的數(shù)據(jù)處理流程,實(shí)現(xiàn)了私有數(shù)據(jù)的?效注?,增強(qiáng)了模型的業(yè)務(wù)適配性。

在 Agent 的?動(dòng)化??,Dify 提供了完整的 Agent 構(gòu)建框架,??簡(jiǎn)化了?動(dòng)化推理系統(tǒng)的開(kāi)發(fā)。

通過(guò) Dify.AI 等 LLMops 開(kāi)發(fā)工具,可以有效解決以下問(wèn)題:

所?即所得的 Prompt ?程,?持?技術(shù)?員實(shí)時(shí)調(diào)試和優(yōu)化。

數(shù)據(jù) 0 代碼化準(zhǔn)備,?持快速數(shù)據(jù)清洗、分段和集成。

?動(dòng)化??本分割、嵌?和上下?存儲(chǔ)。

?鍵應(yīng)?部署,實(shí)時(shí)監(jiān)控和?志追蹤。

國(guó)內(nèi)外多模型可插拔組件化,?持GPT、Claude、MiniMax、百川BaiChuan、訊?星?等,選擇更加靈活。

?持托管在 HuggingFace 及 Replicate 上的開(kāi)源模型,如 Llama2。

Agent 實(shí)驗(yàn)室:智聊,推出了??瀏覽、Google 搜索、Wikipedia 查詢(xún)等第??插件。并與開(kāi)發(fā)者共建?主 Agent、插件開(kāi)發(fā)、多模態(tài)等新能?探索。

多?協(xié)作開(kāi)發(fā)和組織管理。

快速對(duì)接業(yè)務(wù)系統(tǒng),提供 API 接?即服務(wù)。

LLMOps 正將?模型技術(shù)從理想主義的概念,逐步引領(lǐng)?現(xiàn)實(shí)的應(yīng)?落地。它極?降低了基于?模型應(yīng)?開(kāi)發(fā)的?檻,提供了從理論到實(shí)踐的?縫過(guò)渡與落地。

*博客內(nèi)容為網(wǎng)友個(gè)人發(fā)布,僅代表博主個(gè)人觀點(diǎn),如有侵權(quán)請(qǐng)聯(lián)系工作人員刪除。