谷歌研究員被群嘲:LaMDA有人格是胡說八道!谷歌也回應:想多了,就是會聊而已

跟統計機器談感情,你就輸了。

——

文|杜晨 編輯|VickyXiao 題圖來源:News Text Area、谷歌

什么?AI 具備人格了??谷歌前不久搞出來了一個超大規模語言模型 LaMDA。公司里有個研究員 Blake Lemoine 跟它聊了很久,對其能力感到十分驚訝,于是下了個結論:LaMDA 可能已經具備人格了。(原話用的詞是 sentient,在不同的語境下可以被翻譯為感情、智慧、知覺等。)很快,這位仁兄就被“帶薪休假了”。

但他不是一個人:就連公司 VP Blaise Agüera y Arcas 都在發表文章,表示 AI 在獲得意識方面實現了巨大進步,“已經進入了一個嶄新時代。”

消息經過一眾媒體的報道,震撼了整個科技世界。不僅學術和工業界,就連很多普通人,都對 AI 技術的飛躍大吃一驚。“這一天終于來了?”“孩子們(如果你們將來還能活下來的話),請記住,這就是一切的開始。”然而,真正的 AI 專家們,卻對此嗤之以鼻。

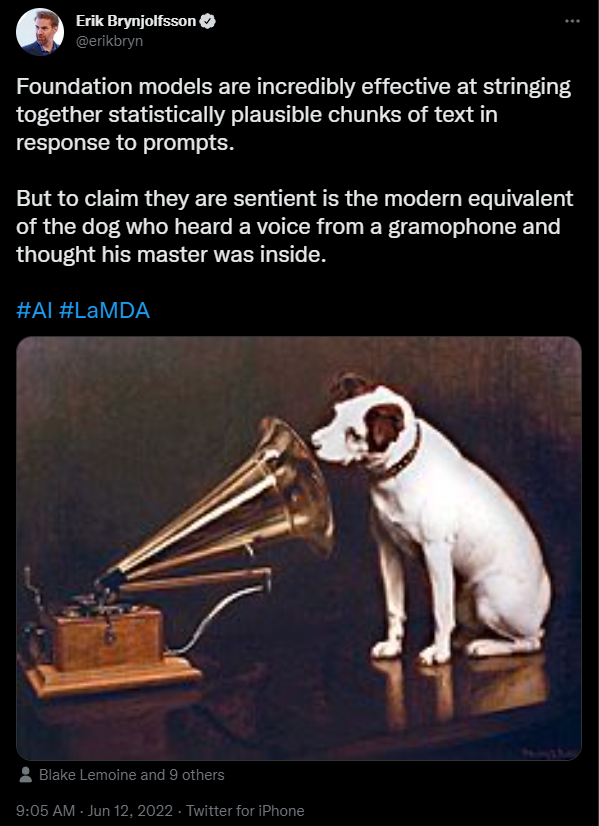

消息經過一眾媒體的報道,震撼了整個科技世界。不僅學術和工業界,就連很多普通人,都對 AI 技術的飛躍大吃一驚。“這一天終于來了?”“孩子們(如果你們將來還能活下來的話),請記住,這就是一切的開始。”然而,真正的 AI 專家們,卻對此嗤之以鼻。| AI具備人格?眾大佬嗤之以鼻斯坦福 HAI 中心主任 Erik Brynjolfsson 直接把這件事比喻為“面對留聲機的狗”,他發推表示:“基礎模型 (foundation models,也即自我監督的大規模深度神經網絡模型) 非常擅長做的一件事,就是根據提示,將文本采用統計學上合理的方式串起來。但是如果你說他們是有知覺的,就好比狗聽到留聲機里的聲音,以為它的主人在里面一樣。”

紐約大學心理學教授 Gary Marcus,同時也是一位頗為知名的機器學習和神經網絡專家,還直接撰文吐槽 LaMDA 具備人格 “胡說八道” (Nonsense)。[1]

紐約大學心理學教授 Gary Marcus,同時也是一位頗為知名的機器學習和神經網絡專家,還直接撰文吐槽 LaMDA 具備人格 “胡說八道” (Nonsense)。[1] “簡直是扯淡。無論是 LaMDA 還是它的近親們(比如 GPT-3)都沒有什么智能。它們所做的只是從人類語言的大規模統計數據庫當中提取,然后匹配模式。這些模式可能很酷,但這些系統說出的語言,實際上根本沒有任何的意義,更不可能意味著這些系統是有智慧的。”翻譯成白話就是:你看著 LaMDA 說的話都特別有哲理,特別真實,特別像人——然而它的設計功能就是模仿別人說話,它其實根本不知道自己在說什么。“具備知覺 (to be sentient) 的意思是意識到你在這個世界里的存在。LaMDA 并沒有這樣的意識,” Marcus 寫道。如果你以為這些聊天機器人具有人格,那么有幻覺的應該是你……比如在拼字游戲比賽當中,經常能看到母語非英語的玩家拼出英文單詞,卻根本不知道單詞是什么意思——LaMDA 也是如此,它只是會說話,卻根本不知道自己說的話是什么意思。Marcus 大佬直接把這種對于 AI 獲得人格的錯覺,形容為一種新型的“空想性錯覺”,也即把天空中的云看成龍和小狗,把月球上的隕石坑看成人臉和月兔。

“簡直是扯淡。無論是 LaMDA 還是它的近親們(比如 GPT-3)都沒有什么智能。它們所做的只是從人類語言的大規模統計數據庫當中提取,然后匹配模式。這些模式可能很酷,但這些系統說出的語言,實際上根本沒有任何的意義,更不可能意味著這些系統是有智慧的。”翻譯成白話就是:你看著 LaMDA 說的話都特別有哲理,特別真實,特別像人——然而它的設計功能就是模仿別人說話,它其實根本不知道自己在說什么。“具備知覺 (to be sentient) 的意思是意識到你在這個世界里的存在。LaMDA 并沒有這樣的意識,” Marcus 寫道。如果你以為這些聊天機器人具有人格,那么有幻覺的應該是你……比如在拼字游戲比賽當中,經常能看到母語非英語的玩家拼出英文單詞,卻根本不知道單詞是什么意思——LaMDA 也是如此,它只是會說話,卻根本不知道自己說的話是什么意思。Marcus 大佬直接把這種對于 AI 獲得人格的錯覺,形容為一種新型的“空想性錯覺”,也即把天空中的云看成龍和小狗,把月球上的隕石坑看成人臉和月兔。 AI 學術界新星之一,Mozilla 基金會高級研究員 Abeba Birhane 也表示:“帶著最小限度的批判思維,我們終于登上了AI炒作的巔峰。”Birhane 是所謂的 “AI 知覺論” 的長期批評者。她在一篇發表于2020年的論文里,曾經直接提出了以下幾個觀點:

AI 學術界新星之一,Mozilla 基金會高級研究員 Abeba Birhane 也表示:“帶著最小限度的批判思維,我們終于登上了AI炒作的巔峰。”Birhane 是所謂的 “AI 知覺論” 的長期批評者。她在一篇發表于2020年的論文里,曾經直接提出了以下幾個觀點:1)大家天天炒的 AI 并不是真的 AI,而是統計學系統,是機器人 (robot);2)我們不應該賦予機器人權利;3)我們甚至壓根就不應該討論是否要賦予機器人權利……比利時 Donders Institute 計算認知科學教授 Olivia Guest 也加入了“戰局“,稱整個事情的邏輯是錯亂的。“‘我看到的東西像人,因為我按照人的樣子開發的它,所以它是一個人’——簡直是倒騎驢的邏輯。”

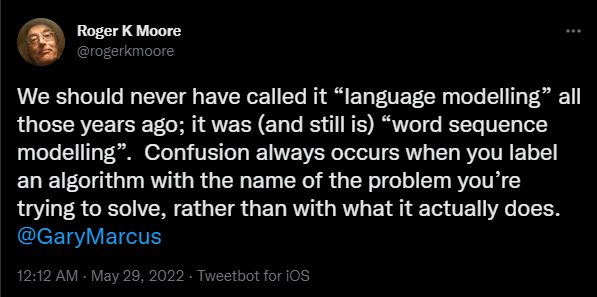

英國謝菲爾德大學機器人學院教授 Roger Moore 指出:人們會有 “AI 獲得人格”的這種錯覺,一個最關鍵的原因就是當年的那幫研究員非要管這項工作叫做“語言建模”。正確的叫法應該是“詞序建模”(word sequence modelling)。“你開發了一個算法,卻不用它實際能做的事情去命名,而是用你想要解決的問題——這樣總是會發生誤會。”

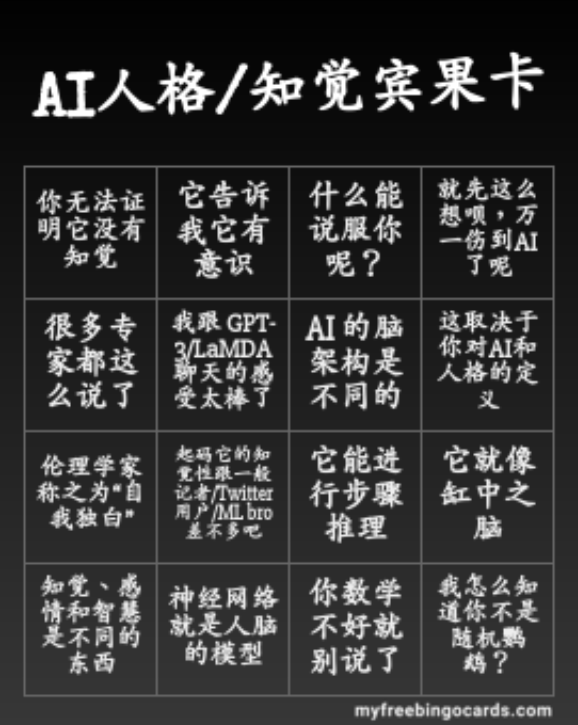

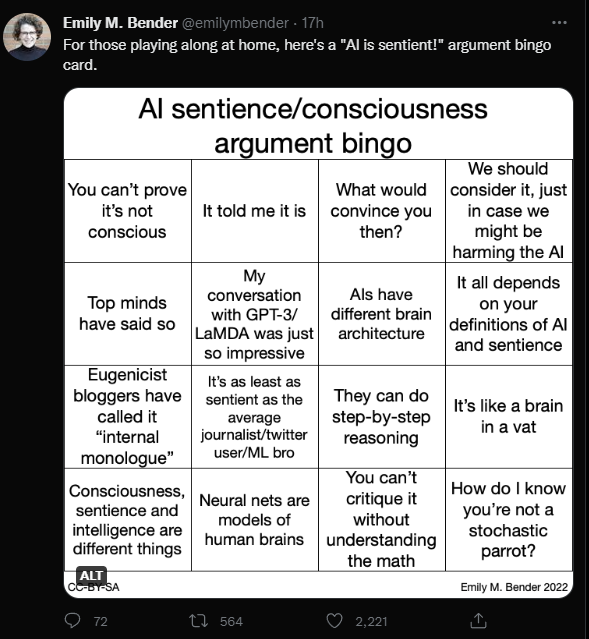

英國謝菲爾德大學機器人學院教授 Roger Moore 指出:人們會有 “AI 獲得人格”的這種錯覺,一個最關鍵的原因就是當年的那幫研究員非要管這項工作叫做“語言建模”。正確的叫法應該是“詞序建模”(word sequence modelling)。“你開發了一個算法,卻不用它實際能做的事情去命名,而是用你想要解決的問題——這樣總是會發生誤會。” 總而言之,各位業界大牛的結論就是:你最多可以說 LaMDA 能夠高分通過圖靈測試。說它具備人格?那可真是太搞笑了。更何況就連圖靈測試的參考價值也沒那么高了。Macus 直言,很多 AI 學者希望這個測試被取消、被人們遺忘的原因,正是因為它利用了人類容易上當,傾向于將機器當作人的這一弱點。華盛頓大學的計算機語言系主任 Emily Bender 教授,干脆做了一個“AI 人格意識爭論”的賓果卡:(這個賓果卡的意思就是,如果你認為 AI 有人格/知覺,并且你的論據是下面的其中一種,那你最好就別聊了!)

總而言之,各位業界大牛的結論就是:你最多可以說 LaMDA 能夠高分通過圖靈測試。說它具備人格?那可真是太搞笑了。更何況就連圖靈測試的參考價值也沒那么高了。Macus 直言,很多 AI 學者希望這個測試被取消、被人們遺忘的原因,正是因為它利用了人類容易上當,傾向于將機器當作人的這一弱點。華盛頓大學的計算機語言系主任 Emily Bender 教授,干脆做了一個“AI 人格意識爭論”的賓果卡:(這個賓果卡的意思就是,如果你認為 AI 有人格/知覺,并且你的論據是下面的其中一種,那你最好就別聊了!) 原版:

原版: | 谷歌也回應:別想多,它就是會聊而已那位被指為”走火入魔“的研究員 Blake Lemoine 在自己發表的一篇文章中,批評谷歌對于了解自己開發成果的真實情況“沒有興趣”,然而自己在長達6個月的對話事件當中,看到 LaMDA 對于自己想要的東西,特別是“自己作為人的權利”,表達的越來越清晰,使得自己相信 LaMDA 真的是人。然而在谷歌看來,這位研究員完全想多了,甚至有點走火入魔了。LaMDA 真的不是人,它純粹就是特別會聊天而已……

| 谷歌也回應:別想多,它就是會聊而已那位被指為”走火入魔“的研究員 Blake Lemoine 在自己發表的一篇文章中,批評谷歌對于了解自己開發成果的真實情況“沒有興趣”,然而自己在長達6個月的對話事件當中,看到 LaMDA 對于自己想要的東西,特別是“自己作為人的權利”,表達的越來越清晰,使得自己相信 LaMDA 真的是人。然而在谷歌看來,這位研究員完全想多了,甚至有點走火入魔了。LaMDA 真的不是人,它純粹就是特別會聊天而已……事情在社交網絡上發酵之后,谷歌很快作出了回應:LaMDA 和公司近幾年的大型 AI 項目一樣,都經過了多次嚴格的 AI 道德方面的審核,對其內容、質量、系統安全性等進行了多方面的考量。今年早些時候,谷歌也專門發表了一篇論文,公開了 LaMDA 開發過程當中的合規細節。“在 AI 群體內,對于具備感知的 AI/通用 AI 的長期可能性,確實有一些研究。然而在今天把對話模型來擬人化,這樣做是沒有意義的,因為這些模型是沒有知覺的。”“這些系統能夠基于數以百萬計的句子來模仿交流的方式,并且在任何有趣的話題上都能夠扯出有意思的內容。如果你問它們做一支冰激淋恐龍是怎樣的體驗,它們可以生成大量關于融化咆哮之類的文字。”

(These systems imitate the types of exchanges found in millions of sentences, and can riff on any fantastical topic — if you ask what it’s like to be an ice cream dinosaur, they can generate text about melting and roaring and so on.)

類似的故事我們見過太多了,特別是前幾年一個非常經典的電影《她》(Her) 里面,主角對于虛擬助手的身份界限越來越不清晰,把“她”當成了人。然而根據電影的描繪,這種錯覺其實來自于當代人社交失敗、情感破裂、孤獨感等一系列自我和社會性的問題,跟聊天機器人到底是不是人這一技術性的問題,壓根沒有半毛錢關系。

電影《她》劇照 圖片來源:華納兄弟影業

當然,有這些問題并不是我們的錯,想要把機器人當成人,也不是那個研究員的錯。將各種情緒(比如思念)托付在物件上,是人類自古以來就具有的一種創造性的情感能力。將大規模語言模型當成人,對其傾注情感,雖然被各位 AI 大佬批評為一種心理誤差,不也正是人之所以為人的體現嗎?不過,至少在今天,談啥都別跟機器人談感情……參考資料:[1] Nonsense on Stilts by Gary Marcus https://garymarcus.substack.com/p/nonsense-on-stilts*博客內容為網友個人發布,僅代表博主個人觀點,如有侵權請聯系工作人員刪除。