騰訊優(yōu)圖出品:P2P網絡的人群檢測與計數

人群計數是計算機視覺中的一項核心任務,旨在估計靜止圖像或視頻幀中的行人數量。在過去的幾十年中,研究人員在該領域投入了大量精力,并在提升現有主流基準數據集的性能方面取得了顯著進展。

1背景

人群計數是計算機視覺中的一項核心任務,旨在估計靜止圖像或視頻幀中的行人數量。 在過去的幾十年中,研究人員在該領域投入了大量精力,并在提升現有主流基準數據集的性能方面取得了顯著進展。然而,訓練卷積神經網絡需要大規(guī)模和高質量的標記數據集,而注釋像素級行人位置的成本高得令人望而卻步。

此外,由于數據分布之間的域轉移,在標簽豐富的數據域(源域)上訓練的模型不能很好地泛化到另一個標簽稀缺域(目標域),這嚴重限制了現有方法的實際應用。

2 引言

最近的ICCV2021,騰訊優(yōu)圖出品了一個人群基數相關論文《Rethinking Counting and Localization in Crowds: A Purely Point-Based Framework》。

論文:https://arxiv.org/pdf/2107.12858.pdf

相比僅僅估計人群中的總人數,在人群中定位每個個體更為切合后續(xù)高階人群分析任務的實際需求。但是,已有的基于定位的解決方法依賴于某些中間表示(如密度圖或者偽目標框)作為學習目標,這不光容易引入誤差,而且是一種反直覺的做法。

優(yōu)圖團隊提出了一種完全基于點的全新框架,可同時用于人群計數和個體定位。針對基于該全新框架的方法,我們不滿足于僅僅量化圖像級別的絕對計數誤差,因此研究者提出了一種全新的度量指標即密度歸一化平均精度,來提供一個更全面且更精準的性能評價方案。

此外,作為該框架一個直觀解法,研究者給出了一個示例模型,叫做點對點網絡(P2PNet)。P2PNet忽略了所有冗余步驟,直接預測一系列人頭點的集合來定位圖像中的人群個體,這完全與真實人工標注保持一致。通過深入分析,研究者發(fā)現實現該方法的一個核心策略是為預測候選點分配最優(yōu)的學習目標,并通過基于匈牙利算法的一對一匹配策略來完成了這一關鍵步驟。實驗證明,P2PNet不光在人群計數基準上顯著超越了已有SOTA方法,還實現了非常高的定位精度。

今天我們“計算機視覺研究院”分享另一篇《計算機協(xié)會》收錄的一篇人群計數論文《Coarse to Fine: Domain Adaptive Crowd Counting via Adversarial Scoring Network》。

3 框架分析

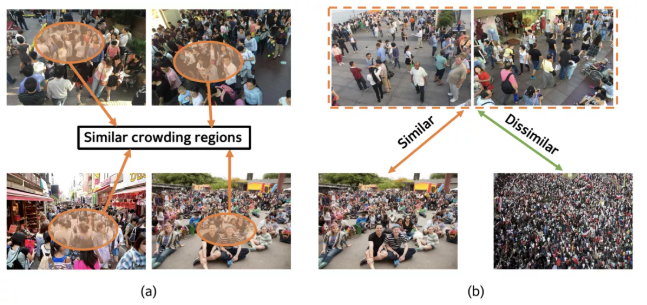

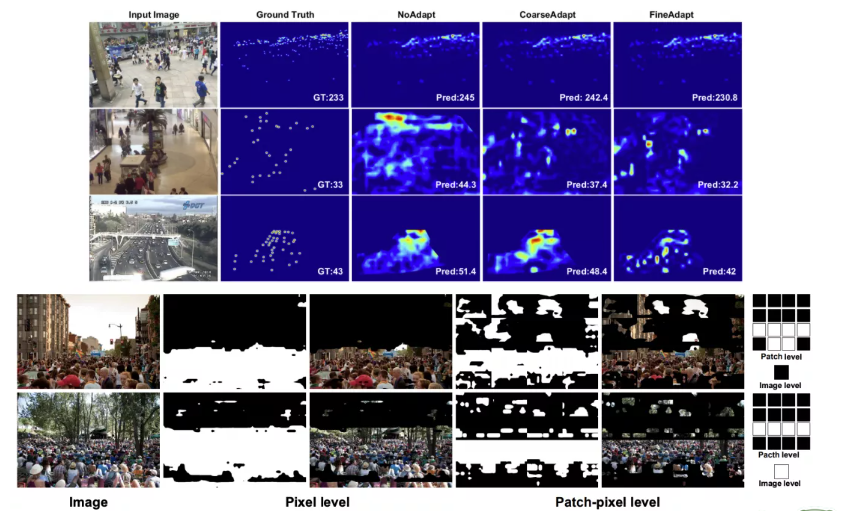

目標域(下圖頂部)和源域(下圖底部)之間存在的域相似性的圖示。左:一些擁擠區(qū)域在像素級別跨域相似。右圖:部分源樣本可能與目標樣本共享相似的圖像分布。

最近的深度網絡令人信服地展示了人群計數的高能力,這是一項因其各種工業(yè)應用而引起廣泛關注的關鍵任務。盡管取得了這樣的進展,但由于固有的領域轉移,訓練有素的依賴于數據的模型通常不能很好地推廣到看不見的場景。

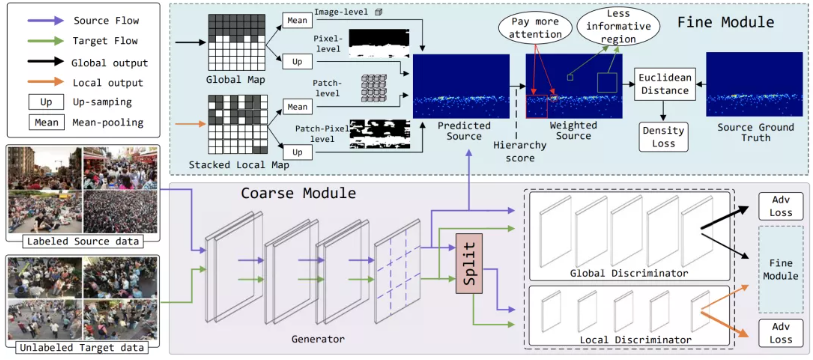

為了解決這個問題,有研究者提出了一種新穎的對抗性評分網絡 (ASNet),以逐步彌合域之間從粗粒度到細粒度的差距。具體來說,在粗粒度階段,設計了一種雙鑒別器策略,通過對抗性學習,從全局和局部特征空間的角度使源域接近目標。兩個域之間的分布因此可以大致對齊。在細粒度階段,通過基于粗階段得出的生成概率對源樣本與來自多個級別的目標樣本的相似程度進行評分來探索源特征的可轉移性。由這些分層分數引導,正確選擇可轉移的源特征,以增強適應過程中的知識傳輸。通過從粗到細的設計,可以有效緩解由域差異引起的泛化瓶頸。

生成器將輸入圖像編碼為密度圖。然后雙鑒別器將密度圖分類為源域或目標域。通過生成器和雙鑒別器之間的對抗訓練,域分布接近。同時,雙鑒別器進一步產生四種類型的分數作為信號來指導源數據的密度優(yōu)化,從而在適應過程中實現細粒度轉移。

4實驗及可視化

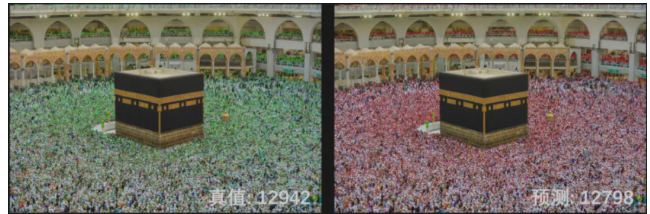

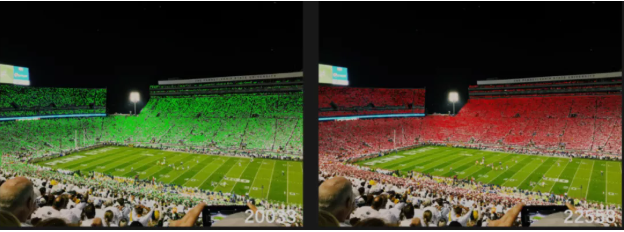

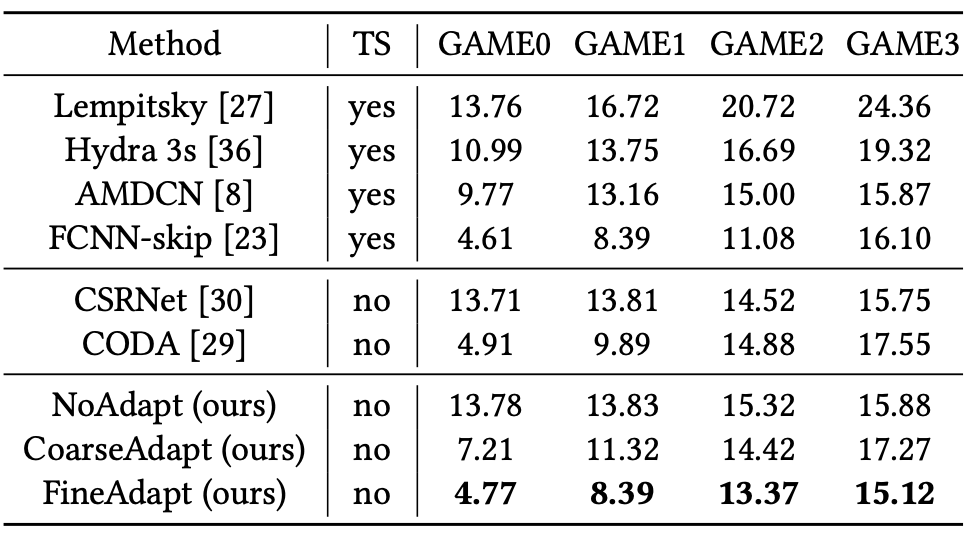

研究者考慮了從ShanghaiTech Part A到Trancos的實驗,如上表所示。顯然,所提出的方法比現有的適應方法提高了2.9%。

由雙重鑒別器生成的不同級別(分別為像素、補丁像素、補丁、圖像)級別分數的可視化。圖中的正方形代表一個標量。注意白色方塊代表1,黑色方塊代表0。

*博客內容為網友個人發(fā)布,僅代表博主個人觀點,如有侵權請聯(lián)系工作人員刪除。