AI 看唇語,在嘈雜場景的語音識別準(zhǔn)確率高達(dá)75%

編譯 | 禾木木

出品 | AI科技大本營(ID:rgznai100)

人們通過聆聽和觀察說話者的嘴唇動作來感知言語。

那么,AI 也可以嗎?

事實(shí)上,研究表明視覺線索在語言學(xué)習(xí)中起著關(guān)鍵的作用。相比之下,人工智能語言識別系統(tǒng)主要是建立在音頻上。而且需要大量數(shù)據(jù)來訓(xùn)練,通常需要數(shù)萬小時(shí)的記錄。

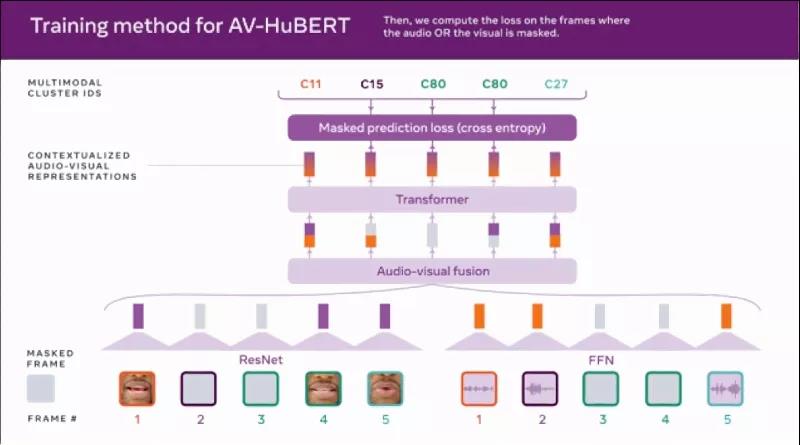

為了研究視覺效果,尤其是嘴部動作的鏡頭,是否可以提高語音識別系統(tǒng)的性能。Meta 的研究人員開發(fā)了 Audio-Visual Hidden Unit BERT (AV-HuBERT),這是一個(gè)通過觀看學(xué)習(xí)和聽人們說話來理解語言的框架。

Meta 聲稱 AV-HuBERT 比使用相同數(shù)量轉(zhuǎn)錄量的最佳視聽語音識別系統(tǒng)準(zhǔn)確率高 75%。此外,該公司表示,AV-HuBERT 使用十分之一的標(biāo)記數(shù)據(jù)優(yōu)于以前最好的視聽語言識別系統(tǒng),這使得它可能對音視頻數(shù)據(jù)很少的語言具有潛在的用途。

Meta AI 研究科學(xué)家 Abdelrahman Mohamed 表示:“在未來,像 AV-HuBERT 這樣的 AI 框架可用于提高語音識別技術(shù)在嘈雜的日常條件下的性能,例如,在聚會上或在熙熙攘攘的街頭中進(jìn)行的互動。智能手機(jī)中的助手、增強(qiáng)現(xiàn)實(shí)眼鏡和配備攝像頭的智能揚(yáng)聲器,例如 Alexa Echo Show 也可以在這項(xiàng)技術(shù)中受益。”

目前,Meta 已將相關(guān)代碼開源到 GitHub。

AV-HuBERT

Meta 并不是第一個(gè)將人工智能應(yīng)用于讀唇語問題的公司。2016年,牛津大學(xué)的研究人員創(chuàng)建了一個(gè)系統(tǒng),該系統(tǒng)在某些測試中的準(zhǔn)確率幾乎是經(jīng)驗(yàn)豐富的唇讀者的兩倍,并且可以實(shí)時(shí)地處理視頻。2017年,Alphabet 旗下的 DeepMind 在數(shù)千小時(shí)的電視節(jié)目中訓(xùn)練了一個(gè)系統(tǒng),在測試集上可以正確翻譯約 50%的單詞而沒有錯(cuò)誤,遠(yuǎn)高于人類專家的 12.4%。

但是牛津大學(xué)和 DeepMind 的模型,與許多后續(xù)的唇讀模型一樣,在它們可以識別的詞匯范圍內(nèi)受到限制。這些模型還需要與轉(zhuǎn)錄本配對的數(shù)據(jù)集才能進(jìn)行訓(xùn)練,而且它們無法處理視頻中任何揚(yáng)聲器的音頻。

有點(diǎn)獨(dú)特的是, AV-HuBERT 利用了無監(jiān)督或自我監(jiān)督的學(xué)習(xí)。通過監(jiān)督學(xué)習(xí),像 DeepMind 這樣的算法在標(biāo)記的示例數(shù)據(jù)上進(jìn)行訓(xùn)練,直到它們可以檢測到示例和特定輸出之間的潛在關(guān)系。例如,系統(tǒng)可能會被訓(xùn)練在顯示柯基的圖片時(shí)寫出單詞「dog」。然而,AV-HuBERT 自學(xué)對未標(biāo)記的數(shù)據(jù)進(jìn)行分類,處理數(shù)據(jù)以從其固有結(jié)構(gòu)中學(xué)習(xí)。

AV-HuBERT 也是多模態(tài)的,因?yàn)樗ㄟ^一系列的音頻和唇部動作提示來學(xué)習(xí)感知語言。通過結(jié)合說話過程中嘴唇和牙齒的運(yùn)動等線索以及聽覺信息,AV-HuBERT 可以捕捉這兩種數(shù)據(jù)類型之間的細(xì)微關(guān)聯(lián)。

最初的 AV-HuBERT 模型在 30 小時(shí)的 TED Talk 視頻上進(jìn)行了訓(xùn)練,大大少于之前最先進(jìn)模型的 31,000 小時(shí)的訓(xùn)練時(shí)間。但是,盡管在較少的數(shù)據(jù)上進(jìn)行了訓(xùn)練,AV-HuBERT 的單詞錯(cuò)誤率 (WER)(衡量語音識別性能的指標(biāo))在可以看到但聽不到說話者的情況下略好于舊模型的 33.6%,前者為 32.5%。(WER 的計(jì)算方法是將錯(cuò)誤識別的單詞數(shù)除以總單詞數(shù);32.5% 轉(zhuǎn)化為大約每 30 個(gè)單詞出現(xiàn)一個(gè)錯(cuò)誤。)在 433 小時(shí)的 TED 演講訓(xùn)練進(jìn)一步將 AV-HuBERT 的 WER 降低到 28.6%。

一旦 AV-HuBERT 很好地了解了數(shù)據(jù)之間的結(jié)構(gòu)和相關(guān)性,研究人員就能夠在未標(biāo)記的數(shù)據(jù)上進(jìn)一步訓(xùn)練它。上傳到 YouTube 的 2,442 小時(shí)名人英語視頻,這不僅使 WER 下降到 26.9%,而且 Meta 表示,它表明只需要少量標(biāo)記數(shù)據(jù)來訓(xùn)練特定應(yīng)用程序(例如,當(dāng)多人同時(shí)說話時(shí))或不同語言的框架。

事實(shí)上,Meta 聲稱當(dāng)背景中播放響亮的音樂或噪音時(shí),AV-HuBERT 在識別一個(gè)人的語音方面比純音頻模型好約 50%,當(dāng)語音和背景噪音同樣響亮?xí)r,AV-HuBERT 的 WER 為 3.2%,而之前的最佳多模式模型為 25.5%。

潛在的缺點(diǎn)

在許多方面來看,AV-HuBERT 象征著 Meta 在用于復(fù)雜任務(wù)的無監(jiān)督、多模式技術(shù)方面不斷增長的投資。

Meta 表示 AV-HuBERT 可以為開發(fā)“低資源”語言的對話模型開辟可能性。該公司建議,AV-HuBERT 還可用于為有語言障礙的人創(chuàng)建語音識別系統(tǒng),以及檢測深度偽造和為虛擬現(xiàn)實(shí)化身生成逼真的嘴唇運(yùn)動。

在各方面數(shù)據(jù)上,新方法的變現(xiàn)著實(shí)很精彩,但也有學(xué)者有一些擔(dān)憂。

其中,華盛頓大學(xué)的人工智能倫理學(xué)專家Os Keye就提到,對于因患有唐氏綜合征、中風(fēng)等疾病而導(dǎo)致面部癱瘓的人群,依賴讀唇的語音識別還有意義嗎?

在微軟和卡內(nèi)基梅隆大學(xué)的一篇論文中,提出了人工智能公平性研究路線圖,指出類似于 AV-HuBERT 的面部分析系統(tǒng)的某些方面可能不適用于患有唐氏綜合癥、軟骨發(fā)育不全(損害骨骼生長)和“導(dǎo)致特征性面部差異的其他條件”等。

Mohamed 強(qiáng)調(diào) AV-HuBERT 只關(guān)注唇部區(qū)域來捕捉唇部運(yùn)動,而不是整個(gè)面部。他補(bǔ)充說,與大多數(shù) AI 模型類似,AV-HuBERT 的性能將“與訓(xùn)練數(shù)據(jù)中不同人群的代表性樣本數(shù)量成正比”。

“為了評估我們的方法,我們使用了公開可用的 LRS3 數(shù)據(jù)集,該數(shù)據(jù)集由牛津大學(xué)研究人員于 2018 年公開提供的 TED Talk 視頻組成。由于該數(shù)據(jù)集不代表殘疾說話者,因此我們沒有預(yù)期性能下降的特定百分比,”Mohamed 說。

Meta 表示,它將“繼續(xù)在背景噪聲和說話者重疊很常見的日常場景中進(jìn)行基準(zhǔn)測試和開發(fā)改進(jìn)視聽語音識別模型的方法。”

參考鏈接:

https://venturebeat.com/2022/01/07/meta-claims-its-ai-improves-speech-recognition-quality-by-reading-lips/

*博客內(nèi)容為網(wǎng)友個(gè)人發(fā)布,僅代表博主個(gè)人觀點(diǎn),如有侵權(quán)請聯(lián)系工作人員刪除。