英偉達(dá)把P圖軟件GAN了

英偉達(dá)的最新AI工具又讓網(wǎng)友用戶們激動(dòng)了。

“我已經(jīng)等不及了!”

一位網(wǎng)友在看完演示視頻后表示。對于“手殘黨”來說,英偉達(dá)的EditGAN簡直就是零基礎(chǔ)P圖神器。能夠高質(zhì)量、高精細(xì)度地對圖像進(jìn)行修改,讓P圖方式從未如此容易。

例如,讓畫像和雕塑“擠眉弄眼”:

只要你會上傳圖片、能畫草圖,就能夠輕松P圖。如此“魔性”的工具,難怪得到了網(wǎng)友熱捧。

EditGAN甚至能精細(xì)到修改車輪輻條大小和方向:

當(dāng)然,真人照片也不在話下,如控制人眼朝向、頭發(fā)量等:

還能給貓咪修改耳朵大小:

而你要做的,只是上傳一張圖片,然后由程序生成一張語義分割草圖,直接在草圖上涂抹修改。

△ 在草圖中加入牙齒部分,人就笑了

EditGAN只會修改你想要改變的部位,其他部分都原封不動(dòng)。和最近的GauGAN2一樣,英偉達(dá)也為EditGAN開發(fā)了一個(gè)電腦軟件:

這項(xiàng)研究已經(jīng)被NeurIPS 2021接收。

本文一作是來自多倫多大學(xué)的華人博士生凌歡,他同時(shí)在該校人工智能研究院(Vector Institute)和英偉達(dá)做研究。

首個(gè)GAN驅(qū)動(dòng)的圖像編輯器

研究人員表示,EditGAN是第一個(gè)GAN驅(qū)動(dòng)的圖像編輯框架,它的主要特點(diǎn)是:

1. 提供非常高的精度編輯;

2. 只需要很少的注釋訓(xùn)練數(shù)據(jù);

3. 可以實(shí)時(shí)交互式運(yùn)行;

4. 允許多個(gè)編輯的直接合成;

5. 適用于真正的嵌入式、GAN生成甚至域外圖像。

首先,EditGAN使用StyleGAN2生成圖像。StyleGAN2的工作流程是:獲取圖像,將其編碼到潛在空間,并使用生成器將這個(gè)編碼子空間轉(zhuǎn)換為另一個(gè)圖像。

但問題在于,這個(gè)空間是多維的,我們很難將其可視化,也很難確定該子空間的哪一部分負(fù)責(zé)重建圖像中的哪個(gè)特征。

通常,需要龐大的標(biāo)注數(shù)據(jù)集,才能知道模型中潛在空間哪一部分控制哪些特征。

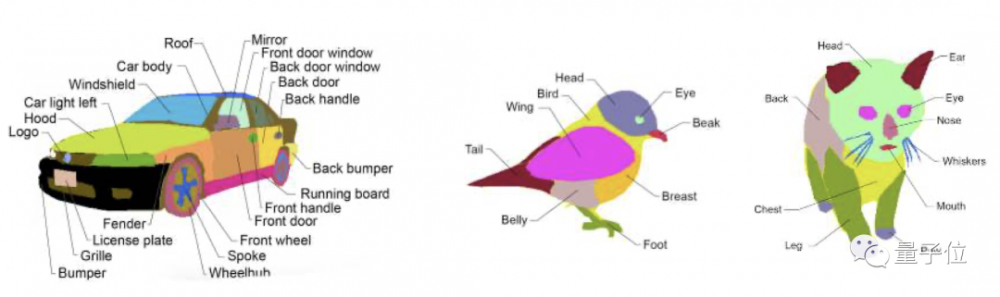

而EditGAN僅通過對少數(shù)標(biāo)記的數(shù)據(jù)集示例進(jìn)行學(xué)習(xí),就能將分割與圖像相匹配,從而實(shí)現(xiàn)圖像圖像的編輯。

EditGAN保留了完整的圖像質(zhì)量,同時(shí)提供了前所未有的細(xì)節(jié)和自由度。更重要的是EditGAN不僅知道潛在空間對應(yīng)控制那個(gè)部分,而且還將它們與草圖對應(yīng)起來。這樣,我們就可以通過修改草圖輕易地修改圖像了。

EditGAN基于DatasetGAN,結(jié)合了圖像建模及其語義分割。EditGAN的關(guān)鍵思想在于利用圖像和像素級語言分割聯(lián)合分布。

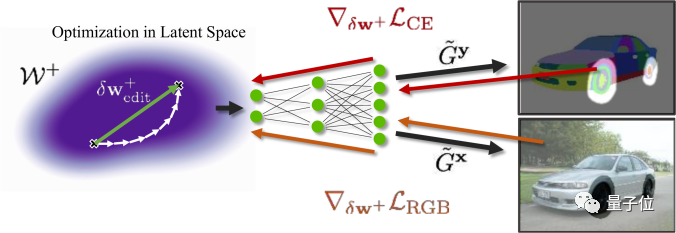

具體而言,就是將圖像嵌入GAN的潛在空間,并根據(jù)分割編輯執(zhí)行條件潛在代碼優(yōu)化。

以上展示了EditGAN的訓(xùn)練過程:修改語義分割并優(yōu)化共享的潛在代碼,與編輯區(qū)域內(nèi)的新分割,以及編輯區(qū)域外的RGB外觀保持一致。相應(yīng)的梯度通過共享生成器進(jìn)行反向傳播。

為了攤銷優(yōu)化,作者在實(shí)現(xiàn)編輯的潛在空間中找到“編輯矢量”。該框架允許學(xué)習(xí)任意數(shù)量的編輯矢量,然后以實(shí)時(shí)的速率直接應(yīng)用于其他圖像。

P圖工具即將發(fā)布

作者團(tuán)隊(duì)在英偉達(dá)內(nèi)部GPU集群上使用V100執(zhí)行底層 StyleGAN2、編碼器和分割分支的訓(xùn)練以及嵌入和編輯的優(yōu)化。該項(xiàng)目使用了大約14000個(gè)GPU 小時(shí),其中大約3500個(gè) GPU 小時(shí)用于最終實(shí)驗(yàn),其余用于研究項(xiàng)目早期階段的探索和測試。

至于EditGAN的運(yùn)行,在V100上進(jìn)行30 (60) 步優(yōu)化需要 11.4 (18.9) 秒。

雖然訓(xùn)練不起,但是用訓(xùn)練好的模型來P圖還是有可能的。

此前英偉達(dá)發(fā)布的Canvas就集成了GauGAN2等最新成果,可以用手繪草圖生成精細(xì)的PS文件。

可能Canvas也會很快集成EditGAN的吧。

有個(gè)好消息是,英偉達(dá)表示,將會代碼和編輯工具軟件即將推出。你是是不是迫不及待想嘗試一把了?

論文地址:

https://arxiv.org/abs/2111.03186

補(bǔ)充材料:

https://nv-tlabs.github.io/editGAN/editGAN_supp_compressed.pdf

講解視頻:

https://www.youtube.com/watch?v=bus4OGyMQec

*博客內(nèi)容為網(wǎng)友個(gè)人發(fā)布,僅代表博主個(gè)人觀點(diǎn),如有侵權(quán)請聯(lián)系工作人員刪除。