NüWA:女?huà)z算法,多模態(tài)預(yù)訓(xùn)練模型,大殺四方!

論文地址:https://arxiv.org/abs/2111.12417

源代碼:https:// github.com/microsoft/NUWA

一、前言

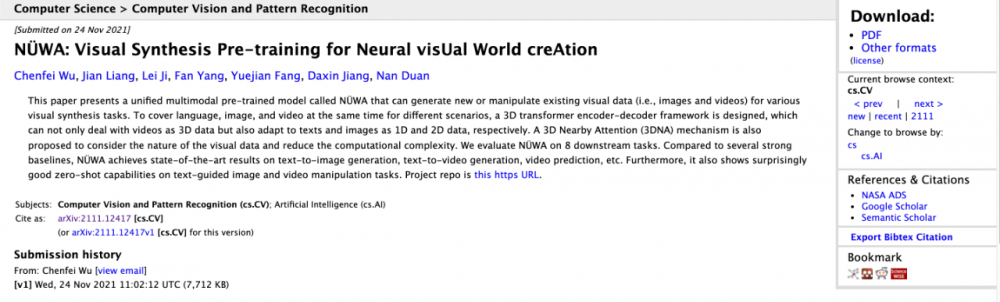

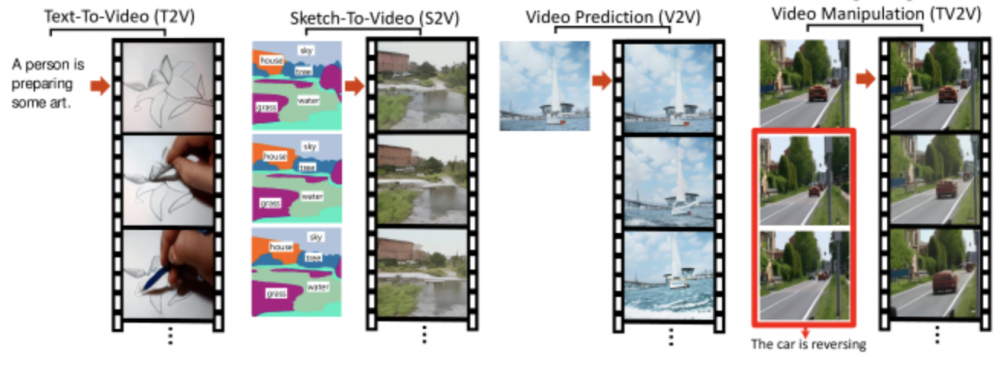

今天分享的論文,主要提出了一個(gè)統(tǒng)一的多模態(tài)預(yù)訓(xùn)練模型,稱(chēng)為NüWA,可以為各種視覺(jué)合成任務(wù)生成新的或操縱現(xiàn)有的視覺(jué)數(shù)據(jù)(即圖像和視頻)。針對(duì)不同場(chǎng)景同時(shí)覆蓋語(yǔ)言、圖像和視頻,設(shè)計(jì)了3D Transformer編碼器-****框架,不僅可以將視頻作為3D數(shù)據(jù)處理,還可以分別將文本和圖像作為1D和2D數(shù)據(jù)進(jìn)行適配。還提出了3D Nearby Attention(3DNA)機(jī)制來(lái)考慮視覺(jué)數(shù)據(jù)的性質(zhì)并降低計(jì)算復(fù)雜度。在8個(gè)下游任務(wù)上評(píng)估NüWA。與幾個(gè)強(qiáng)大的基線(xiàn)相比,NüWA在文本到圖像生成、文本到視頻生成、視頻預(yù)測(cè)等方面取得了最先進(jìn)的結(jié)果。此外,它還顯示了令人驚訝的良好的文本零樣本能力——引導(dǎo)圖像和視頻處理任務(wù)。

8個(gè)任務(wù)的案例

二、背景

如今,網(wǎng)絡(luò)變得比以往任何時(shí)候都更加視覺(jué)化,圖像和視頻已成為新的信息載體,并已被用于許多實(shí)際應(yīng)用中。在此背景下,視覺(jué)合成正成為越來(lái)越受歡迎的研究課題,其目的是構(gòu)建可以為各種視覺(jué)場(chǎng)景生成新的或操縱現(xiàn)有視覺(jué)數(shù)據(jù)(即圖像和視頻)的模型。

自回歸模型【Auto-regressive models】在視覺(jué)合成任務(wù)中發(fā)揮著重要作用,因?yàn)榕cGAN相比,它們具有顯式的密度建模和穩(wěn)定的訓(xùn)練優(yōu)勢(shì)。早期的視覺(jué)自回歸模型,如PixelCNN、PixelRNN、Image Transformer、iGPT和Video Transformer,都是以“pixel-by-pixel”的方式進(jìn)行視覺(jué)合成的。然而,由于它們?cè)诟呔S視覺(jué)數(shù)據(jù)上的高計(jì)算成本,這些方法只能應(yīng)用于低分辨率的圖像或視頻,并且難以擴(kuò)展。

最近,隨著VQ-VAE作為離散視覺(jué)標(biāo)記化方法的出現(xiàn),高效和大規(guī)模的預(yù)訓(xùn)練可以應(yīng)用于圖像的視覺(jué)合成任務(wù)(例如DALL-E和CogView) 和視頻(例如GODIVA)。盡管取得了巨大的成功,但此類(lèi)解決方案仍然存在局限性——它們分別處理圖像和視頻,并專(zhuān)注于生成它們中的任何一個(gè)。這限制了模型從圖像和視頻數(shù)據(jù)中受益。

三、NüWA的表現(xiàn)

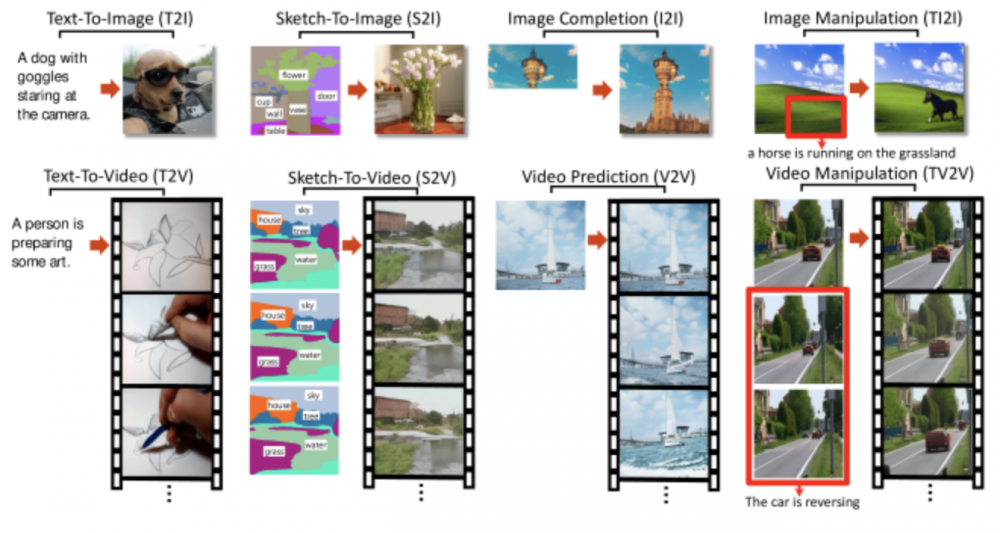

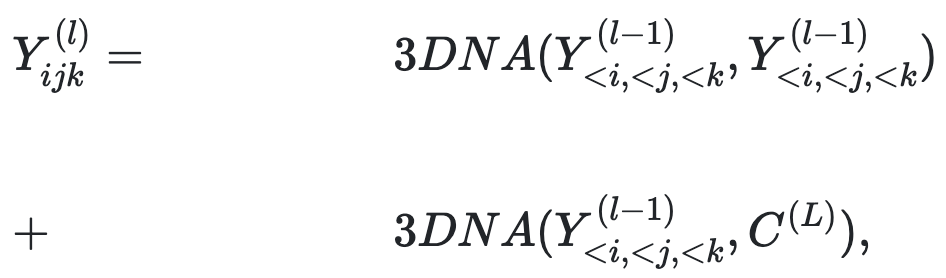

Text-To-Image(T2I)

一只戴著護(hù)目鏡,盯著攝像機(jī)的狗

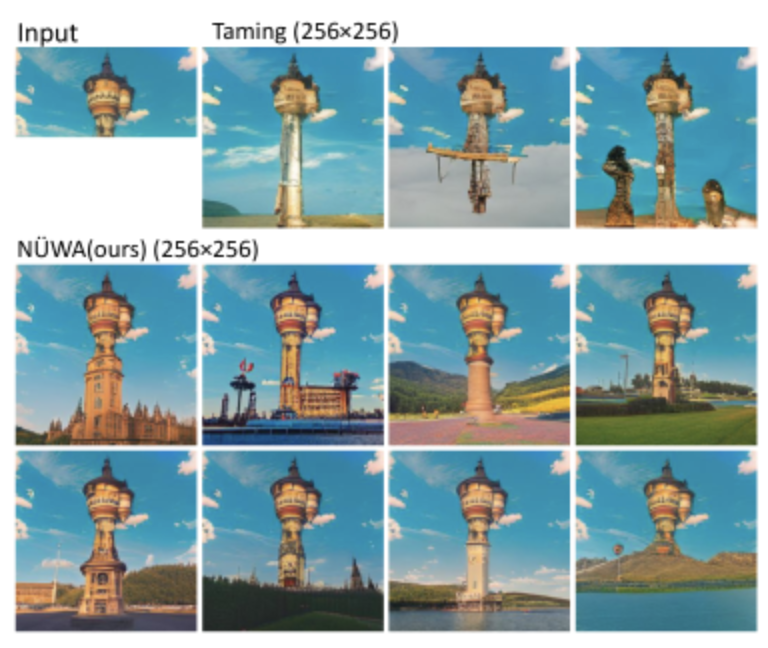

Sketch-To-Image (S2I)

草圖轉(zhuǎn)圖片任務(wù),就是根據(jù)草圖的布局,生成對(duì)應(yīng)的圖片

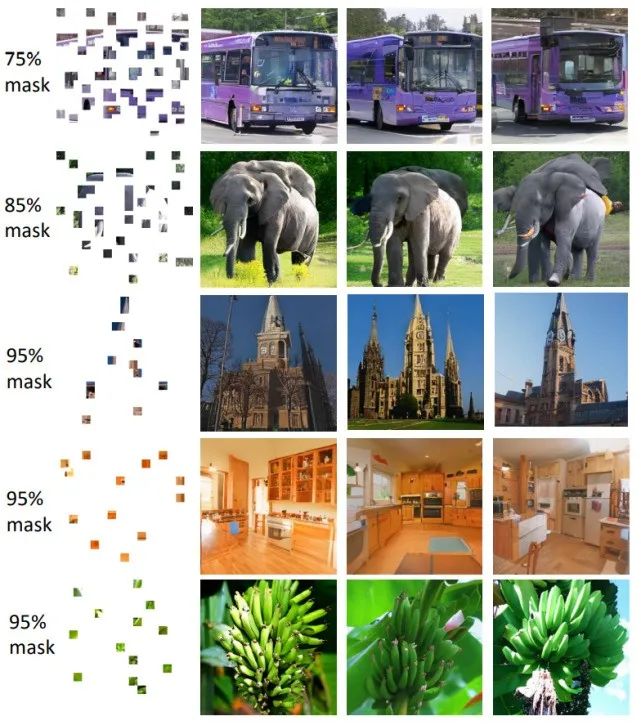

Image Completion (I2I)

圖像補(bǔ)全,如果一副圖片殘缺了,算法可以自動(dòng)“腦補(bǔ)”出殘缺的部分

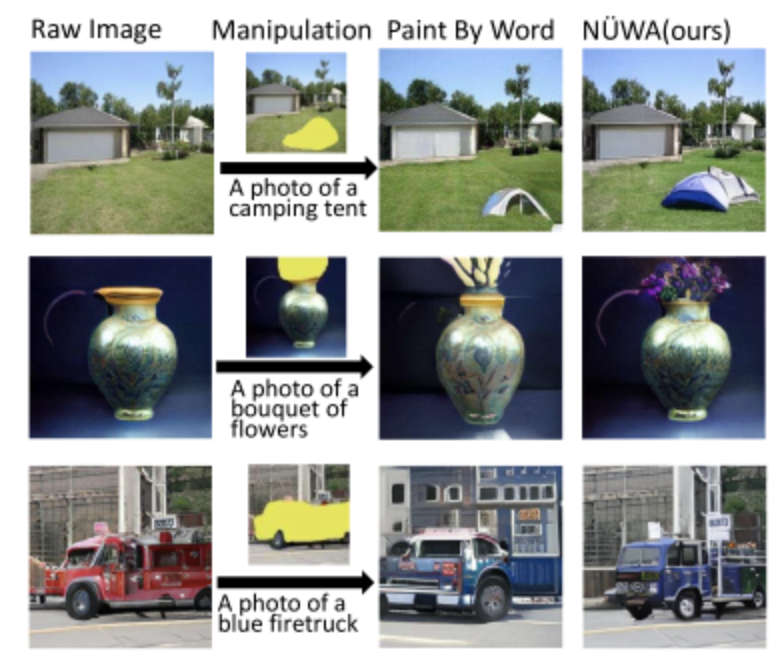

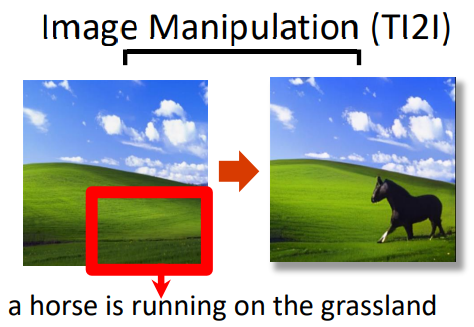

Image Manipulation (TI2I)

圖片處理,根據(jù)文字描述,處理圖片

例如:有一副草原的圖片,然后增加一段描述:一匹馬奔跑在草原上,然后就可以生成對(duì)應(yīng)的圖片。

Video

四、新框架

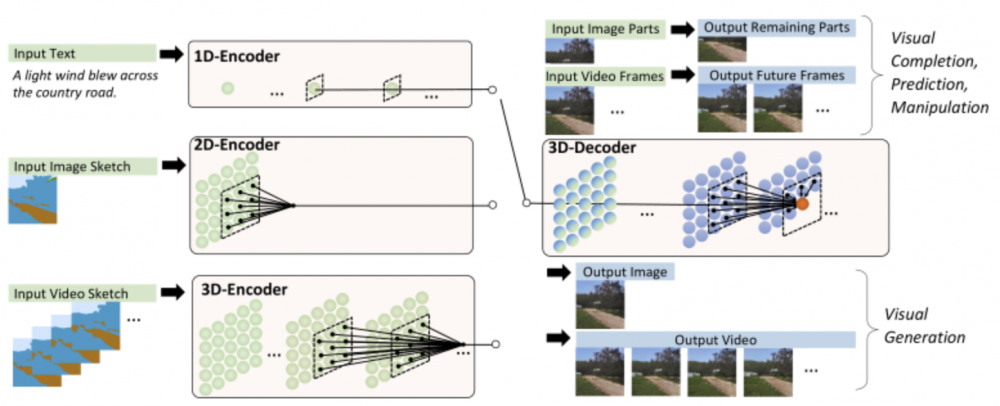

NüWA模型的整體架構(gòu)包含一個(gè)支持多種條件的 adaptive 編碼器和一個(gè)預(yù)訓(xùn)練的****,能夠同時(shí)使圖像和視頻的信息。對(duì)于圖像補(bǔ)全、視頻預(yù)測(cè)、圖像處理和視頻處理任務(wù),將輸入的部分圖像或視頻直接送入****即可。

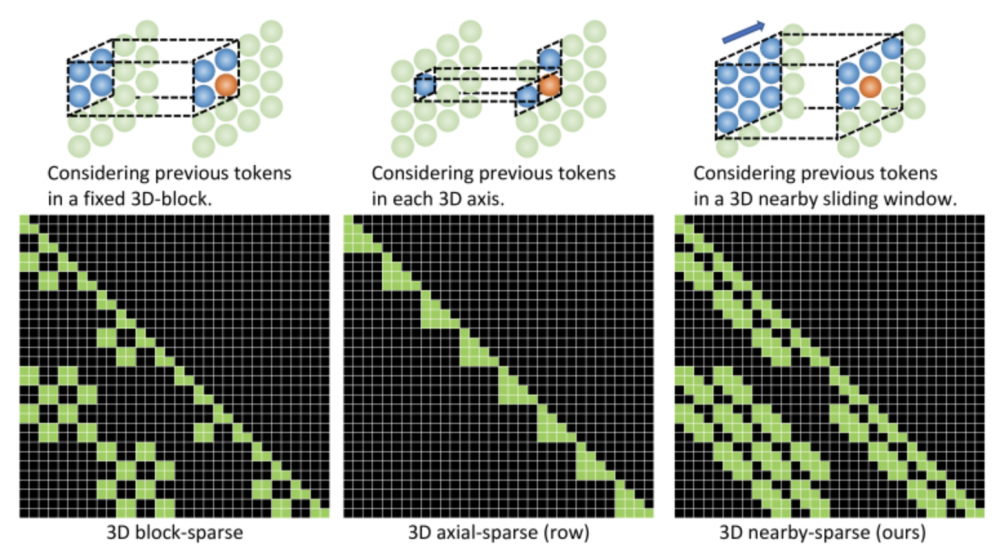

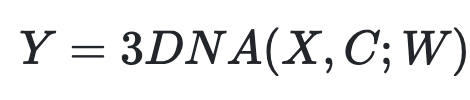

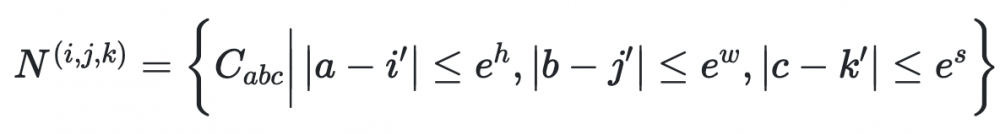

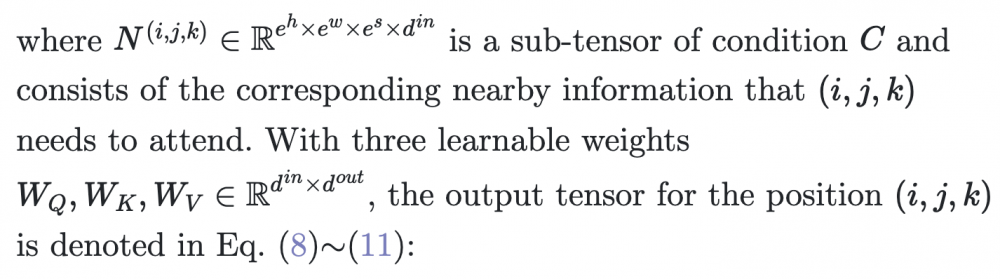

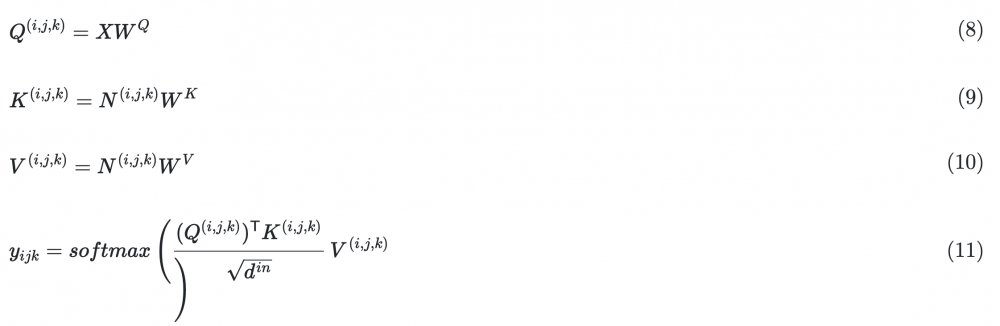

而編碼****都是基于一個(gè)3D NEARBY SELF-ATTENTION(3DNA)建立的,該機(jī)制可以同時(shí)考慮空間和時(shí)間軸的上局部特性,定義如下:

W 表示可學(xué)習(xí)的權(quán)重,X 和 C 分別代表文本、圖像、視頻數(shù)據(jù)的 3D 表示。

3DNA考慮了完整的鄰近信息,并為每個(gè)token動(dòng)態(tài)生成三維鄰近注意塊。注意力矩陣還顯示出3DNA的關(guān)注部分(藍(lán)色)比三維塊稀疏注意力和三維軸稀疏注意力更平滑。

3D DATA REPRESENTATION

為了涵蓋所有文本、圖像和視頻或其草圖,研究者將它們?nèi)恳暈闃?biāo)記并定義統(tǒng)一的 3D符號(hào)X∈Rh×w×s×d,其中h和w表示空間軸(分別為高度和寬度)中的標(biāo)記數(shù)量,s表示時(shí)間軸上的標(biāo)記數(shù)量,d是每個(gè)標(biāo)記的維度。

3D NEARBY SELF-ATTENTION

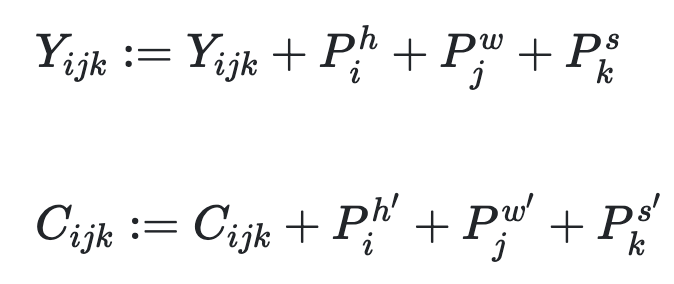

基于之前的3D數(shù)據(jù)表示定義了一個(gè)統(tǒng)一的3D Nearby Self-Attention (3DNA) 模塊,支持自注意力和交叉注意力。首先給出方程中3DNA的定義:

并在如下等式中介紹詳細(xì)的實(shí)現(xiàn)。

3D ENCODER-DECODER

開(kāi)始介紹基于3DNA構(gòu)建的3D編碼-****。為了在C∈Rh′×w′×s′×din的條件下生成目標(biāo)Y∈Rh×w×s×dout,Y和C的位置編碼通過(guò)考慮高度、寬度和時(shí)間軸的三個(gè)不同的可學(xué)習(xí)詞匯更新。

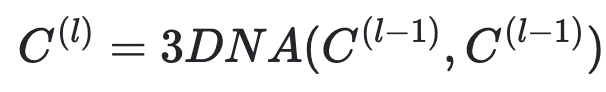

然后,條件C被輸入到具有L 3DNA層堆棧的編碼器中,以對(duì)自注意力交互進(jìn)行建模,第l層在等式中表示:

同樣,****也是一堆L 3DNA層。****計(jì)算生成結(jié)果的自注意力以及生成結(jié)果和條件之間的交叉注意力。第l層表示如下等式。

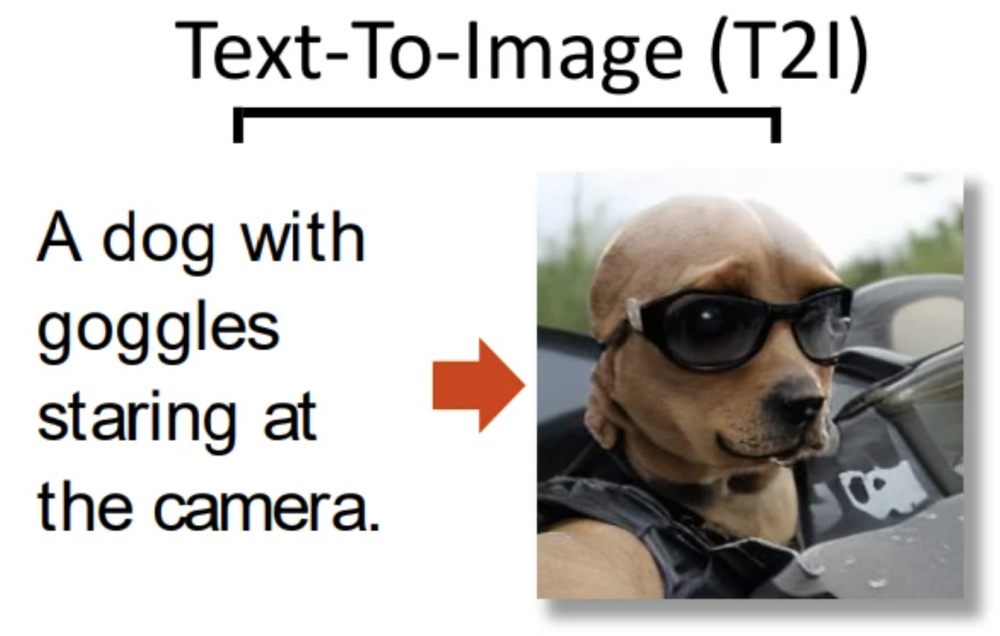

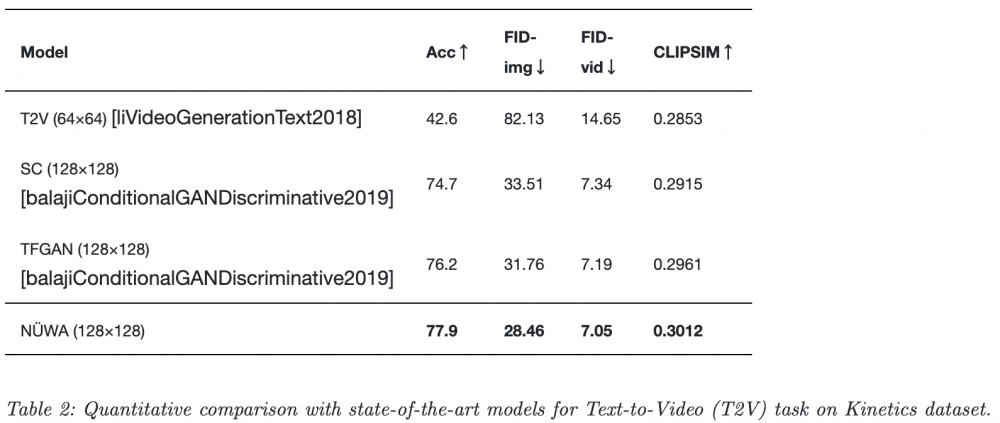

五、實(shí)驗(yàn)簡(jiǎn)單分析

圖

其他實(shí)驗(yàn)可在論文中獲取!

*博客內(nèi)容為網(wǎng)友個(gè)人發(fā)布,僅代表博主個(gè)人觀點(diǎn),如有侵權(quán)請(qǐng)聯(lián)系工作人員刪除。