精心設計的 GNN 只是“計數器”?

編者按:問答(QA)任務是自然語言理解領域中一個基本且重要的課題,目前通常會使用預訓練語言模型以及圖神經網絡等方法對問答進行推理。GNN 模塊在推理中到底發揮了什么作用?這個問題需要科研人員做進一步深入探究。為此,微軟亞洲研究院和佐治亞理工的研究員們剖析了最前沿的相關方法,并且發現一種極其簡單、高效的圖神經計數器就能在主流的知識問答數據集中取得更好的效果。

長期以來,問答(QA)問題都是人工智能和自然語言處理領域中一個基本且重要的課題,層出不窮的研究工作都試圖賦予問答系統具有人類水平的推理能力。然而,人類的推理過程是極為復雜的,為了接近這樣復雜的推理,目前最前沿的方法一般會使用預訓練的語言模型(LM)來獲取和利用其隱含的知識,再輔以精心設計的圖神經網絡(GNN)來對知識圖譜進行推理。但是關于 GNN 模塊在這些推理中到底發揮了哪些功能,仍需要進一步深入研究。

為此,微軟亞洲研究院和佐治亞理工的研究員們剖析了最前沿的相關方法,并且發現一種極其簡單、高效的圖神經計數器就能在主流的知識問答數據集中取得更好的效果。同時,研究員們還揭示了當前基于知識推理的 GNN 模塊很有可能只是在完成簡單的推理功能如計數。(點擊閱讀原文,查看論文)

論文鏈接:https://arxiv.org/abs/2110.03192

知識的獲取和推理是問答(QA)任務的核心, 而這些知識被隱式編碼于預訓練語言模型(LM)或者顯式存儲在結構化的知識圖譜(KG)里。當前的 LM 在預訓練過程中都會使用大規模的語料庫,其中蘊含極其豐富的知識,這就使得 LM 稍加微調(finetune)就可以在各種 QA 數據集上取得不錯的表現。

但是,LM 更依賴于共現(co-occurrance),這在處理推理問題時捉襟見肘,并缺乏可解釋性。而與之互補的 KG 盡管需要人工整理且規模受限,但它可以直接顯示存儲特定的信息和關系,從而具備可解釋性。

如何在 QA 里將二者結合起來揚長避短是近年來的熱點話題,最前沿的工作大多采用了兩個步驟來處理知識圖譜:

1. Schema graph grounding。在知識圖譜里檢索與 QA 文本提及的實體相關聯的子圖,這個子圖包含帶有概念文本的節點和代表關系的邊以及鄰接矩陣。

2. 圖建模推理(Graph modeling for inference)。用設計精巧的 GNN 模塊對這個子圖進行建模推理。

這里的 GNN 模塊通常會設計得比較復雜,比如 KagNet 用了 GCN-LSTM-HPA 即基于路徑的分層注意力機制(HPA)來耦合 GCN 與 LSTM,從而對基于路徑的關系圖進行表征;再如 QA-GNN 則在以 GAT 網絡為主體的同時,用 LM 將 QA 文本編碼到圖中,成為一個單獨的節點,從而與圖中其它概念和關系進行聯合推理。

隨著 QA 系統變得越來越復雜,研究員們也不得不進一步思考一些基本問題:這些 GNN 模型是不夠復雜還是過于復雜了?它們究竟在推理中扮演了哪些關鍵的角色?

為了回答這些問題,研究員們首先分析了現在最先進的基于 GNN 的 QA 系統及其推理能力。基于發現,研究員們設計了一種圖計數網絡。這個網絡不光簡單高效,而且在 CommonsenseQA 和 OpenBookQA 這兩個基于推理的主流數據集上都達到了更優的效果。

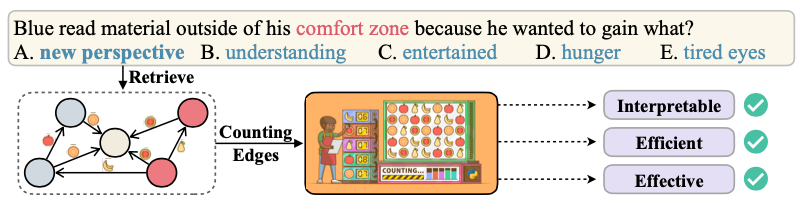

圖 1 :研究員們分析發現當前 GNN 在 QA 中扮演的關鍵角色是對邊進行計數,于是便設計了一種高效且具有解釋性的圖計數模塊來對 QA 進行推理。

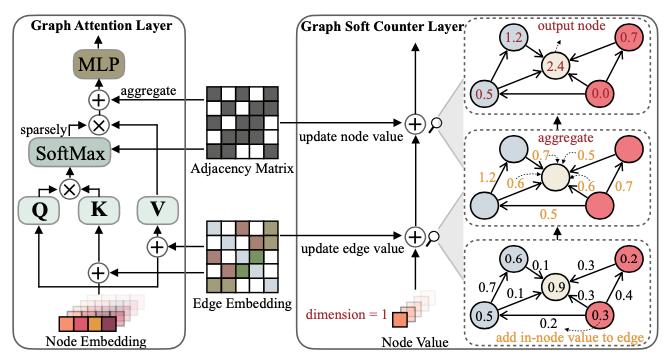

而為了分析 QA 里最前沿的基于 GNN 對的系統,研究員們則用 SparseVD 剪枝方法對 GNN 各個子單元先進行剪枝訓練,然后,在不損失精度的前提下,對各層保留的稀疏率進行統計,以判斷各子模塊的重要性及功能。如圖2所示,通常檢索得到的 KG 子圖會被預處理成 Node Embedding, Edge Embedding 和鄰接矩陣,相關分數等部分則作為 GNN 的輸入。研究員們通過分析發現,初始的 Node Embedding 和相關分數是不必要的,相關層的稀疏率幾乎可以被剪枝到零,即這些相關層可以直接去掉。而 Edge Embedding 相關層更難被剪枝,可見其對當前場景下的推理非常重要。對于 GAT 里的 message passing 層,通過觀察可以得知,這些層的稀疏率都比較低,尤其是前幾層的 query 和 key 層已經接近于零,即這些層有過參數化的趨勢,并且注意力機制幾乎退化為線性變換。

圖 2:研究員們用剪枝方法 SparseVD 作為工具對 QA 里的 GNN 各個模塊進行分析,發現邊的信息相關層極為重要,而其它很多層存在過參數化的現象。

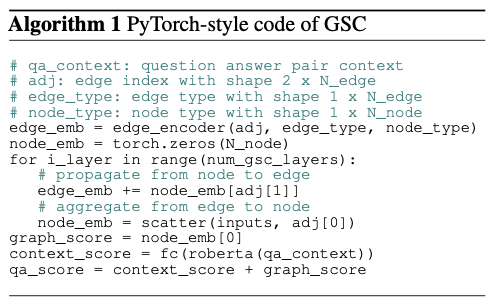

基于分析結論,研究員們設計了一個極其簡單且高效的基于計數的Graph Soft Counter(GSC)。如圖3所示,相較于其他主流的 GNN 如 GAT,GSC 只有兩個基本部件:邊編碼器(Edge encoder)和圖計數層(Graph Soft Counter Layer),并且節點和邊上的隱層維度也減少到1,這意味著在途中流動的全是單個的數字,可以將它們解釋為邊和節點的重要性分數。亦如圖4的算法一所示,GSC 極度簡化 massage passing 的過程為最基本的兩個操作即 propagation 和 aggregation,從而將這些重要性分數加總到 QA context 中心節點,并作為選項的分數進行輸出。

圖 3:GSC 層交替更新邊和節點上的計數分數

圖 4:算法一:將邊信息進行編碼后,GSC 層執行 message passing 將分數匯總到中心節點即為圖分

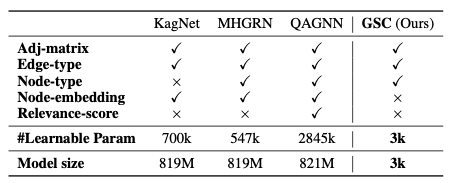

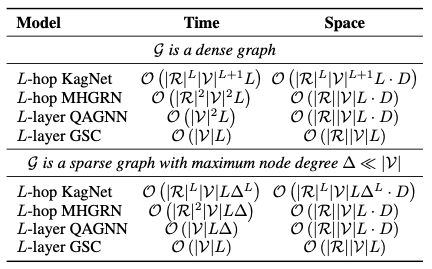

值得一提的是,GSC 層內部是完全無參數的,這也使得它非常高效。如表1所示,GSC 的可學習參數量少于其它 GNN 模塊的百分之一,并且由于沒有使用初始的Node Embedding,GSC 的模型存儲大小更是小了五個數量級。再如表2所示,GSC 在時間和空間復雜度上也都極其高效。

表 1:GSC 僅使用了鄰接矩陣和邊/節點類型信息,且參數極少

表 2:GSC 在時間和空間復雜度上都極其高效

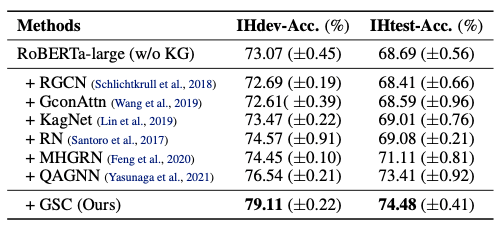

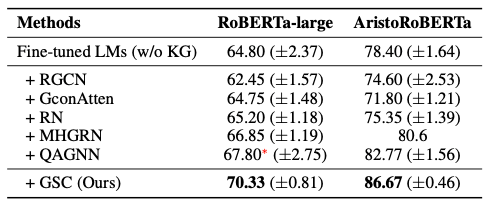

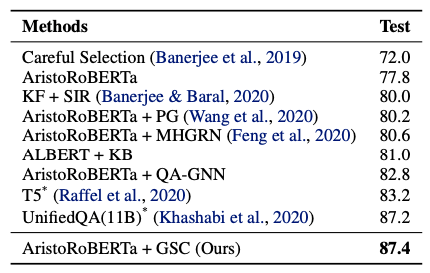

除了簡單高效,GSC 的表現也很突出。研究員們在 CommonsenseQA 和 OpenBookQA 這兩個基于推理的主流數據集上進行了實驗。論文中提出的基線既有未使用 KG 的 LM 本身,也有其它使用 GNN 來處理 KG 的其他前沿方法。如表3~5所示,GSC 方法在兩個數據集上都占有優勢,并且在OpenBookQA 官方排行榜上位居第一,甚至超過了 UnifiedQA(11B)這個擁有110億參數的巨無霸模型。

表 3:GSC 在 CommonsenseQA 數據集上優于其它基于 GNN 的方法

表 4:GSC 在 OpenBookQA 數據集上優于其它基于 GNN 的方法

表 5:GSC 在 OpenBookQA 官方排行榜上排名第一,甚至超過了 UnifiedQA

本篇論文的分析和提出的方法,揭示了當前復雜的基于 GNN 的 QA 系統很可能只是在執行一些基礎的推理功能比如計數這一現象。如何打造一個面面俱到的 QA 系統以達到人類的推理水平仍是一個丞待解決的宏大命題。

*博客內容為網友個人發布,僅代表博主個人觀點,如有侵權請聯系工作人員刪除。

pa相關文章:pa是什么