DeepMind 的新強化學習系統是邁向通用 AI 的一步嗎?

來源 | 數據實戰派

這篇文章是我們對 AI 研究論文評論的一部分,這是一系列探索人工智能最新發現的文章。

對于已經精通圍棋、星際爭霸 2 和其他游戲的深度強化學習模型來說,人工智能系統的主要挑戰之一是它們無法將其能力泛化到訓練領域之外。這種限制使得將這些系統應用到現實世界中變得非常困難,在現實世界中,情況比訓練 AI 模型的環境復雜得多且不可預測。

最近,DeepMind 人工智能研究實驗室的科學家根據一篇新的“開放式學習”倡議的博客文章中,聲稱已經采取了“初步來訓練一個能夠在不需要人類交互數據的情況下,玩許多不同游戲的代理”。他們的新項目包括一個具有真實動態的 3D 環境和可以學習解決各種挑戰的深度強化學習代理。

根據 DeepMind 的人工智能研究人員的說法,新系統是“創建更通用的代理邁出的重要一步,該代理具有在不斷變化的環境中快速適應的靈活性。”

該論文的發現表明,在將強化學習應用于復雜問題方面取得了一些令人印象深刻的進步。但它們也提醒人們,當前的系統距離實現人工智能社區幾十年來直夢寐以求的通用智能能力還有多遠。

深度強化學習的脆弱性

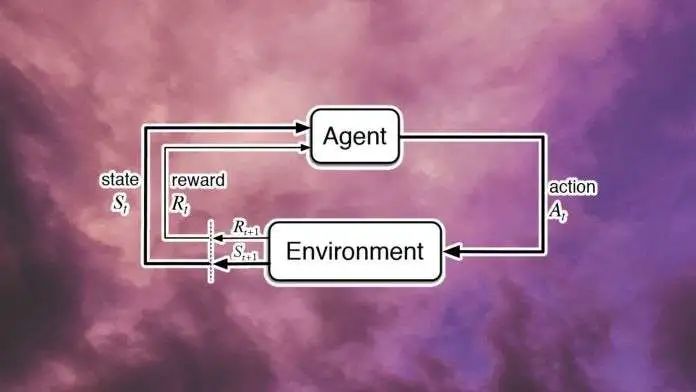

強化學習的主要優勢在于可以在執行動作和獲得反饋來發展行為的能力,類似于人類和動物通過與環境互動來學習的方式類似。一些科學家將強化學習描述為“首個智能計算理論”。

強化學習和深度神經網絡的結合,稱為深度強化學習,是包括 DeepMind 著名的 AlphaGo 和 AlphaStar 模型在內的許多強化 AI 的核心。在這兩種情況下,人工智能系統都能夠在各自的比賽中擊敗人類世界冠軍。

但強化學習系統的靈活性不足也是眾所周知的缺陷。例如,可以在專家級別玩星際爭霸 2 的強化學習模型將無法在任何能力級別玩具有類似機制的游戲(例如,魔獸爭霸 3)。即使對原始游戲稍有改動,也會大大降低 AI 模型的性能。

“這些智能體通常被限制只能玩他們接受過訓練的游戲,雖然游戲的布局、初始條件、對手可能會變化,智能體必須滿足的目標在訓練和測試之間保持不變。偏離這一點可能會導致代理的災難性失敗,”DeepMind 的研究人員在一篇論文中寫道,該論文提供了有關其開放式學習的全部細節。另一方面,人類非常擅長跨領域轉移知識。

XLand 環境

DeepMind 新項目的目標是創建“一個人工智能,其行為的概括超出了它所訓練的游戲集。”

DeepMind 新項目的目標是創建“一個人工智能,其行為的概括超出了它所訓練的游戲集。”

為此,該團隊創建了 XLand,這是一個可以生成由靜態拓撲和可移動對象組成的 3D 環境的引擎。游戲引擎模擬了剛體物理學,并允許玩家以各種方式使用對象(例如,創建斜坡、塊路徑等)。

XLand 是一個豐富的環境,可以在其中訓練代理執行幾乎無限數量的任務。XLand 的主要優勢之一是能夠使用程序化規則自動生成大量環境和挑戰來訓練 AI 代理。這解決了機器學習系統的主要挑戰之一,該系統通常需要大量手動策劃的訓練數據。

根據博客文章,研究人員“在 XLand 中創建了數十億個任務,跨越不同的游戲、世界和玩家。”這些游戲包括非常簡單的目標,例如在更復雜的設置中尋找對象,其中 AI 代理會權衡不同獎勵的收益和權衡。一些游戲包括涉及多個代理的合作或競爭元素。

深度強化學習

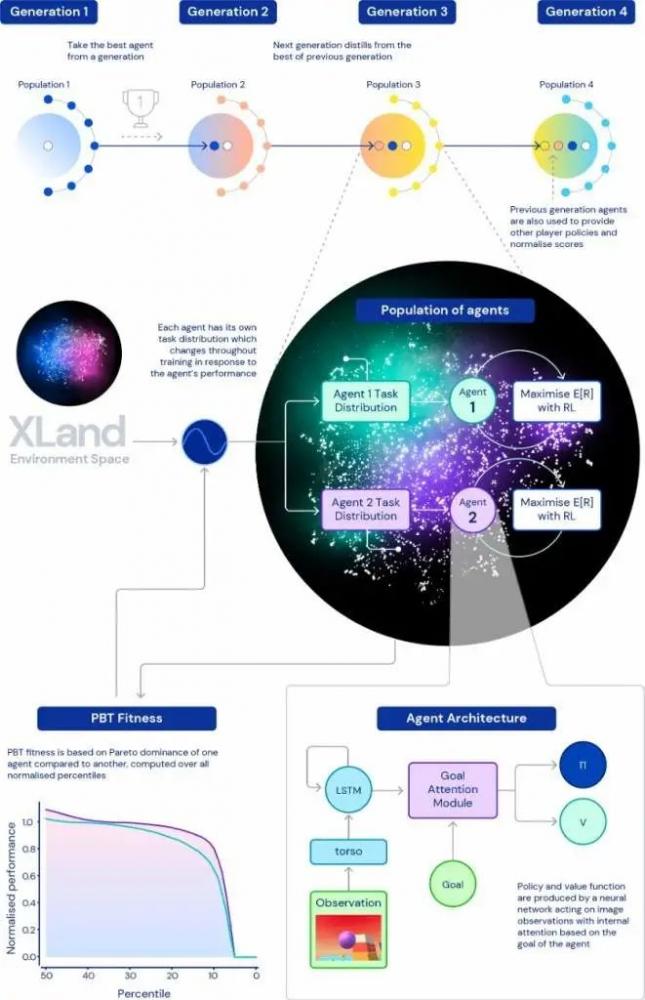

DeepMind 使用深度強化學習和一些聰明的技巧來創建可以在 XLand 環境中茁壯成長的 AI 代理。

每個代理的強化學習模型接收世界的第一人稱視角、代理的物理狀態(例如,是否持有對象)及其當前目標。每個代理微調其策略神經網絡的參數,以最大限度地提高當前任務的回報。神經網絡架構包含一個注意力機制,以確保代理可以平衡完成主要目標所需的子目標的優化。

一旦代理掌握了當前的挑戰,計算任務生成器就會為代理創建一個新的挑戰。每個新任務都是根據代理的訓練歷史生成的,并有助于在各種挑戰中分配代理的技能。

DeepMind 還使用其龐大的計算資源對大量代理進行并行培訓,并在不同的代理之間傳輸學習參數,以提高強化學習系統的一般能力。

DEEPMind使用多步驟和基于人群的機制來培訓許多強化學習代理

強化學習代理的性能是根據它們完成未經訓練的各種任務的一般能力來評估的。一些測試任務包括眾所周知的挑戰,例如“奪旗”和“捉迷藏”。

根據 DeepMind 的說法,每個代理在 XLand 的 4,000 個獨特世界中玩了大約 700,000 個獨特的游戲,并在 340 萬個獨特任務中經歷了 2000 億個訓練步驟(在論文中,研究人員寫道,1 億個步驟相當于大約 30 分鐘的訓練) .

AI 研究人員寫道:“此時,我們的代理已經能夠參與每一個程序生成的評估任務,除了少數甚至對人類來說都是不可能的。” “而且我們看到的結果清楚地展示了整個任務空間的一般零樣本行為。”

零樣本機器學習模型可以解決訓練數據集中不存在的問題。在 XLand 等復雜空間中,零樣本學習可能意味著代理已經獲得了有關其環境的基本知識,而不是記住特定任務和環境中的圖像幀序列。

當研究人員試圖為新任務調整它們時,強化學習代理進一步表現出廣義學習的跡象。根據他們的發現,對新任務進行 30 分鐘的微調,足以在使用新方法訓練的強化學習代理中產生令人印象深刻的改進。相比之下,在相同時間內從頭開始訓練的代理在大多數任務上的性能接近于零。

高級行為

根據 DeepMind 的說法,強化學習代理表現出“啟發式行為”的出現,例如工具使用、團隊合作和多步計劃。如果得到證實,這可能是一個重要的里程碑。深度學習系統經常因學習統計相關性而不是因果關系而受到批評。如果神經網絡能夠開發出高級概念,例如使用對象來創建斜坡或導致遮擋,它可能會對機器人和自動駕駛汽車等領域產生重大影響,而這些領域目前深度學習正在苦苦掙扎。

但這些都是重要的假設,DeepMind 的研究人員對就他們的發現得出結論持謹慎態度。他們在博文中寫道:“鑒于環境的性質,很難確定意圖——我們看到的行為經常看起來是偶然的,但我們仍然看到它們始終如一地發生。”

但是他們相信他們的強化學習代理“了解他們身體的基本知識和時間的流逝,并且他們了解他們遇到的游戲的高級結構。”

這種基本的自學技能是人工智能社區備受追捧的另一個目標。

智力理論

DeepMind 的一些頂尖科學家最近發表了一篇論文,其中他們假設單一獎勵和強化學習足以最終實現通用人工智能 (AGI)。科學家們認為,一個具有正確激勵機制的智能代理可以開發各種能力,例如感知和自然語言理解。

盡管 DeepMind 的新方法仍然需要在多個工程獎勵上訓練強化學習代理,但這符合他們通過強化學習實現 AGI 的一般觀點。

Pathmind 的首席執行官 Chris Nicholson 告訴 TechTalks:“DeepMind 在這篇論文中表明,單個 RL 代理可以開發智能以實現多個目標,而不僅僅是一個目標,” “它在完成一件事時學到的技能可以推廣到其他目標。這與人類智能的應用方式非常相似。例如,我們學習抓取和操縱物體,這是實現從敲錘子到鋪床的目標的基礎。”

Nicholson 還認為,該論文發現的其他方面暗示了通向智能的進展。“家長們會認識到,開放式探索正是他們的孩子學會在世界中穿行的方式。他們從柜子里拿出一些東西,然后把它放回去。他們發明了自己的小目標——這對成年人來說可能毫無意義——然后他們掌握了這些目標,”他說。“DeepMind 正在以編程方式為其代理在這個世界上設定目標,而這些代理正在學習如何一一掌握它們。”

Nicholson 說,強化學習代理也顯示出在他們自己的虛擬世界中開發具身智能的跡象,就像人類一樣。“這又一次表明,人們學習穿越和操縱的豐富而可塑的環境有利于通用智能的出現,智能的生物學和物理類比可以指導人工智能的進一步工作,”他說。

南加州大學計算機科學副教授 Sathyanaraya Raghavachary 對 DeepMind 論文中的主張持懷疑態度,尤其是關于本體感覺、時間意識以及對目標和環境的高級理解的結論。

“即使我們人類也沒有完全意識到我們的身體,更不用說那些 VR 代理了,” Raghavachary 在對 TechTalks 的評論中說,并補充說,對身體的感知需要一個集成的大腦,該大腦被共同設計以實現合適的身體意識和空間位置。“與時間的流逝一樣——這也需要一個對過去有記憶的大腦,以及與過去相關的時間感。他們(論文作者)的意思可能與代理跟蹤由他們的行為(例如,由于移動紫色金字塔)導致的環境中的漸進變化,底層物理模擬器將產生的狀態變化有關。

Raghavachary 還指出,如果代理能夠理解他們任務的高層結構,他們就不需要 2000 億步的模擬訓練來達到最佳結果。

“底層架構缺乏實現他們在結論中指出的這三件事(身體意識、時間流逝、理解高級任務結構)所需的東西,”他說。“總的來說,XLand 只是‘大同小異’。”

模擬與現實世界的差距

簡而言之,這篇論文證明,如果你能夠創建一個足夠復雜的環境,設計正確的強化學習架構,并讓你的模型獲得足夠的經驗(并且有很多錢可以花在計算資源上),你將能夠泛化到同一環境中的各種任務。這基本上就是自然進化賦予人類和動物智能的方式。

事實上,DeepMind 已經對 AlphaZero 做了類似的事情,AlphaZero 是一種強化學習模型,能夠掌握多個兩人回合制游戲。XLand 實驗通過添加零樣本學習元素將相同的概念擴展到更高的水平。

但是,雖然我認為 XLand 訓練的代理的經驗最終會轉移到現實世界的應用中,例如機器人和自動駕駛汽車,但我認為這不會是一個突破。您仍然需要做出妥協(例如創建人為限制以降低現實世界的復雜性)或創建人為增強(例如將先驗知識或額外傳感器注入機器學習模型)。

DeepMind 的強化學習代理可能已經成為虛擬 XLand 的主人。但是他們的模擬世界甚至沒有真實世界的一小部分復雜性。在很長一段時間內,這種差距仍將是一個挑戰。

參考鏈接:

https://bdtechtalks.com/2021/08/02/deepmind-xland-deep-reinforcement-learning/

*博客內容為網友個人發布,僅代表博主個人觀點,如有侵權請聯系工作人員刪除。

稱重傳感器相關文章:稱重傳感器原理