馬賽克變高清,谷歌將SR3、CDM相結合,推出超分辨率新方法

谷歌的研究者用兩種有關聯的方法提升了擴散模型的圖像合成質量。

自然圖像合成作為一類機器學習 (ML) 任務,具有廣泛的應用,也帶來了許多設計挑戰。例如圖像超分辨率,需要訓練模型將低分辨率圖像轉換為高分辨率圖像。從修復老照片到改進醫學成像系統,超分辨率有著非常重要的作用。

另一個圖像合成任務是類條件圖像生成,該任務訓練模型以從輸入類標簽生成樣本圖像。生成的樣本圖像可用于提高下游模型的圖像分類、分割等性能。

通常,這些圖像合成任務由深度生成模型執行,例如 GAN、VAE 和自回歸模型。然而,當經過訓練以在高分辨率數據集上合成高質量樣本時,這些生成模型都有其缺點。例如,GAN 經常遭受不穩定的訓練和模式崩潰,而自回歸模型通常會遭受合成速度緩慢的問題。

最初于 2015 年提出的擴散模型由于其訓練穩定性和對圖像的有希望的樣本質量結果,最近重新引起了人們的興趣 。因此,與其他類型的深度生成模型相比,它們提供了潛在的有利權衡。擴散模型通過逐漸添加高斯噪聲來破壞訓練數據,慢慢消除數據中的細節直到它變成純噪聲,然后訓練神經網絡來逆轉這種破壞過程。運行這個反向損壞過程通過逐漸去噪直到產生干凈的樣本來合成來自純噪聲的數據。該合成過程可以解釋為作為一種優化算法,它遵循數據密度的梯度以生成可能的樣本。

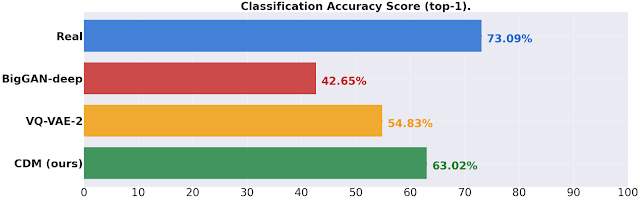

近日,來自谷歌的研究者提出了兩種有關聯的方法,它們推動了擴散模型的圖像合成質量的界限——通過重復細化的超分辨率(SR3,Super-Resolution via Repeated Refinements)和一個類條件合成模型,稱為級聯擴散模型(CDM)。研究者表明,通過擴大擴散模型和精心挑選的數據增強技術,新方法可以勝過現有的方法。具體來說,SR3 在人類評估中獲得了超過 GAN 的強大圖像超分辨率結果。CDM 生成的高保真 ImageNet 樣本在兩個 FID 得分上均超過 BigGAN-deep 和 VQ-VAE2。分類準確率得分大幅提升。

SR3:圖像超分辨率

SR3 是一種超分辨率擴散模型,它以低分辨率圖像作為輸入,并從純噪聲中構建相應的高分辨率圖像。該模型在圖像損壞過程中進行訓練,其中噪聲逐漸添加到高分辨率圖像中,直到只剩下純噪聲為止。然后它學習逆轉這個過程,從純噪聲開始,并通過輸入低分辨率圖像的引導逐步去除噪聲以達到目標分布。

通過大規模訓練,當擴展到輸入低分辨率圖像的 4 倍到 8 倍的分辨率時,SR3 在人臉和自然圖像的超分辨率任務上取得了強大的基準測試結果。這些超分辨率模型可以進一步級聯在一起以增加有效的超分辨率比例因子,例如,將 64x64 → 256x256 和 256x256 → 1024x1024 人臉超分辨率模型堆疊在一起,以執行 64x64 → 1024x1024 的超分辨率任務。

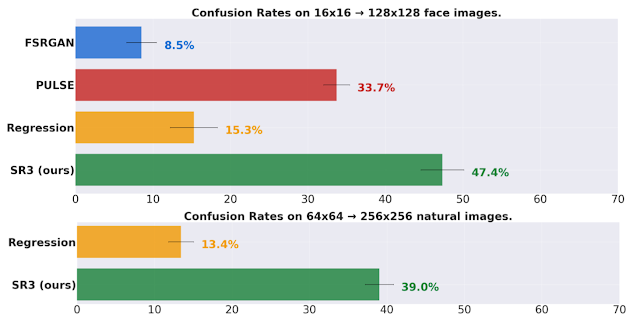

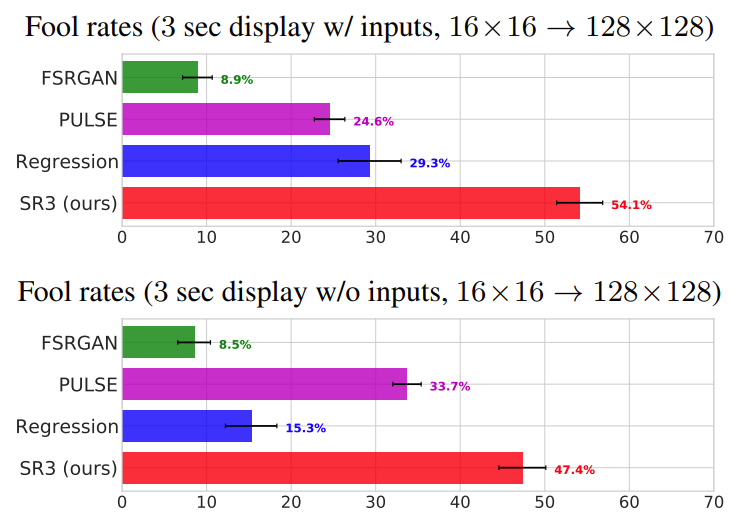

研究者將 SR3 與現有方法進行比較,并進行了一項雙重強制選擇實驗,要求受試者在參考高分辨率圖像和被問及以下問題時的模型輸出之間進行選擇:「你猜是相機拍的嗎?」該研究通過混淆率(confusion rate)來衡量模型的性能(評估者選擇模型輸出而不是參考圖像的時間百分比,其中完美的算法將實現 50% 的混淆率)。這項研究的結果如下圖所示。

上圖:該研究在 16x16 → 128x128 人臉的任務上實現了接近 50% 的混淆率,優于 SOTA 人臉超分辨率方法 PULSE 和 FSRGAN。下圖:該方法還在 64x64 → 256x256 自然圖像這一更困難的任務上實現了 40% 的混淆率,大大優于回歸基線。

實驗結果

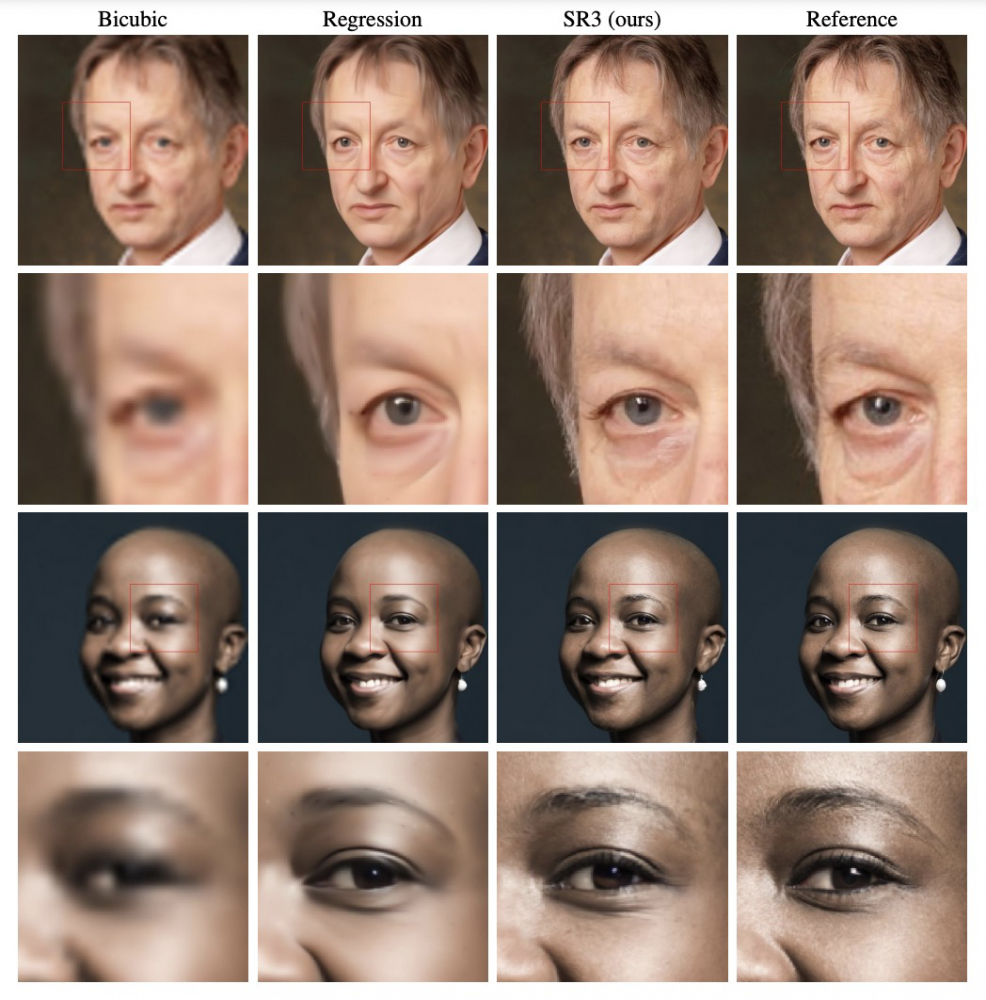

自然圖像:圖 3 給出了 ImageNet 開發集上 64×64 → 256×256 的超分辨率自然圖像示例,以及用于更精細檢查的放大 patch。基線回歸模型生成的圖像忠實于輸入,但模糊且缺乏細節。相比之下,SR3 產生的圖像清晰,細節更豐富。

圖 3:SR3 模型(64×64 → 256×256)的結果,模型在 ImageNet 上訓練并在兩個 ImageNet 測試圖像上進行評估。

人臉圖像:圖 4 顯示了兩個測試圖像上的人臉超分辨率模型(64×64 → 512×512)的輸出,并放大了選定 patch。使用 8 倍的放大因子可以清楚地看到推斷的詳細結構。注意由于放大因子很大,因此有很多似是而非的輸出,因此我們不期望輸出與參考圖像完全匹配。

圖 4:SR3 模型(64×64 → 512×512)的結果,在 FFHQ 上訓練并應用于訓練集之外的圖像,以及放大的 patch 以顯示更精細的細節。

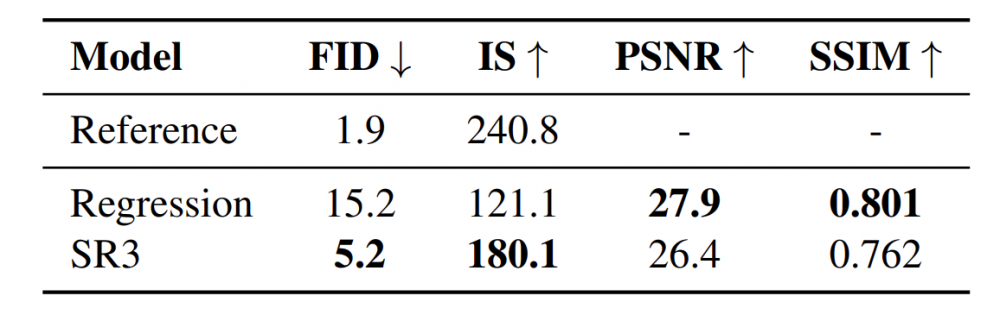

表 1 顯示了 16×16 → 128×128 人臉超分辨率的 PSNR、SSIM [59] 和 Consistency 分數。SR3 在 PSNR 和 SSIM 上的表現優于 PULSE 和 FSRGAN,而在回歸基準上的表現則遜色。先前的工作 [7, 8, 28] 觀察到,當輸入分辨率低且放大因子大時,這些傳統的自動評估措施與人類感知的相關性不佳。這并不奇怪,因為這些指標往往會懲罰與目標圖像不完全對齊的任何合成高頻細節。

表 1:16×16 → 128×128 人臉超分辨率下的 PSNR 和 SSIM。

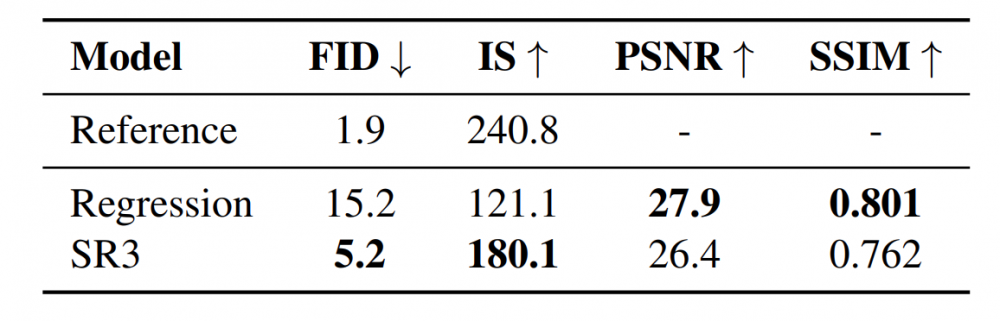

由于生成完美對齊的高頻細節,例如,圖 4 中完全相同的發束和圖 3 中相同的豹斑,幾乎是不可能的,因此 PSNR 和 SSIM 往往基于 MSE 回歸的技術,這些技術對高頻保守細節。對于 ImageNet 超分辨率 (64×64 → 256×256),表 2 進一步證實了這一點,其中 SR3 的輸出實現了更高的樣本質量分數(FID 和 IS),但 PSNR 和 SSIM 比回歸差。

表 2:使用在 ImageNet 驗證集上計算的標準指標,SR3 和回歸基線在自然圖像超分辨率上的性能比較。

受試者(subject) fool rate 是受試者選擇模型輸出而不是真實情況的試驗比例。每個模型的 fool rate 有 50 名受試者,每個人都看到了測試集中 100 張圖像中的 50 張。圖 6 顯示了 Task-1(頂部)和 Task-2(底部)的 fool rate。在這兩個實驗中,SR3 的 fool rate 接近 50%,表明 SR3 生成的圖像既逼真又忠實于低分辨率輸入。

圖 6:人臉超分辨率人類 fool rates(越高越好,照片逼真的樣本產生 50% 的 fool rate)。將 4 個模型的輸出與真實情況進行比較。(頂部)對象顯示為低分辨率輸入, (底部)未顯示輸入。

CDM:類條件 ImageNet 生成

上面展示了 SR3 在生成超分辨率自然圖像的有效性,更近一步的,研究者使用 SR3 模型來生成類條件圖像。CDM 是在 ImageNet 數據集上訓練的類條件擴散模型,用于生成高分辨率的自然圖像。由于 ImageNet 是一個難度較高、熵較高的數據集,因此研究者將 CDM 構建為多個擴散模型的級聯。

這種級聯方法涉及在多個空間分辨率上級聯多個生成模型:一個擴散模型以低分辨率生成數據,然后是一系列 SR3 超分辨率擴散模型,這種級聯模型將生成圖像的分辨率提高到最高分辨率。眾所周知,級聯可以提高高分辨率數據的質量和訓練速度。正如定量評估結果所證明的那樣,CDM 進一步突出了擴散模型中級聯對樣本質量和下游任務(例如圖像分類)有效性。

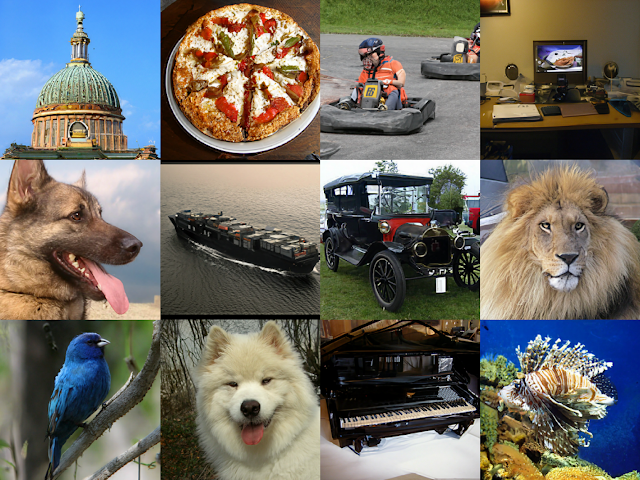

一系列擴散模型的級聯 pipeline 示例:第一個是生成低分辨率圖像,其余圖片是執行上采樣到最終高分辨率圖像。這里 pipeline 用于類條件 ImageNet 生成,它從 32x32 分辨率的類條件擴散模型開始,然后是使用 SR3 生成分辨率是原始分辨率 2 倍和 4 倍的類條件超分辨率圖像。

上圖為 256x256 級聯類條件 ImageNet 模型中選擇生成的圖像。

除了在級聯 pipeline 中包含 SR3 模型外,該研究還引入了一種新的數據增強技術:條件增強,它進一步提高了 CDM 生成的樣本質量。雖然 CDM 中的超分辨率模型是在原始圖像上訓練的,但在生成階段,需要對低分辨率基礎模型生成的圖像進行超分辨率處理。這導致超分辨率模型「訓練 - 測試」不匹配。

條件增強是指對級聯 pipeline 中每個超分辨率模型的低分辨率輸入圖像進行數據增強。這些數據增強包括高斯噪聲和高斯模糊,以防止每個超分辨率模型對其低分辨率條件輸入過擬合,最終得到更好的高分辨率 CDM 樣本質量。

實驗結果

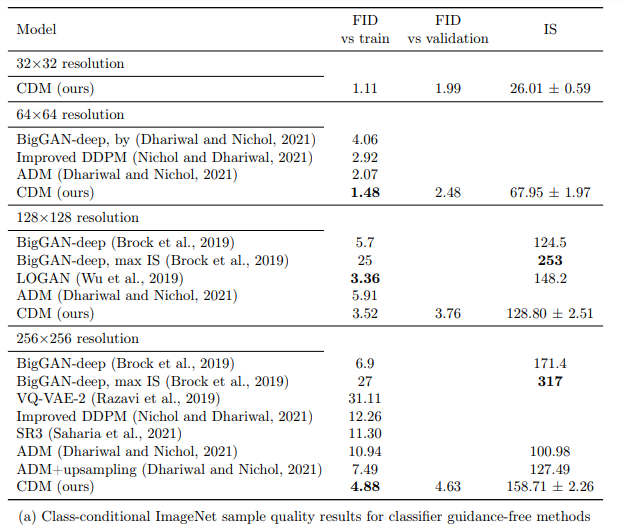

下表為級聯擴散模型 (CDM) 的主要結果,主要針對 64×64、 128×128、256×256 ImageNet 數據集分辨率以及基線的結果。

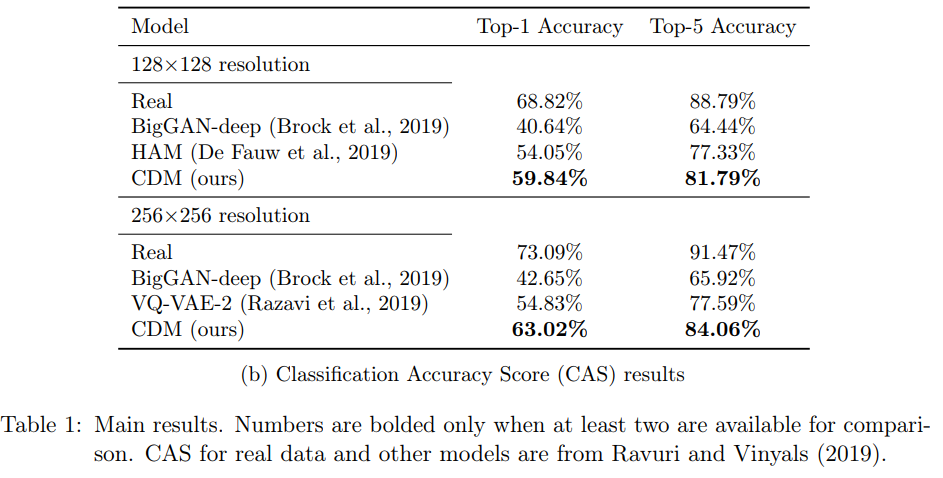

下表為在 128×128 、256×256 分辨率下,模型分類準確率得分(Classification Accuracy Score,CAS)結果:

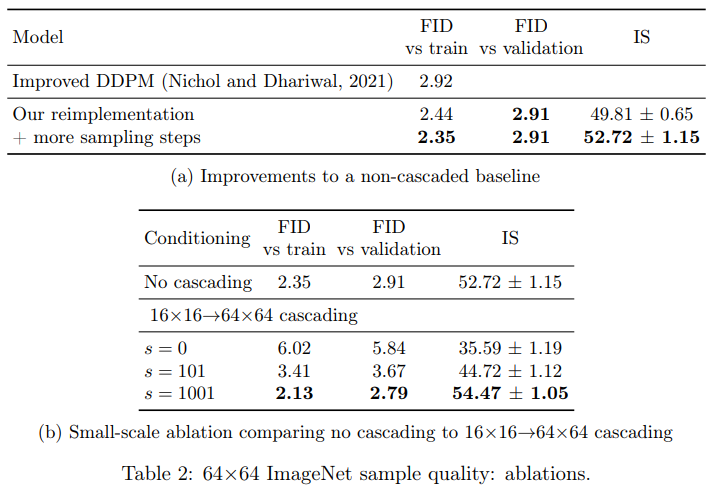

表 2b 和圖 7 為 16×16→64×64 級聯 pipeline 結果。結果發現如果沒有條件增強,級聯 pipeline 獲得的樣本質量低于非級聯基線 64×64 模型,以 FID 得分為例,得分從 2.35 增加到 6.02。

圖 7:消融實驗,小規模 16×16→64×64pipeline 在不同數量的條件增強下生成的圖形。如表 2b 所示。

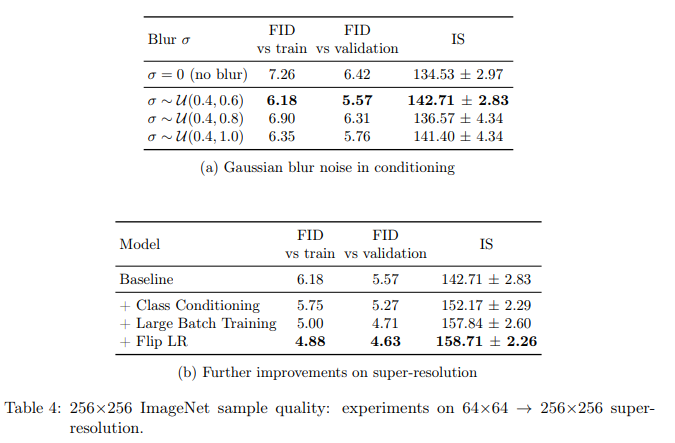

表 4a 為 64×64→256×256 超分辨率模型應用高斯模糊增強的結果。表 4b 顯示了超分辨率模型在類條件、大批量訓練和隨機翻轉增強方面的進一步改進。

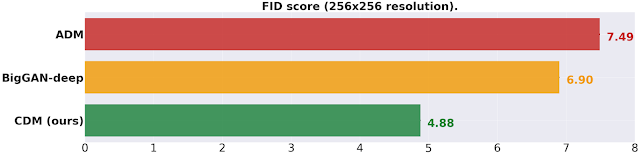

總之,CDM 生成的高保真樣本在類條件 ImageNet 生成的 FID 得分和分類準確率得分方面均優于 BigGAN-deep 和 VQ-VAE-2。CDM 是一種純生成模型,與 ADM 和 VQ-VAE-2 等其他模型不同,它不使用分類器來提高樣本質量。

對于不使用額外分類器來提高樣本質量的方法,類條件 ImageNet 在 256x256 分辨率下的 FID 得分結果(值越低越好)。

ImageNet 在 256x256 分辨率下的分類準確率得分,與現有方法相比,CDM 生成的數據獲得了顯著的增益,縮小了真實數據和生成數據之間的分類準確率差距(值越高越好)。

*博客內容為網友個人發布,僅代表博主個人觀點,如有侵權請聯系工作人員刪除。