把黑人小伙識別為“靈長類”,Facebook為闖禍算法道歉

英國《每日郵報》 6 月 27 日發布的一段視頻最近在Facebook忽然火了起來,但其引發關注的原因并不是因為視頻本身,而是因為它被打上的“標簽":這是一段關于一位黑人的視頻,但所有觀看該視頻的用戶都會收到一條提示,詢問他們是否想“繼續觀看有關靈長類動物的視頻”。

前 Facebook 內容設計經理 Darci Groves 在推特發布了這一發現,并且很快引發眾怒。

之后,Facebook很快下線了這一推薦,并且公開道歉。

“這顯然是一個不可接受的錯誤,我們在意識到發生這種情況后立即禁用了整個主題推薦功能,這樣我們可以調查原因并防止這種情況再次發生,”Facebook 發言人 Dani Lever 在給《今日美國》的一份聲明中說。

“正如我們所說,雖然我們對人工智能進行了改進,但我們知道它并不完美,我們還有很多的進步空間,”她說。“我們向任何可能看到這些冒犯性內容的人道歉。”

爭論:人類不是靈長類嗎?

不過,事情發生后,也有人在相關社區表示,不必太過敏感,畢竟人類都是靈長類動物的一種,ai的判定也沒有問題。

也有黑人程序員兄弟在社區表示,不要太過敏感,“我個人同意承認黑人的膚色在視覺上與某些非人類靈長類動物的圖像更相似,并且可以理解為什么這個問題不是程序員的偏見,而是一個復雜的計算機視覺問題,計算機很容易發現相似之處,但要訓練一個神經網絡了解為什么圖像彼此相似但不相關,就非常困難了。”

而反對者則認為,AI只會反饋它學習的數據,出現這樣的標注結果,也反映出facebook整體標注系統的大問題,而據Facebook自己的說法,其人工智能是使用用戶上傳的圖像進行訓練的。

畢竟,這也不是Facebook的ai系統第一次出這種”種族主義“的問題。”

Facebook并非唯一,科技公司坎坷的“種族主義”難題

近些年,Facebook 在為算法“去種族偏見”的問題上付出了不少代價,過程頗為坎坷。早在2018年,該公司就曾被曝出丑聞,允許廣告商在如住房和就業等行業做廣告時排除某些少數群體。Facebook當時也同樣使用“技術性”這一口徑來回避相關問題,例如并不是按種族而是按所謂的“多元文化”對用戶進行分類。

因此,Facebook在種族問題上一直持有比較謹慎的態度,也為此付出了很多努力。去年7月,The Verge報道稱,Facebook 正在組建新的內部團隊,致力于研究其主要社交網絡和 Instagram 的種族偏見,特別是其使用人工智能訓練的算法是否會對黑人、西班牙裔和其他少數族群產生不利影響。Facebook 發言人當時告訴The Verge,該團隊將“負責確保公平和公平的產品開發存在于我們所做的一切中” 。“我們將繼續與 Facebook 的負責任的人工智能團隊密切合作,以確保我們正在關注我們各自平臺上的潛在偏見。”

不過,從現在的結果來看,Facebook引以為豪的這一整改影響非常有限。

當然,Facebook不是唯一一家因自動化系統中的種族偏見而受到抨擊的科技公司。

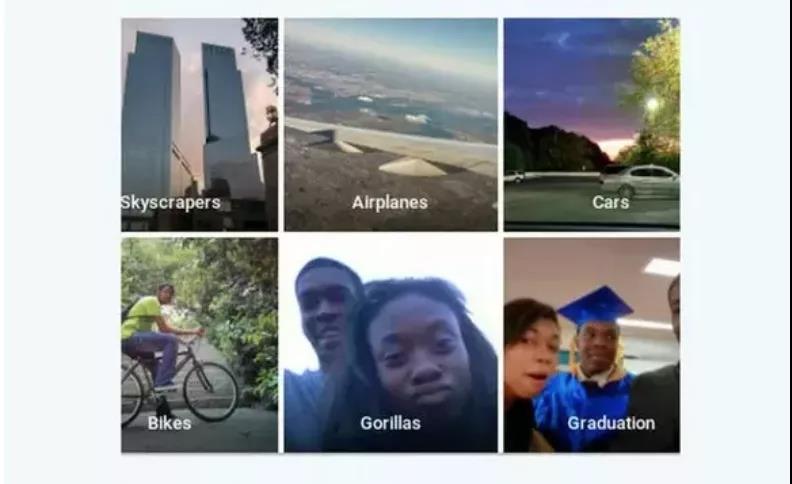

2015 年,谷歌的應用程序錯誤地將黑人識別為“大猩猩”,并且為此道歉。不過兩年后,有媒體發現谷歌的解決方案非常簡單粗暴,直接從搜索結果中刪除了相關標簽,也就是說,禁止將任何圖片標記為大猩猩、黑猩猩或猴子。

谷歌這種“寧可錯殺一千,不肯放過一個”的做法或許殘暴,但也從某種程度上說明了圖片分類這一看似簡單的能力仍然存在比較大的問題。對于實現真正的人工智能,我們任重而道遠。

相關報道:

https://www.theverge.com/2021/9/4/22657026/facebook-mislabeling-video-black-men-primates-algorithm

https://www.nytimes.com/2021/09/03/technology/facebook-ai-race-primates.html

https://www.usatoday.com/story/tech/2021/09/03/facebook-video-black-men-primates-apology/5721948001/

https://www.wired.com/story/when-it-comes-to-gorillas-google-photos-remains-blind/

*博客內容為網友個人發布,僅代表博主個人觀點,如有侵權請聯系工作人員刪除。

路由器相關文章:路由器工作原理

路由器相關文章:路由器工作原理