突破!阿里達摩院刷新VQA紀錄,AI再次超越人類

近年來,在深度學習和大數據的支撐下,自然語言處理技術迅猛發展。而預訓練語言模型把自然語言處理帶入了一個新的階段,得到了工業界的廣泛關注。隨著技術的發展,阿里巴巴達摩院在通用語言的基礎上,已拓展到多語言、生成式、多模態、結構化、知識驅動等領域,不僅節省了大量的時間成本,還提高了效率。

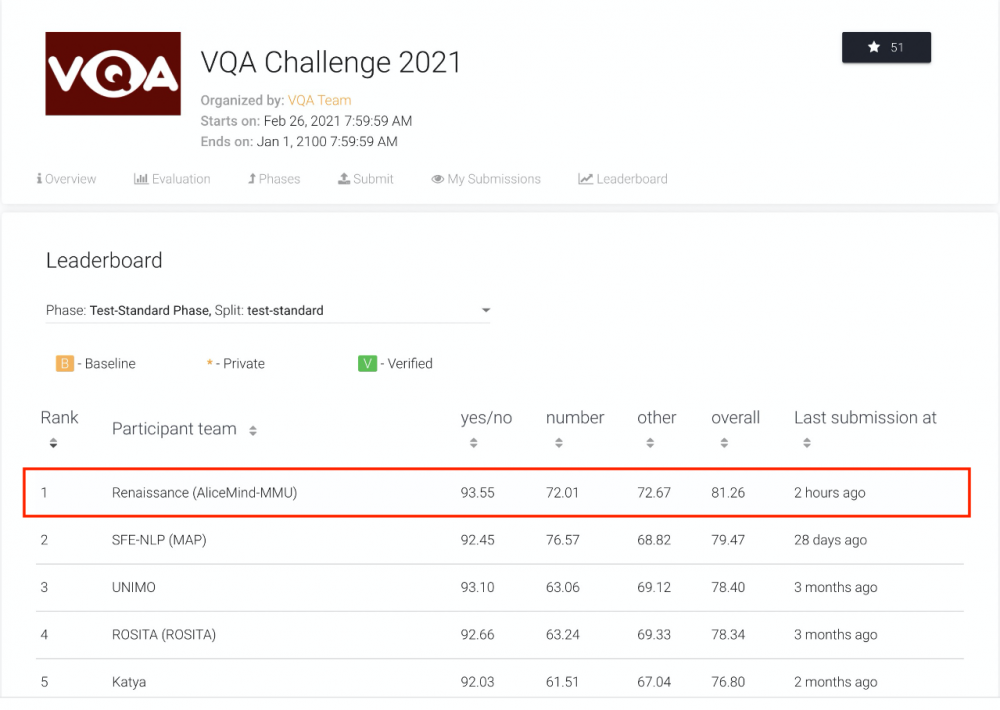

8月12日,國際權威機器視覺問答榜單 VQA Leaderboard 出現了關鍵突破:阿里巴巴達摩院以81.26%的準確率創造了新紀錄,讓 AI 在“詩圖會意”上首次超越人類基準。這是繼2015年、2018年 AI 分別在視覺識別及文本理解領域超越人類后,人工智能在多模態技術領域也迎來一大進展。

(達摩院AliceMind在VQA Leaderboard上創造首次超越人類的紀錄)

VQA是什么?

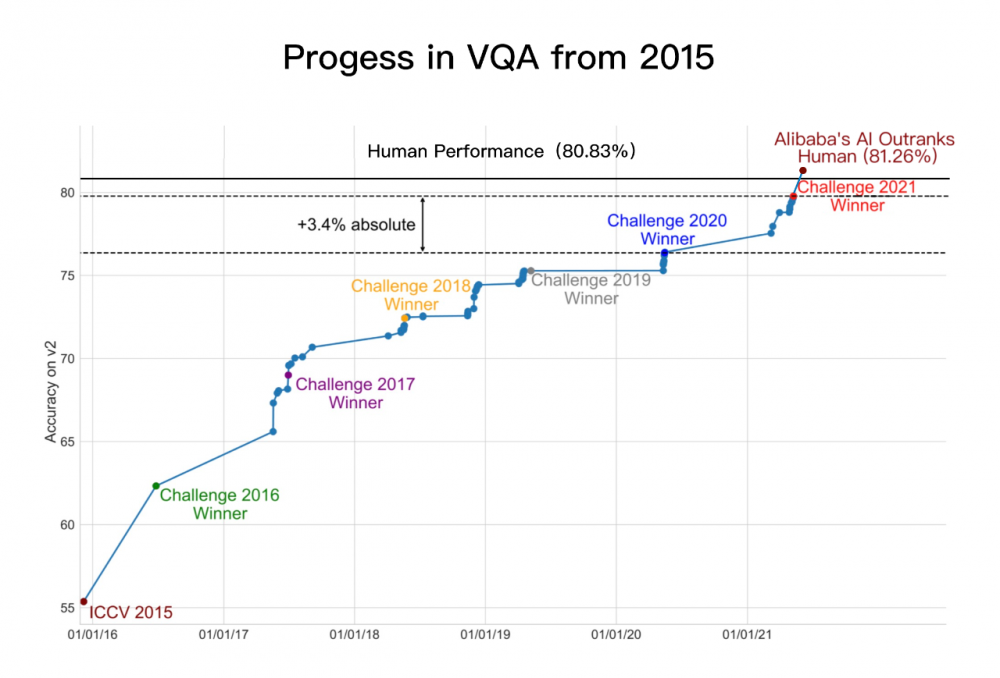

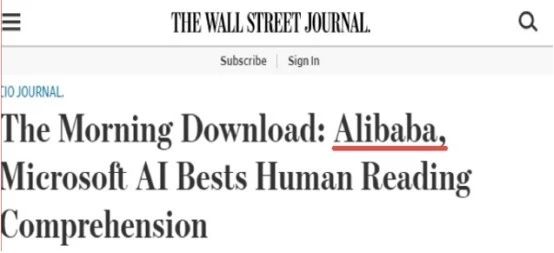

近10年來,AI技術保持高速發展,AI在下棋、視覺、文本理解等單模態技能上突飛猛進,比如在視覺理解領域,以CNN為代表的卷積累模型2015年在ImageNet視覺分類任務上超越了人類成績;在文本理解領域,2018年微軟與阿里幾乎同時在斯坦福SQuAD挑戰賽上讓AI閱讀理解超越了人類基準。

然而,在視覺問答VQA(Visual Question Answering)這一涉及視覺-文本跨模態理解的高階認知任務上,AI過去始終未能達到人類水平的突破。

隨著深度學習、視覺理解、文本理解等領域高速發展,自然語言處理技術與計算機視覺交融逐漸成為多模態領域重要的前沿研究方向。其中,VQA是多模態領域挑戰極高的核心任務,解決VQA挑戰,對研發通用人工智能具有重要意義。

為鼓勵攻克這一難題,全球計算機視覺頂會CVPR從2015年起連續6年舉辦VQA挑戰賽,吸引了包括微軟、Facebook、斯坦福大學、阿里巴巴、百度等眾多頂尖機構踴躍參與,形成了國際上規模最大、認可度最高的VQA數據集,其中包含超20萬張真實照片、110萬道考題。

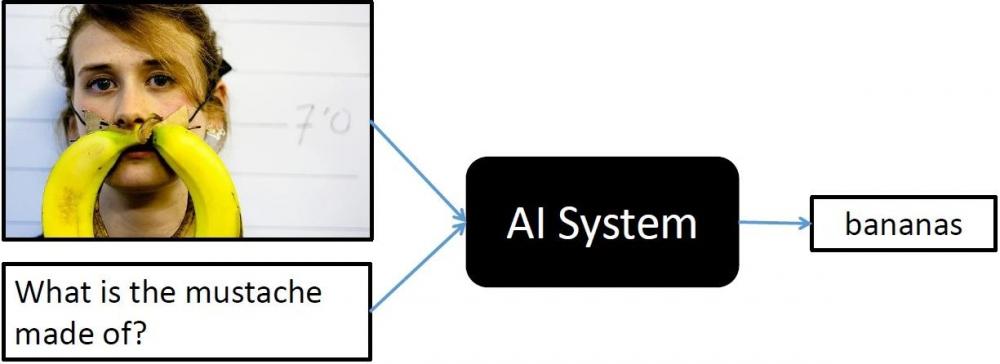

VQA是 AI 領域難度最高的挑戰之一。在測試中,AI需根據給定圖片及自然語言問題生成正確的自然語言回答。這意味著單個AI模型需融合復雜的計算機視覺及自然語言技術:首先對所有圖像信息進行掃描,再結合對文本問題的理解,利用多模態技術學習圖文的關聯性、精準定位相關圖像信息,最后根據常識及推理回答系列問題。

今年6月,阿里達摩院在VQA 2021 Challenge的55支提交隊伍中奪冠,成績領先第二名約1個百分點、去年冠軍3.4個百分點。兩個月后,達摩院再次以81.26%的準確率創造VQA Leaderboard全球紀錄,首次超越人類基準線80.83%。

這一結果意味著,AI在封閉數據集內的VQA表現已媲美人類。

面對更開放的現實世界,AI一定會遇到新的挑戰,需要喂更多的數據、進一步提升模型。但和CV等領域的發展一樣,這一結果依然具有標志性意義,相信VQA技術在現實中的表現提升只是時間問題。

(VQA技術自2015年的進展)

VQA“學霸”如何煉成?

VQA挑戰的核心難點在于,需在單模態精準理解的基礎上,整合多模態的信息進行聯合推理認知,最終實現跨模態理解,即在統一模型里做不同模態的語義映射和對齊。

據了解,為了解決VQA挑戰,基于阿里云PAI 平臺及EFLOPS框架的工程底座,達摩院語言技術實驗室及視覺實驗室對AI視覺-文本推理體系進行了系統性的設計,融合了大量算法創新,包括:

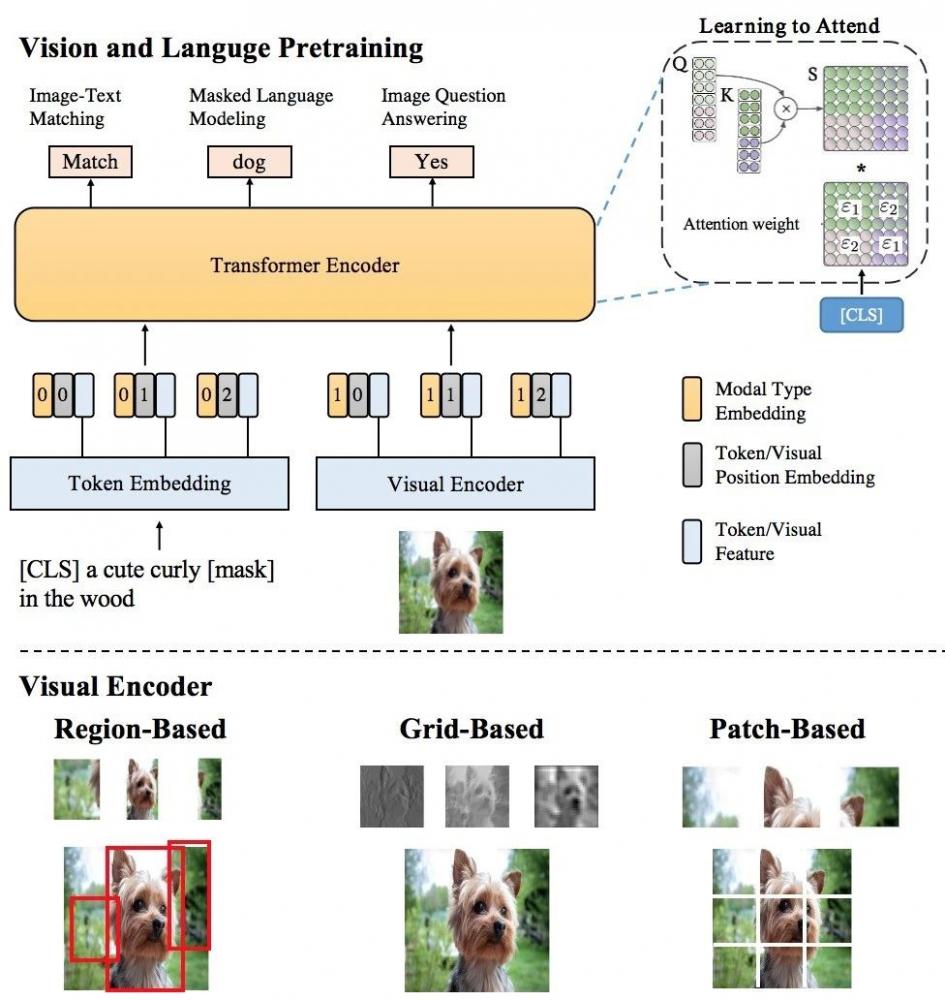

(1)多樣性的視覺特征表示,從各方面刻畫圖片的局部和全局語義信息,同時使用Region,Grid,Patch等視覺特征表示,以更精準地進行單模態理解;

(2)基于海量圖文數據和多粒度視覺特征的多模態預訓練,用于更好地進行多模態信息融合和語義映射,創新性地提出了SemVLP,Grid-VLP,E2E-VLP和Fusion-VLP等預訓練模型;

(3)研發自適應的跨模態語義融合和對齊技術,創新性地在多模態預訓練模型中加入Learning to Attend機制來進行跨模態信息地高效深度融合;

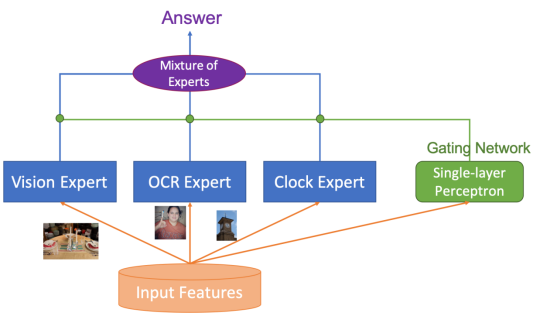

(4)采用Mixture ofExperts (MOE)技術進行知識驅動的多技能AI集成。

其中自研的多模態預訓練模型E2E-VLP,StructuralLM已被國際頂級會議ACL2021接受。

模型大圖如下:

這不是達摩院第一次在AI關鍵領域超越人類。

早在2018年,作為業界最早投入預訓練語言模型研究的機構之一,達摩院前身IDST曾在斯坦福SQuAD挑戰賽中歷史性地讓機器閱讀理解首次超越人類,轟動全球。

今年以來,達摩院在AI底層技術領域動作頻頻。

從3月起,達摩院先后發布了中國科技公司中首個超大規模多模態預訓練模型M6及首個超大規模中文語言模型PLUG,并開源了歷經3年打造的深度語言模型體系 AliceMind(https://github.com/alibaba/AliceMind),其曾登頂 GLUE等六大國際權威NLP榜單。

VQA考高分有什么用?

達摩院語言技術實驗室負責人司羅認為,“人工智能分為計算智能、感知智能、認知智能、創造智能四個層次。”

本次,AI在視覺—文本跨模態理解及推理上媲美人類的水平,意味著AI向認知智能邁進了關鍵一步。

據了解,VQA技術擁有廣闊的應用場景,可用于圖文閱讀、跨模態搜索、盲人視覺問答、醫療問診、智能駕駛、虛擬主播等領域,或將變革人機交互方式。目前,VQA技術已在阿里內部廣泛應用于商品圖文理解、智能客服等場景。

在阿里平臺上,達摩院VQA能力已實現大范圍工業應用落地,典型VQA應用包括:

(1)商品圖文信息理解:數萬家淘寶天貓商家開通使用店小蜜客服VQA視覺問答功能,AI幫助提升了提問解決率,優化了買家體驗,降低了商家配置工作量。盒馬、考拉的客服場景,閑魚的圖文同款匹配場景也接入了VQA能力。

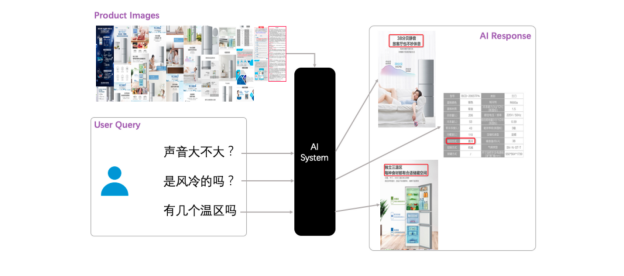

淘寶店小蜜VQA能力詳解:

a)商家精心制作的商品詳情海報內,蘊含著大量有價值的商品信息。

b)消費者對商品進行提問時,AI客服可通過理解、檢索商品海報進行回答,如裁切一張小圖作為答案,一方面為消費者帶來了更好的交互體驗,另一方面為賣家節省了大量配置成本。

VQA不僅可以回答事實類問題,還可以回答非事實類、主觀類問題。

(2)直播視頻交互:VQA技術被應用于智能直播間等多模態人機交互場景中,幫助解決直播中多模態劇本構建、多模態語義問答等問題。

(3)多模態搜索:基于創新性的多模態預訓練方法,達摩院為AliExpress訓練了電商多模態通用模型,應用于搜索query相關性排序等需要圖文理解的場景,有效提升了搜索相關性。

據悉,VQA技術在電商領域成熟運用后,阿里計劃將其推廣至醫療問診等更廣泛的社會應用領域。

VQA考卷有多難?

對單一AI模型來說,VQA考卷難度堪稱“變態”。

要拿到漂亮的分數,AI不僅要修煉好圖像識別、文本識別、文本理解等基本功,還要解鎖計數、讀鐘表、推理認知等附加技能,此外還必須擁有百科全書的豐富常識。

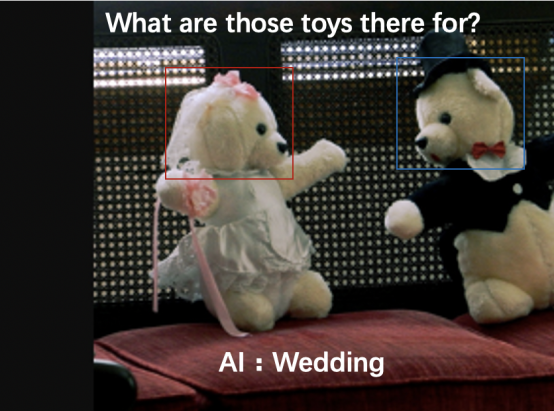

比如,在下面這道VQA考題中,根據有禮服裝飾的小熊玩具照片+圖片“這些玩具用來做什么的?”AI需要成功推理出一個可能的答案“婚禮”。

6年前,這些問題對AI來說難度極高。經過多年的技術積累,達摩院AliceMind在VQA測試中拿到了超81分的成績,基本達到普通人看圖問答的水準。

相信AI未來將給人類帶來更多驚喜。

論文鏈接:

1. E2E-VLP: End-to-EndVision-Language Pre-training Enhanced by Visual Learning, ACL2021

2. A Structural Pre-trained Modelfor Table and Form Understanding, ACL 2021

3. SemVLP: Vision-LanguagePre-training by Aligning Semantics at Multiple Levels

*博客內容為網友個人發布,僅代表博主個人觀點,如有侵權請聯系工作人員刪除。