替代離線RL?Transformer進軍決策領域,「序列建模」成關鍵

Transformer 開始進軍決策領域了,它能否替代離線強化學習呢?近日,UC 伯克利、FAIR 和谷歌大腦的研究者提出了一種通過序列建模進行強化學習的 Transformer 架構,并在 Atari、OpenAI Gym 等強化學習實驗平臺上媲美甚至超越 SOTA 離線 RL 基線方法。

自 2016 年 AlphaGo 擊敗李世石開始,強化學習(Reinforcement Learning)在優化決策領域可謂是風頭無兩。同年,基于強化學習算法的 AlphaGo 升級版 AlphaGo Zero 更是采用「從零開始」、「無師自通」的學習模式,以 100:0 的比分輕而易舉打敗了之前的 AlphaGo。

與此同時,BERT、GPT 等語言模型在 NLP 領域掀起狂潮。去年 DETR 和 ViT 出來之后,Transformer 在計算機視覺領域也是大殺四方。而多虧了深度學習,我們今天能做的比幾年前要多出許多。處理序列數據的能力,如音樂歌詞、句子翻譯、理解評論或構建聊天機器人,所有這些都要歸功于序列建模(Sequential Modeling)。

那么能否結合強化學習與序列建模,并構建優化決策的 Transformer 架構呢?

近日,UC 伯克利、FAIR 和谷歌大腦的研究者發布了一篇論文,就此問題展開了研究并提出了 Decision Transformer——一種通過序列建模進行強化學習的架構。

首先,為了使用 Transformer 架構的簡單性和可擴展性,以及 GPT-x 和 BERT 等語言建模的優勢,研究者引入了一個框架,將強化學習抽象為序列建模問題。然后將強化學習問題轉化為條件序列建模的架構,提出了 Decision Transformer。與先前擬合值函數或計算策略梯度的方法不同,Decision Transformer 通過利用因果掩蔽的 Transformer 來輸出最佳行動。

根據期望獎勵、過去的狀態和行動來調節自回歸模型,Decision Transformer 模型能夠生成實現期望回報的未來行動。盡管很簡單,Decision Transformer 在 Atari、OpenAI Gym 和 Key-to-Door 任務上達到甚至超過了最先進的無模型離線強化學習基線性能。

論文鏈接:https://arxiv.org/pdf/2106.01345.pdf

GitHub 鏈接:https://github.com/kzl/decision-transformer

當前,該研究已經引起業內極大的關注,官方代碼庫已經有 750 + 的 star 量。

作為序列建模問題的離線強化學習

研究者首先研究了如何通過在語言建模框架中提出順序決策問題來改變對強化學習的觀點。雖然強化學習中的傳統工作使用了依賴 Bellman 備份的特定框架,但用序列建模來作為替代對軌跡進行建模使其能夠使用強大且經過充分研究的架構(如 Transformer)來生成行為。

為了說明這一點,研究者研究了離線強化學習,從固定的數據集上訓練模型,只需最少的更改就能夠使用與語言建模框架相同的代碼來訓練強化學習策略。

為何選用 Transformer

最近的各項成果表明,Transformer 可以大規模地對語義概念的高維分布進行建模,包括語言中的有效零樣本泛化和分布外圖像生成。鑒于此類模型成功應用的多樣性,研究者想要驗證它們能否用于形式化為強化學習的序列決策問題。與以往使用 Transformer 作為傳統強化學習算法中組件的架構選擇相比,他們試圖研究生成軌跡建模,即對狀態、動作和獎勵的序列聯合分布進行建模,以替代傳統強化學習算法。

此外,研究者還考慮了以下范式轉變:使用序列建模目標,根據采集的經驗來訓練 Transformer 模型,而不是通過傳統的強化學習算法(如時序差分學習)來訓練策略。這將使研究者繞過對長期信用分配進行自舉的需要,從而避免已知會破壞強化學習穩定的「deadly triad」之一。它還避免了時序差分學習(temporal difference,TD)中可能會導致不受歡迎的短視行為,減少未來獎勵的需求。此外,利用在語言和視覺領域廣泛應用且易于擴展的 Transformer 框架,可以進行大量穩定的訓練。

除了長序列建模能力之外,Transformer 還具有其他優勢,比如可以通過自注意力(self-attention)直接執行信用分配。這與緩慢傳播獎勵并容易產生干擾信號的 Bellman 備份相反,可以使 Transformer 在獎勵稀少或分散注意力的情況下仍然有效地工作。Transformer 還可以對廣泛的行為分布進行建模,從而實現更好的泛化和轉移。

離線強化學習是從次優數據中學習策略來分配代理,即從固定、有限的經驗中產生最大有效的行為。由于錯誤傳播和價值高估,探索非常具有挑戰性。但是,在使用序列建模目標進行訓練時,這是一項自然的任務。通過在狀態、動作和返回序列上訓練自回歸模型,研究者將策略抽樣減少到自回歸生成建模,選擇作為生成的提示的返回 token 來指定策略的專業知識。

Decision Transformer:強化學習的自回歸序列建模

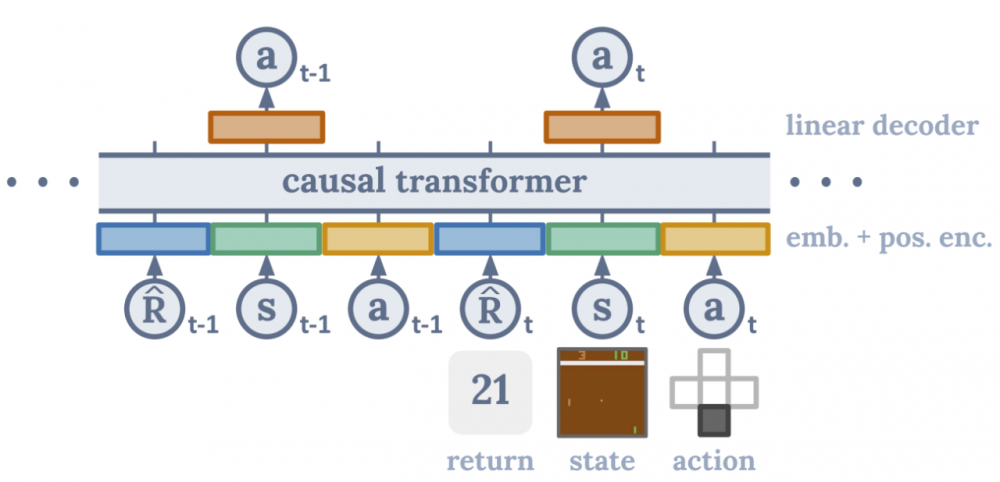

研究者采用了一種簡單的方法:每個模態(返回、狀態或動作)都被傳遞到一個嵌入網絡(圖像的卷積編碼器和連續狀態的線性層),然后嵌入通過自回歸 Transformer 模型處理,在給定先前 token 的情況下,使用線性輸出層進行訓練以預測下一個動作。

評估也很容易:通過期望的目標返回值(例如成功或失敗的 1 或 0)和環境中的起始狀態進行初始化,展開序列(類似于語言模型中的標準自回歸生成)以產生一系列要在環境中執行的動作。

Decision Transformer 架構。

拼接子序列以產生最佳軌跡

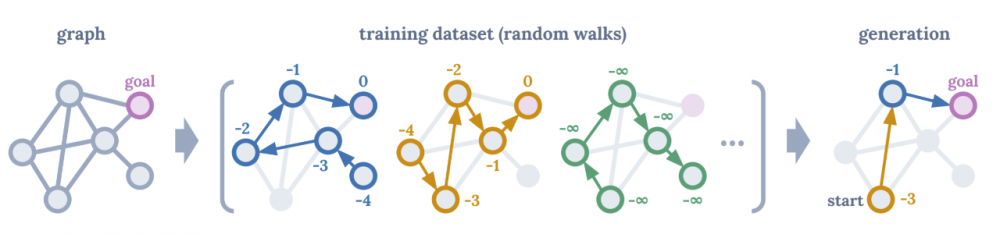

研究者考慮了固定圖上找到最短路徑的任務的強化學習問題(累積獎勵 = 邊權重之和)。在由隨機游走組成的訓練數據集中,他們觀察到了許多次優軌跡。如果在這些序列上訓練 Decision Transformer,可以要求模型通過調節高回報來生成最佳路徑。如果僅對隨機游走進行訓練,Decision Transformer 可以學習將來自不同訓練軌跡的子序列拼接在一起,以便在測試時產生最佳軌跡。

事實上,這與離線強化學習框架中常用的離策略 Q-learning 算法所期望的行為相同。然而,無需引入 TD 學習算法、價值悲觀主義或行為正則化,就可以使用序列建模框架實現相同的行為。

如下圖所示,圖左為強化學習為固定圖尋找最短路徑,圖中顯示由隨機游走軌跡和每個節點的返回組成的訓練數據集,圖右顯示了以起始狀態和每個節點產生的最大可能回報為條件,Decision Transformer 對最佳路徑進行了排序。

離線強化學習基準的比較

研究者擴展到了離線強化學習文獻中常用的基準,即 Atari 學習環境、OpenAI Gym、Minigrid Key-To-Door 任務。在離散和連續控制以及狀態和圖像觀察的多樣化任務中,他們發現 Decision Transformer 的性能可以媲美經過充分研究的專業 TD 學習算法的性能。

主要比較點是基于 TD 學習的無模型離線強化學習算法,因為 Decision Transformer 架構本質上也是無模型的。此外,TD 學習是強化學習中提高樣本效率的主要范式,并且作為一個子程序在許多基于模型的強化學習算法中也很突出。研究者還與行為克隆和變體進行了比較,因為這些也涉及了基于似然的策略學習公式。確切的算法取決于環境,但研究者的動機如下:

TD 學習:這些方法中的大多數使用動作空間約束或價值悲觀主義,并且將是與 Decision Transformer 最忠實的比較,代表標準的強化學習方法。最先進的無模型方法是 Conservative Q-Learning (CQL),它作為主要的比較方法。此外,研究者還與其他的無模型強化學習算法(如 BEAR 和 BRAC )進行了比較;

模仿學習:這種機制類似地使用監督損失進行訓練(而不是 Bellman 備份),并在這里使用行為克隆。

關于評估離散(Atari)和連續(OpenAI Gym)控制任務,前者涉及高維觀察空間,需要長期的信用分配,而后者需要細粒度的連續控制,代表不同的任務集。如下圖所示,主要結果總結了每個域的平均歸一化性能。

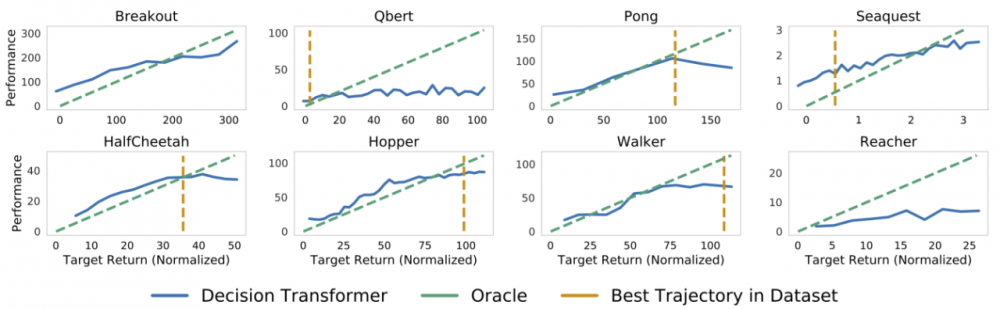

序列建模和多任務學習

此類型建模的一個效果是執行條件生成:通過輸入想要的回報來初始化一個軌跡。Decision Transformer 不產生單個策略,相反它模擬了廣泛的政策分布。如果繪制訓練后 Decision Transformer 的目標回報與平均獲得的回報之間的關系圖,就會發現可以合理地匹配目標,并且僅使用監督學習進行訓練。此外,在某些任務(例如 Qbert 和 Seaquest)上,研究者發現 Decision Transformer 實際上可以在數據集和模型策略之外進行推理,從而獲得更高的回報。

研究者通過在很大的范圍內改變所需的目標回報來評估 Decision Transformer 理解返回 token 的能力,即評估 Transformer 的多任務分布建模能力。下圖顯示了當以指定的目標(期望)回報為條件時,Decision Transformer 累積的平均采樣(評估)回報,上部為 Atari,底部為 D4RL 中重放數據集。在每項任務中,期望的目標回報和真實觀察到的回報是高度相關的。

在 Pong、HalfCheetah 和 Walker 等一些任務上,Decision Transformer 生成的軌跡幾乎完美匹配所需的回報(如圖中與 oracle 線重疊所示)。此外,在諸如 Seaquest 之類的一些 Atari 任務中,Decision Transformer 有時能夠進行外推。

*博客內容為網友個人發布,僅代表博主個人觀點,如有侵權請聯系工作人員刪除。

風力發電機相關文章:風力發電機原理