深度學習實現場景字符識別模型|代碼干貨

文字是人從日常交流中語音中演化出來,用來記錄信息的重要工具。文字對于人類意義非凡,以中國為例,中國地大物博,各個地方的口音都不統一,但是人們使用同一套書寫體系,使得即使遠隔千里,我們依然能夠通過文字進行無障礙的溝通。文字也能夠跨越時空,給予了我們了解古人的通道。隨著計算機的誕生,文字也進行了數字化的進程,但是不同于人類,讓計算機能夠正確地進行字符識別是一個復雜又艱巨但意義重大的工作。從計算機誕生開始,無數的研究者在這方面做了很多工作與嘗試,但面臨的困難艱巨。

其中場景文字識別中主要面臨的困難是:

(1)場景復雜變化很大;

(2)字體形態顏色多變;

(3)光照條件變化大;

(4)文字排列方式不確定;

(5)文本行與文本行之間的距離,大小格式,字體變化大。

而深度學習的引入,使得在我們在復雜場景下進行字符識別更為便利。

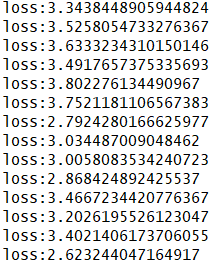

本項目通過使用pytorch搭建resnet遷移學習模型實現對復雜場景下字符的識別。其模型訓練過程如下圖可見:

# 1.基本介紹#

文字是人從日常交流中語音中演化出來,用來記錄信息的重要工具。文字對于人類意義非凡,以中國為例,中國地大物博,各個地方的口音都不統一,但是人們使用同一套書寫體系,使得即使遠隔千里,我們依然能夠通過文字進行無障礙的溝通。文字也能夠跨越時空,給予了我們了解古人的通道。隨著計算機的誕生,文字也進行了數字化的進程,但是不同于人類,讓計算機能夠正確地進行字符識別是一個復雜又艱巨但意義重大的工作。從計算機誕生開始,無數的研究者在這方面做了很多工作與嘗試,但面臨的困難艱巨。

1.1 環境要求

本次環境使用的是python3.6.5+windows平臺。

主要用的庫有:Opencv-python模塊、Pillow模塊、PyTorch模塊。

Opencv-python模塊:

opencv-python是一個Python綁定庫,旨在解決計算機視覺問題。其使用Numpy,這是一個高度優化的數據庫操作庫,具有MATLAB風格的語法。所有Opencv數組結構都轉換為Numpy數組。這也使得與使用Numpy的其他庫(如Scipy和Matplotlib)集成更容易。

Pillow模塊:

Pillow是Python里的圖像處理庫,它提供了了廣泛的文件格式支持和強大的圖像處理能力,主要包括圖像儲存、圖像顯示、格式轉換以及基本的圖像處理操作等。

PyTorch模塊

PyTorch是一個基于Torch的Python開源機器學習庫,用于自然語言處理等應用程序。它主要由Facebookd的人工智能小組開發,不僅能夠實現強大的GPU加速,同時還支持動態神經網絡,這一點是現在很多其他的主流框架都不支持的。PyTorch還提供了兩個高級功能:1.具有強大的GPU加速的張量計算2.包含自動求導系統的深度神經網絡 除了Facebook之外,Twitter、GMU和Salesforce等機構都采用了PyTorch。

1.2 遷移模型

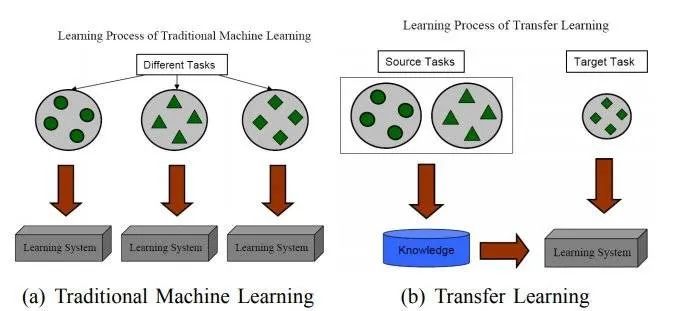

遷移學習是通過從已學習的相關任務中轉移知識來改進學習的新任務,雖然大多數機器學習算法都是為了解決單個任務而設計的,但是促進遷移學習的算法的開發是機器學習社區持續關注的話題。

由下圖可以看出遷移學習和傳統機器學習的區別,在傳統機器學習的學習過程中,我們試圖單獨學習每一個學習任務,即生成多個學習系統;而在遷移學習中,我們試圖將在前幾個任務上學到的知識轉移到目前的學習任務上,從而將其結合起來。

# 2.算法模型#

在這里我們使用的是resnet模型對圖像進行特征提取。其中圖像特征提取通常使用卷積神經網絡進行特征學習,由于字符識別相較于物體分類的不同,通常不會完全照搬分類網絡來直接進行圖形特征提取,會在分類網絡的基礎上為了適應目標任務的改進。

由于卷積神經網絡會受到感受野的限制,因此提出了需要使用序列特征提取模型對特征進行建模,學習卷積神經網絡提取到的圖像特征之間的上下文關系。

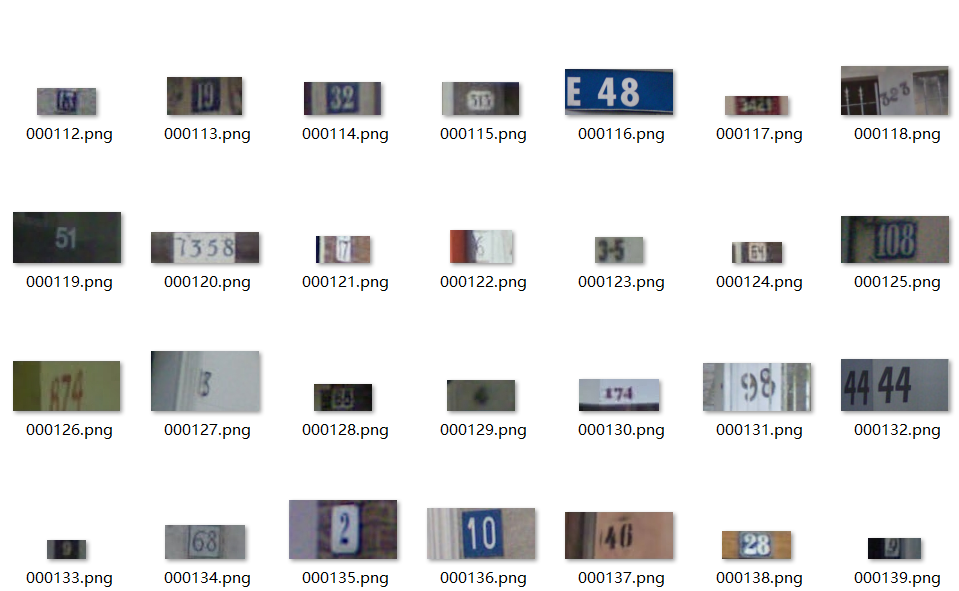

2.1 數據集準備

在這里我們將訓練的數據集分成了訓練集、測試集和驗證集三部分。其中準備的數據集如下:

2.2 數據處理

為了保證每次運行模型效果基本相同,這里設置隨機種子,同時torch.backends.cudnn.deterministic將這個flag置為True。然后進行圖像變換transforms,shffule=True在表示不同批次的數據遍歷時,打亂順序。num_workers=0表示使用0個子進程來加載數據。代碼如下:

SVHNDataset(train_path, train_label, transforms.Compose([ # 圖像尺寸變換(resize) ——transforms.Resize transforms.Resize((64, 128)), # 隨機裁剪:transforms.RandomCrop。size(sequence 或int) transforms.RandomCrop((60, 120)), # 修改亮度、對比度和飽和度:transforms.ColorJitter。亮度。對比度。飽和度。。。 transforms.ColorJitter(0.3, 0.3, 0.2), # 隨機旋轉:transforms.RandomRotation。degrees(sequence 或float或int) -要選擇的度數范圍 transforms.RandomRotation(5), # 將PIL Image或者 ndarray 轉換為tensor,并且歸一化至[0-1] transforms.ToTensor(), # 標準化:transforms.Normalize。用平均值和標準偏差歸一化張量圖像。mean每個通道的均值序列。std每個通道的標準偏差序列。 transforms.Normalize([0.485, 0.456, 0.406], [0.229, 0.224, 0.225]) ])), batch_size=40, shuffle=True, num_workers=0 )

2.3 resnet模型搭建

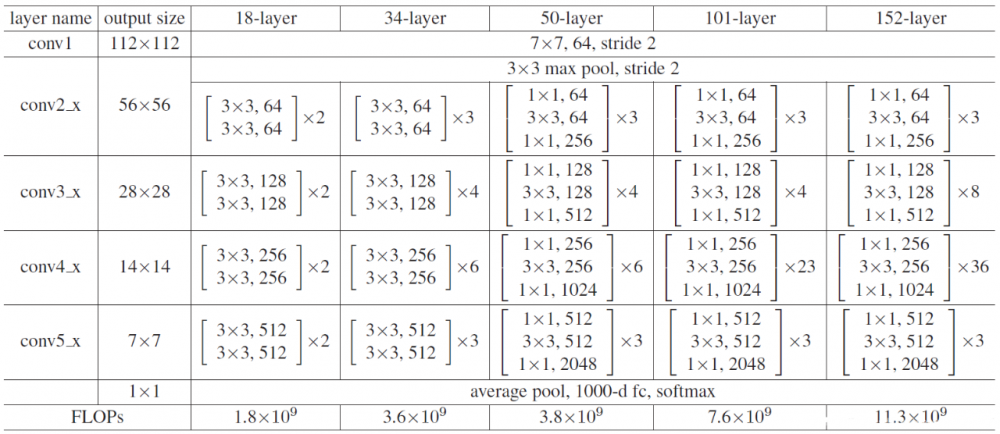

這里采用的resnet18模型是由17個卷積層(conv)+1個全連接層(fc)構成。其中使用resnet模型的主要優勢在于,當逐漸增加神經網絡的深度時,網絡難以學習恒等函數的參數,導致最后的訓練效果往往達不到預期,也會影響網絡性能。殘差網絡學習恒等函數比較容易,可將添加的網絡層看成一個個殘差塊。例如,一個20層的普通網絡,每兩層之間通過跳躍連接構成一個殘差塊,那么這個普通網絡就成為一個由10個殘差塊構成的殘差網絡。網絡性能不僅沒有下降,而且甚至有所提高。普通網絡轉化為殘差網絡也比較容易,只需要加入殘差塊即可。殘差網絡大大提高了網絡層數,通過殘差映射的方式進行擬合,簡單易操作,同時提高了準確率。

設置resnet18網絡模型,進行遷移學習,保留resnet18網絡的卷積網絡部分,并保留預訓練參數。然后設計自適應平均池化函數,即不管之前的特征圖尺寸為多少,只要設置為(1,1),那么最終特征圖大小都為(1,1),然后把resnet18模型除了最后一個全連接層之外的各個網絡層提取出來,并設置5個全連接層,分別對應5個可能的街道字符的識別。

def __init__(self): super(SVHN_Model1, self).__init__() model_conv = models.resnet18(pretrained=True) model_conv.avgpool = nn.AdaptiveAvgPool2d(1) model_conv = nn.Sequential(*list(model_conv.children())[:-1]) self.cnn = model_conv self.fc1 = nn.Linear(512, 11) self.fc2 = nn.Linear(512, 11) self.fc3 = nn.Linear(512, 11) self.fc4 = nn.Linear(512, 11) self.fc5 = nn.Linear(512, 11) def forward(self, img): feat = self.cnn(img) feat = feat.view(feat.shape[0], -1) c1 = self.fc1(feat) c2 = self.fc2(feat) c3 = self.fc3(feat) c4 = self.fc4(feat) c5 = self.fc5(feat) # c6 = self.fc6(feat) return c1, c2, c3, c4, c5 # , c6

完整代碼鏈接:

https://pan.baidu.com/s/1UpIq9XSlWxSotE0fama3Vw 提取碼:gcwu

*博客內容為網友個人發布,僅代表博主個人觀點,如有侵權請聯系工作人員刪除。