實踐教程|YOLOX目標檢測ncnn實現

作者 | 唐超@知乎(已授權)

來源丨https://zhuanlan.zhihu.com/p/391788686

編輯丨極市平臺

導讀

本文將YOLOX訓練的模型轉到ncnn進行推理加速。

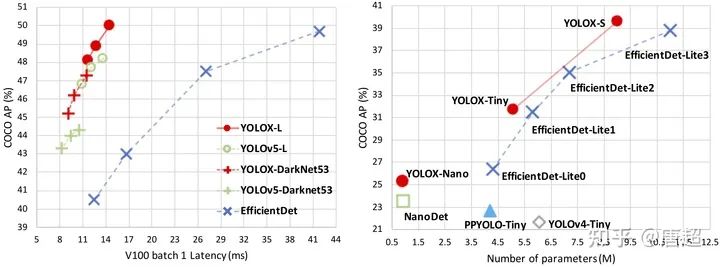

YOLOX最近刷屏了,關鍵是官方倉庫直接給出了ncnn、tensorRT、openvino、onnxruntime實現,簡直是無 比 良 心bù gěi huó lù!!!

0x00 YOLOX目標檢測

懂得都懂,異常強大。貼上鏈接方便大家感受:https://github.com/Megvii-BaseDetection/YOLOX;

以及https://arxiv.org/abs/2107.08430。

具體算法解析啥的,極市之前有過解讀,詳見吊打一切現有版本的YOLO!曠視重磅開源YOLOX:新一代目標檢測性能速度擔當!一文,本文主要是照顧有些人想自己轉YOLOX訓練的模型到ncnn進行推理加速。

具體算法解析啥的,極市之前有過解讀,詳見吊打一切現有版本的YOLO!曠視重磅開源YOLOX:新一代目標檢測性能速度擔當!一文,本文主要是照顧有些人想自己轉YOLOX訓練的模型到ncnn進行推理加速。

0x01 配置環境

因為只是需要導出原始pytorch模型到onnx,所以機器配置可以隨意,不過建議還是用帶gpu的設備,跑demo需要用gpu才能行,我嘗試改成cpu之后并不能出結果/sad。

git clone git@github.com:Megvii-BaseDetection/YOLOX.git cd YOLOX pip3 install -U pip && pip3 install -r requirements.txt pip3 install -v -e . # or python3 setup.py develop git clone https://github.com/NVIDIA/apex cd apex pip3 install -v --disable-pip-version-check --no-cache-dir --global-option="--cpp_ext" --global-option="--cuda_ext" ./

其實跟著官網git上面流程走就行,到目前為止就可以試試demo看看模型效果了。我這里用的是yolox-nano這個模型來做說明。

python tools/demo.py image -n yolox-nano -c /path/to/your/yolox_nano.pth.tar --path assets/dog.jpg --conf 0.3 --nms 0.65 --tsize 640 --save_result

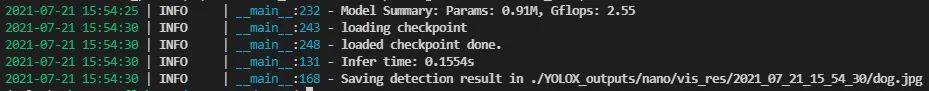

上述命令執行完成之后會打印出以下信息:

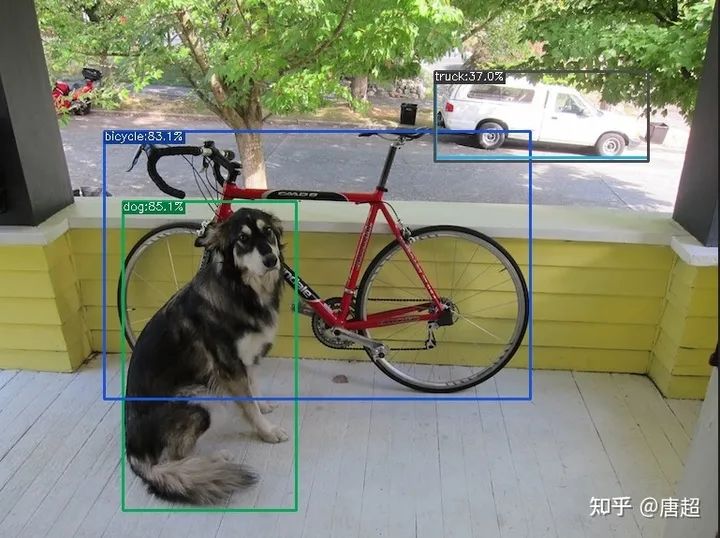

檢測的結果存儲在./YOLOX\_outputs/nano/vis\_res/2021\_07\_21\_15\_54\_30/dog.jpg。具體效果如下圖所示:

(小聲BB,用官方model以及demo程序跑出來還是有一丟丟問題,我也提了issue,不過回答的我并不怎么滿意。有興趣的可以自己去翻......當然了,那個誤識別可以設置conf為0.4剔除。)

好了,至此,相當于我們整體環境就整完了,接下來就是導出pytorch模型到onnx,然后再轉到ncnn了。

PS:我看issue里好多人在問在哪看結果,我的怎么沒結果之類的。。。。如果正確執行完成了,會輸出檢測結果的存儲路徑。如果你沒看到這個,那么不好意思,可能是你姿勢有問題(大概率是模型不對,沒有用gpu,cpu是沒法跑的,但是它又不報錯/sad)

0x02 模型轉換

其實吧,pytorch模型導出到onnx這塊代碼YOLOX已經很貼心的提供了,這樣就不需要我們自己倒騰啥后處理屏蔽之類的騷操作了。直接按下面命令運行即可:

#如果你環境中還沒安裝onnx-simplifier,那么需要安裝一個,嫌麻煩不安裝也可以,后面給另一個方案 pip install onnx-simplifier python tools/export_onnx.py -n yolox-nano -c /path/to/your/yolox_nano.pth.tar

這個導出onnx的代碼非常貼心,之間把onnx-simplifier也放在里面一起做了,可以一定程度上減少模型里面出現的一些膠水OP,如果你嫌安裝這個比較麻煩,也可以用“@大缺弦www.zhihu.com/people/33295f2791c588f9df071dddb701278a”的網頁版進行模型轉換,這里給出鏈接:一鍵轉換 Caffe, ONNX, TensorFlow 到 NCNN, MNN, Tengineconvertmodel.com

使用非常方便,節約了自己配環境安裝的過程(其實主要是有些轉換工具編譯時需要protobuf支持,但是好多人這里都卡住了)。不過大老師由于太忙了,網頁端轉換工具有時候并沒有更新到最新,所以.....大家還是體諒下吧。

得到由onnx-simplifier的模型之后,就可以開始轉換ncnn之旅了!(貼太多圖了,模型圖就不貼了,大家可以自己用netron打開欣賞)

# ncnn_root代表ncnn根目錄 cd /ncnn_root/build/tools/onnx ./onnx2ncnn /path/to/yolox-nano.onnx yolox-nano.param yolox-nano.bin

運行完成之后會出現很多Unsupported slice step,這是focus模塊轉換的報錯,別害怕,up已經幫我們鋪好路了。

Unsupported slice step ! Unsupported slice step ! Unsupported slice step ! Unsupported slice step ! Unsupported slice step ! Unsupported slice step ! Unsupported slice step ! Unsupported slice step !

具體怎么寫focus可以去看up寫的轉換yolov5s到ncnn的文章,我這里主要只講具體操作過程:nihui:詳細記錄u版YOLOv5目標檢測ncnn實現zhuanlan.zhihu.com

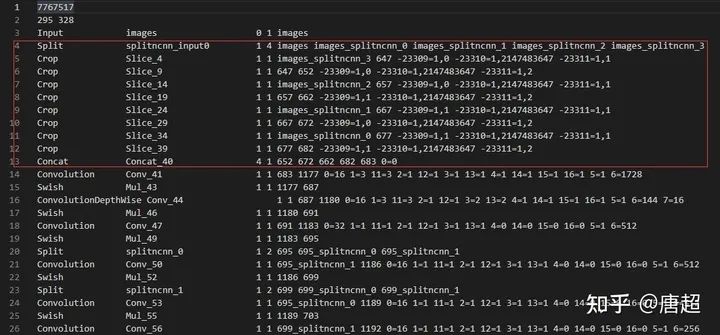

打開上面轉換好的yolox-nano.param文件,可以看到如上圖所示的樣子,紅框中的內容實際上就是focus,我們只需要把這里修改下就好了,具體是在第四行插入以下內容:

YoloV5Focus focus 1 1 images 683

然后把原先的4-13行全部刪除,這里需要注意的是,1 1 images 683分別代表的意思是一個輸入、一個輸出、輸入blob名稱為images、輸出blob名稱為683。有可能你自己改結構轉出來的名字不一樣,所以需要對照上面紅框來取。images也就是第三行的輸出blob name,而683則是第13行Concat的輸出blob name,因為這個Concat的輸入是4個,輸出有一個,也就是652 672 662 682都是輸出,而683是輸出。這樣就把這里修改完成了。

你以為這樣就完事了?NO,其實還有個關鍵的東西沒改,那就是param文件的第二行的數字沒改,第一個數是layer count,我們刪除了一些層,如果還是按照這個走后面載入模型會報錯。這里給個簡單的修改方法(免得你要自己記刪除了多少增加了多少......),直接看param整體行數,然后減去開頭的兩行就行了,我們這里改成focus之后需要把layer count改成286,而至于第二個數,代表的是blob count,這個可以多,但是別少就行了!因為我們之后還有個很重要的操作,可以把這里的數量改對。

接下來可以用ncnnoptimize對模型進行優化,順便轉為 fp16 存儲減小模型體積

./ncnnoptimize ./onnx/yolox-nano-sim.param ./onnx/yolox-nano-sim.bin yolox-nano-sim.param yolox-nano-sim.bin 65536

前面兩個參數是優化前的模型,后面兩個是優化后的模型。

create_custom_layer YoloV5Focus fuse_convolution_activation Conv_314 Sigmoid_330 fuse_convolution_activation Conv_328 Sigmoid_329 fuse_convolution_activation Conv_347 Sigmoid_363 fuse_convolution_activation Conv_361 Sigmoid_362 fuse_convolution_activation Conv_380 Sigmoid_396 fuse_convolution_activation Conv_394 Sigmoid_395 model has custom layer, shape_inference skipped model has custom layer, estimate_memory_footprint skipped

0x03 run起來

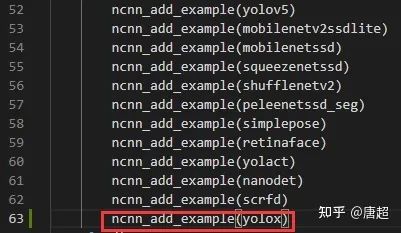

模型轉換完成之后,運行起來就比較簡單了(主要是YOLOX自己提供了ncnn的代碼),為看簡單起見,咱們直接把yolox.cpp文件挪到ncnn工程的examples目錄下,然后在/ncnn\_root/examples/CMakeLists.txt中做如圖修改:

接下來就是正常的編譯環節了,另外,由于yolox.cpp中模型路徑是寫的絕對路徑,大家可以根據自己的情況去做更改。

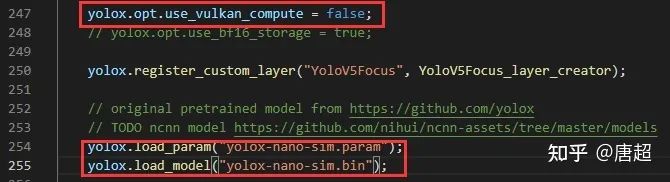

上圖中第一個紅框因為我只是跑流程,沒有編譯vulkan,所以把這個關掉了,大家根據自己的來,第二個位置就是把模型改成自己的模型路徑。

./yolox /path/to/YOLOX/assets/dog.jpg

(反正已經是保姆級別了,就再提一下,因為模型是傳的相對路徑,對于上圖而言,你需要將可執行程序和模型放到同級目錄才能正常運行。或者你直接給絕對路徑也行)

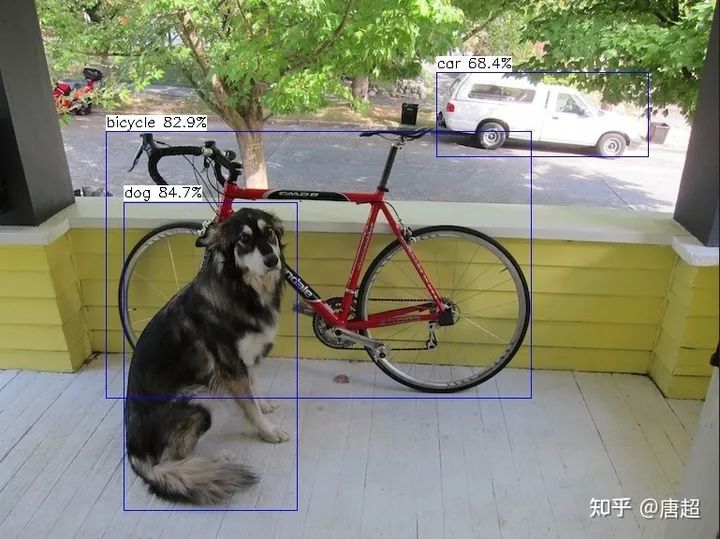

最后附上ncnn的結果(有彩蛋,大概算吧).

啊,彩蛋就是ncnn沒有出現那個誤檢的框......參數配置都是一樣,conf0.3,nms0.65, size 416。官方說法是nms實現不一樣,咱也沒看,后面再細究吧,反正本文不是為了講技術實現(主要是菜)。

0x04 總結

其實沒啥好總結的,很多工作大家都已經做好了,我只是搬運然后寫細致了一點,只希望能夠幫助到有些剛入門或者對這塊感興趣的人吧。

*博客內容為網友個人發布,僅代表博主個人觀點,如有侵權請聯系工作人員刪除。