人臉識(shí)別精度提升 | 基于Transformer的人臉識(shí)別

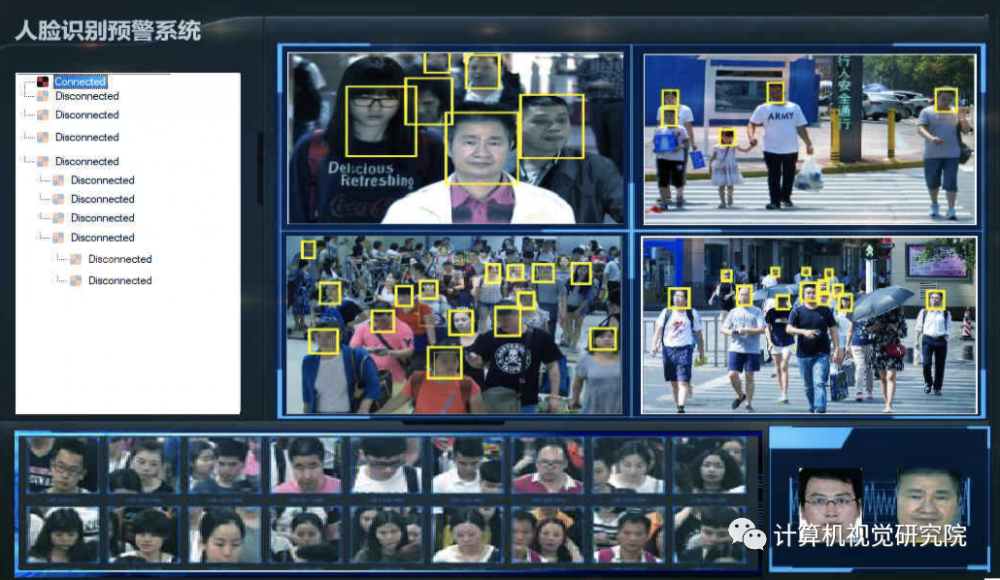

現(xiàn)階段的人臉檢測(cè)識(shí)別技術(shù)已經(jīng)特別成熟,不管在什么領(lǐng)域都有特別成熟的應(yīng)用,比如:無(wú)人超市、車站檢測(cè)、犯人抓捕以及行跡追蹤等應(yīng)用。但是,大多數(shù)應(yīng)用都是基于大量數(shù)據(jù)的基礎(chǔ),成本還是非常昂貴。所以人臉識(shí)別的精度還是需要進(jìn)一步提升,那就要繼續(xù)優(yōu)化更好的人臉識(shí)別框架。

論文:https://arxiv.org/pdf/2103.14803.pdf

一、技術(shù)回顧——Transformer

相比于卷積,Transformer有什么區(qū)別,優(yōu)勢(shì)在哪?

卷積有很強(qiáng)的歸納偏見(jiàn)(例如局部連接性和平移不變性),雖然對(duì)于一些比較小的訓(xùn)練集來(lái)說(shuō),這毫無(wú)疑問(wèn)是有效的,但是當(dāng)我們有了非常充足的數(shù)據(jù)集時(shí),這些會(huì)限制模型的表達(dá)能力。與CNN相比,Transformer的歸納偏見(jiàn)更少,這使得他們能夠表達(dá)的范圍更廣,從而更加適用于非常大的數(shù)據(jù)集;

卷積核是專門設(shè)計(jì)用來(lái)捕捉局部的時(shí)空信息,它們不能夠?qū)Ω惺芤爸獾囊蕾囆赃M(jìn)行建模。雖然將卷積進(jìn)行堆疊,加深網(wǎng)絡(luò)會(huì)擴(kuò)大感受野,但是這些策略通過(guò)聚集很短范圍內(nèi)的信息的方式,仍然會(huì)限制長(zhǎng)期以來(lái)的建模。與之相反,自注意力機(jī)制通過(guò)直接比較在所有時(shí)空位置上的特征,可以被用來(lái)捕捉局部和全局的長(zhǎng)范圍內(nèi)的依賴;

當(dāng)應(yīng)用于高清的長(zhǎng)視頻時(shí),訓(xùn)練深度CNN網(wǎng)絡(luò)非常耗費(fèi)計(jì)算資源。目前有研究發(fā)現(xiàn),在靜止圖像的領(lǐng)域中,Transformer訓(xùn)練和推導(dǎo)要比CNN更快。使得能夠使用相同的計(jì)算資源來(lái)訓(xùn)練擬合能力更強(qiáng)的網(wǎng)絡(luò)。

二、簡(jiǎn)要

最近,人們不僅對(duì)Transformer的NLP,而且對(duì)計(jì)算機(jī)視覺(jué)也越來(lái)越感興趣。我們想知道Transformer是否可以用于人臉識(shí)別,以及它是否比cnns更好。

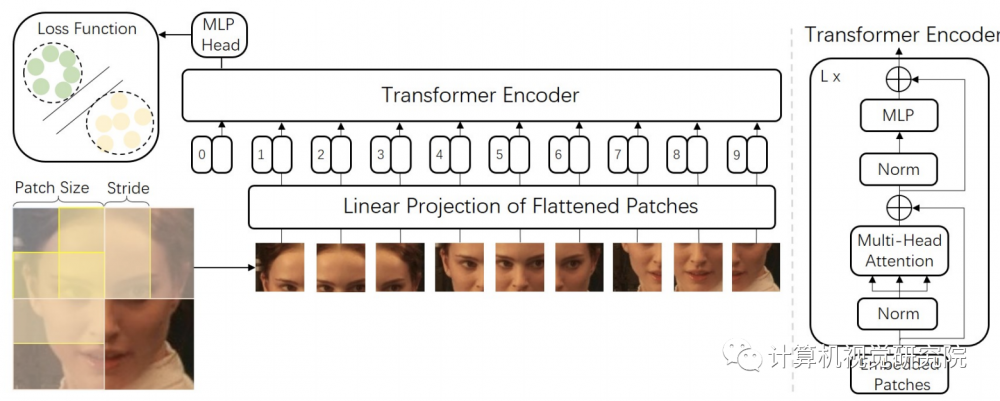

因此,有研究者研究了Transformer模型在人臉識(shí)別中的性能。考慮到原始Transformer可能忽略inter-patch信息,研究者修改了patch生成過(guò)程,使相互重疊的滑動(dòng)塊成為標(biāo)識(shí)。這些模型在CASIA-WebFace和MSSeleb-1M數(shù)據(jù)庫(kù)上進(jìn)行訓(xùn)練,并在幾個(gè)主流基準(zhǔn)上進(jìn)行評(píng)估,包括LFW、SLLFW、CALFW、CPLFW、TALFW、CFP-FP、AGEDB和IJB-C數(shù)據(jù)庫(kù)。研究者證明了在大規(guī)模數(shù)據(jù)庫(kù)MS-Celeb-1M上訓(xùn)練的人臉Transformer模型實(shí)現(xiàn)了與CNN具有參數(shù)和MACs相似數(shù)量的CNN相似的性能。

二、FACE TRANSFORMER

2.1 網(wǎng)絡(luò)框架愛(ài)

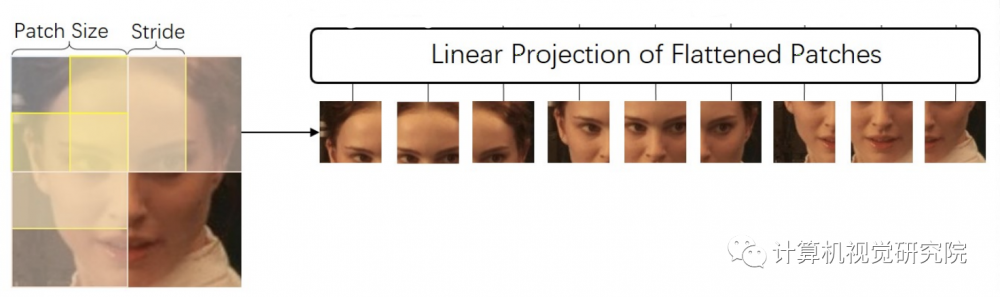

人臉Transformer模型采用ViT[A. Dosovitskiy, L. Beyer, A. Kolesnikov, D. Weissenborn, X. Zhai, T. Unterthiner, M. Dehghani, M. Minderer, G. Heigold, S. Gelly et al., “An image is worth 16x16 words: Transformers for image recognition at scale,” arXiv preprint arXiv:2010.11929]體系結(jié)構(gòu),采用原Transformer。唯一的區(qū)別是,研究者修改了ViT的標(biāo)記生成方法,以生成具有滑動(dòng)塊的標(biāo)記,即使圖像塊重疊,以便更好地描述塊間信息,如下圖所示。

具體地說(shuō),從圖像

*博客內(nèi)容為網(wǎng)友個(gè)人發(fā)布,僅代表博主個(gè)人觀點(diǎn),如有侵權(quán)請(qǐng)聯(lián)系工作人員刪除。