基于三角測(cè)量與稠密化稀疏點(diǎn)的深度估計(jì) (ECCV2020)

論文題目:DELTAS: Depth Estimation by Learning Triangulation And densification of Sparse points (ECCV2020)

數(shù)據(jù)集和預(yù)訓(xùn)練模型下載地址:在公眾號(hào)「計(jì)算機(jī)視覺(jué)工坊」,后臺(tái)回復(fù)「DELTAS」,即可直接下載。

一、摘要

多視圖立體匹配(Multi-view Stereo)是一種主動(dòng)式深度探測(cè)與單目深度估計(jì)實(shí)用化的權(quán)衡方法。基于代價(jià)體的方法利用3D卷積網(wǎng)絡(luò)來(lái)提高M(jìn)VS系統(tǒng)的精度。然而這種方法的計(jì)算開(kāi)銷(xiāo)很大,很難用于實(shí)際應(yīng)用。與構(gòu)建代價(jià)體的方法不同,本文提出一種高效的深度估計(jì)方法。具體地,首先進(jìn)行特征點(diǎn)提取與描述子計(jì)算;然后進(jìn)行特征點(diǎn)匹配與特征點(diǎn)的三角化;最后通過(guò)CNN來(lái)對(duì)稀疏深度圖進(jìn)行稠密化。上述三個(gè)步驟的操作通過(guò)一個(gè)端到端的網(wǎng)絡(luò)框架實(shí)現(xiàn),在網(wǎng)絡(luò)模型訓(xùn)練中除了深度圖的監(jiān)督約束外,還加入了中間2D圖像和3D幾何的監(jiān)督。實(shí)驗(yàn)結(jié)果證明:文章提出的方法在不同場(chǎng)景下能夠以更低的計(jì)算開(kāi)銷(xiāo)來(lái)實(shí)現(xiàn)更精確的深度估計(jì)。

二、相關(guān)工作

2.1 特征點(diǎn)檢測(cè)與描述

基于稀疏特征點(diǎn)的方法是SLAM或VIO技術(shù)的標(biāo)準(zhǔn),因?yàn)樗麄兯俣瓤臁⒕雀摺!跋葯z測(cè)再描述”是最常見(jiàn)的稀疏特征提取方法,具體地,首先檢測(cè)特征點(diǎn),然后對(duì)該特征點(diǎn)周?chē)膲K進(jìn)行描述。描述子封裝了更高級(jí)別的信息,這些信息被低級(jí)別的關(guān)鍵點(diǎn)所忽略。在深度學(xué)習(xí)之前,SIFT和ORB特征點(diǎn)被廣泛用于低級(jí)別視覺(jué)任務(wù)的特征匹配描述子。而隨著深度學(xué)習(xí)的出現(xiàn),在很多的應(yīng)用中取代了這些手工設(shè)計(jì)的特征。近年來(lái),出現(xiàn)了SuperPoint、LIFT和GIFT等相關(guān)工作。

2.2 三角測(cè)量

三角測(cè)量是指,通過(guò)在兩處觀(guān)察同一點(diǎn)的夾角,確定該點(diǎn)的距離。三角測(cè)量最早由高斯提出并應(yīng)用于測(cè)量學(xué)中,他在天文學(xué)、地理學(xué)測(cè)量中都有應(yīng)用。在本文中,主要用三角化來(lái)估計(jì)像素點(diǎn)的距離。Samsung 人工智能研究院的研究員于2019年提出了用于多視圖位姿估計(jì)的可學(xué)習(xí)的三角測(cè)量方法[4]。可學(xué)習(xí)的三角化模塊可以集成到端到端學(xué)習(xí)的網(wǎng)絡(luò)中。

2.3 Sparse-to-Dense Depth Estimation

由于深度傳感器探測(cè)范圍的限制,Sparse-to-Dense的深度估計(jì)方法成為輔助主動(dòng)深度傳感器的一種方式,而且還具有難以檢測(cè)區(qū)域(比如黑暗和反射物體)深度空洞填補(bǔ)的作用。最早的工作是由MIT的研究人員Fangchang Ma等人提出[2]:《Sparse-to-Dense: Depth Prediction from Sparse Depth Samples and a Single Image》該文章引入了一種新的深度預(yù)測(cè)方法,用于從RGB圖像和稀疏深度圖中預(yù)測(cè)稠密深度圖,此方法適用于多傳感器融合和基于特征點(diǎn)方式的SLAM。

三、方法

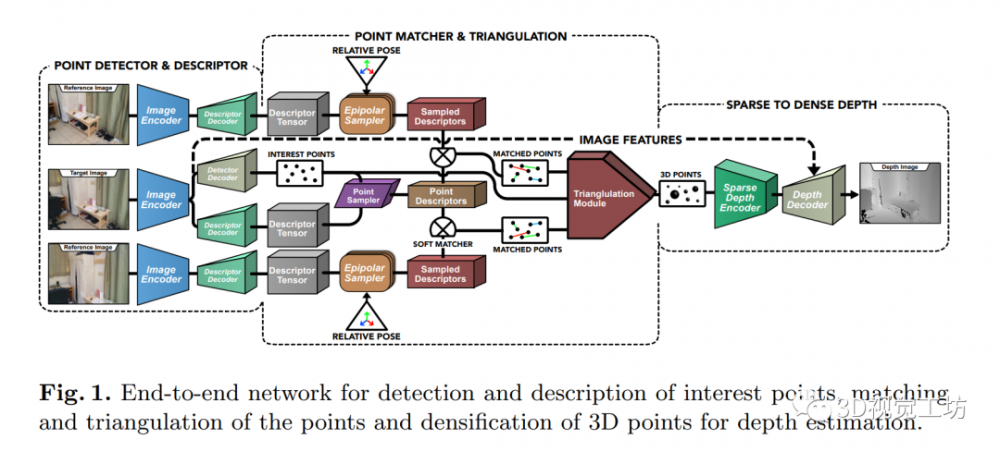

如圖1所示,以一幅目標(biāo)圖像和兩幅輔助圖像為例進(jìn)行方法步驟的說(shuō)明。本文方法大致可以分為三個(gè)步驟。第一步,首先利用類(lèi)似于SuperPoint的網(wǎng)絡(luò)進(jìn)行目標(biāo)圖像的特征點(diǎn)提取與描述子計(jì)算,同時(shí)也為輔助圖像進(jìn)行描述子計(jì)算。第二步,根據(jù)相對(duì)位姿(對(duì)極幾何)的關(guān)系確定目標(biāo)圖像特征點(diǎn)在輔助圖像的空間范圍。然后在搜索空間中采樣描述子,并與目標(biāo)圖像特征點(diǎn)的描述子進(jìn)行匹配。然后利用SVD奇異值分解的方法進(jìn)行特征點(diǎn)的三角化,最后根據(jù)輸出的3D點(diǎn)創(chuàng)建稀疏深度圖。最后一步,稀疏深度圖編碼器輸出的特征圖與RGB圖像編碼器輸出的特征圖用于生成最后的稠密深度圖。

3.1 特征點(diǎn)檢測(cè)與描述

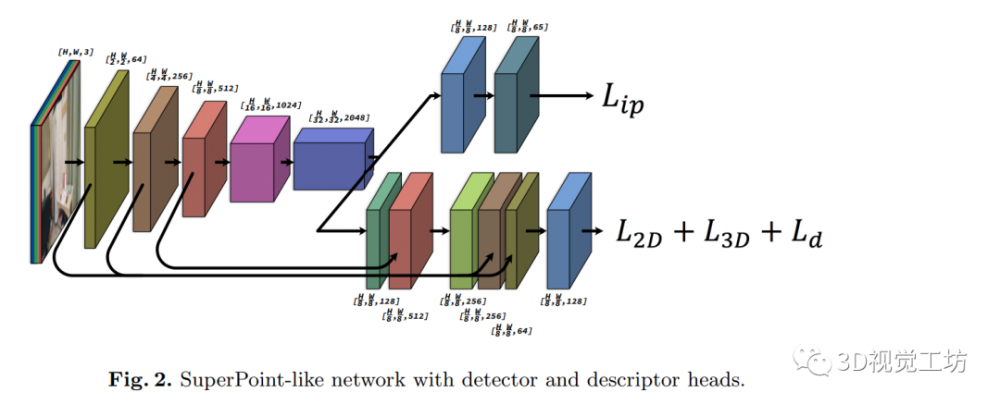

如圖2所示,本文使用類(lèi)似于SuperPoint的網(wǎng)絡(luò)結(jié)構(gòu)進(jìn)行特征點(diǎn)檢測(cè)與描述子計(jì)算。該網(wǎng)絡(luò)模型有一個(gè)圖像編碼器用于提取圖像特征,并且減小圖像維度。提取的特征送入后續(xù)的兩個(gè)特征任務(wù)的****中:用于特征點(diǎn)檢測(cè)與特征點(diǎn)描述子計(jì)算。原始版本的SuperPoint用于高速視頻幀的姿態(tài)估計(jì),所以圖像編碼器使用的是淺層的VGG網(wǎng)絡(luò)。但是SuperPoint淺層的骨干網(wǎng)絡(luò)并不完全適合于本文的深度估計(jì)任務(wù)。因此出于權(quán)衡效率和性能的考量,作者使用了ResNet-50編碼器替換了原來(lái)的骨干網(wǎng)絡(luò)。

3.2 特征點(diǎn)匹配與三角化

3.2.1 特征點(diǎn)匹配

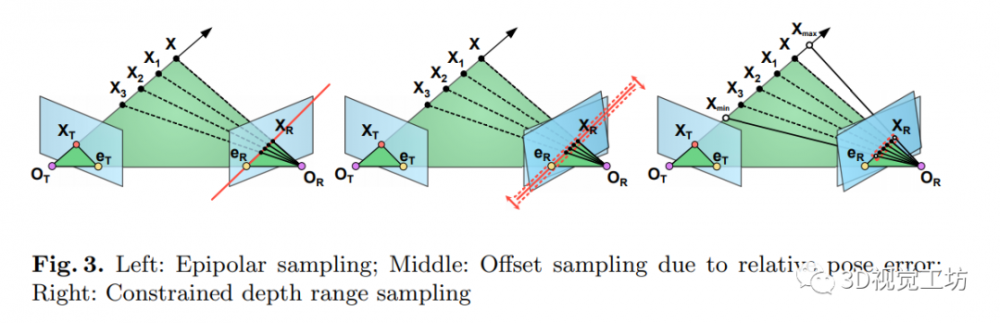

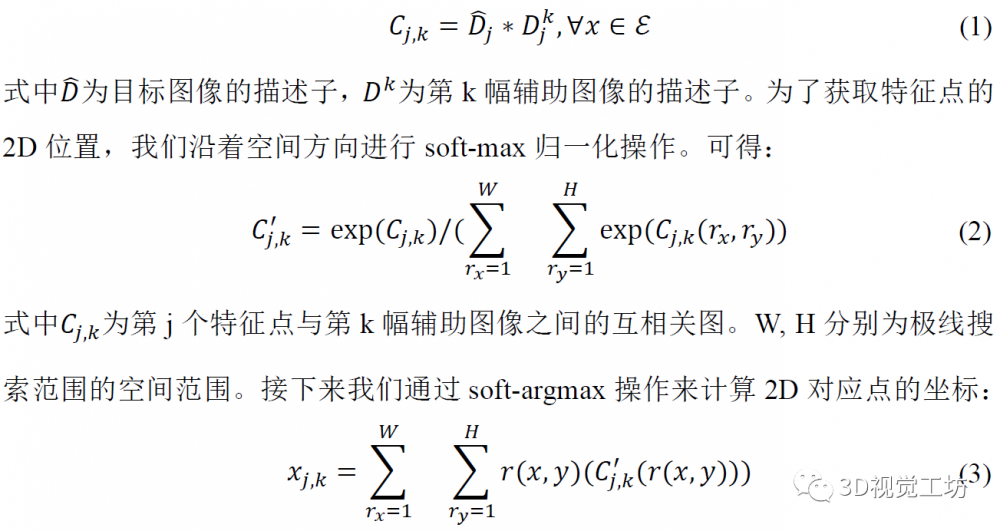

上述步驟進(jìn)行了目標(biāo)圖像的特征點(diǎn)檢測(cè)與所有視圖的描述子計(jì)算。一種直接的特征點(diǎn)匹配策略是:將目標(biāo)圖像特征點(diǎn)的描述子與輔助圖像上所有可能的位置進(jìn)行匹配對(duì)應(yīng)。然而這種策略因?yàn)橛?jì)算量過(guò)大而不能采用。考慮到匹配點(diǎn)的對(duì)應(yīng)滿(mǎn)足對(duì)極幾何的關(guān)系,所以我們只在輔助圖像的極線(xiàn)上進(jìn)行搜索。如圖3所示,在理想情況下匹配點(diǎn)會(huì)位于極線(xiàn)上。然而實(shí)際情況中由于相機(jī)位姿存在偏差等因素,我們?cè)跇O限搜索時(shí)會(huì)加上一個(gè)小的偏置。考慮到極線(xiàn)延伸范圍為-∞到+∞,我們將極線(xiàn)范圍限制在可行的深度探測(cè)范圍內(nèi)(如右圖所示)。對(duì)于每一幅輔助圖像,目標(biāo)圖像特征點(diǎn)的描述子沿著極線(xiàn)方向與描述子進(jìn)行卷積,可得互相關(guān)圖:

3.2.2 特征點(diǎn)三角化

3.3 Sparse-to-Dense Depth Estimation

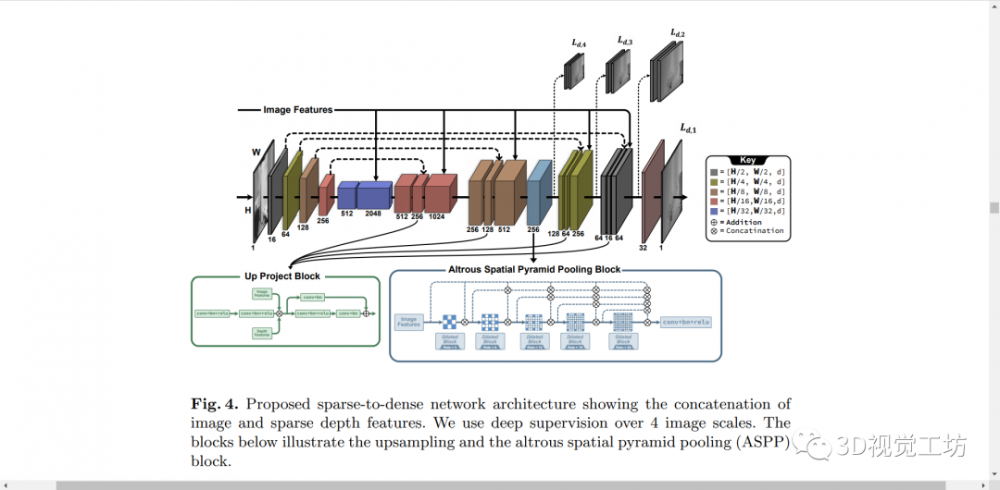

特征點(diǎn)檢測(cè)網(wǎng)絡(luò)提供了特征點(diǎn)的2D坐標(biāo),三角化的z坐標(biāo)提供了深度值。我們可以將稀疏點(diǎn)轉(zhuǎn)化為與彩色圖像相同分辨率的稀疏深度圖。網(wǎng)絡(luò)模型的梯度可以從稀疏深度圖回傳至3D關(guān)鍵點(diǎn),再回傳至輸入圖像。我們將稀疏深度圖通過(guò)一個(gè)編碼器獲得深度圖特征(該編碼器為一個(gè)層數(shù)較淺的RGB圖像編碼器)。具體地,編碼器使用的是ResNet-50,其中每層的通道寬度為圖像編碼器的1/4。將稀疏深度圖的特征和RGB彩色圖的特征聯(lián)結(jié)起來(lái)。如圖4所示,本模塊共有4個(gè)尺度的深度圖輸出。模塊中還用到了空間金字塔池化模塊,以獲得不同感受野下的特征。

四、實(shí)驗(yàn)

4.1 特征點(diǎn)與描述子質(zhì)量

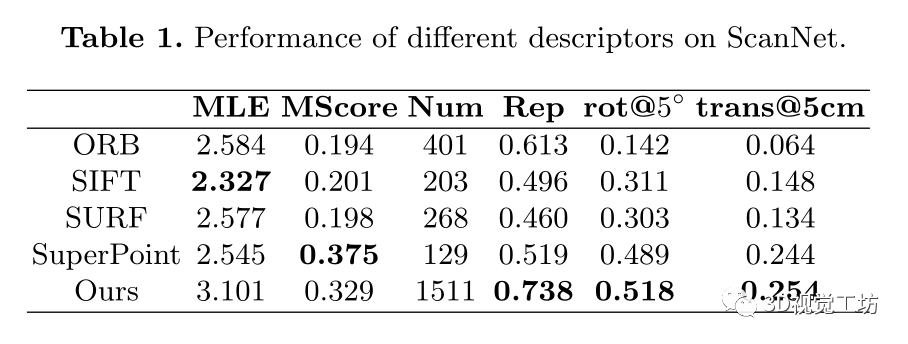

表1展示了檢測(cè)子與描述子的性能評(píng)測(cè)。其中MLE和可重復(fù)性為檢測(cè)子的評(píng)判指標(biāo),MScore為描述子評(píng)判指標(biāo)。旋轉(zhuǎn)5°和平移5°為綜合考量指標(biāo)。

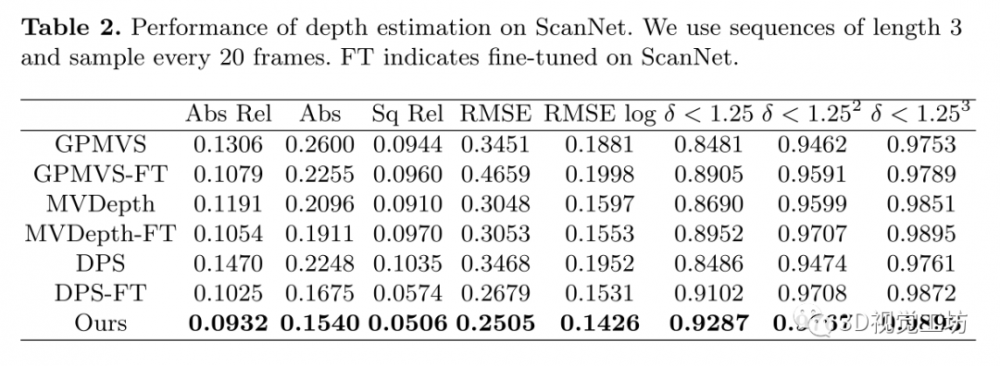

4.2 深度估計(jì)性能對(duì)比

在不同場(chǎng)景和不同數(shù)據(jù)集的評(píng)測(cè)中,采用了相同的超參數(shù):將檢測(cè)的特征點(diǎn)數(shù)固定為512,采樣的描述子長(zhǎng)度為100,檢測(cè)子的閾值設(shè)為5e-4。同時(shí)為確保提取的特征點(diǎn)呈現(xiàn)均勻分布并避免聚類(lèi),將NMS的參數(shù)設(shè)定為9。圖2展示了在ScanNet數(shù)據(jù)集上深度估計(jì)的預(yù)測(cè)精度。

參考文獻(xiàn)

1.Sinha A, Murez Z, Bartolozzi J, et al. Deltas: Depth estimation by learning triangulation and densification of sparse points[C]//Computer Vision–ECCV 2020: 16th European Conference, Glasgow, UK, August 23–28, 2020

2.Ma F, Karaman S. Sparse-to-dense: Depth prediction from sparse depth samples and a single image[C]//2018 IEEE international conference on robotics and automation (ICRA). IEEE, 2018: 4796-4803.

3.DeTone D, Malisiewicz T, Rabinovich A. Superpoint: Self-supervised interest point detection and description[C]//Proceedings of the IEEE conference on computer vision and pattern recognition workshops. 2018: 224-236.

4.Iskakov K, Burkov E, Lempitsky V, et al. Learnable triangulation of human pose[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. 2019: 7718-7727.

*博客內(nèi)容為網(wǎng)友個(gè)人發(fā)布,僅代表博主個(gè)人觀(guān)點(diǎn),如有侵權(quán)請(qǐng)聯(lián)系工作人員刪除。