CVPR 2021 | 谷歌發(fā)布視頻全景分割數(shù)據(jù)集!順帶開發(fā)個(gè)模型屠榜

本文轉(zhuǎn)載自:新智元 | 編輯:LRS

自動(dòng)駕駛里視覺一直為人所詬病,特斯拉就是經(jīng)常被拉出來(lái)批判的典型。谷歌最近開發(fā)了一個(gè)新模型,效果拔群,已被CVPR2021接收。

對(duì)于人來(lái)說(shuō),看一張平面照片能夠想象到重建后的3D場(chǎng)景布局,能夠根據(jù)2D圖像中包含的有限信號(hào)來(lái)識(shí)別對(duì)象,確定實(shí)例大小并重建3D場(chǎng)景布局。

這個(gè)問(wèn)題有一個(gè)術(shù)語(yǔ)叫做光學(xué)可逆問(wèn)題inverse optics problem,它是指從視網(wǎng)膜圖像到視網(wǎng)膜刺激源的模糊映射。

現(xiàn)實(shí)世界中的計(jì)算機(jī)視覺應(yīng)用,例如自動(dòng)駕駛就嚴(yán)重依賴這些功能來(lái)定位和識(shí)別3D對(duì)象,這需要AI模型來(lái)推斷投影到2D圖像的每個(gè)3D點(diǎn)的空間位置、語(yǔ)義類別和實(shí)例標(biāo)簽。

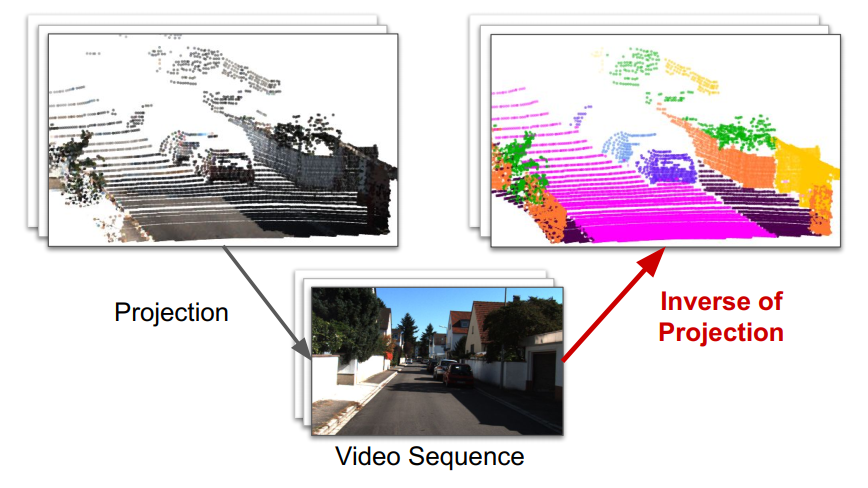

從圖像重建3D世界的能力可以分解為兩個(gè)獨(dú)立的子任務(wù):?jiǎn)文可疃裙烙?jì)(從單個(gè)圖像預(yù)測(cè)深度)和視頻全景分割(實(shí)例分割和語(yǔ)義分割)。

研究人員通常對(duì)每個(gè)任務(wù)提出不同的模型,通過(guò)在多個(gè)任務(wù)之間共享計(jì)算的模型權(quán)重。在實(shí)際應(yīng)用的時(shí)候,將這些任務(wù)與統(tǒng)一的計(jì)算機(jī)視覺模型一起處理可以簡(jiǎn)化部署提高效率。

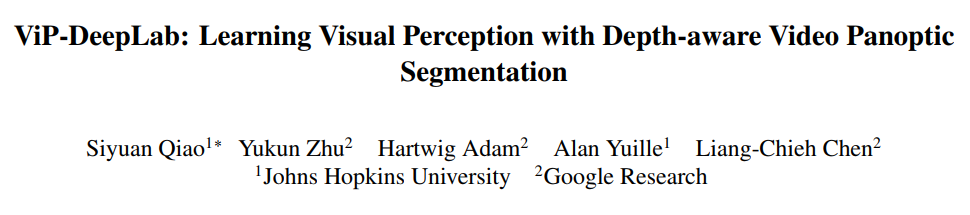

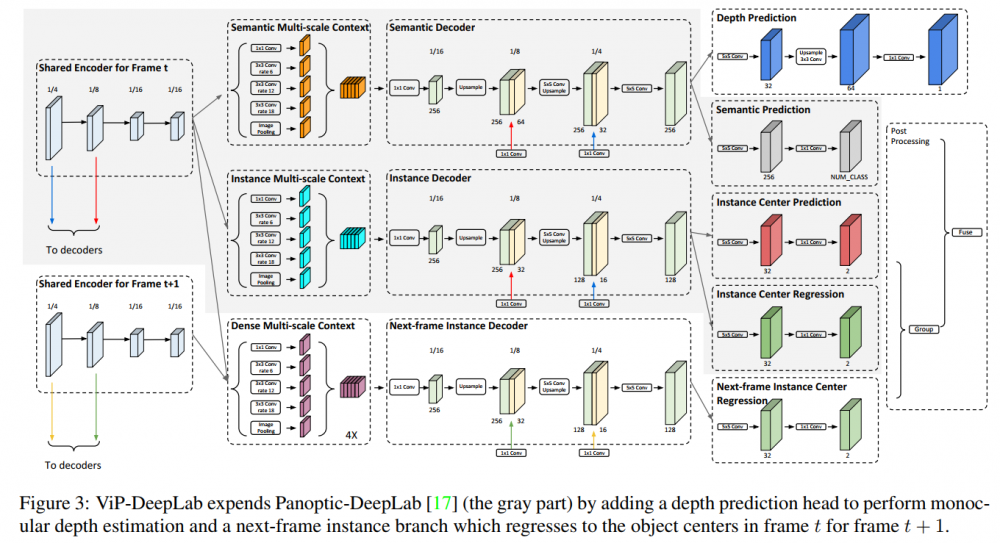

基于這個(gè)研究背景,Google提出一個(gè)全新的模型ViP-DeepLab,通過(guò)深度感知視頻全景分割來(lái)學(xué)習(xí)視覺感知,已被CVPR 2021接受,旨在同時(shí)解決單目深度估計(jì)和視頻全景分割。

ViP-DeepLab: Learning Visual Perception with Depth-aware Video Panoptic Segmentation

論文:https://arxiv.org/abs/2012.05258

數(shù)據(jù)集:https://github.com/joe-siyuan-qiao/ViP-DeepLab

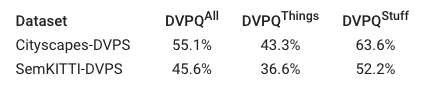

論文中還提出了兩個(gè)數(shù)據(jù)集,并提出了一種稱為深度感知視頻全景質(zhì)量(DVPQ)的新評(píng)估指標(biāo),這個(gè)新指標(biāo)可以同時(shí)評(píng)估深度估計(jì)和視頻全景分割。

ViP-DeepLab是一個(gè)統(tǒng)一的模型,可以對(duì)圖像平面上的每個(gè)像素聯(lián)合執(zhí)行視頻全景分割和單目深度估計(jì),并在子任務(wù)的幾個(gè)學(xué)術(shù)數(shù)據(jù)集取得了sota結(jié)果。

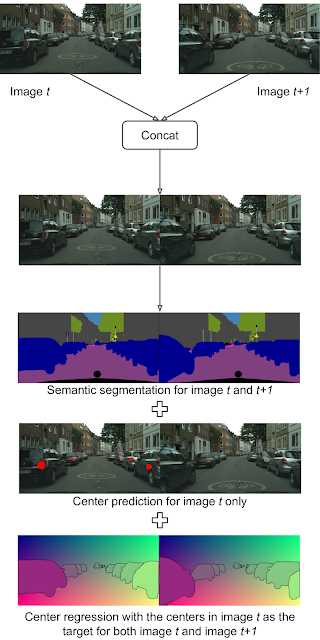

ViP-DeepLab通過(guò)從兩個(gè)連續(xù)的幀作為輸入來(lái)執(zhí)行其他預(yù)測(cè),輸出包括第一幀的深度估計(jì),它為每個(gè)像素分配一個(gè)深度估計(jì)值。

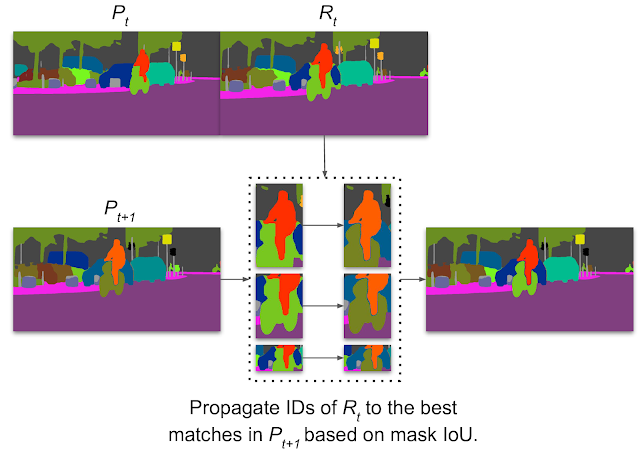

此外,ViP-DeepLab還對(duì)出現(xiàn)在第一幀中的對(duì)象中心執(zhí)行兩個(gè)連續(xù)幀的中心回歸,此過(guò)程稱為中心偏移預(yù)測(cè),它允許兩個(gè)幀中的所有像素分組到出現(xiàn)在第一幀中的同一對(duì)象。如果未將新實(shí)例匹配到先前檢測(cè)到的實(shí)例中,則會(huì)出現(xiàn)新實(shí)例。

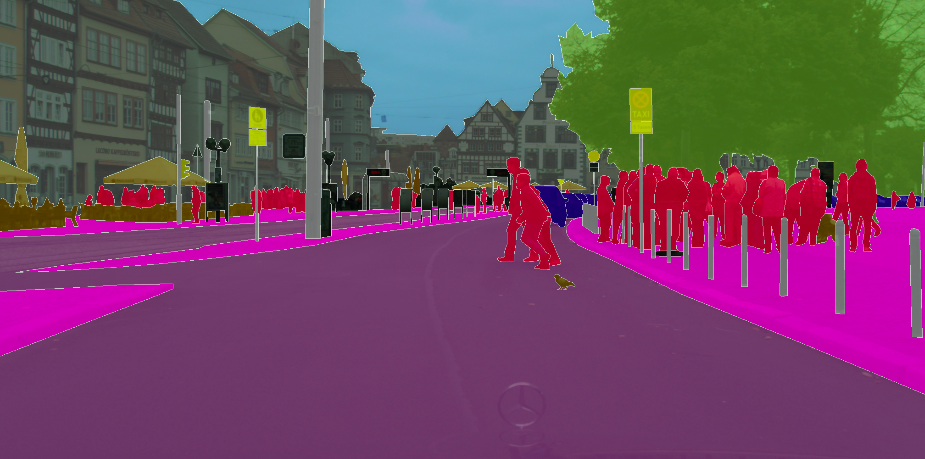

ViP-DeepLab的輸出可以用于視頻全景分割。連接兩個(gè)連續(xù)的幀作為輸入。語(yǔ)義分割輸出將每個(gè)像素與其語(yǔ)義類別相關(guān)聯(lián),而實(shí)例分割輸出則從與第一幀中的單個(gè)對(duì)象相關(guān)聯(lián)的兩個(gè)幀中識(shí)別像素,輸入圖像來(lái)自Cityscapes數(shù)據(jù)集。

論文中在多個(gè)流行的基準(zhǔn)數(shù)據(jù)集上測(cè)試了ViP-DeepLab,包括Cityscapes-VPS,KITTI深度預(yù)測(cè)和KITTI多對(duì)象跟蹤和分段(MOTS)。

論文中在多個(gè)流行的基準(zhǔn)數(shù)據(jù)集上測(cè)試了ViP-DeepLab,包括Cityscapes-VPS,KITTI深度預(yù)測(cè)和KITTI多對(duì)象跟蹤和分段(MOTS)。

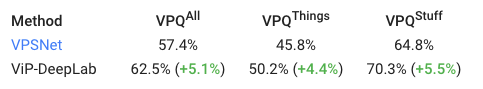

ViP-DeepLab都取得了SOTA的結(jié)果,在Cityscapes-VPS測(cè)試上,其視頻全景質(zhì)量(VPQ)大大優(yōu)于以前的方法,達(dá)到了5.1%。

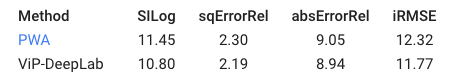

在KITTI深度預(yù)測(cè)基準(zhǔn)上進(jìn)行單眼深度估計(jì)的比較,對(duì)于深度估算指標(biāo),值越小,性能越好。盡管差異可能看起來(lái)很小,但在此基準(zhǔn)上性能最高的方法通常在SILog中的間隙小于0.1。

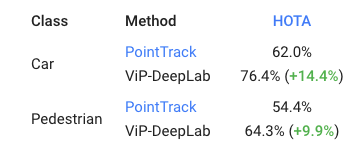

此外,VIP-DeepLab也在KITTI MOTS行人和汽車排名度量使用新的度量標(biāo)準(zhǔn)HOTA,都取得了顯著提升。

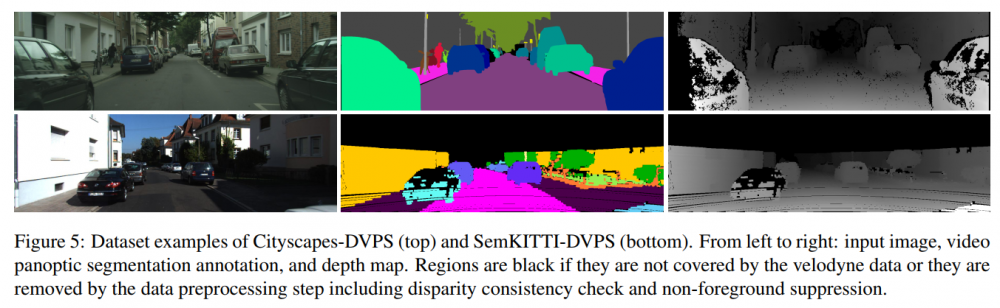

最后,論文中還為新任務(wù)提供了兩個(gè)新的數(shù)據(jù)集,即深度感知視頻全景分割,并在其上測(cè)試了ViP-DeepLab,而這個(gè)模型的結(jié)果將成為社區(qū)進(jìn)行比較的基準(zhǔn)模型。

ViP-DeepLab具有簡(jiǎn)單的體系結(jié)構(gòu),可在視頻全景分割,單目深度估計(jì)以及多對(duì)象跟蹤和分割方面實(shí)現(xiàn)最先進(jìn)的性能,這個(gè)模型也能幫助進(jìn)一步研究對(duì)2D場(chǎng)景中的真實(shí)世界。

參考資料:

https://ai.googleblog.com/2021/04/holistic-video-scene-understanding-with.html

*博客內(nèi)容為網(wǎng)友個(gè)人發(fā)布,僅代表博主個(gè)人觀點(diǎn),如有侵權(quán)請(qǐng)聯(lián)系工作人員刪除。