讓機器人真正去“看見”世界還有多難?

很快,我們可能就會在某些地方看到機器人,但實際上,短期內我們不會看到機器人穿行于街道,也不會看到它們游走在辦公室。一個重要的原因就是機器人至今無法真正“看見”世界,在談論機器人未來如何看見世界前,我們先要討論一下“看見”的真正意思。

本文引用地址:http://www.104case.com/article/284895.htm

“我看見你”

大多數人有兩只眼睛,它用來收集物體反射的光線。眼睛將光線轉化為電信號,傳送到視神經,大腦瞬間對信號進行處理。根據電脈沖和人的體驗,大腦判斷我們身邊的物體是什么。它向我們呈現世界的模樣,我們用它來導航,來撿起東西,用它來看見別人的臉,做其它無數的事。

研究人員發現,大腦最多會有50%參與到視覺處理中去。幾乎世界上所有的動物都有眼睛,都能以某種方式觀看。大多動物(尤其是昆蟲)的大腦比人簡單得多,但它們的視覺功能很好。

這說明一個事實:即使沒有人腦一樣強大的運算能力,以其它形式 “看見”仍然是可以的。在進化的過程中,“看”能力的出現無疑是一個重要的里程碑。

機器人視覺

許多機器人研究者預測,如果機器人能“看見”,它就可以迅速普及并最終成為人類的幫手,這恰恰是許多人期待的。

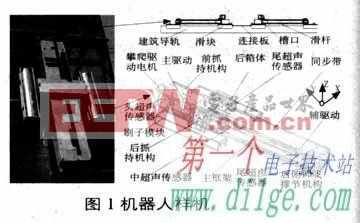

自從20世紀70年以來,機器人視覺工程師就一直在研究圖像的特點,比如說角落和紋理可能就是線或者有趣的點。于是工程師編寫算法去找到這些特征,從視頻一幀一幀的圖像中去追蹤它。

一張圖片有幾千萬像素,采用這種方法可以將海量的數據大幅削減,只需要掌握幾百或者幾千個特征就行了。

不久之前,計算能力還受到限制,現在有了很大的進步。工程師們開始思考機器人到底想看見什么,想做什么。他們編寫軟件建立識別世界的模式,幫助機器人理解它身邊的一切。

本地環境

當機器人運行時,軟件可能會為環境建立基本模式,它可能會將自己找到的特征和特征庫匹配,最終找到自己想要的。

遺憾的是這樣的系統仍然不太可靠,它無法防止機器人碰撞,無法投入到實際使用中去。最近媒體談論的無人駕駛汽車就是用激光或者雷達來補充視覺系統的。

在過去5到10年里,一個新的機器人視覺研究社區開始形成。研究人員沒有采用編程的方法展開研究,而是要讓機器人學會如何自己觀看。

他們開發了機器人視覺系統,其架構構思來自于科學家對動物視覺的認識。他們使用了一個名叫“神經元層”的概念,它和動物的大腦相似。工程師為系統架構編程,但沒有開發運行系統的算法。算法交給機器人自己去解決。

這門技術就是所謂的“機器學習”,我們現在只要用付出合理的成本就能得到強大的計算力,正因如此“機器學習”技術才開始變得流行起來。大家對這門技術的投資正在加速。

分散學習

機器學習之所以重要,首先是因為它可以讓機器人輕易分享學習成果。機器人沒有必要像新生動物一樣從頭學起,將其它機器人的學習體驗植入到新機器人中就可以了,在此基礎上再提高。

某個機器人也許學會了觀察貓,知道它是什么樣的,它可以將自己的認知傳授給其它機器人。例如,可以讓一千個機器人觀察不同的貓,彼此通過互聯網分享數據,一起學習如何給所有貓分類。這就是分散學習的好例子。

實際上,未來的機器人分享、分散學習會造成深遠的影響,它嚇壞了一些人,也讓一些人興奮。

很可能你的信用卡現在正在被數據中心自動學習機器調查,它想看看你是不是騙子。系統可以發現人類發現不了的蛛絲馬跡。此時,蜂群思維被用來做好事。蜂群思維是一種集體思維,是指由許多獨立的單元高度連接而成的一個活系統。

真正的機器人進化

機器人的應用范圍廣闊,在我們的生活中幾乎沒有它不可以幫上忙的地方。它首先可能會用在勞動力短缺的行業,如建筑業,或者是天生就不討人喜歡的行業,如危險行業。它還可以用于災后搜救,可以將人撤離危險場所,或者用在受到限制、人難以進入的空間。

人很難保持長時間的注意力,在一些需要長時間保持高度注意力的地方,機器人可以派上用場。如果機器人可以看見我們,未來家庭式機器人伙伴將大有用武之地。

在手術室,會觀看的機器人能成為助理外科醫生。機器人擁有超級視力,操作超級精準,手臂和手掌穩定,外科醫生只要做好決策就行了。

當機器人醫生的蜂群思維形成,人的決策能力也可能被替代。機器人將可以完全代表人做手術。

評論