2019深度學習語音合成指南

Parallel WaveNet:快速高保真語音合成

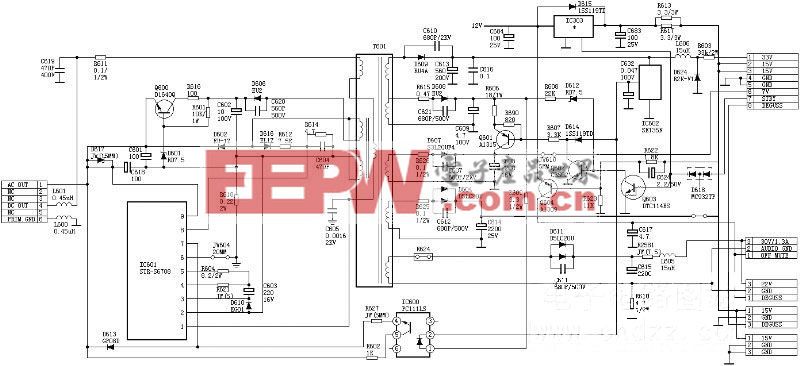

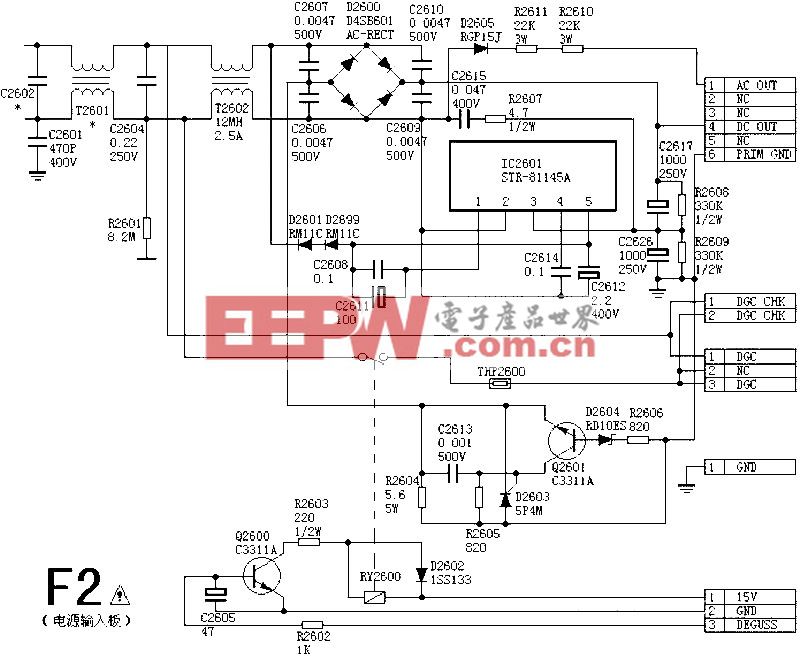

本文引用地址:http://www.104case.com/article/201909/404379.htm這篇文章的作者來自谷歌。他們引入了一種叫做概率密度蒸餾的方法,它從一個訓練過的WaveNet中訓練一個并行前饋網絡。該方法是通過結合逆自回歸流(IAFS)和波形網(WaveNet)的最佳特征構建的。這些特征代表了WaveNet的有效訓練和IAF網絡的有效采樣。

文章鏈接:https://arxiv.org/abs/1711.10433

為了進行有效訓練,作者使用一個已經訓練過的WaveNet作為“老師”,并行WaveNet‘學生’向其學習。目的是為了讓學生從老師那里學到的分布中匹配自己樣本的概率。

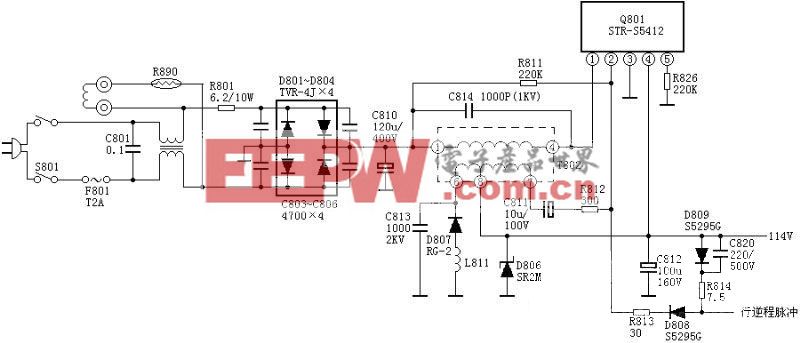

圖18

作者還提出了額外的損失函數,以指導學生生成高質量的音頻流:

●功率損失函數:確保使用語音不同頻帶的功率,就像人在說話一樣。

●感知損失函數:針對這種損失函數,作者嘗試了特征重構損失函數(分類器中特征圖之間的歐氏距離)和風格損失函數(Gram矩陣之間的歐氏距離)。他們發現風格損失函數會產生更好的效果。

●無論條件向量如何,對比度損失會懲罰有高可能性的波形。

下圖顯示了這個模型的性能:

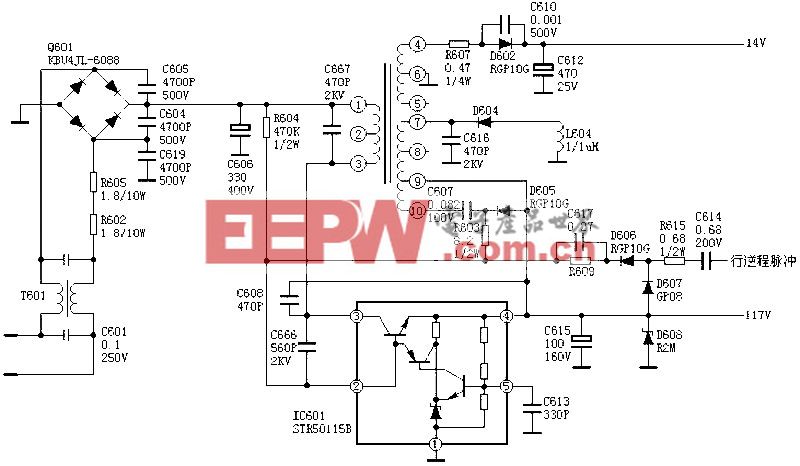

圖19

利用小樣本的神經網絡語音克隆

據雷鋒網了解,這篇文章的作者來自百度研究院。他們引入了一個神經語音克隆系統,它可以通過學習從少量音頻樣本合成一個人的聲音。

系統使用的兩種方法是說話人自適應和說話人編碼。說話人自適應是通過對多個說話人的聲音生成模型進行微調來實現的,而說話人編碼則是通過訓練一個單獨的模型來直接推斷一個新的嵌入到多個說話人語音生成模型。

文章鏈接:https://arxiv.org/abs/1802.06006v3

本文采用Deep Voice 3作為多說話人模型的基線。所謂聲音克隆,即提取一個說話人的聲音特征,并根據這些特征來生成給定的文本所對應的音頻。

生成音頻的性能指標決定于語音的自然度和說話人聲音的相似度。作者提出了一種說話人編碼方法,該方法能夠從未曾見過的說話人音頻樣本中預測說話人聲音嵌入。

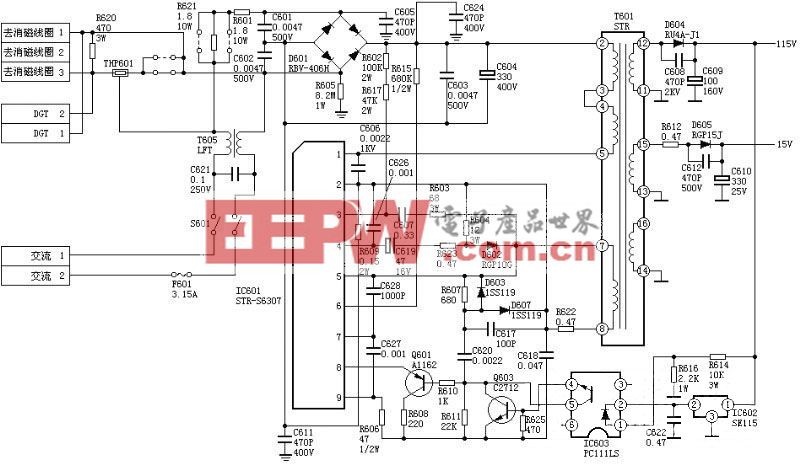

圖20

下面是聲音克隆的性能:

圖21

圖22

VoiceLoop:通過語音循環進行語音擬合與合成

這篇文章的作者來自Facebook AI研究院。他們引入了一種神經文本到語音(TTS)技術,可以將文本從野外采集的聲音轉換為語音。

文章鏈接:https://arxiv.org/abs/1707.06588

VoiceLoop的靈感來源于一種稱為語音循環的工作記憶模型,它能在短時間內保存語言信息。它由兩部分組成,其一是一個不斷被替換的語音存儲(phonological store),其二是一個在語音存儲中保持長期表達(longer-term representations)的預演過程。

Voiceloop將移動緩沖區視作矩陣,從而來構造語音存儲。句子表示為音素列表。然后從每個音素解碼一個短向量。通過對音素的編碼進行加權并在每個時間點對它們求和來生成當前的上下文向量。

使VoiceLoop脫穎而出的一些屬性包括:使用內存緩沖區而不是傳統的RNN,所有進程之間的內存共享,以及使用淺層、全連接的網絡進行所有計算。

圖23

下圖顯示了模型與其他替代方案相比的性能表現。

圖24

圖25

利用梅爾圖譜預測上的條件WaveNet進行自然TTS合成

作者來自谷歌和加州大學伯克利分校。他們引入了Tacotron 2,這是一種用于文本語音合成的神經網絡架構。

文章鏈接:https://arxiv.org/abs/1712.05884

它由一個循環的的序列到序列特征預測網絡組成,該網絡將字符嵌入到梅爾標度圖譜中。然后是一個修改后的WaveNet模型,這個模型充當聲碼器,利用頻譜圖來合成時域波。模型的平均意見評分(MOS)為4.53分。

圖26

這個模型結合了Tacconon和WaveNet的最佳特點。下面是它與其他模型的性能對比:

圖27

雷鋒網小結

現在的語音合成技術發展很快,我們希望能夠盡快追趕上最前沿的研究。以上這幾篇文章是當前語音合成領域最重要的進展代表,論文、以及其代碼實現都可在網上找到,期待你能去下載下來進行測試,并能夠獲得期望的結果。

讓我們一起創造一個豐富多彩的語音世界。

原文鏈接:https://heartbeat.fritz.ai/a-2019-guide-to-speech-synthesis-with-deep-learning-630afcafb9dd

本文轉自雷鋒網,如需轉載請至雷鋒網官網申請授權。

原文章地址為2019深度學習語音合成指南

評論