Meta 可以通過腦電波猜測你聽到了什么

新的人工智能可以僅僅通過大腦測量猜測出正確的、被測者正在想象的單詞。

Meta 的研究科學家讓-雷米·金 (Jean-Rémi King) 告訴《時代》雜志,有許多不好的因素會剝奪某人的說話能力——對這些受到影響的人來說,腦機接口可能是恢復溝通的關鍵。

“通過在患者大腦的運動區域放置一個電極,我們可以解碼活動并幫助患者與世界其他地方交流,”King 說。

大腦植入物使用這樣的方法恢復癱瘓患者的交流能力:神經植入物不需要指向單個字母或單詞,而是將他的想法直接轉化為單詞。

患有 ALS 的澳大利亞人 Phiip O'Keefe 擁有一個腦機接口芯片,可以讓他將自己的想法轉化為文本,從而打開了包括Twitter在內的整個電子通信世界。此外,一名 ALS 進展為完全閉鎖綜合征的患者也接受了一種允許交流的植入物。

Meta 的研究人員正在構建用于在大腦中解碼語音的 AI 模型。

“但是將電極放入某人的大腦中顯然是極具侵入性的。” King 說。

(在 O'Keefe 的案例中,值得注意的是,植入物是通過他的頸靜脈進入的,因此他不需要進行開顱手術,盡管這是一項重大手術。)

“所以我們想嘗試使用非侵入性的大腦活動記錄。最終目標是建立一個人工智能系統,可以解碼大腦對口述內容的反應。”

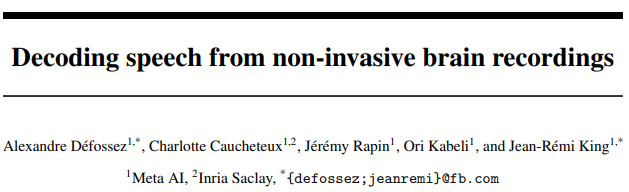

Facebook 人工智能研究 (FAIR) 實驗室的 King 和他的同事已經開始這樣做,他們創造了一種深度學習 AI,能夠在一定程度上從腦電波中解碼語音。

King 在Meta AI 的博客中寫道,在他們目前作為預印本在線的研究中,該團隊使用了之前在 FAIR 創建的開源算法來分析已經存在的數據集。

這些數據集包含 169 名健康志愿者在聽荷蘭語和英語有聲讀物時的大腦記錄,累積超過 150 小時。

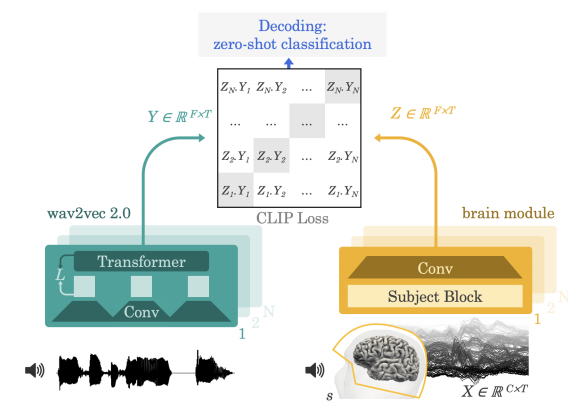

由于目標是非侵入性地解碼語音,因此該團隊使用通過測量大腦的電活動(腦電圖或 EEG)和磁活動(稱為腦磁圖或 MEG)記錄的數據。

兩者都是通過頭骨外部的傳感器記錄的,這構成了研究人員的主要挑戰之一,King 告訴時代周刊:數據的“嘈雜”程度受限于傳感器與大腦的距離,以及皮膚、頭骨、水等的影響,會導致信號質量降低。所有這些噪音都變得更加難以消除,因此我們不能 100% 確定我們在尋找什么。

“另一個大問題更具概念性,因為我們實際上在很大程度上不知道大腦如何代表語言。”King 說。

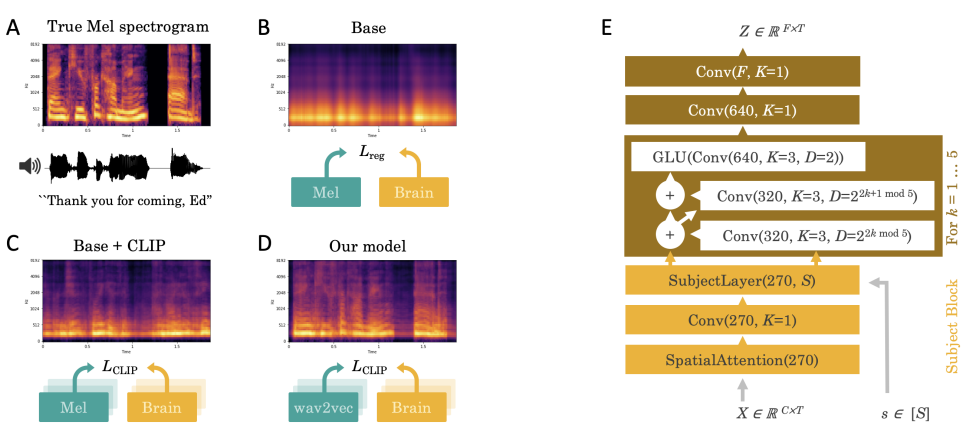

人工智能使用有聲讀物和大腦錄音,分析它們以研究聽到的單詞和腦電波之間的工作模式。

這就是團隊想要外包給人工智能的解碼語音的問題,因為它通過一個動作來預測大腦活動——這將決定,在這種情況下,一個對象會聽到什么。

如果沒有人工智能,“事情將很難說,‘好吧,這個大腦活動意味著這個詞,這個音素,或者一個行動的意圖,或者其他什么。’”King 說。

解碼語音:將這些時間分成三秒位后,他們將有聲讀物和大腦錄音提供給人工智能,人工智能對其進行分析,嘗試發現模式。

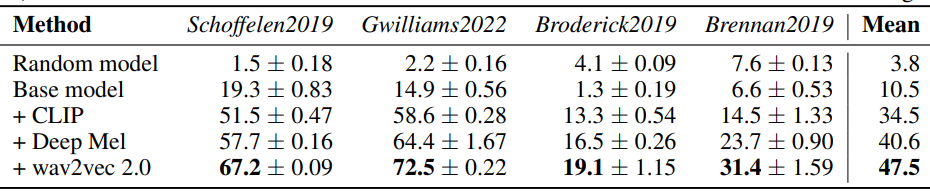

據《新科學家》報道,該團隊保留了 10% 的數據來測試他們的模型:使用從其他 90% 中學習到的模式來嘗試識別它從未見過的大腦記錄中聽到的單詞。

“經過訓練,我們的系統執行所謂的零樣本分類:給定一個大腦活動片段,它可以從大量新音頻片段中確定這個人實際聽到的是哪個片段。”King 在 Meta 博客中寫道。“算法基于這種設計推斷出這個人最有可能聽到的詞。”

具體來說,據《新科學家》報道,人工智能依靠其 793 個單詞的詞匯表來制作十個單詞列表,以粗略地解碼語音。

根據他們的預印本,當使用三秒的 MEG 數據時,人工智能能夠在 72.5% 的時間內在前十名中得到正確的詞——在 44% 的測試中首先猜到它——而在 EEG 數據中則為 19.1%。

人工智能能夠在高達 72.5% 的測試中提供包含正確單詞的答案列表。

不過,倫敦帝國理工學院教授 Thomas Knopfel 告訴《新科學家》,該系統需要更多改進才能真正用于語音解碼,并且懷疑 EEG 和 MEG(非侵入性方案)能否提供更準確所需的精細細節.

“這是關于信息流的。”Knopfel 告訴《新科學家》。“這就像試圖通過老式模擬電話調制解調器播放高清電影。即使在理想的條件下,有人戴著耳機坐在黑暗的房間里,只是在聽音頻,大腦中也會同時發生其他事情。在現實世界中,腦海中只有一個想法獨立地發生完全不可能。”

然而,技術進步可能會改變這一點:一種稱為OPM的新型 MEG正在推動可以從外部學習的范圍。

就他而言,King 告訴《時代》雜志,他們目前只對語音進行解碼,以講述人們在掃描儀中聽到的內容。它還不是用于設計產品,而只是作為基礎研究和原理證明。

來源:中國信息通信研究院知識產權中心

*博客內容為網友個人發布,僅代表博主個人觀點,如有侵權請聯系工作人員刪除。