微軟多語言預訓練模型T-ULRv2登頂XTREME排行榜

編者按:為進一步實現用 AI 賦能用戶體驗,微軟正在不斷拓展多語言模型的邊界。近日,由微軟圖靈團隊與微軟亞洲研究院聯合探索的最新跨語言研究成果——多語言預訓練模型 T-ULRv2,登頂 XTREME 排行榜,T-ULRv2 可以在相同向量空間表示和理解94種語言,提升所有語言的產品體驗。本文編譯自微軟亞洲研究院副院長周明和微軟副總裁、杰出工程師 Saurabh Tiwary 共同發表的微軟研究院博客文章 “Microsoft Turing Universal Language Representation model, T-ULRv2, tops XTREME leaderboard”。

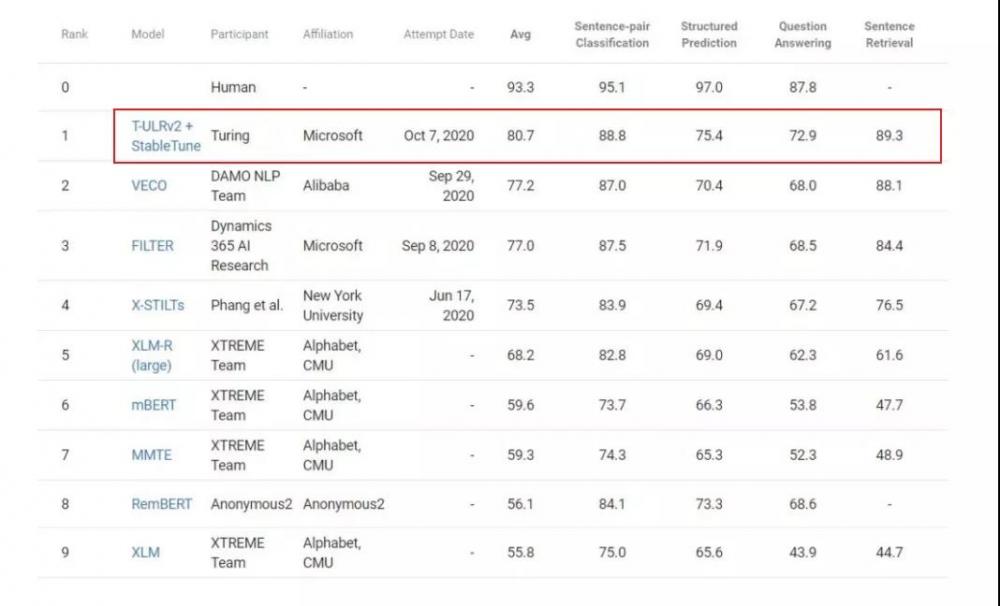

近日,由微軟圖靈團隊與微軟亞洲研究院聯合開發的圖靈多語言預訓練模型 T-ULRv2 榮膺 XTREME 公共排行榜冠軍,該模型比之前最好的模型 VECO 有了3.5的平均分提升。在此次突破中,除了預訓練的模型外,微軟的研究員們還提出了一種基于穩定性訓練的新型多語言微調技術 StableTune。入圍本次排行榜的其他模型還包括:XLM-R、mBERT 和 XLM 等。此前的最好模型 FILTER 也是由微軟團隊提交的。

多語言預訓練模型T-ULRv2:支持94種語言

長期以來,微軟圖靈團隊堅信文本的語義表示是語言無關的。在2018年發表的論文 Towards Language Agnostic Universal Representations中(https://www.microsoft.com/en-us/research/publication/towards-language-agnostic-universal-representations/),微軟的研究員們提出了一種方法,以無監督方式訓練語言無關的語義表示。此方法可以讓經過訓練的模型在針對某一個語言加以微調后,立即應用于另一個語言。以往針對每個語言進行模型訓練都要求具備該語言的標注數據,而此方法有效地解決了這一難題。無監督的預訓練語言模型已成為所有 NLP 模型的基礎,基于 Transformer 的模型則是所有此類創新的核心。

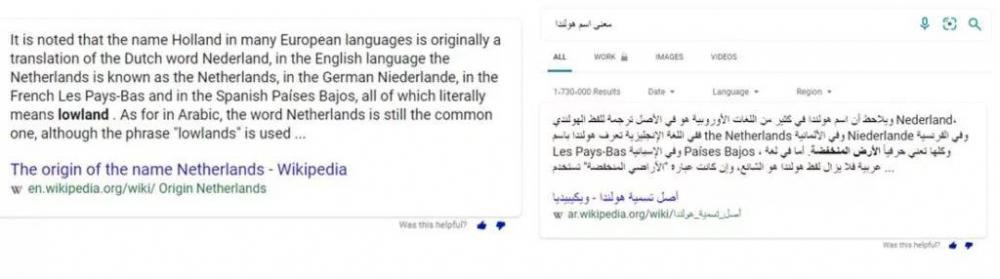

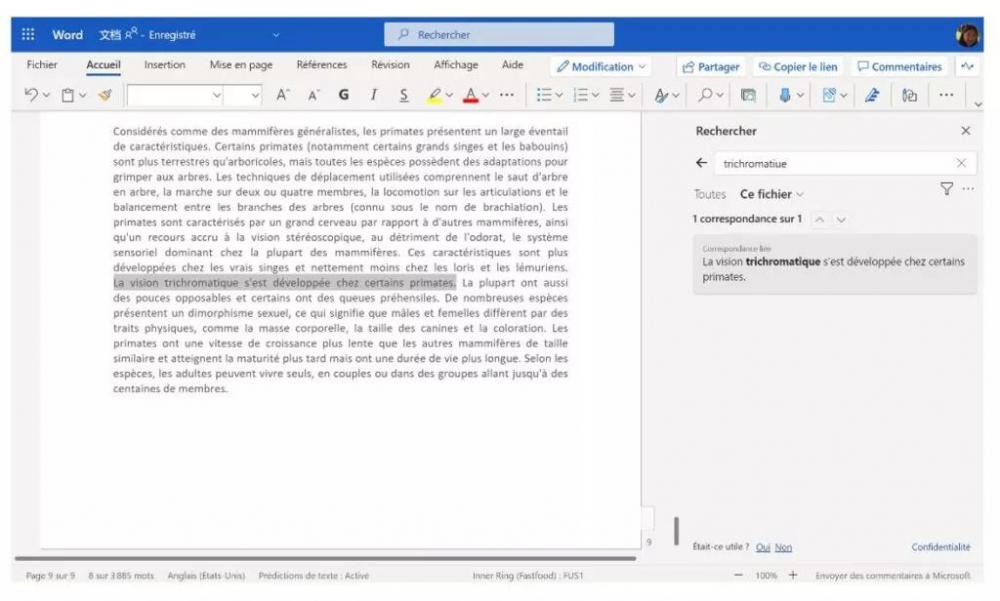

作為微軟 AI at Scale(AI 規模化)研發的重要組成部分之一,圖靈系列的 NLP 模型一直在為微軟產品的下一代 AI 體驗提供原動力。T-ULRv2 是跨語言研究的最新成果,它融合了微軟亞洲研究院近期在 InfoXLM 論文(點擊閱讀原文,了解論文詳情)中的創新,其所開發的多語言預訓練模型可以用于94種語言的文本的自然語言理解任務。通過 T-ULR 可以將微軟必應的智能問題解答服務擴展到所有受支持的語言和地區。而且這個模型還被用于將 Word 語義搜索功能擴展到英語之外的語言,并且實現對微軟 Outlook 和微軟 Teams 中“建議答復”功能地普遍支持。這些功能的體驗將會很快與用戶見面。

由 T-ULR 驅動的西班牙文及阿拉伯文版微軟必應智能問題解答示例

由 T-ULR 驅動的法文版微軟 Word 語義搜索示例

這些真實的產品場景對算法質量的要求極高,因此也為研究員們的 AI 模型提供了理想的測試平臺。根據結果顯示,T-ULR 在多語言 NLP 任務中的準確率和性能都達到了非常可觀的效果。

XTREME基準數據集

多語言編碼器的跨語言遷移能力評估 XTREME 基準涵蓋了橫跨12個語系的40種語言,其中包含的9項任務都需要對不同層級的語法或語義進行推理。XTREME 中的語言選擇旨在最大程度地提高語言多樣性、覆蓋現有的任務范圍,并考慮到訓練數據的可用性。

XTREME 中包含的任務涵蓋了包括語句文本分類、結構化預測、語句檢索和跨語言問答等自然語言處理任務。因此,為了成功完成 XTREME 基準測試,模型必須學會可以跨語言遷移的表示。

有關基準測試和任務的完整說明,請參見《XTREME:A Massively Multilingual Multi-task Benchmark for Evaluating Cross-lingual Generalization》(https://arxiv.org/abs/2003.11080) 。

T-ULRv2預訓練的“鐵人三項”:MMLM、TLM和XLCo

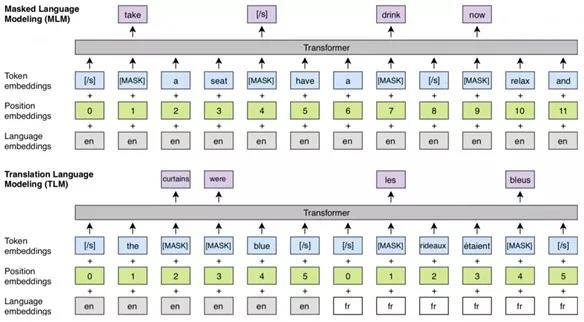

T-ULRv2 采用的是24層的 Transformer 架構,參數總量多達5.5億個。T-ULRv2 預訓練要完成三項不同的任務:多語言掩碼語言模型(MMLM)、翻譯語言模型(TLM)和微軟研究團隊提出的跨語言對比學習(XLCo)。MMLM 任務(也稱為完形填空任務)的目標是根據輸入的不同語言信息預測出被遮蔽的字符。T-ULRv2 使用了來自網絡的多語言數據語料庫,該語料庫由94種語言組成,用于 MMLM 任務訓練。

與 MMLM 相似,TLM 任務也是預測被遮蔽的字符,但該預測是針對拼接在一起的的平行句對。例如,給定一對英語和法語的平行句子,模型可以通過觀察被遮蔽英語字符周邊的英語字符或者它的法語翻譯版來預測這個被遮蔽的英語字符。它能夠幫助模型“對齊”不同語言的表示。

遮蔽語言建模(MLM)的跨語言預訓練以及 TLM 任務(來源:XLM)

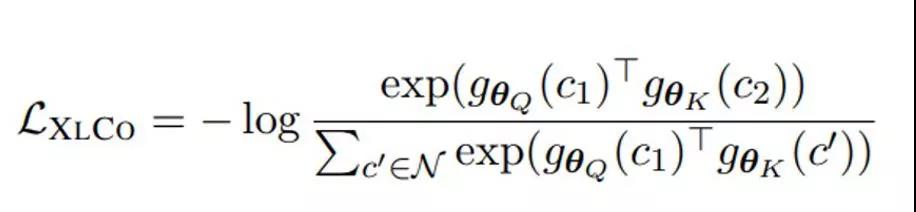

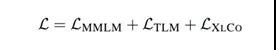

XLCo 任務則可以使用平行訓練數據,其目的是讓平行句子表示之間的互信息最大化。MMLM 和 TLM 的目標是使字符-序列互信息最大化,而 XLCo 的目標是序列級別的跨語言互信息最大化。對于 TLM 和 XLCo 任務,T-ULRv2 會用到含有14個語言對的平行數據。XLCo 的損失函數如下:

隨后,它將計入 MMLM 和 TLM 的損失,得出跨語言預訓練的總體損失:

有關 T-ULRv2 的更多信息,請參見論文《InfoXLM: An Information-Theoretic Framework for Cross-Lingual Language Model Pre-Training》(https://arxiv.org/abs/2007.07834) 。

構建定制化應用:T-ULRv2將發揮重要作用

在微軟 Ignite 2020 大會上,微軟宣布圖靈模型將作為私人預覽的一部分,用于構建定制化應用,而 T-ULRv2 也將成為該計劃的一部分。目前,研究團隊正在與微軟 Azure 認知服務部門緊密合作,為當前及未來帶有圖靈模型的語言服務提供支持。微軟 Azure 認知服務的現有客戶將通過 API 自動享受這些升級服務。

AI體驗普及化:以改善所有語言的產品體驗為先

微軟認為,全球化發展不僅僅是個研究課題,也是一項必須直面的挑戰。目前 Windows 在全世界范圍內被使用,微軟 Office 和微軟必應也已在200個地區使用,且提供了超過100個語言版本。微軟的客戶遍及全球每個角落,他們都在以各自的母語使用著微軟的產品。當下,微軟的研究員們正在積極地拓展多語言模型的邊界,像類似于 T-ULRv2 這樣無語言差異的表示便是拓展之路上的又一次突破。它將可以提升所有語言的產品體驗,賦能所有用戶,真正實現 AI 體驗的普及化。

*博客內容為網友個人發布,僅代表博主個人觀點,如有侵權請聯系工作人員刪除。