“AI觸覺”使靈巧手及電子皮膚更敏感

觸覺是機器人感知世界的一種非常重要的方式。觸覺傳感器技術正不斷進步,從傳統的壓阻式、壓電式到如今的柔性觸覺傳感器、電子皮膚等,技術迭代速度不斷加快。

其中,AI觸覺傳感器以及模型的構建對于提升機器人的交互能力和環境適應性至關重要。借助這些技術,他山科技已嘗試讓靈巧手抓取豆腐和薯片等柔性物品。近日,公司市場與生態副總裁付宜暉在“2025中國人形機器人生態大會”上介紹了“AI觸覺傳感器及模型構建”。

1 第二大傳感器市場——觸覺

據VMR 的調研,2021年全球觸覺傳感器市場已超過112.5億美元,2028年將達到260.8億美元的市場容量。值得一提的是,VRM當年做這個統計時,人形機器人市場還沒有爆發。

實際上,人形機的靈巧手是其核心零部件之一,其中觸覺又是靈巧手的核心能力之一,因此觸覺舉足輕重,或許會成為除了視覺以外的人形機器人的第二大感官,這無疑給觸覺傳感器賽道帶來了一波新的動能。

目前這波人形機器人的增長浪潮主要得益于AI大模型的賦能,因為人形機器人剛好是具身智能的最佳載體,所以催化了人形機器人行業的崛起。

2 觸覺的重要性

2024年網上很火的一個視頻是斯坦福ALOHA團隊做的家務靈巧手的抓取視頻。然而,在實際抓取和執行任務中還有很多問題尚待解決。例如雖然有AI大模型的加持,但是當時更多的是通過視覺去解決觸覺問題的。

失去觸覺會怎樣?人類有一種罕見病是喪失了觸覺能力,這種患者抓取物品時,更多的是依賴視覺去做行為判斷,因此抓取柔性物品時容易把柔性易碎的物品抓壞;同時為了有更多的容錯,患者也會把手張得很大去抓取。

可見,無論對于人還是具身機器人,觸覺感知都是非常重要的。

3 觸覺感知的痛點

首先是高度適應性算法的缺失。觸覺和視覺不同,視覺底層是基于相應的色度和亮度來組成數據的。觸覺的數據是多維的,例如人去抓取物品的時候,先去判斷是冷是熱,是干性還是油性的,同時有相應的觸覺、壓覺、滑覺等一系列觸覺維度,需要把這種多維觸覺解析出來。

另外還需要底層的硬件來做支撐。底層硬件是否能做到高精度的測量?同時能滿足低延時、低功耗的需求?

再有,觸覺是分布式的,就像人類全身都有觸覺。對于機器人,目前至少靈巧手的5 個指尖有觸覺,此外還有指腹及手掌,這時會涉及多個觸覺傳感單元之間的協同感知與協同控制。為什么這會成為一個重點或痛點?如果拿單獨的一個觸覺傳感單元去摸,就會像盲人摸象一樣片面。因此還要判斷其冷熱和材質等,即判斷一系列物理量的變化。

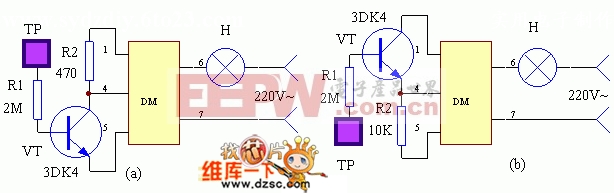

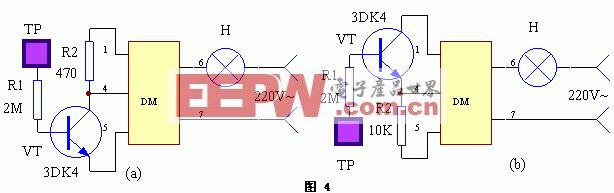

4 整體觸覺傳感器的結構

遺憾的是,市面上還沒有這種高度集成化、標準化的解決方案。

整體觸覺傳感器可拆分成幾部分,首先是五指靈巧手的指尖,還希望能去做相應任務的執行,因此會涉及感知及控制一體的效果。核心原因是什么?就像人去抓一杯很燙的水,這時人為了保護自己,會下意識地松開手。對于機器觸覺,也希望在邊緣端解決這類問題。

除了指尖以外,還有指腹及手掌,因此會要求有一定的空間分辨力。因為在抓取物品的時候,人可能是通過手掌來更多地判斷這個物品有沒有碰到,或者碰到了哪個位置。

另外,機械臂(大小臂或大小腿)往往需要做防碰撞檢測,以便在未來人機交互等場景下有安全性保證。

對于軀干,在具身本體中會涉及人機交互及環境感知的能力,就會要求觸覺傳感器有較好的一致性,無論是單獨觸覺傳感器的相應數據的一致性,還是不同批次傳感器的一致性,這是保證底層數據可用、可去建立模型的基礎,同時還有魯棒性、穩定性及耐久力。

5 觸覺是場景“泛化”的關鍵支撐

為什么現在觸覺更重要?在最早的工業產線中,較少提到觸覺的原因是由于工業產線中完成的更多的是既定目標,所有的任務目標、運動控制及相應的力都是提前預設好的。但是在具身或人形機器人方面,2024年業界提得最多的一個詞是“泛化”,即如何在不同的應用中,能泛化地去做場景的閉環。

對于觸覺系統,人們把觸覺的執行分成了三個部分——抓取、移動和遞交,來支撐不同場景的泛化能力的閉環。

● 抓取。在抓到物品時,可以把一系列的觸覺維度信號去解析,例如接觸覺、壓覺、滑覺、溫濕覺、力矩覺等,同時在這個過程中實現自適應力的抓取。這里有一個原則是施與目標物體最小的力,使其不產生滑動,就可以判斷是把這個物品抓住了。

例如在抓豆腐時,靈巧手停頓了一下,是因為在這個過程中,靈巧手在判斷這塊豆腐有沒有被抓牢?如果豆腐產生了滑動,這時靈巧手就去調整,以便抓得更緊一些,然后再去做下一步動作。這就是去實現自適應力抓取的過程。

● 移動。在移動和遞交的過程中,例如去端一杯水,或者抓一個柔性的材質,在移動過程中,其重心或形態會時時發生變化。反推觸覺傳感器,就要求能對這種實時三維的力去做相應的感知。在這個過程中體現更多的是實時摩擦力的感知。

所以他山科技的解決方案是對法向力、切向力等做實時的感知,而并非是通過算法反推去實現的。因為通過算法反推,在一些場景下,相應的算法可能會失效。

首先動態抓取屬于靜摩擦力的一個場景。如果是基于一維力傳感器,其實沒有去做相應的運動軌跡和趨勢的判斷,所以感知不到靜摩擦力的變化。例如在倒水過程中,如果基于觸覺傳感器來實現,可以通過自適應力調節去抓得更緊一些。

● 遞交。在遞交過程中,目前大部分人形機器人把物品扔或丟下,核心問題是因為觸覺感知的缺乏。他山科技可以實現實時的對靜摩擦力去做感知和判斷。

在他山科技的演示圖中,在人把物品放下的時候,由于桌面的支持力和靜摩擦力會做相應的抵消,所以這個值上也會有瞬態的變化。這樣就可以實現平穩地把物品放下,或者是在人機交互的場景中,可以把物品去遞交給人。

他山科技在展會上還演示了直接去做物品的泛化抓取和遞交的動作。

6 AI觸覺專用芯片

在觸覺賽道,他山科技有自研的底層芯片——已經開發完成首顆芯片——Ruby并流片。

與市面上常用的面向AI視覺去支撐AI相關的ANN算法不同,他山科技是面向AI 觸覺去支撐SNN(脈沖神經網絡)算法。因SNN 低延時、低功耗,更適用于異步架構的特性。

他山科技的底層芯片是一個數模混合的AI 觸感芯片,有數字端相應的MCU,以及包括模擬端的高精度的信號鏈芯片。核心在于一個CDC,另外有數字、模擬雙流的架構,可以去支撐分區、分級的SNN 的架構,并且基于雙流可以實現級聯,可以做到多個芯片以及觸覺傳感器的大規模部署。

他山科技的芯片出爐時,有專家評價是:是全球首款的數模混合AI觸感芯片,也是第一款基于SNN的分布式類腦產業化應用芯片。

該芯片的核心——模擬芯片部分也做了與國際模擬芯片三大廠的對標,在核心指標中也有超越。

6.1 靈巧手于機械臂

● 接觸類

在面向靈巧手的方向,他山科技提供了幾種觸覺傳感器產品。有單點的觸覺傳感器,以及多點的、點陣的產品。

單點的基于立體結構,有更好的靈敏度及傾向力的感知。

多點是目前商用較多的形態,在實時三維力和切向力的感知基礎上,可以很好地對位置和方向去做判斷。點陣是針對一些客戶對于位置或空間分辨率有訴求的場景,例如面向二指夾爪、三指夾爪、五指靈巧手等末端執行器的需求。

另外,他山科技也做到了多個觸覺單元的協同感知,以便去做一定量的材質識別,或者提高抓取的成功率。

● 非接觸類

他山科技也做了一些非接觸的空間感知的訓練。例如可以通過非接觸來識別相應物體的材質,像塑料或玻璃這種視覺不太容易區分的材質做到了一定程度的有效區分。

在機械臂的場景中,人們更多在意的是人機交互的過程中的安全性防護。他山科技的方案可以實現非接觸式的人體避障。

早期,該方案布設在了某一個關節,現在無論是機械臂的關節,還是整個機械臂,甚至機器人的本體上,他山科技都已經落地了一些應用,可以去提供7~10cm的非接觸/ 防碰撞。

他山科技也做到了多層感知,即使隔著一本書,也能檢測到后面是否有人手,從而去實現相應的人體避障。

6.2 本體/軀干

針對于機器人的本體/ 軀干方面,他山科技更多的是側重大面積點陣的觸覺傳感器,來去提高人形機器人和人機交互過程中的應用。同時會基于柔性材料去適配一些本體需求。

6.3 模型

他山科技一直在做觸覺相關的模型,整體上,它和視覺是非常不同的,有幾個特點。首先,觸覺的數據屬于離散型,而視覺(諸如雙目攝像頭)的兩個攝像頭之間是有一定的相關性的,所以做模型時,會有一些相關性去做支撐。但是觸覺不一樣,是非常離散的——不同的觸覺傳感單元接觸到一些位置的時候,其數據很難找到關聯性。

其次,當人們通過柔性觸覺傳感器去抓一個物品時,屬于柔性對柔性的過程。在采集數據時,會發現每次抓取時,底層的數據值都會發生變化,所以這無疑給模型帶來了較大的挑戰和難度。在這里,他山科技積累了50萬+的針對不同目標物體抓取的數據庫。

他山科技在2024年發表了一篇論文,提到基于不同的觸覺傳感器做了一系列的抓取測試,以及針對底層不同空間分辨率的觸覺傳感器做了一系列的實驗室測試,最終的結論是相應的觸覺傳感器的數據稠密度和它的感知精度并非正相關的關系,會有一個最精密以及最優質的空間分辨率的點,然后來去做相應的這種抓取。

在整個觸覺感知的底層數據的維度,他山科技目前做了一系列標準,也是希望可以跟整個行業一起去建立底層觸覺相關的標準。

另外,他山科技也希望可以推動不同的技術路徑,以及觸覺相關的數據的共享和互通,以便更好地去支撐觸覺維度的模型的建立。

在2024年,他山科技也有幸參與了人形機器人和具身智能的標準制定,參考了自動駕駛的L1到L5,劃分成了G1到G5。

在G1階段,更多的是工廠階段,在G2、G3階段,可以做到日常生活中的任務的執行,G5是未來最終通用的智能化。現在大部分廠商已處于G1~G3的階段,想一步到G5還是有較大的難度。

7 數據混合

在數據融合之前,提倡做相應的數據混合。

如何理解數據混合?當人形機器人通過視覺去獲取一段長任務,然后把長任務拆解成一系列的子任務,通過專有技術去支撐和執行完成每一個相應子任務的閉環。

拆解完之后,由觸覺能力去執行相應的一些能力閉環,然后去支撐任務的發展。其實在這種任務混合/ 數據混合的階段,已經可以較好地去落地一些垂直場景的應用。

除此之外,還有觸覺的空間感知的能力。他山科技也是基于自己底層的針對不同目標的相應的觸覺感知的數據庫,再做數據的合成/ 混合的訓練,包括在模擬仿真環境以及真實環境中的遷移算法的應用。

8 關于他山科技

公司2017年底成立,研發團隊由清華大學和曼徹斯特大學人員組成。先是解決了觸覺算法的問題,方法是把多維的觸覺感知信號解析出來,后面又流了底層的芯片,形成了軟硬件一體的完整的解決方案。

在人形機器人方向,主要是提供觸覺傳感器和電子皮膚。

團隊方面,算法團隊由清華團隊組成,從傳感器到芯片的團隊是由曼大和清華團隊一起做的支撐。

他山科技在2022年芯片成功流片,2023、2024年有較多的機器人相關的投入。公司累計申請了有200多項專利,其中發明專利占80多項,核心的觸覺傳感器相關專利有40多個。

除了傳感器本身,還有模型,他山科技已經在推進觸覺感知模擬仿真的內測,預計在2025 年二季度發布。他山科技的靈巧手的指尖的觸覺傳感器,可以抓取易碎的材質,像雞蛋或者薯片等材質,以及柔性的豆腐。

芯片方向:目前面向具身的芯片已經量產,下一步還有面向車規和家電消費的芯片。

(本文來源于《EEPW》202505)

評論