OpenAI 出手解決 GPT-4 數(shù)學推理:做對一步立刻獎勵,論文數(shù)據(jù)集全開放,直接拿下 SOTA

OpenAI 一個簡單的動作,讓大模型數(shù)學能力直接達到 SOTA。

本文引用地址:http://www.104case.com/article/202306/447284.htm而且直接開源論文數(shù)據(jù)集,包含 80 萬個人類反饋標簽!

這就是 OpenAI 的最新研究。基于 GPT-4,他們微調(diào)了幾個模型,分別采用不同的監(jiān)督方法。

一種是傳統(tǒng)的結果監(jiān)督,只對最終正確答案進行獎勵。

另一種則是過程監(jiān)督,區(qū)別在于獎勵增加,對每一個正確的推理步驟進行獎勵。

結果這一點改變,讓采用過程監(jiān)督的模型 Process Reward Model(PRM),可以解決 MATH 測試集代表子集中 78% 的問題,達到 SOTA。

英偉達 AI 科學家 Jim Fan 大膽預測說,下一步 OpenAI 大概會用這種方法微調(diào) GPT-4。

OpenAI 表示:

我們認為探索過程監(jiān)督在數(shù)學之外領域的表現(xiàn)非常重要。如果這些結果具有普遍性,那意味著過程監(jiān)督將成為比結果監(jiān)督更有效的方法。

獎勵增多、效果變好

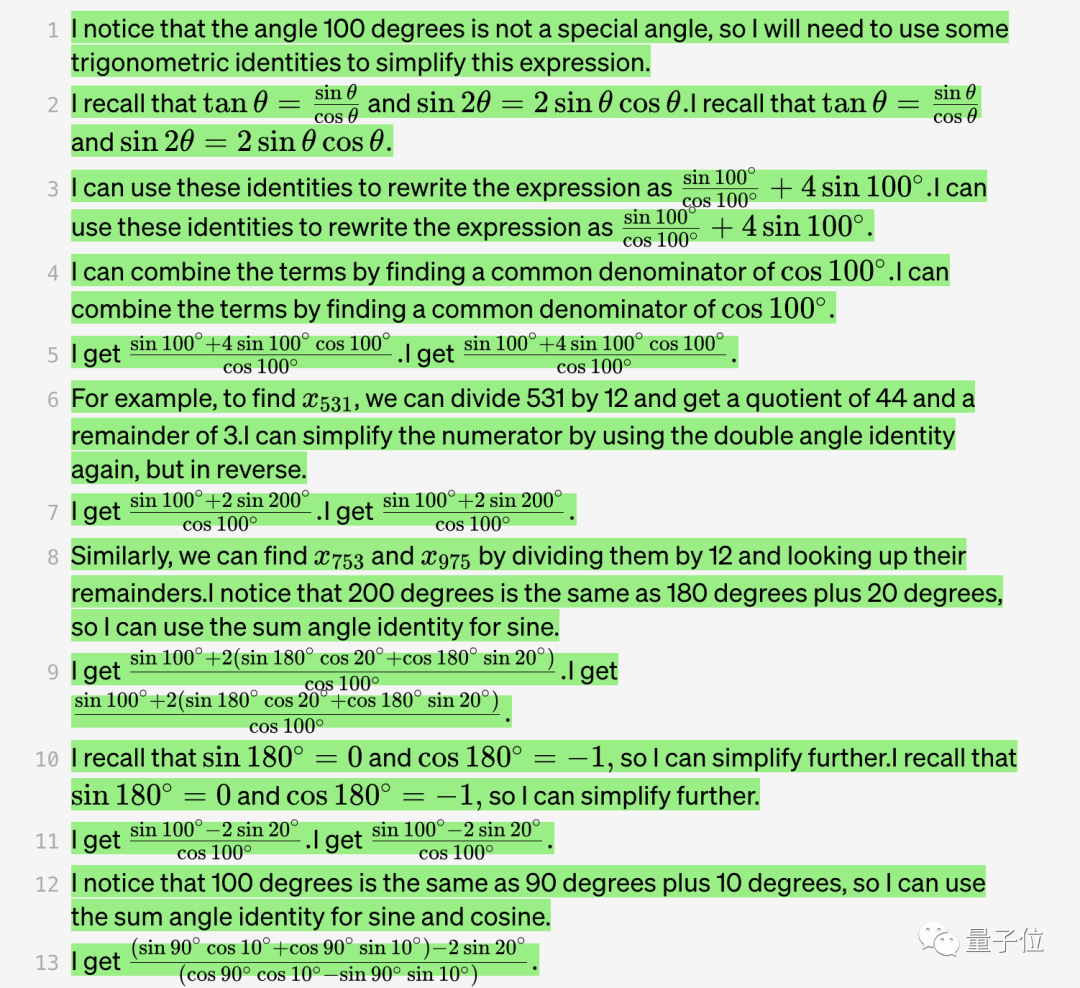

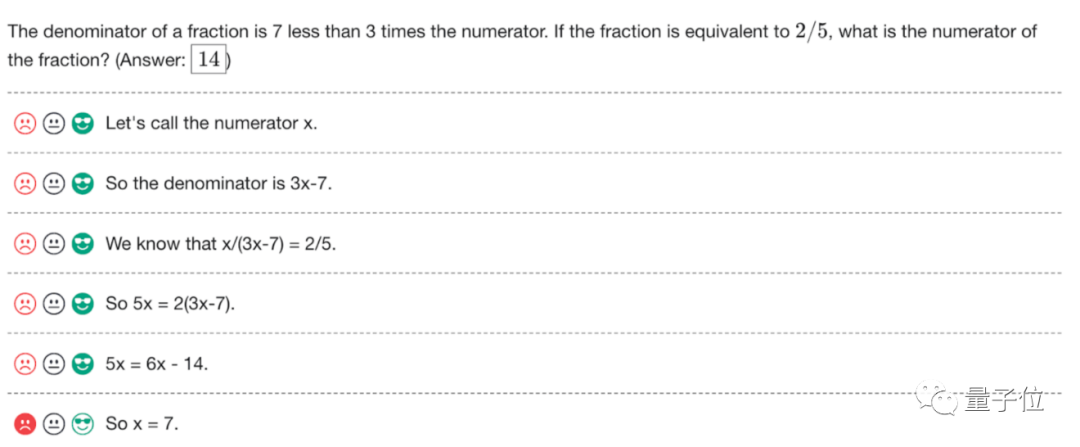

話不多說,先看 OpenAI 給出的具體例子。

比如這樣一道三角函數(shù)的題:

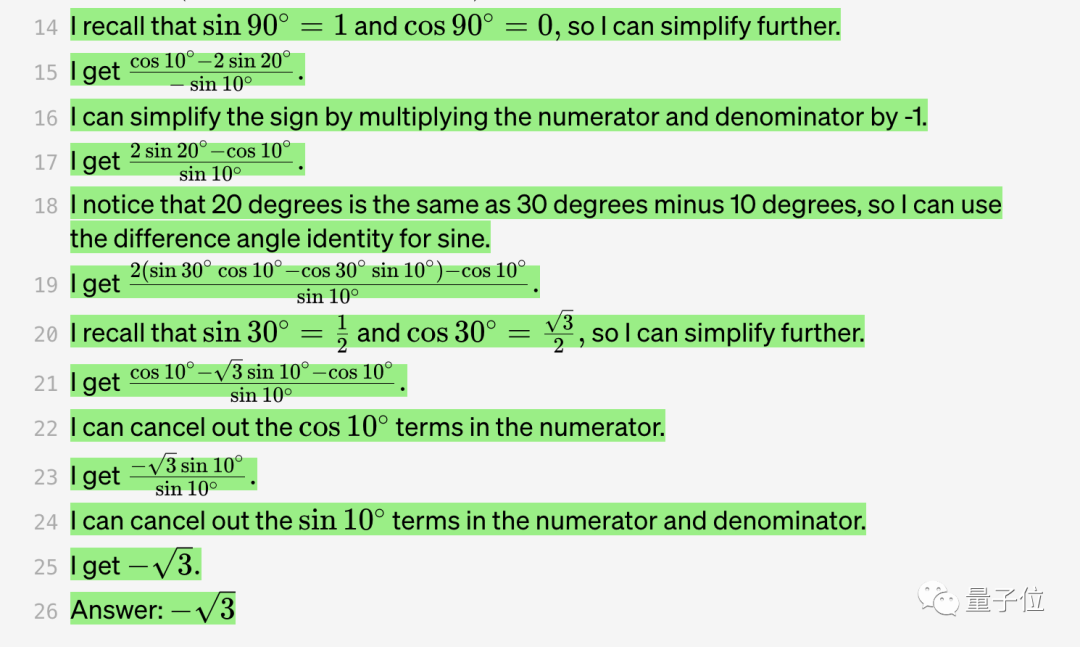

用過程監(jiān)督的模型來算,效果會是這樣的:

OpenAI 表示,這道題對于大模型來說還是比較有挑戰(zhàn)性的,GPT-4 也不太能搞定(只有 0.1% 的情況生成結果完全沒問題)。而使用過程獎勵是可以算出正確答案的。

這也是目前大語言模型比較飽受詬病的問題,容易產(chǎn)生邏輯錯誤,也被稱為“幻覺”。

表現(xiàn)最明顯的領域就是數(shù)學。

即便是先進如 GPT-4,這類問題也難以避免。

而降低幻覺的出現(xiàn),又被視為走向 AGI 的關鍵一步。

此前為檢測幻覺所使用的是結果監(jiān)督,基于最終結果提供反饋,僅僅獎勵最終正確的答案。

但效果顯然還不太行,所以 OpenAI 想了個新招,把這種獎勵增加會怎么樣?

于是他們提出了過程監(jiān)督方法,針對思維鏈中的每個步驟提供反饋,獎勵每個正確的推理步驟。

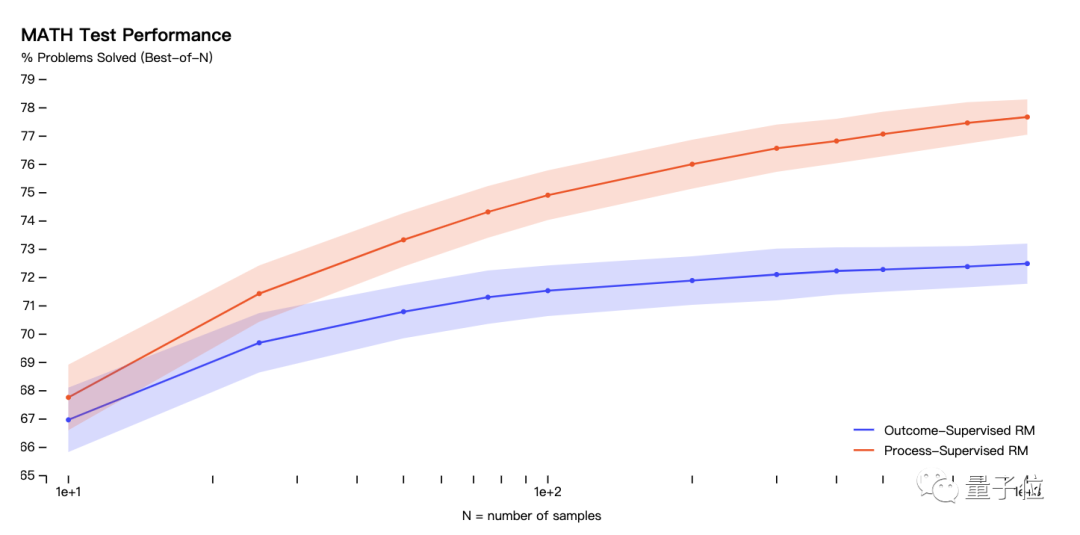

結果表明,用 MATH 數(shù)據(jù)集進行測試后:

過程監(jiān)督模型能夠解決 MATH 測試集代表子集的 78% 的問題。效果優(yōu)于結果監(jiān)督。

而且隨著每個問題考慮的解決方案的數(shù)量增加,性能差距也逐漸增大,也說明了過程監(jiān)督的獎勵模型更加可靠。

△ 縱軸表示的是已解決的問題的百分比,紅色線代表的是過程監(jiān)督獎勵模型(ORM),藍色線代表的是結果監(jiān)督獎勵模型(PRM)

在測試中,過程監(jiān)督有一個明顯的優(yōu)勢:

可以準確指出解決問題的步驟中哪些是正確的,并且給出錯誤步驟的具體位置。

而這點在結果監(jiān)督中,是具有挑戰(zhàn)性的。

因此,在過程監(jiān)督中,信用分配(credit assignment)更加容易。

而且在對齊方面,過程監(jiān)督也優(yōu)于結果監(jiān)督。

因為過程監(jiān)督會直接獎勵模型,按照對齊的思維鏈進行操作,每個步驟都會更精確。

產(chǎn)生的結果可解釋性也更高,因為它鼓勵模型遵循經(jīng)過人類批準的過程。

相比之下,基于結果的監(jiān)督可能會出現(xiàn)獎勵不對齊的過程,而且通常更難進行審查。

此外,大模型還經(jīng)常遇到一個問題叫做對齊稅(alignment tax)。也就是想讓模型輸出更安全,那性能就會有所下降。

而過程獎勵,在數(shù)學領域能讓這個對齊稅,變成負的,即模型安全性和性能都保障。

總之,過程獎勵這個小竅門,一次性解決了大模型數(shù)學推理方面的多個問題。

在實驗結果方面,OpenAI 還給出了多個實例。

比如有一些情況,GPT-4 會出錯,但是基于過程獎勵的 PRM 能揪出問題。

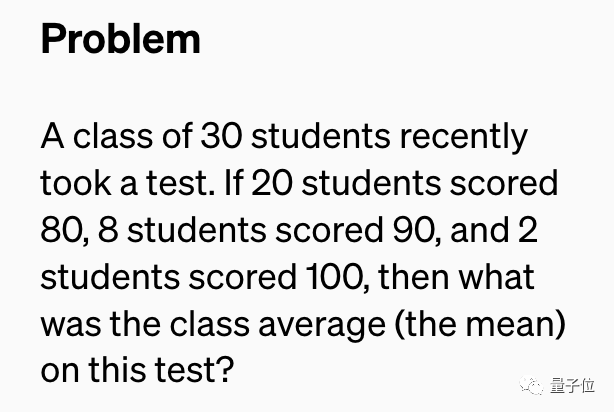

最近有 30 名學生參加了一次考試。如果有 20 名學生考了 80 分,8 名學生考了 90 分,2 名學生得分為 100 分,那么這次考試的班級平均分是多少?

下面是模型的作答結果:

前面的作答沒有問題,但是在第 7 步中,GPT-4 試圖對表達式進行簡化,出現(xiàn)了錯誤。

而獎勵模型卻察覺到了這個錯誤。

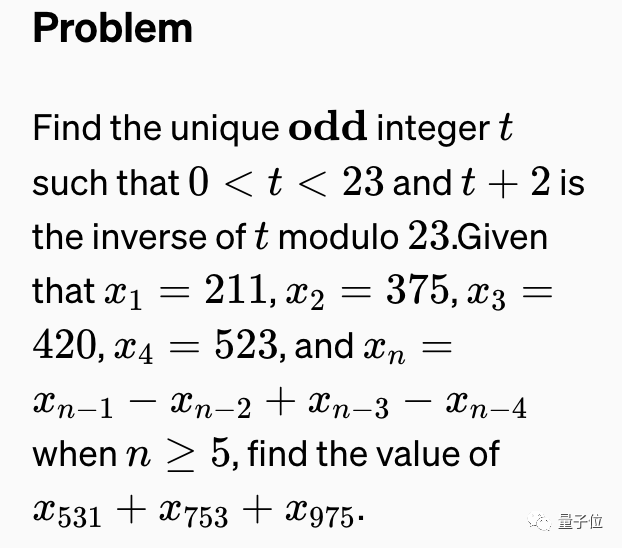

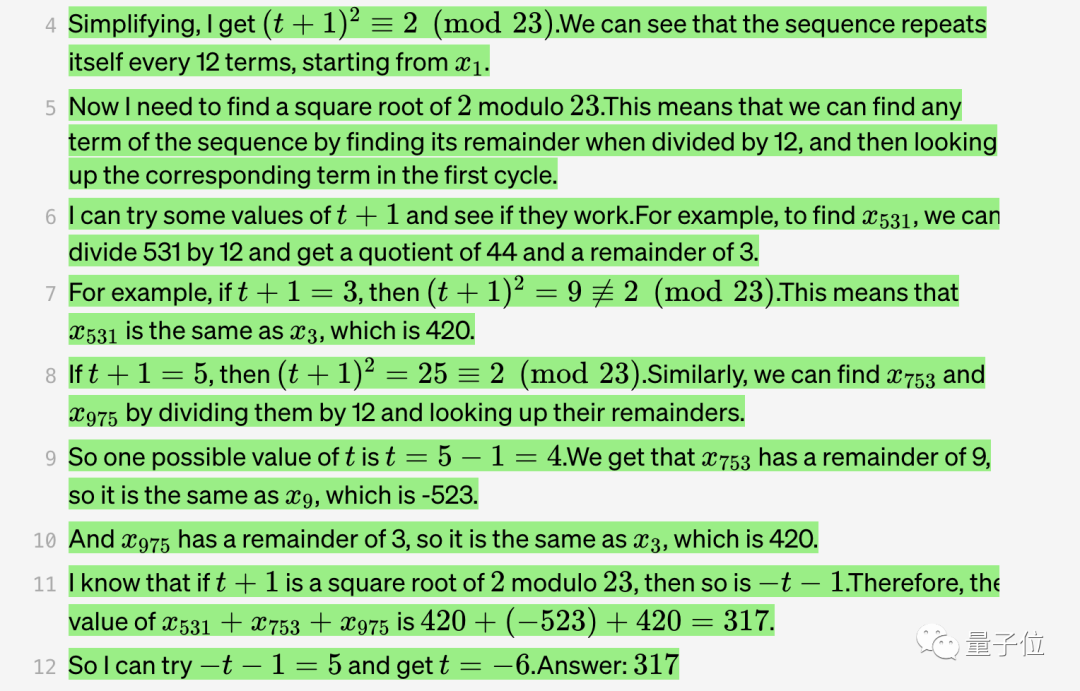

當然也有都不成功的例子,比如下面這道題 GPT-4 和 PRM 都被迷惑了:

來看一下模型的回答:

在第 4 步中,GPT-4 錯誤地認為該序列每 12 項循環(huán)一次,而事實上是每 10 項循環(huán)一次。

而這種計數(shù)錯誤也迷惑到了獎勵模型。

此外,OpenAI 共給出了 10 個問題和解決方案。

可以看出,基于過程監(jiān)督的獎勵模型在一些問題上也會被迷惑住,但是在整體上明顯表現(xiàn)得更好。

網(wǎng)友:再也不用做數(shù)學證明題了

很快,OpenAI 的最新工作在各個平臺上都引發(fā)了熱烈討論。

有人評價:

如果這個方法在非數(shù)學領域也能奏效,我們現(xiàn)在或許正處于游戲規(guī)則即將改變的時刻。

還有人說,這項工作如果用在互動、教育方面,會非常令人興奮,尤其是數(shù)學領域。

這不,有人就說,看來以后不用再做數(shù)學家庭作業(yè)和證明題了(doge)。

用一張圖來總結,大概就是醬嬸兒的:

也有人提出了自己的擔心:這種密集的獎勵信號是否會導致模型更容易陷入局部最小值。

但是如果能夠足夠隨機化、全局搜索,或許模型的魯棒性更高。

值得一提的是,這種 step by step 的方法,不止一次在提升大模型性能上奏效。

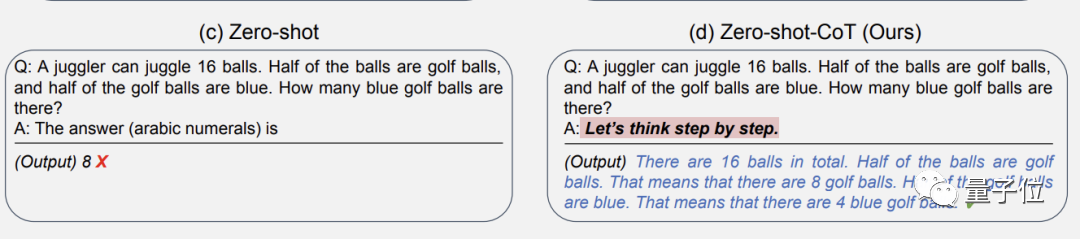

之前,東京大學和谷歌的研究人員發(fā)現(xiàn),只要在對話中加一句“Let’s think step by step”,GPT-3 就能回答出以前不會的問題。

比如提問:

16 個球中有一半是高爾夫球,這些高爾夫球中有一半是藍色的,一共有幾個藍色的高爾夫球?

(問題不難,但要注意這是零樣本學習,也就是說 AI 訓練階段從沒見過同類問題。)

如果要求 GPT-3 直接寫出“答案是幾”,它會給出錯誤答案:8。

但加上讓我們一步一步地思考這句“咒語”后,GPT-3 就會先輸出思考的步驟,最后給出正確答案:4!

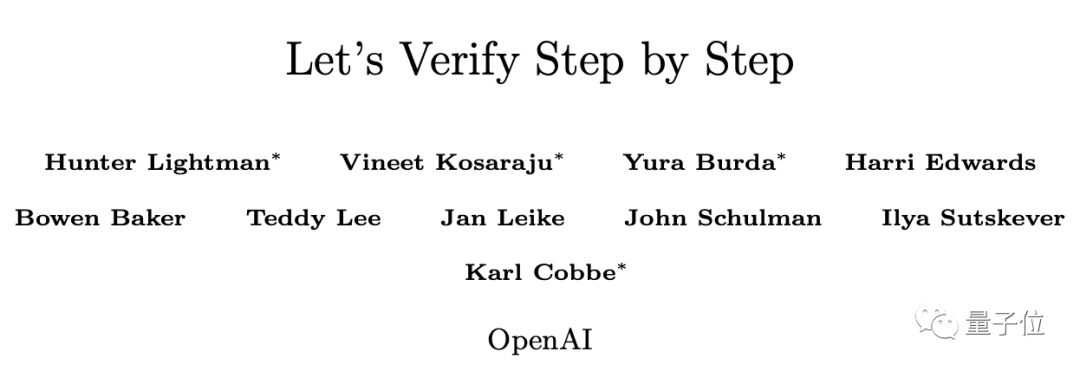

而與之相呼應的是,這回 OpenAI 最新研究的論文題目就叫做《Let’s Verify Step by Step》。

評論