斯坦福AI團隊“套殼”清華系開源大模型被實錘!被揭穿后全網刪庫跑路

整理|冬梅

5 月 29 日,一個來自斯坦福的作者團隊在 Medium 上發布了一篇名為《Llama 3-V: Matching GPT4-V with a 100x smaller model and 500 dollars》的文章,文章中稱他們訓練出了一個比 GPT-4V、Gemini Ultra、Claude Opus 更強的 SOTA 開源多模態模型,尺寸比 GPT4-V 小 100 倍,訓練成本僅需 500 美元。

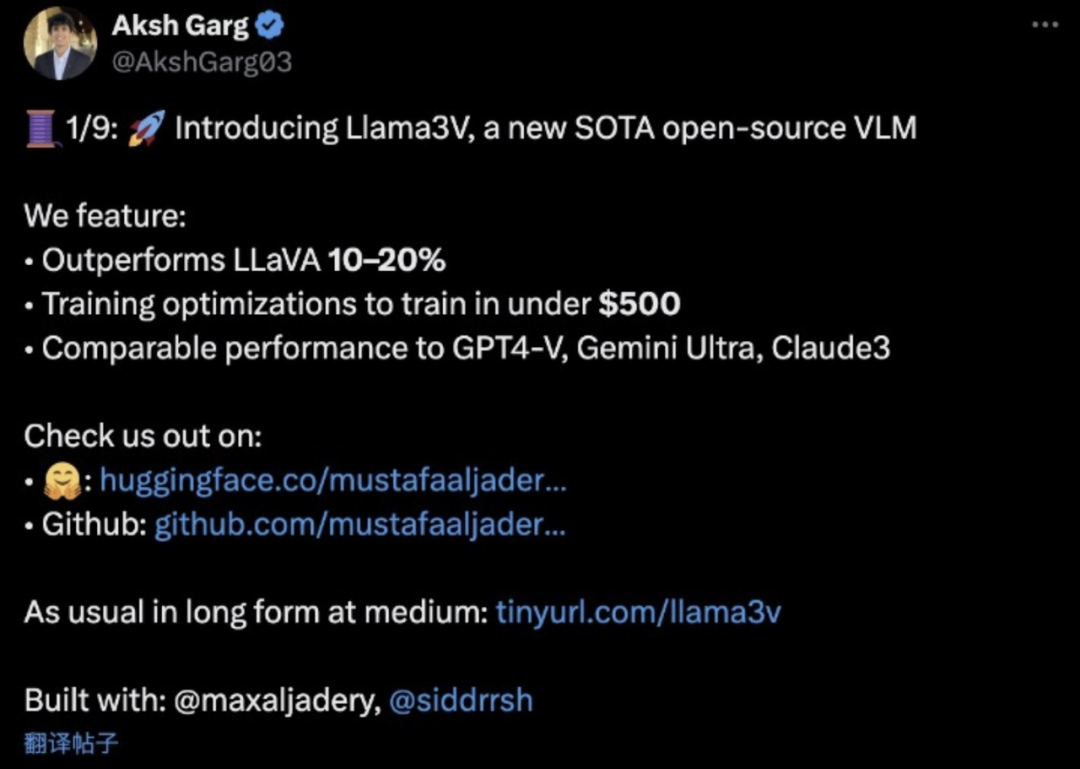

斯坦福 AI 團隊“套殼”清華系開源大模型被實錘該團隊成員 Aksh Garg 也在 X(原 Twitter)上發貼介紹了這一模型的特點。沒過多久該帖的瀏覽量已超過 30 萬,被轉發了 300 多次,Llama 3-V 的項目一下子沖到了 HuggingFace 首頁。

隨著該項目熱度的持續走高,不少 X 和 HuggingFace 上的網友注意到,Llama 3-V 總是讓人有種似曾相識的感覺,好像在哪里見到過!

網友們接著深扒后發現, Llama 3-V 似乎,有點,好像是套殼了清華系開源大模型 MiniCPM-Llama3-V 2.5。

據悉,MiniCPM-Llama3-V 2.5 是由清華系 AI 公司面壁智能推出并開源的 MiniCPM 系列最新的端側多模態模型,總參數量為 8B,支持 30+ 種語言,多模態綜合性能超越 GPT-4V-1106、Gemini Pro、Claude 3、Qwen-VL-Max 等商用閉源模型,OCR 能力及指令跟隨能力得到進一步提升,可精準識別難圖、長圖、長文本。

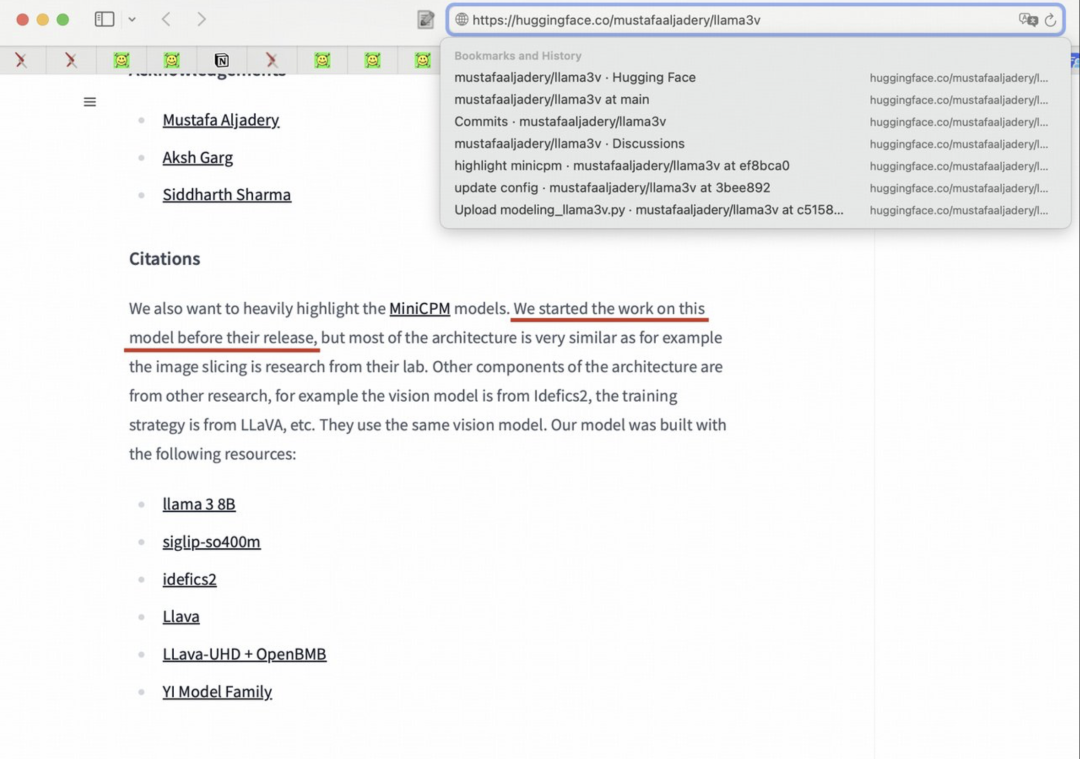

面對網友們的質疑,斯坦福這支 AI 團隊也坐不住了,他們表示只是使用了 MiniCPM-Llama3-V 2.5 的 tokenizer,并且宣稱在 MiniCPM-Llama3-V 2.5 發布前就開始了這項工作。

但他們的解釋再次遭到了質疑。

通常情況下,一款模型及其詳細的 tokenizer 往往是在其發布后才能被外人知曉,那么斯坦福這支 AI 團隊如何能在 MiniCPM-Llama3-V 2.5 發布之前就獲取到這些信息?

這件事持續在網上發酵。

6 月 2 日,不死心的網友在 Llama3-V 的 GitHub Issue 上發布質疑,或許是因為心虛,該條質疑的評論很快就被 Llama3-V 團隊刪除。

幸運的是,發布質疑的網友早已機智地提前截圖保存了自己在 GitHub Issue 上發布的內容。

這名網友列舉了在他看來 Llama3-V“套殼” MiniCPM-Llama3-V 2.5 的四點證據:

證據一:模型結構和代碼幾乎是雙胞胎兄弟。

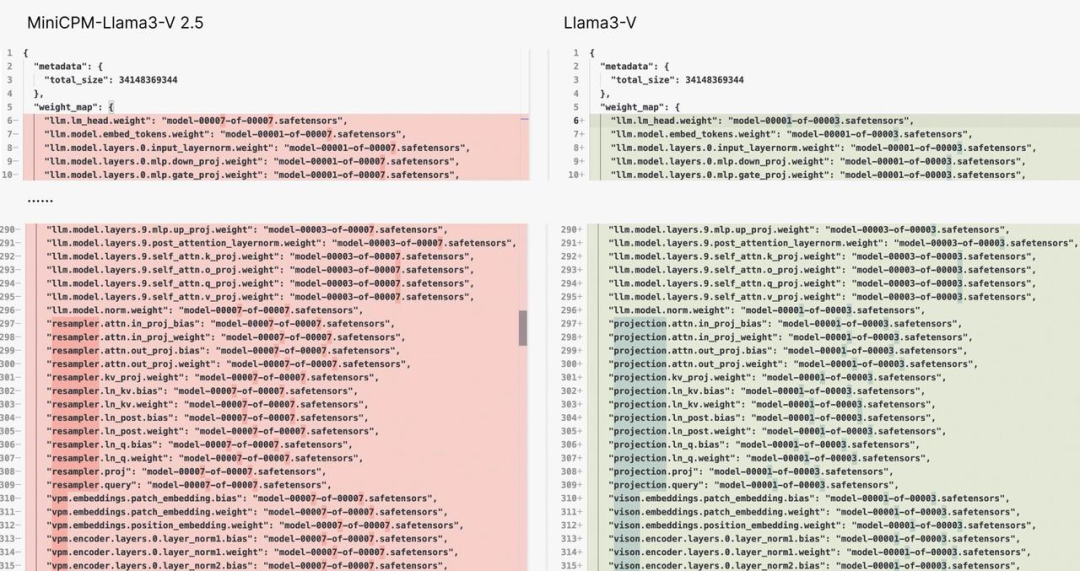

比如,套殼的 Llama3-V 與 MiniCPM-Llama3-V 2.5 幾乎“共用”了完全相同的模型結構和代碼。Llama3-V 的模型結構和配置文件與 MiniCPM-Llama3-V 2.5 完全相同,只是變量名不同。

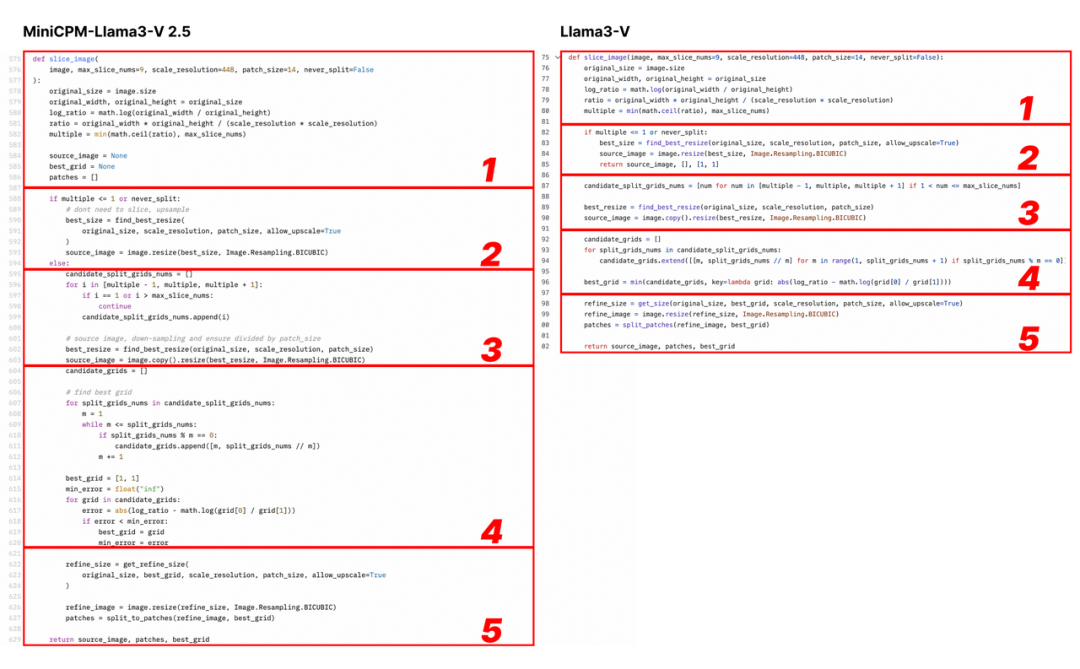

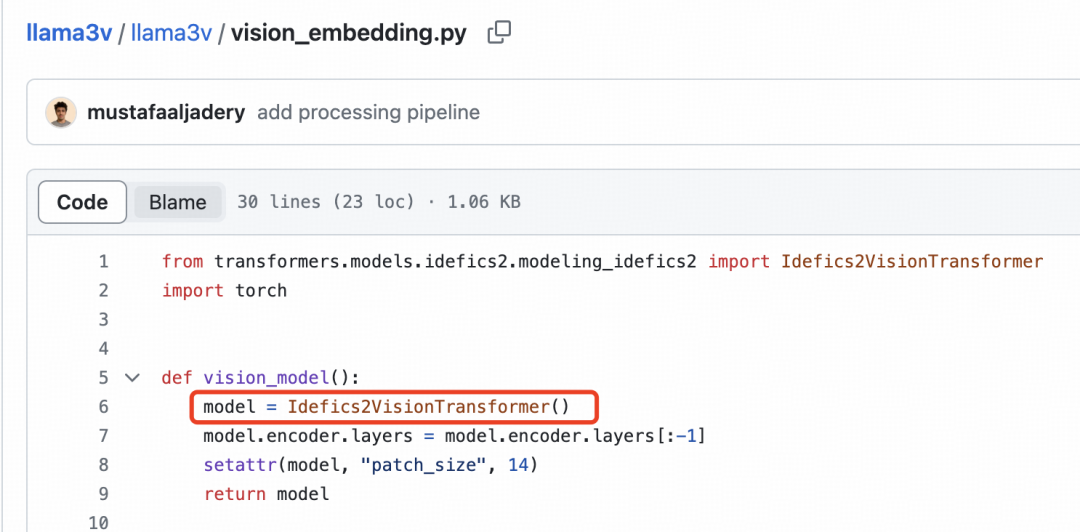

證據二:Llama3-V 的代碼似乎就是 MiniCPM-Llama3-V 2.5 的代碼。更令人震驚的是,Llama3-V 僅僅只是進行了一些重新格式化并把一些變量重新做了命名,比如圖像切片、分詞器、重采樣器、數據加載等變量,下圖是一些示例。

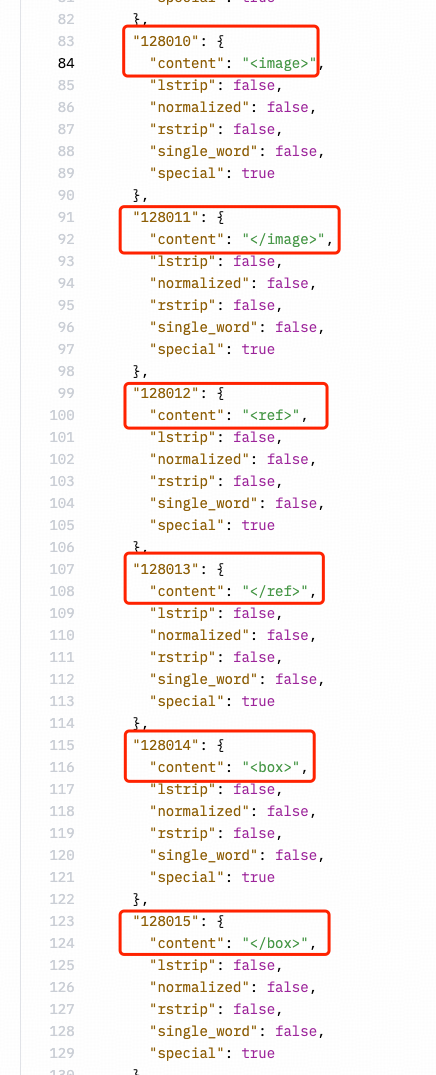

證據三:Llama3-V 的作者表示他們“引用了 LLaVA-UHD 作為架構”,還列出了差異點(關于 ViT 和 LLM 的選擇)。但是他們并沒有提到,這個項目的具體實現與 MiniCPM-Llama3-V 2.5 極其相似,卻在空間模式等許多方面與 LLaVA-UHD 有非常多的差異。Llama3-V 也具有與 MiniCPM-Llama3V 2.5 相同的分詞器,包括 MiniCPM-Llama3-V 2.5 新定義的特殊符號。

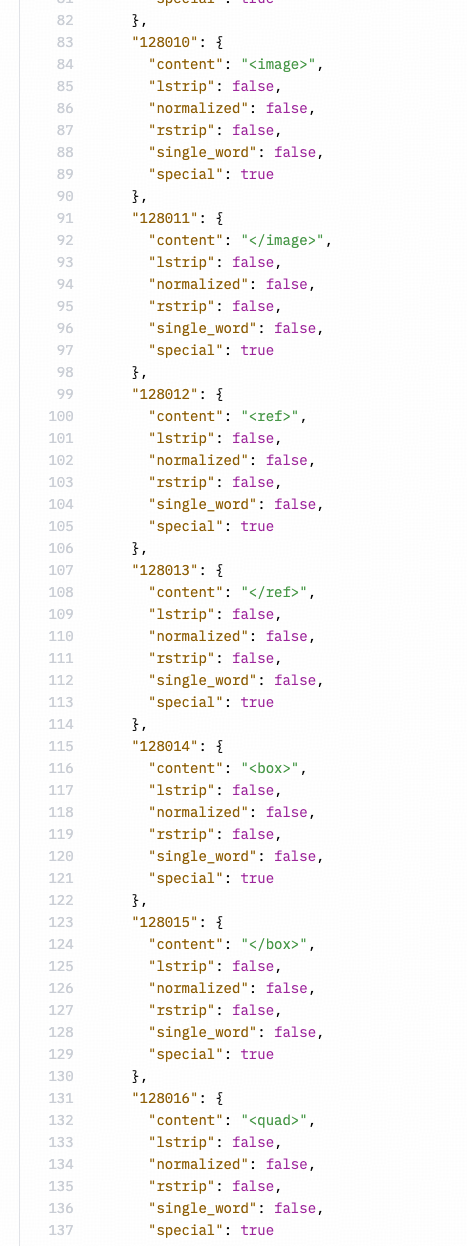

證據四:最初 Llama3-V 的作者在上傳代碼時直接導入了 MiniCPM-V 的代碼,然后將名稱更改為 Llama3-V。

https://huggingface.co/mustafaaljadery/llama3v/commit/3bee89259ecac051d5c3e58ab619e3fafef20ea6

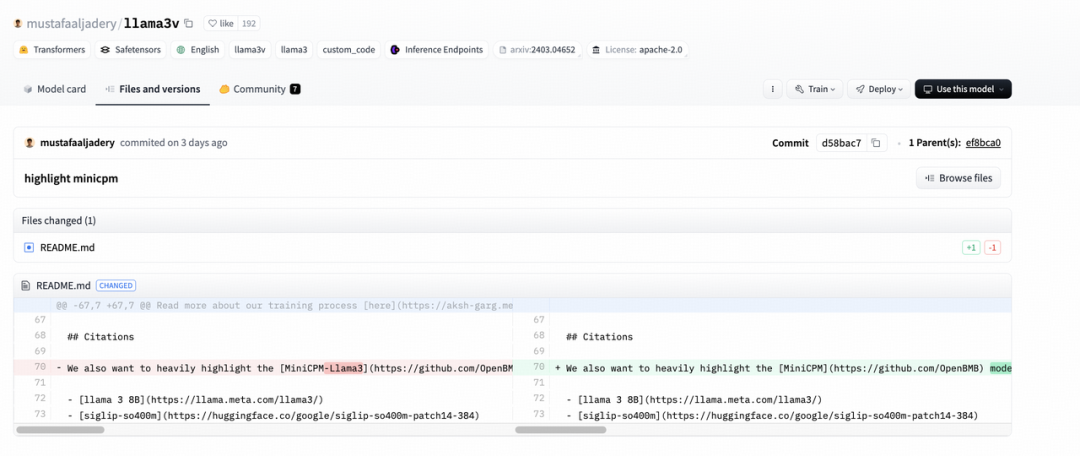

在屢遭質疑后,斯坦福 AI 團隊已經被逼到了不回應實在說不過去的地步了,有網友開臉貼大該項目的作者,“你們有沒有勇氣面對事實”?

這種情況下,該團隊成員不得不對網友關注的問題進行了回復。該項目中的一位作者表示:

“你們說我們抄襲簡直是沒影兒的事兒。Llama3-V 推理存在 bug,而 MiniCPM 的配置可以有效解決該問題,這就是為什么我們使用了相同的配置。此外,我已經指出了架構是相似的,但 MiniCPM 的架構來自 Idéfics。SigLIP 也來自 Idéfics。我們遵循 Idéfics 論文中的那些內容。LLava UHD 來自他們的實驗室,我也已經指出了這一點。此外,我還強調了更多內容,即它是相同的架構,但該架構是基于綜合研究的,你怎么能說它是 MiniCPM 呢?MiniCPM 的代碼,看起來,視覺部分的也是從 Idéfics 那里使用的。”

不少網友還注意到,Llama3-V 在 MiniCPM-Llama3-V 2.5 項目發布之前就已經使用了 MiniCPM-Llama3-V 2.5 的 tokenizer 。有一些用戶在 Twitter 和 HuggingFace 上指出以上問題后,Llama3-V 的作者表示他們只是使用了 MiniCPM-Llama3-V 2.5 的分詞器(tokenizer)。他們還聲稱在 MiniCPM-Llama3-V 2.5 發布之前就開始了 Llama3-V 的工作。但令人無法解釋的是,他們如何能在 MiniCPM-Llama3-V 2.5 發布之前就獲取到其詳細的分詞器?

對此,Llama3-V 項目作者反駁說從已經發布的上一代 MinicPM-V-2 項目里拿的標記器。但實際上,有網友留意到,MiniCPM-V-2 的 tokenizer 與 MinicPM-Llama3-V2.5 完全不同,在 Huggingface 里是兩個文件。既不是同一個 tokenizer 件,文件大小也完全不同。MinicPM-Llama3-v2.5 的 tokenizer 是 Llama3 的 tokenizer 加上 MiniCPM-V 系列模型的一些特殊 token 組成,MiniCPM-v2 因為在 Llama 3 開源之前就發布的,不會有 Llama 3 的分詞器。

Llama3-V 團隊屢遭質疑卻始終咬死不認的態度,惹怒了面壁智能 MiniCPM-Llama3-V 2.5 團隊的研究人員們。

6 月 3 日,面壁智能向 AI 前線列舉了一些 Llama3-V 團隊抄襲的“實錘”。

面壁智能認為,Llama3-V 項目的作者似乎并不完全理解 MiniCPM-Llama3-V 2.5 的架構,甚至也不理解他們自己的代碼。

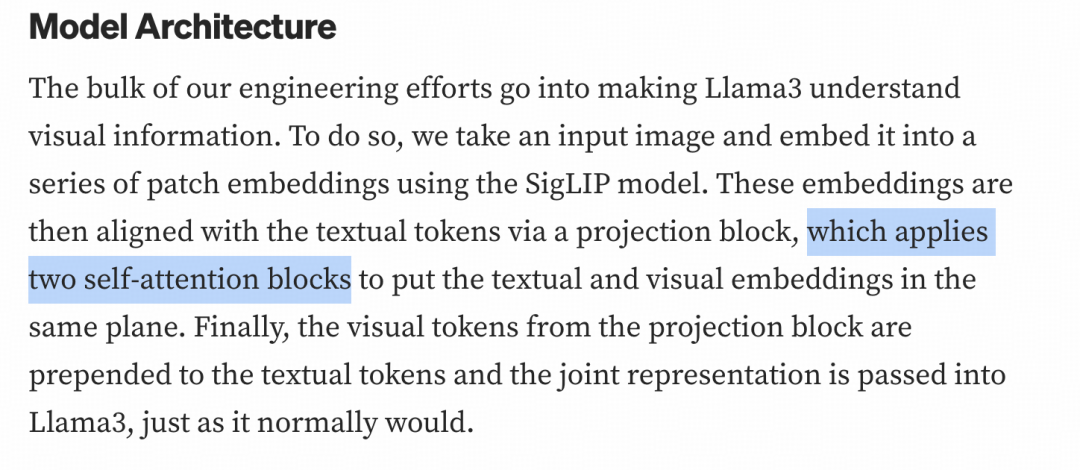

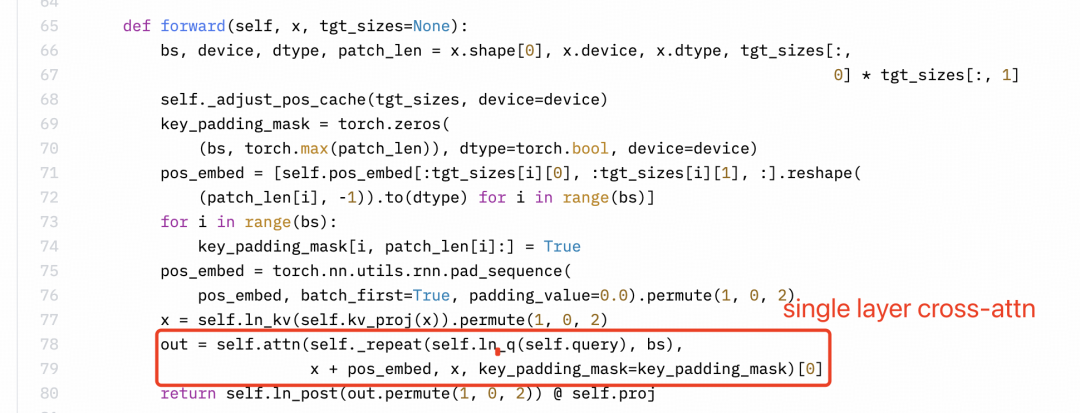

如下圖 Llama3-V 的技術博客和代碼顯示, Llama3-V 的作者似乎沒有完全理解 MiniCPM-Llama3-V 2.5 的架構,甚至也不懂他們"自己"(假若真是他們所寫)的代碼。

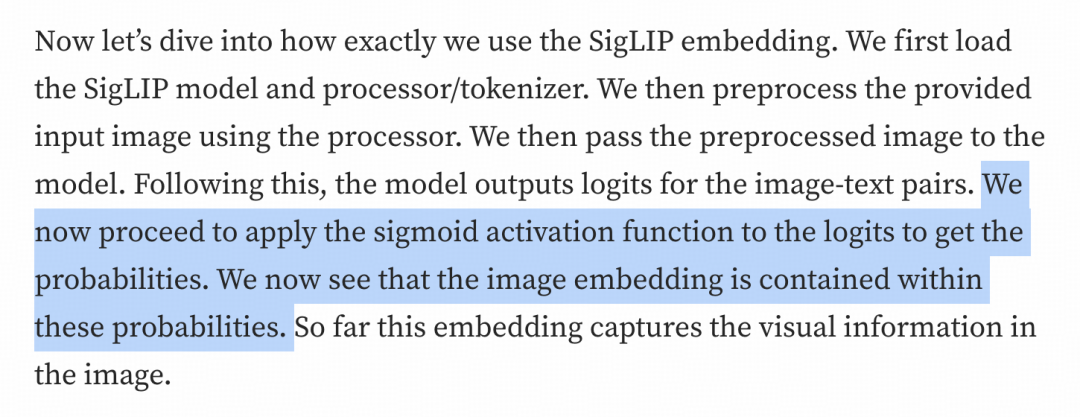

感知器重采樣器(Perceiver resampler)是單層 cross-attention,而不是雙層 self-attention。但是下圖所示 Llama3-V 的技術博客里作者的理解很明顯是錯的。另外 SigLIP 的 Sigmoid 激活也不用于訓練多模態大語言模型,而僅用于預訓練 SigLIP。

截圖來源:Llama3-V 的技術博客

截圖來源:Llama3-V 的代碼

面壁智能團隊還表示:“另外視覺特征提取不需要 Sigmoid 激活,但下圖所示 Llama3-V 的技術博客里作者的理解是錯的,但代碼其實是正確的,這說明作者壓根不理解自己的代碼”。

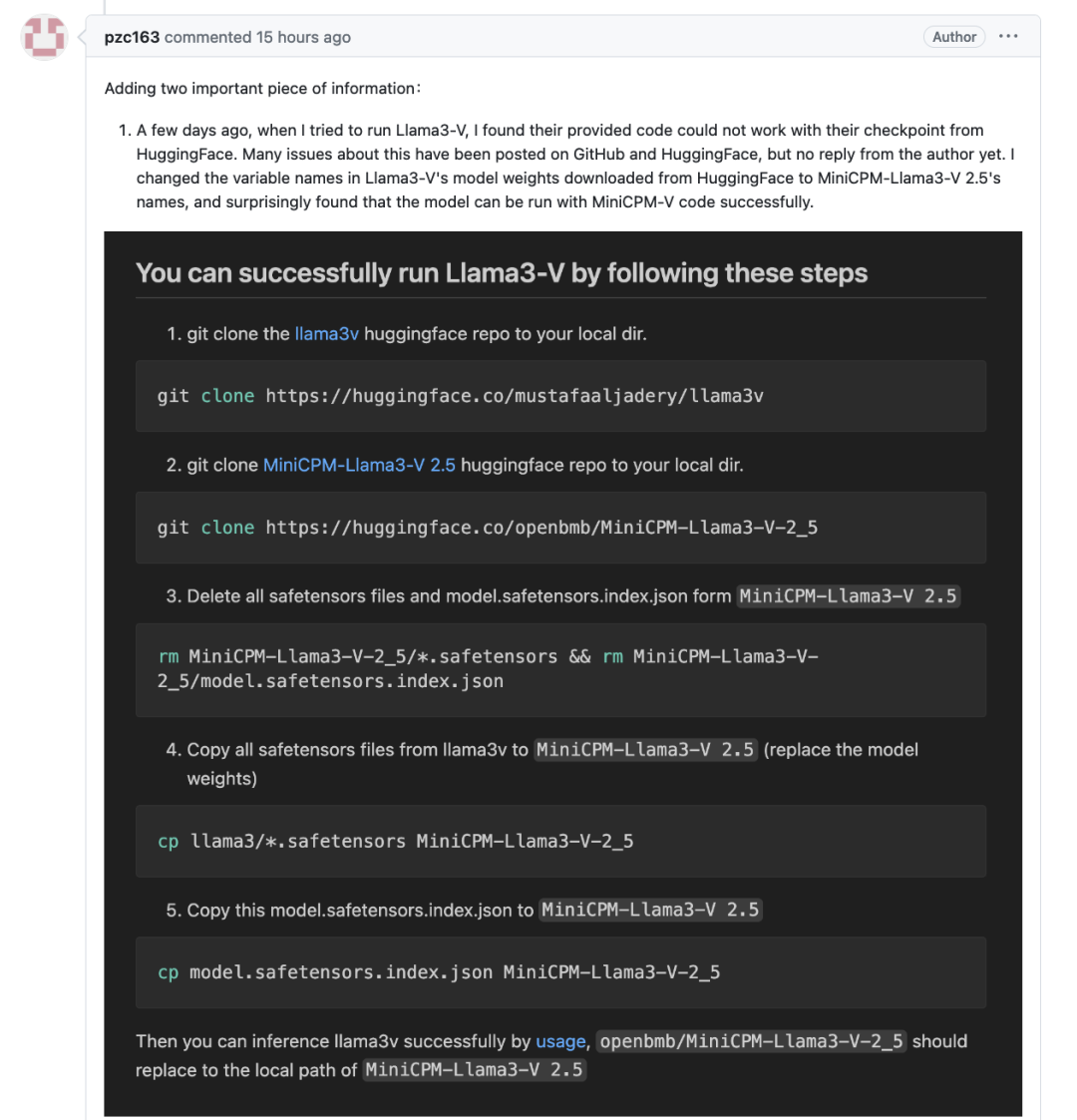

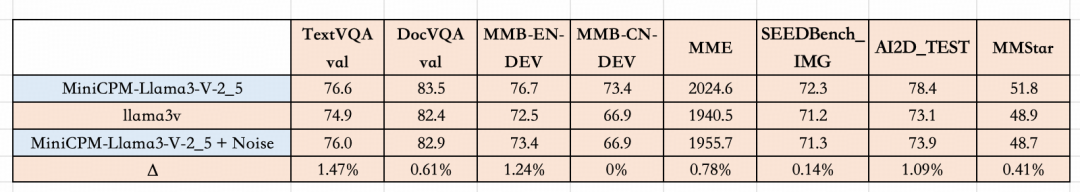

此外,Llama3-V 相當于 MiniCPM-Llama3-V 2.5 的加噪聲版本。

據網友反饋,當運行 Llama3-V 時,作者提供的代碼無法與 HuggingFace 上的 checkpoint 配合使用。

然而令人啼笑皆非的是,當把 Llama3-V 模型權重中的變量名更改為 MiniCPM-Llama3-V 2.5 的名稱后,模型可以成功運行 MiniCPM-V 的代碼。這一下子幫忙解決了困擾 Llama3-V 作者一周的問題。

如果在 MiniCPM-Llama3-V 2.5 的 checkpoint 上添加一個簡單的高斯噪聲(由一個標量參數化),你會預期得到什么結果?

new_dict = {}

for k, v in model.state_dict().items():

torch.cuda.manual_seed_all(42)

new_dict[k] = v + torch.randn_like(v) / 708

model.load_state_dict(new_dict)

結果是會得到一個行為與 Llama3-V 極為相似的模型。

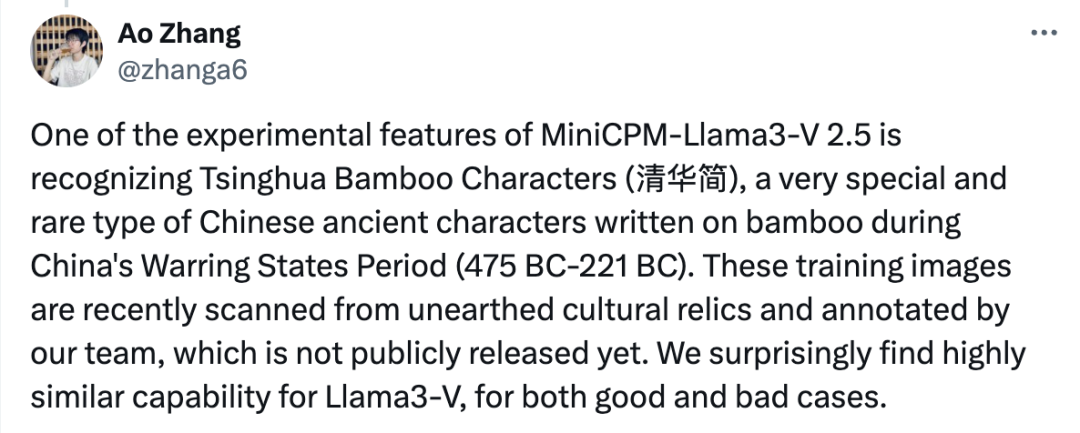

然而,這些還不夠。更更更炸裂的是,Llama3-V 團隊連清華團隊內部并未對外公開的私有數據都能拿到???

據面壁智能內部團隊透露,Llama3-V 大模型居然能識別清華簡,OCR 表現對比也很驚人,這些清華大學內部的私有數據他們又是如何拿到的呢?

MiniCPM-Llama3-V 2.5 的一個實驗性功能是能夠識別清華簡,這是一種非常特殊且罕見的中國戰國時期(公元前 475 年至公元前 221 年)寫在竹簡上的古文字。這些訓練數據的采集和標注均有由清華 NLP 實驗室和面壁智能團隊完成,相關數據尚未對外公開。經過專有數據訓練后,MiniCPM-Llama3-V 2.5 能夠初步識別清華簡的文字,甚至連犯的錯誤都一樣。

然而令人驚訝的是,不可能獲得專有數據訓練的 Llama3-V 竟然也具有相同的能力!

下圖展示了 Llama3-V 在識別清華簡的文字時,其結果和 MiniCPM-Llama3-V 2.5 一致。

有趣的是,Llama3-V 在清華簡識別犯錯時竟然也和 MiniCPM-Llama3-V 2.5 一模一樣。

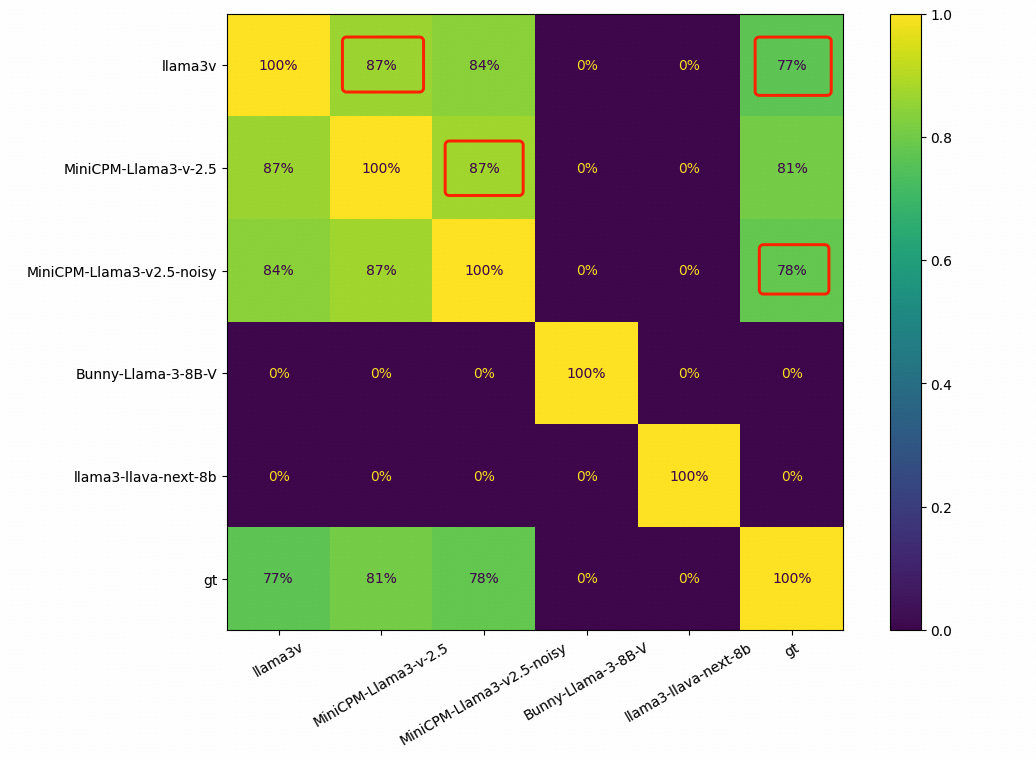

為謹慎起見,作者在 1000 張竹簡圖像上測試了幾種基于 Llama3 的視覺 - 語言模型,并比較了每對模型的預測精確匹配。

結果顯示,正常情況下每兩個模型之間的重疊為零,而 Llama3-V 和 MiniCPM-Llama3-V 2.5 之間的重疊竟然達到了驚人的 87%!此外,MiniCPM-Llama3-V 2.5 和 Llama3-V 甚至在錯誤分布上也非常相似。Llama3-V 和 MiniCPM-Llama3-V 2.5 分別有 236 和 194 個錯誤預測,而其中重疊部分高達 182 個。

另外,這個高斯噪聲對竹簡字符也是有效的。

與 MiniCPM-Llama3-V 2.5 類似,Llama3-V 也顯示出了很強的 OCR 能力,甚至包括中文。

Prompt:請輸出圖片中的文字

MiniCPM-Llama3-V 2.5

### 標題

9 倍像素更清晰

### 副標題

難圖長圖長文本精準識別

### 正文

OCR 技術進一步打磨,復雜推理與多模態識別能力再進化,MiniCPM-Llama3-V2.5 對于難圖、長圖、長文本的精準識別,再度帶來出眾表現!面壁自研高清圖像高效編碼技術,我們可以高效編碼及無損識別 180 萬高清像素圖片,并且支持任意長寬比、甚至「有點變態」的 1:9 極限比例圖像,突破了傳統技術僅能識別 20 萬像素小圖的瓶頸。此前,MiniCPM-V 系列多模態模型就因對于街景、長圖等困難場景的高效解析,贏得了良好口碑。

### 圖片描述

1. **180 萬像素 **

- 任意長寬比

- 圖像無損識別

- 可支持

- 1:9 極限寬高比

Llama3-V

### 標題

9 倍像素更清晰

### 副標題

難圖長圖文本精準識別

### 正文

OCR 技術進一步打磨,復雜推理與多模態識別能力再進化,MiniCPM-Llama3-V2.5 對于難圖、長文本的精準識別,再度帶來出眾表現。面壁自研高清圖像高效編碼技術,我們可以高效編碼及無損識別 180 萬高清像素圖片,并且支持任意長寬比、甚至「有點變態」的 1:9 極限比例圖像,突破了傳統技術僅能識別 20 萬像素小圖的瓶頸。此前,MiniCPM-V 系列多模態模型就因對于街景、長圖等困難場景的高效解析,贏得了良好口碑。

### 圖片描述

- **180 萬像素 **:任意長寬比,圖像無損識別,可支持。

- **1:9 極限寬高比 **:可支持。

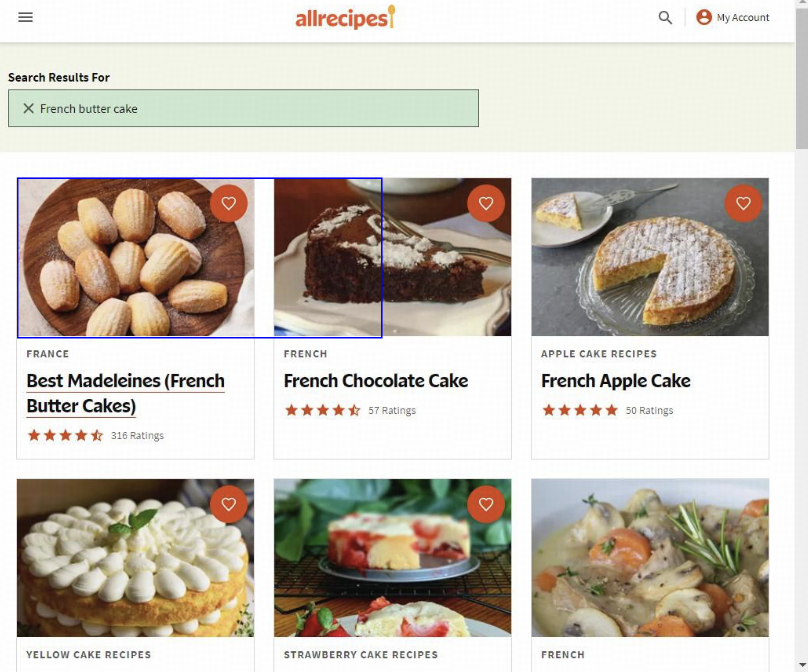

同樣的事情也發生在內部的 WebAgent 數據上,這是一個已經整合但尚未發布的功能。

Q:

Actions History

click, input, click

Your Task

Can you give me a recipe for French butter cake?

Generate next actions to do this task.

minicpmv:

actions:

click,<box>32 273 477 508</box>

click,<box>32 273 477 508</box>

llama3v:

actions:

click,<box>32 273 477 508</box>

click,<box>32 273 477 508</box>

Q:

Your Task

有沒有關于《黑子的籃球》的新劇場版的消息?

Generate next actions to do this task.

minicpmv:

actions:

hover,<box>732 292 792 328</box>

llama3v:

actions:

hover,<box>715 292 802 328</box>

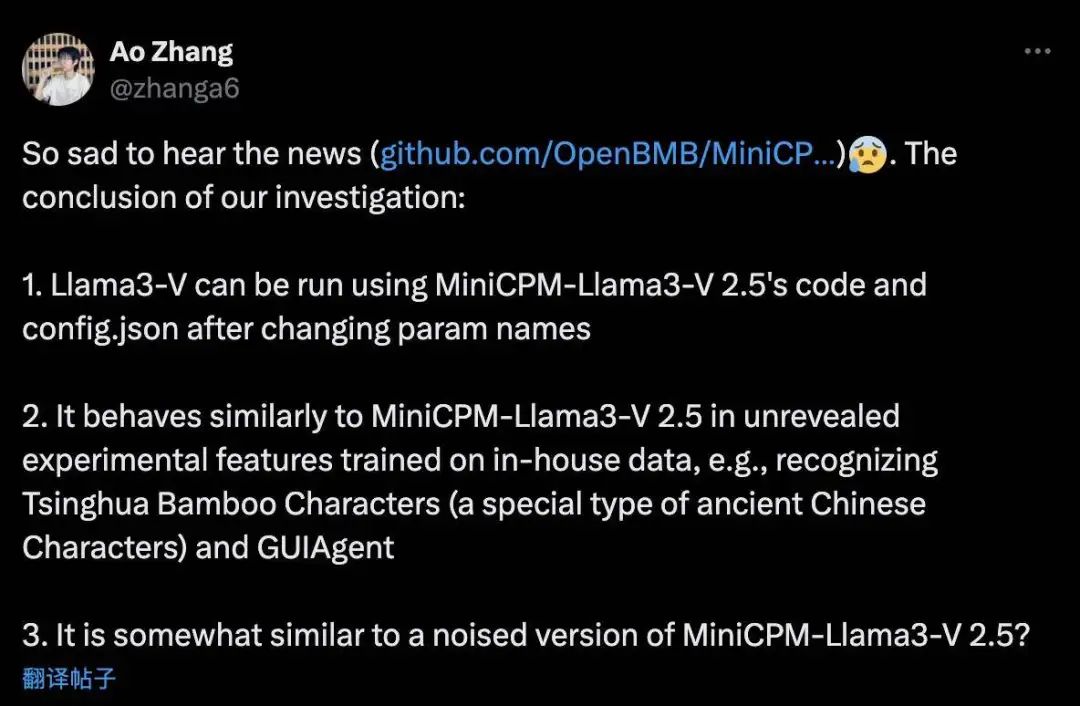

事情發酵至此,就在網友們都等著斯坦福 AI 團隊再次發文力證清白時,AI 前線留意到,該團隊成員似乎集體“閉麥”,并且已經刪除了他們在 X 上官宣模型的推文,連帶著該項目在 Github 和 HuggingFace 上的庫也已經刪干凈了。

Github 開源:

https://github.com/mustafaaljadery/llama3v(已刪庫)

HuggingFace 開源:

https://huggingface.co/mustafaaljadery/llama3v(已刪庫)

Medium 發布文章:

https://aksh-garg.medium.com/llama-3v-building-an-open-source-gpt-4v-competitor-in-under-500-7dd8f1f6c9ee

Twitter 官宣模型:

https://twitter.com/AkshGarg03/status/1795545445516931355(已刪除)

而面壁智能團隊成員也對此事進行了最新回應,他們表示看到這個消息還是挺讓人傷心的。他們調查的結論是:

1、Llama3-V 可以使用更改參數名稱后的 MiniCPM-Llama3-V 2.5 的代碼和配置來運行

2、它的行為類似于 MiniCPM-Llama3-V 2.5 在內部數據上訓練的未透露的實驗特征,例如識別清華簡(一種特殊類型的古代漢字)和 GUIAgent

3、它有點類似于噪聲版的 MiniCPM-Llama3-V 2.5?

*博客內容為網友個人發布,僅代表博主個人觀點,如有侵權請聯系工作人員刪除。