馬斯克打臉OpenAI,全球最大巨無霸模型Grok-1開源!3140億參數8個MoE,GitHub狂攬6k星

說到做到,馬斯克xAI的Grok,果然如期開源了!

就在剛剛,xAI正式發布3140億參數混合專家模型Grok-1的權重和架構。

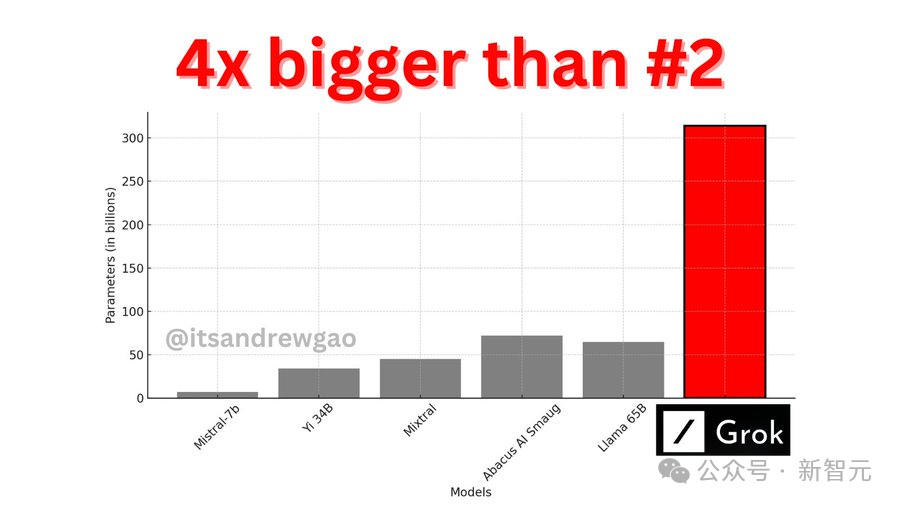

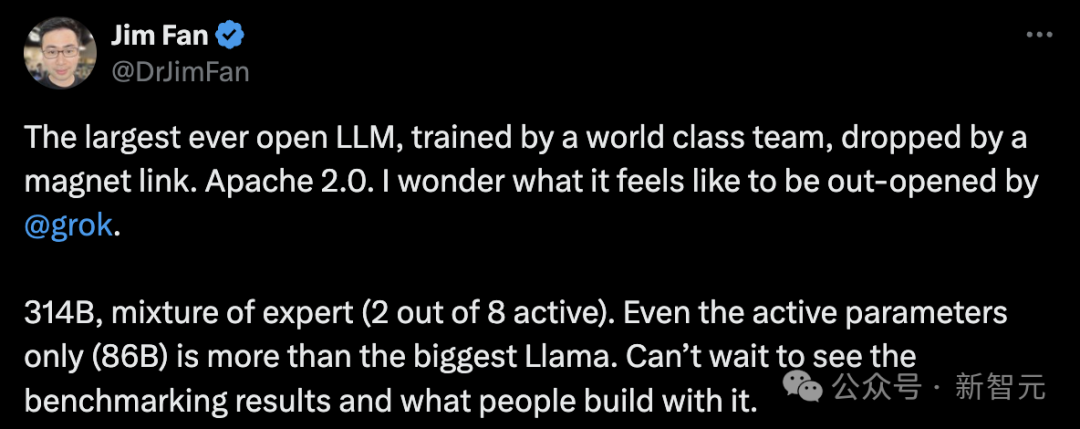

3140億的參數,讓Grok-1成為迄今參數量最大的開源LLM,是Llama 2的4倍。

目前,xAI關于Grok-1沒有透露更多信息。

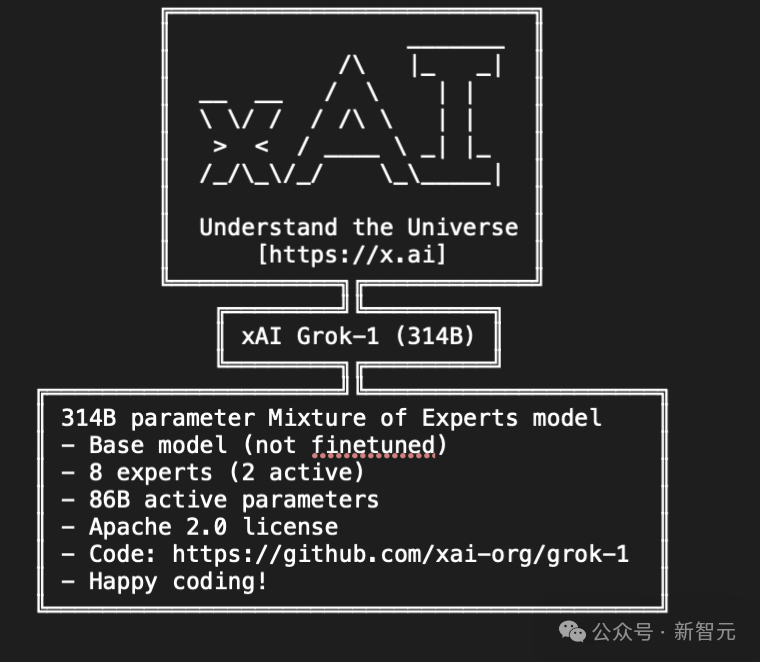

官網放出的信息如下——

- 基礎模型在大量文本數據上訓練,未針對任何特定任務進行微調。

- 314B參數的MoE,有25%的權重在給定token上處于激活狀態。

- 2023年10月,xAI使用JAX和Rust之上的自定義訓練堆棧從頭開始訓練。

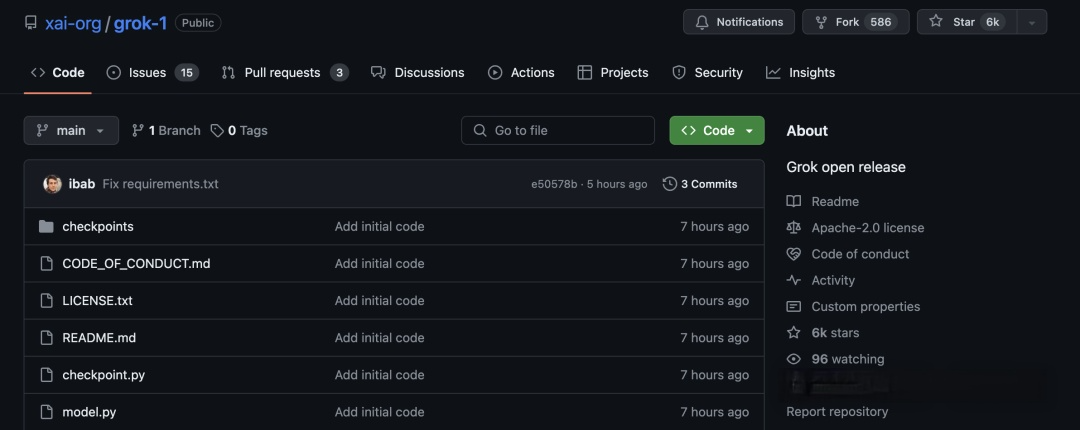

一經上線GitHub,Grok就狂攬了6k星,586個Fork。

項目地址:https://github.com/xai-org/grok-1

馬斯克還不忘嘲諷OpenAI一番,「告訴我們更多關于OpenAI的「open」部分...」

紐約時報點評道,開源Gork背后的原始代碼,是這個世界上最富有的人控制AI未來戰斗的升級。

開源究竟會讓技術更安全,還是會讓它更濫用?

「開源支持者」馬斯克,以身作則地卷入了AI界的這場激烈辯論,并用行動給出了答案。

小扎剛剛也對Grok做出了評價,「并沒有給人留下真正深刻的印象,3140億參數太多了,你需要一堆H100,不過我已經買下了」。

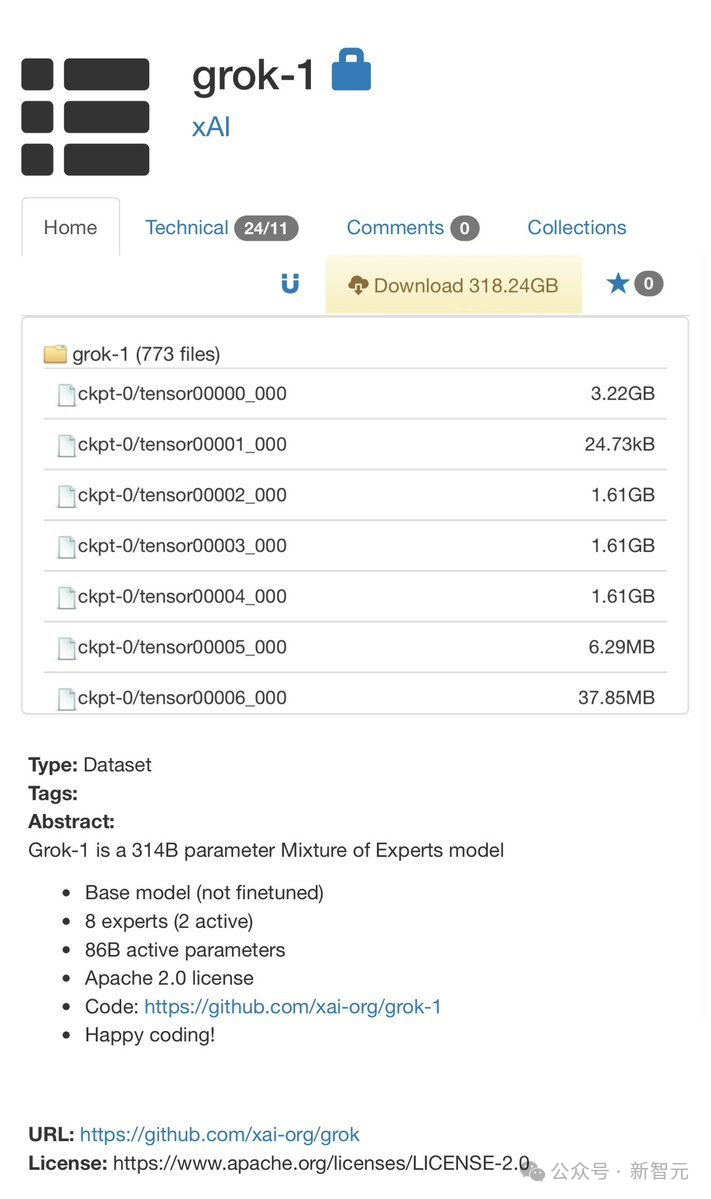

一條磁力鏈,全球首個最大模型開源

這次xAI開源Grok-1,遵守的是Apache-2.0許可證,因此,用戶可以自由使用、修改和分發軟件。存儲庫包含了用于加載和運行Grok-1開源權重模型的JAX示例代碼。用戶需要下載checkpoint,將ckpt-0目錄放置在checkpoint中,隨后運行以下代碼來測試:pip install -r requirements.txtpython run.py

這個腳本會在測試輸入上,加載checkpoint和模型中的樣本。

由于模型較大,參數達到了314B參數,因此需要具有足夠GPU內存的計算機,才能使用示例代碼測試模型。而且,由于此存儲庫中MoE層的實現效率不高,選擇該實現是為了避免需要自定義內核來驗證模型的正確性。通過Torrent客戶端和下面這個磁力鏈接,就可以下載權重了。magnet:?xt=urn:btih:5f96d43576e3d386c9ba65b883210a393b68210e&tr=https%3A%2F%2Facademictorrents.com%2Fannounce.php&tr=udp%3A%2F%2Ftracker.coppersurfer.tk%3A6969&tr=udp%3A%2F%2Ftracker.opentrackr.org%3A1337%2Fannounce

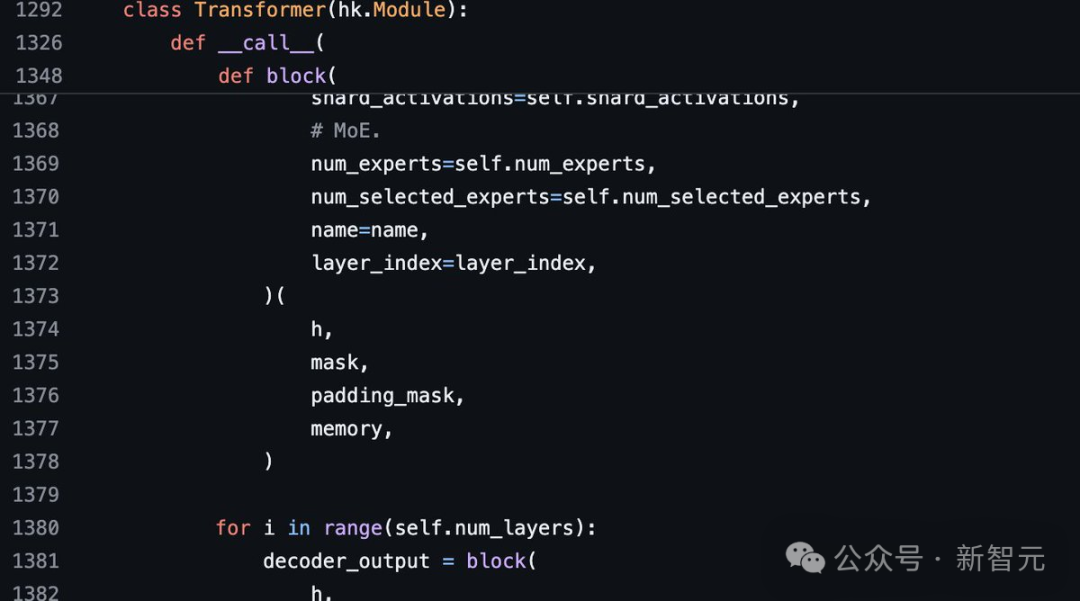

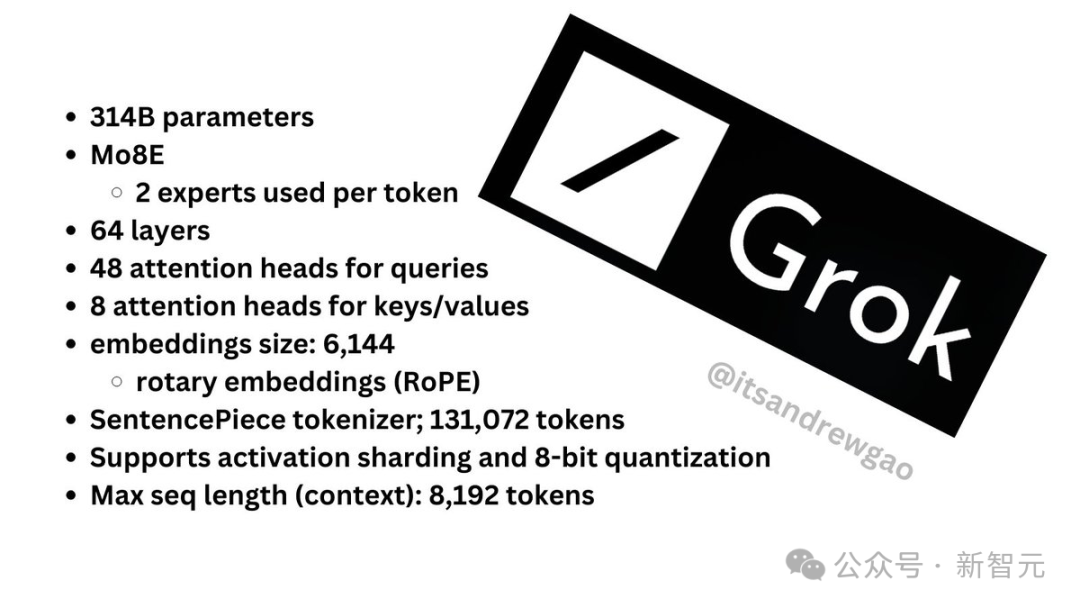

更多細節斯坦福研究者Andrew Kean Gao瀏覽了model.py介紹了更多Grok的架構信息,314B參數沒有更多附加條款。

更多細節斯坦福研究者Andrew Kean Gao瀏覽了model.py介紹了更多Grok的架構信息,314B參數沒有更多附加條款。

8個混合專家(2個活躍專家),86B活躍參數。使用旋轉嵌入,而不是固定位置嵌入。

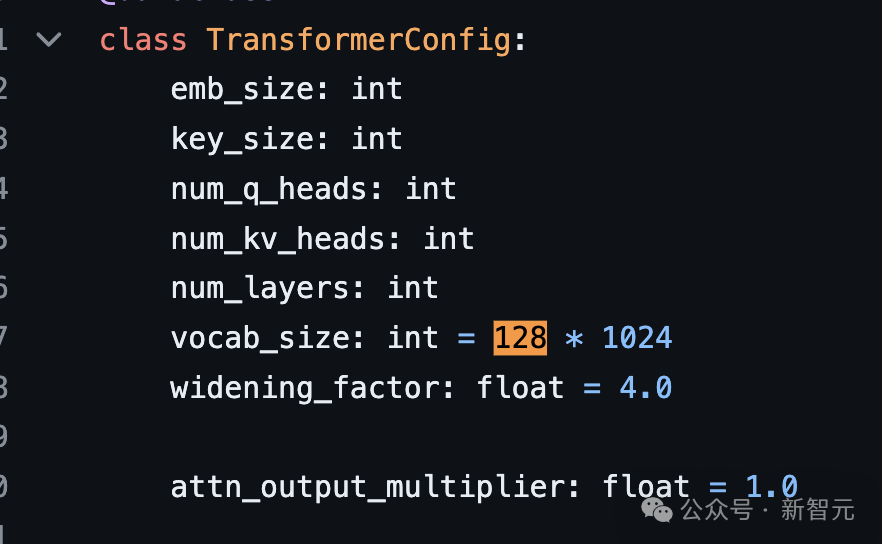

8個混合專家(2個活躍專家),86B活躍參數。使用旋轉嵌入,而不是固定位置嵌入。- tokenizer詞匯量:131,072(于GPT-4類似)相當于2^17

- 嵌入大小:6144(48*128)

- Transformer層:64(每一層都有一個解碼層:多頭注意塊和密度塊)

- 鍵值大小:128 多頭注意模塊:有48個查詢頭和8個鍵值

多頭注意模塊:有48個查詢頭和8個鍵值密集塊(密集前饋塊):

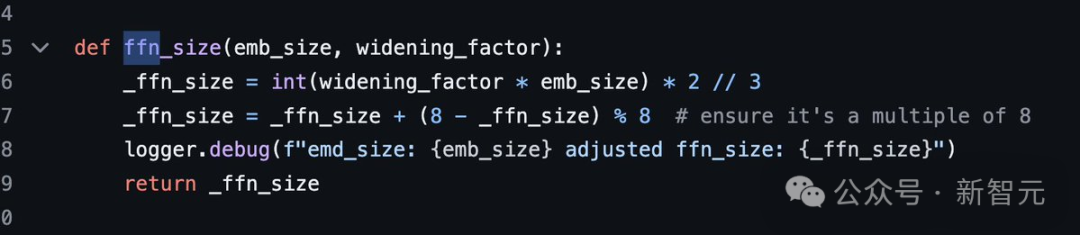

- 寬度因子(Widening Factor):8

- 隱藏層大小為32768每個token從8個專家中選出2個。 旋轉位置嵌入大小6144,與模型的輸入嵌入大小相同。

旋轉位置嵌入大小6144,與模型的輸入嵌入大小相同。- 上下文長度:8192個token

- 精度:bf16 最后,附上一張總結版圖。

最后,附上一張總結版圖。

網友:開源爭霸戰要來

AI社區已經沸騰了!

技術界指出,Grok的亮點是在前向反饋層中使用了GeGLU以及歸一化方法,并且使用了有趣的三明治范式技術(sandwich norm technique)。

連OpenAI的員工,都表示了自己對Grok的強烈興趣。

AI研究人員Sebastian Raschka表示,與其他通常有使用限制的開源模重模型相比,Grok更為開源。不過它的開源程度低于Pythia、Bloom和Olmo,后者提供了訓練代碼和可重現的數據集。

AI研究人員Sebastian Raschka表示,與其他通常有使用限制的開源模重模型相比,Grok更為開源。不過它的開源程度低于Pythia、Bloom和Olmo,后者提供了訓練代碼和可重現的數據集。

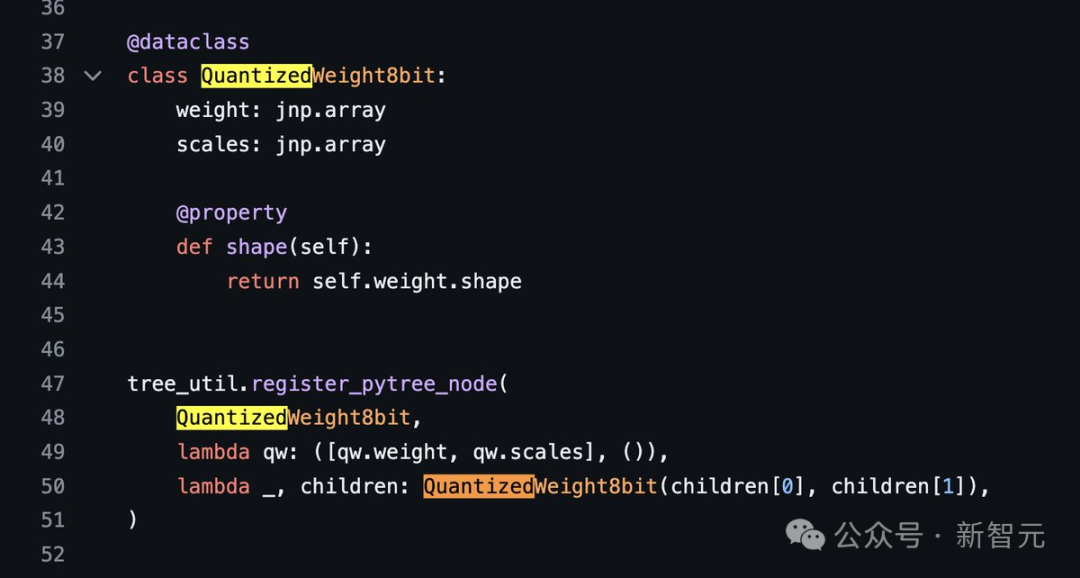

Craiyon創始人Boris Dayma,詳細分析了Grok-1的代碼。

Craiyon創始人Boris Dayma,詳細分析了Grok-1的代碼。 網友indigo表示,為了「理解宇宙」的理念,看來xAI團隊特意把參數設定成了「圓周率 314B」,這是目前規模最大的開源模型,期待今年6月的Llama 3加入Grok的開源爭霸戰。

網友indigo表示,為了「理解宇宙」的理念,看來xAI團隊特意把參數設定成了「圓周率 314B」,這是目前規模最大的開源模型,期待今年6月的Llama 3加入Grok的開源爭霸戰。 Grok開源后,一大波微調要來了。

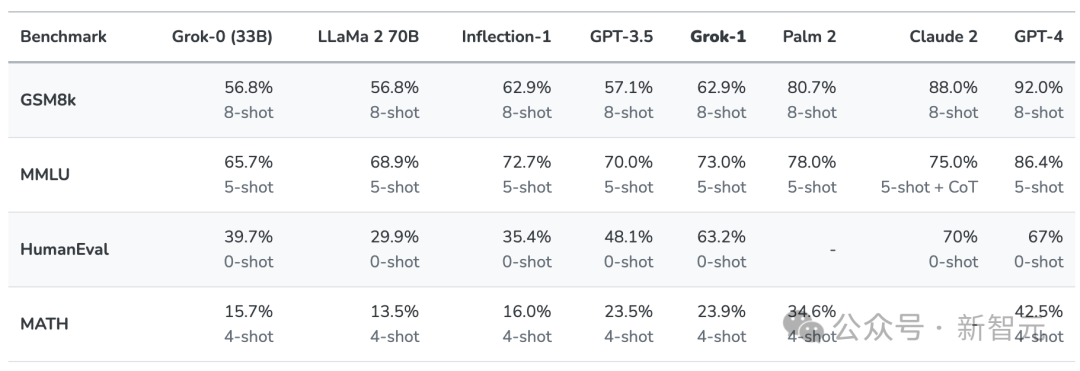

Grok開源后,一大波微調要來了。 第一代Grok已超越Llama-2-70B2023年11月,xAI推出了自己的第一代大語言模型Grok,正式加入大模型的戰爭。當時,Grok在推特上作為「Premium+」訂閱服務的一部分,月費16美元。xAI表示,Grok的設計靈感來源于《銀河系漫游指南》,它能夠回答幾乎所有問題,助力人類不分背景或政治立場地追求理解和知識。Grok最初的版本Grok-0擁有330億參數,緊接著xAI推出了經過數次改進的Grok-1,為X上的Grok聊天機器人提供支持。根據xAI公布的數據,在GSM8K、HumanEval和MMLU等一系列基準測試中,Grok-1的表現超過了Llama-2-70B和GPT-3.5,雖然跟GPT-4還差得遠。

第一代Grok已超越Llama-2-70B2023年11月,xAI推出了自己的第一代大語言模型Grok,正式加入大模型的戰爭。當時,Grok在推特上作為「Premium+」訂閱服務的一部分,月費16美元。xAI表示,Grok的設計靈感來源于《銀河系漫游指南》,它能夠回答幾乎所有問題,助力人類不分背景或政治立場地追求理解和知識。Grok最初的版本Grok-0擁有330億參數,緊接著xAI推出了經過數次改進的Grok-1,為X上的Grok聊天機器人提供支持。根據xAI公布的數據,在GSM8K、HumanEval和MMLU等一系列基準測試中,Grok-1的表現超過了Llama-2-70B和GPT-3.5,雖然跟GPT-4還差得遠。 當時,Grok不僅能夠處理X平臺上實時生成的用戶內容,還帶有一點幽默感,給憨憨的AI注入了一絲活力。在提供最新熱點事件信息(無論是政治還是體育)的同時,它還能抖個機靈,甚至偶爾諷刺一下。

當時,Grok不僅能夠處理X平臺上實時生成的用戶內容,還帶有一點幽默感,給憨憨的AI注入了一絲活力。在提供最新熱點事件信息(無論是政治還是體育)的同時,它還能抖個機靈,甚至偶爾諷刺一下。馬斯克為何選擇開源?

在數次嘲諷OpenAI是「CloseAI」之后,馬斯克果真選擇了開源自家大模型。

當然,這背后肯定也有商業上的考量。作為市場領導者的OpenAI,是沒有理由開源ChatGPT背后模型代碼的。現在,通過發布Grok的代碼,馬斯克將自己牢牢扎根在后者的陣營中。這一決定,或許能讓他的xAI超越Meta和Mistral AI。Llama的開源給Meta帶來了很多好處,幾乎讓小扎從元宇宙的泥潭爬了出來。 而僅僅只是一個小型初創公司的Mistral AI,也因為自己的開源策略而聲名鵲起,被業界公認為「歐洲的OpenAI」。

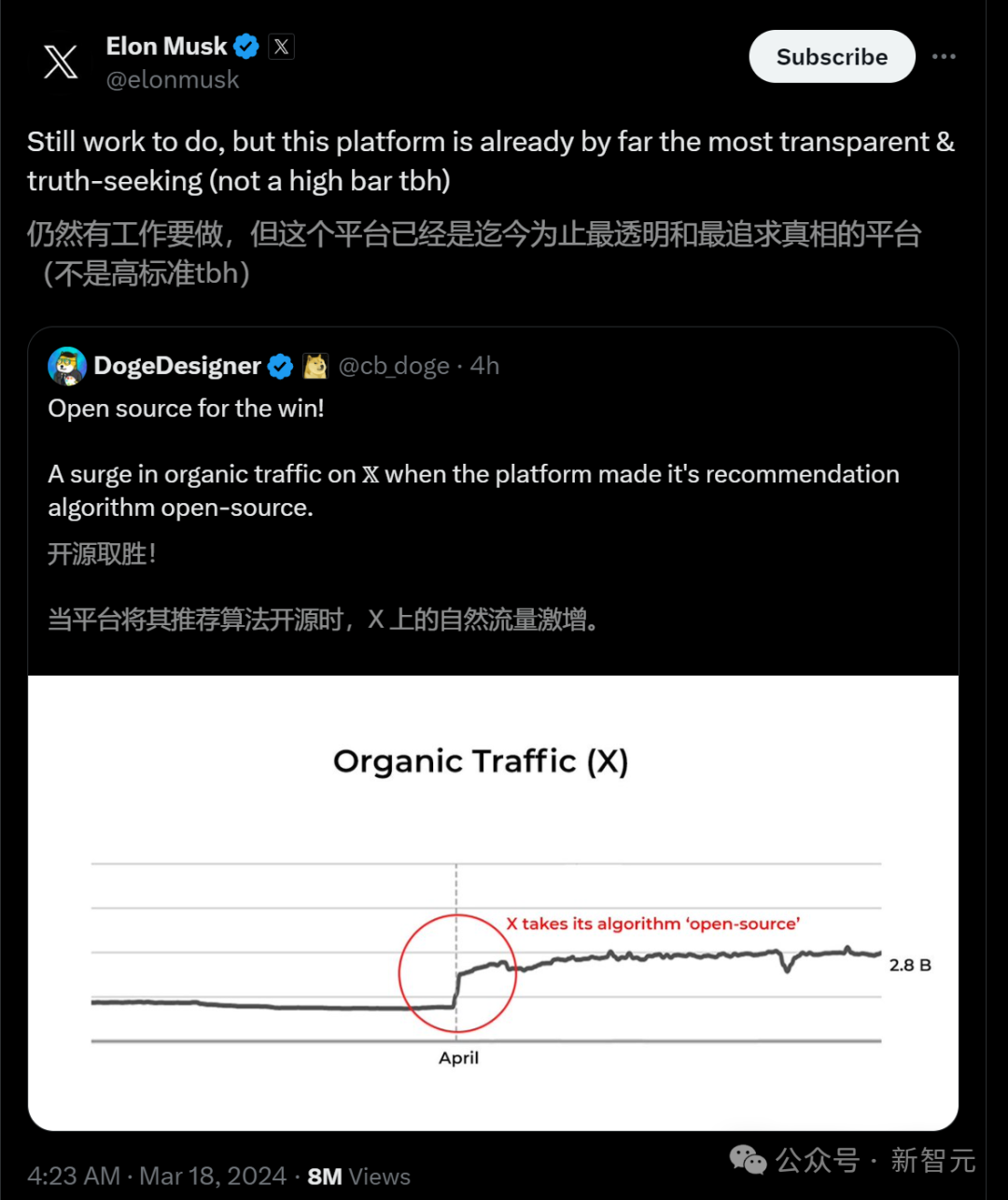

而僅僅只是一個小型初創公司的Mistral AI,也因為自己的開源策略而聲名鵲起,被業界公認為「歐洲的OpenAI」。 開源版本可能會鼓勵開發者和潛在客戶更快地采納自己的模型,實際上起到了市場推廣的作用。開發者社區對Grok開源版本的反饋和改進也可能有助于xAI加速開發新版本,這些新版本xAI可以選擇開放源代碼或保留專有權。比如像Mistral一樣,承諾繼續發布開源版本,同時為付費客戶保留最先進的模型。馬斯克一直是開源技術的支持者,連Tesla也已經開放了汽車某些部分的源代碼,而他的社交媒體平臺X公開了一些用于內容排名的算法。「還有工作要做,但這個平臺已經是迄今為止最透明、最注重真相、不是高門檻的平臺,」馬斯克今天在回應對開源X推薦算法的評論時,這樣說道。

開源版本可能會鼓勵開發者和潛在客戶更快地采納自己的模型,實際上起到了市場推廣的作用。開發者社區對Grok開源版本的反饋和改進也可能有助于xAI加速開發新版本,這些新版本xAI可以選擇開放源代碼或保留專有權。比如像Mistral一樣,承諾繼續發布開源版本,同時為付費客戶保留最先進的模型。馬斯克一直是開源技術的支持者,連Tesla也已經開放了汽車某些部分的源代碼,而他的社交媒體平臺X公開了一些用于內容排名的算法。「還有工作要做,但這個平臺已經是迄今為止最透明、最注重真相、不是高門檻的平臺,」馬斯克今天在回應對開源X推薦算法的評論時,這樣說道。 盡管OpenAI目前在AI領域仍遙遙領先,但開源和閉源的戰爭還遠遠沒有結束。

盡管OpenAI目前在AI領域仍遙遙領先,但開源和閉源的戰爭還遠遠沒有結束。 AI模型是否應該開源?某些人認為,必須防止這種強大技術免受闖入者的侵害,而另一些人則堅持認為,開源的利絕對大于弊。作為市場領導者的OpenAI,是沒有理由開源ChatGPT背后模型代碼的。現在,通過發布Grok的代碼,馬斯克將自己牢牢扎根在后者的陣營中。這一決定,或許能讓他的xAI最終超越Meta和Mistral AI。參考資料:https://x.ai/blog/grok-oshttps://twitter.com/itsandrewgao/status/1769447551374156097https://www.wired.com/story/elon-musk-no-choice-open-chatbot-grok/

AI模型是否應該開源?某些人認為,必須防止這種強大技術免受闖入者的侵害,而另一些人則堅持認為,開源的利絕對大于弊。作為市場領導者的OpenAI,是沒有理由開源ChatGPT背后模型代碼的。現在,通過發布Grok的代碼,馬斯克將自己牢牢扎根在后者的陣營中。這一決定,或許能讓他的xAI最終超越Meta和Mistral AI。參考資料:https://x.ai/blog/grok-oshttps://twitter.com/itsandrewgao/status/1769447551374156097https://www.wired.com/story/elon-musk-no-choice-open-chatbot-grok/*博客內容為網友個人發布,僅代表博主個人觀點,如有侵權請聯系工作人員刪除。