微軟自研芯片靴子落地,黃仁勛要打造“AI界臺積電”。作者 | ZeR0

編輯 | 漠影

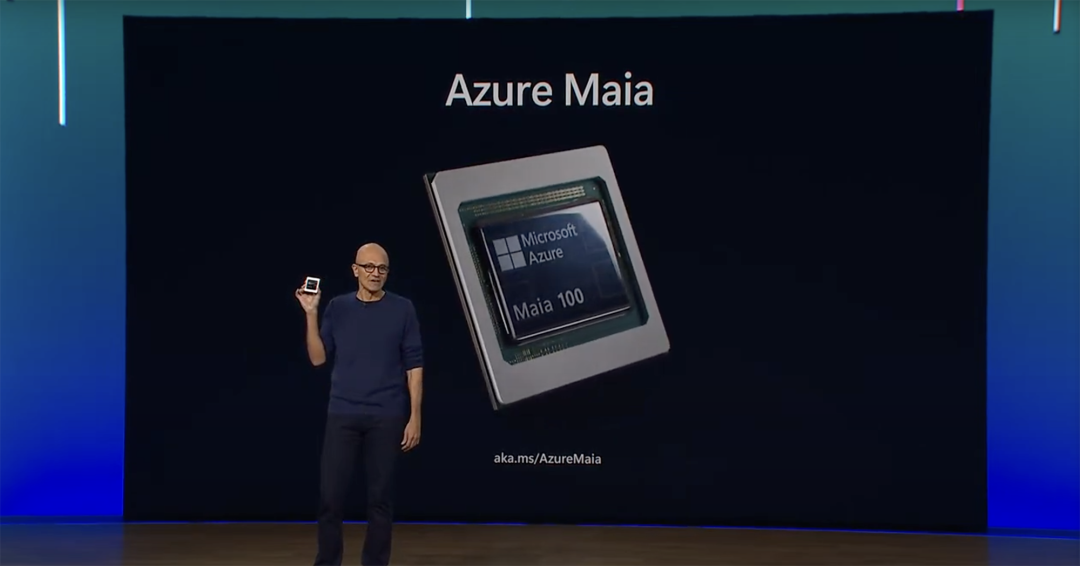

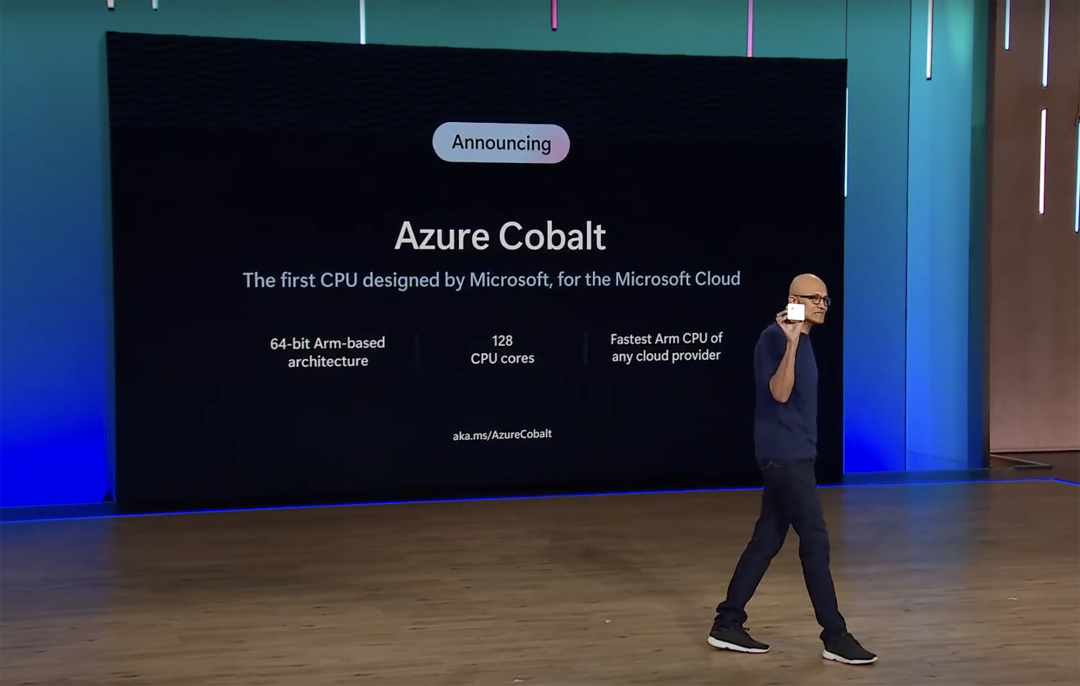

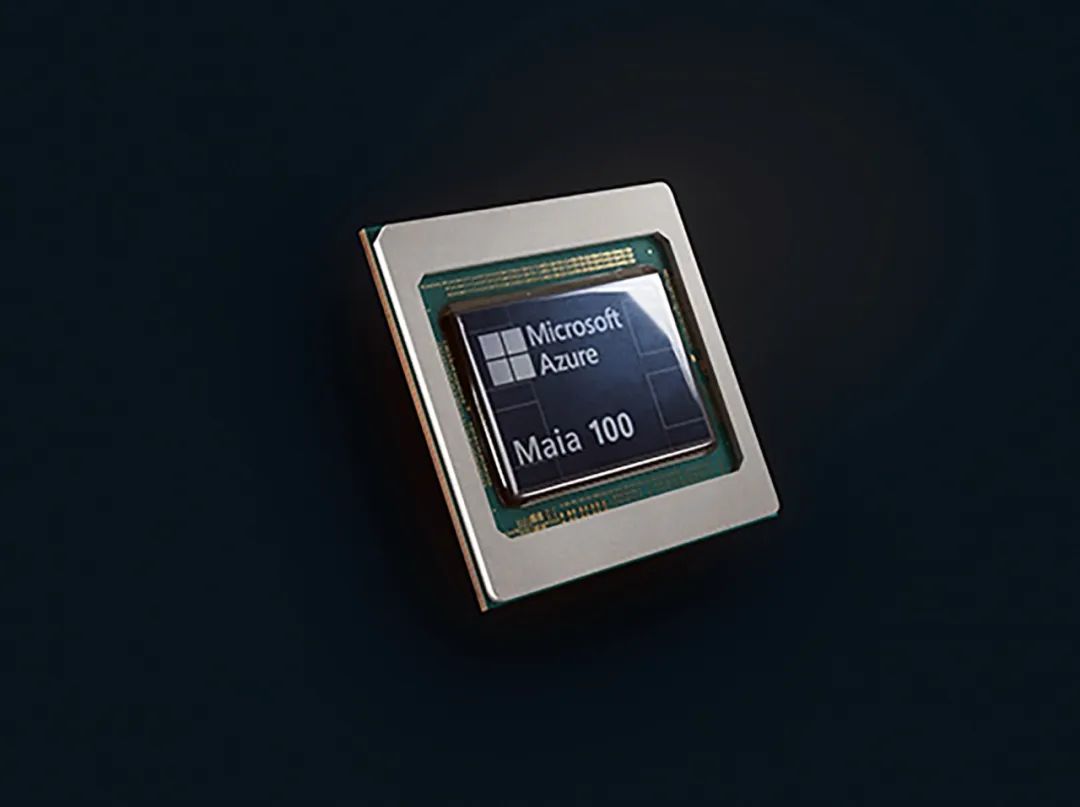

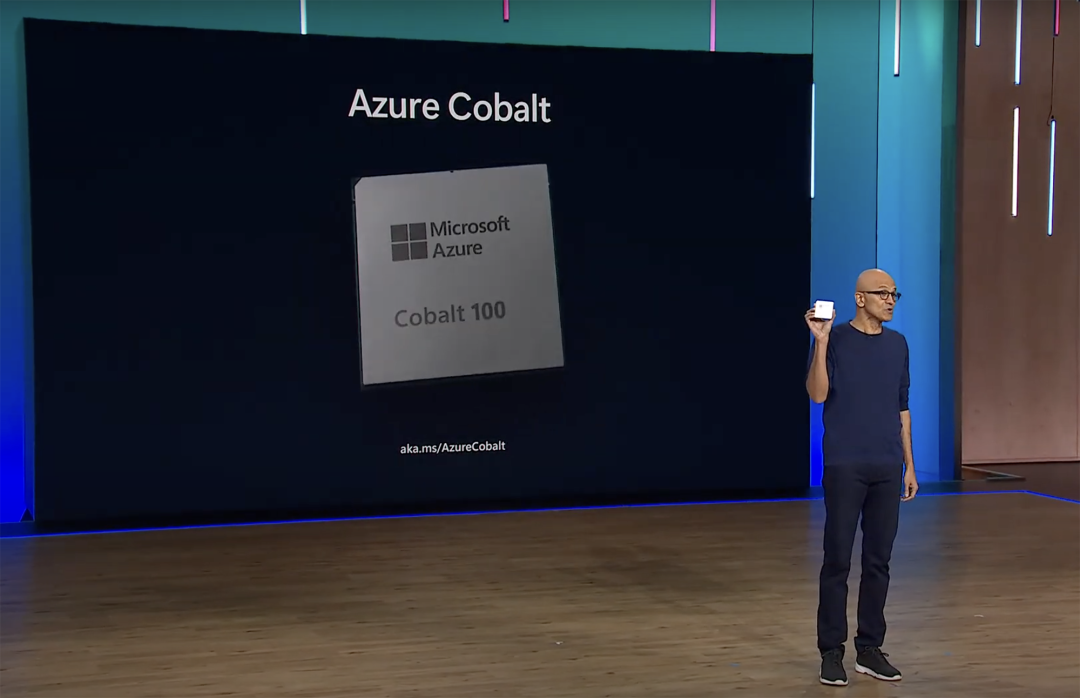

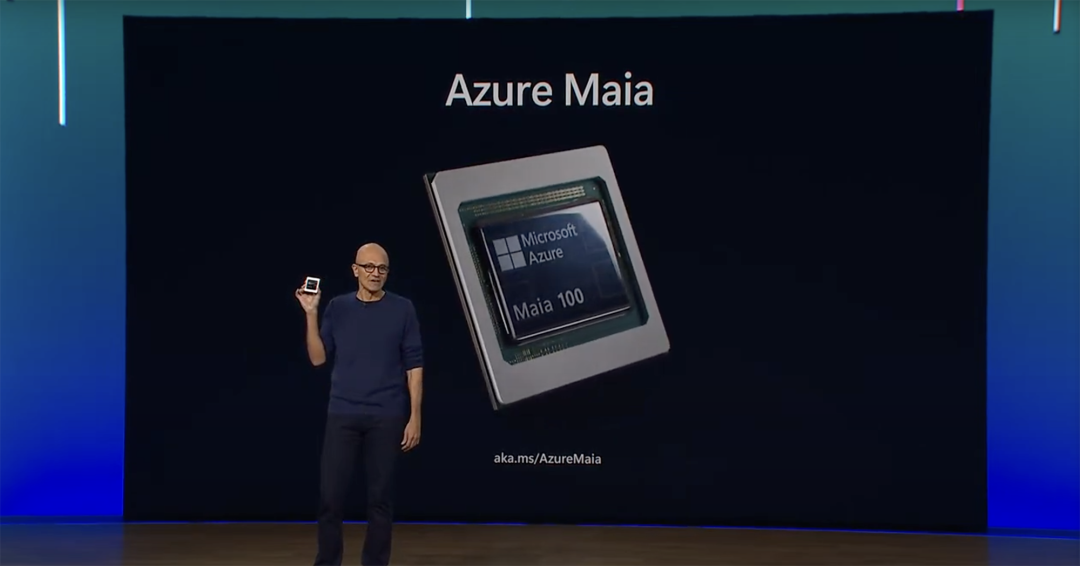

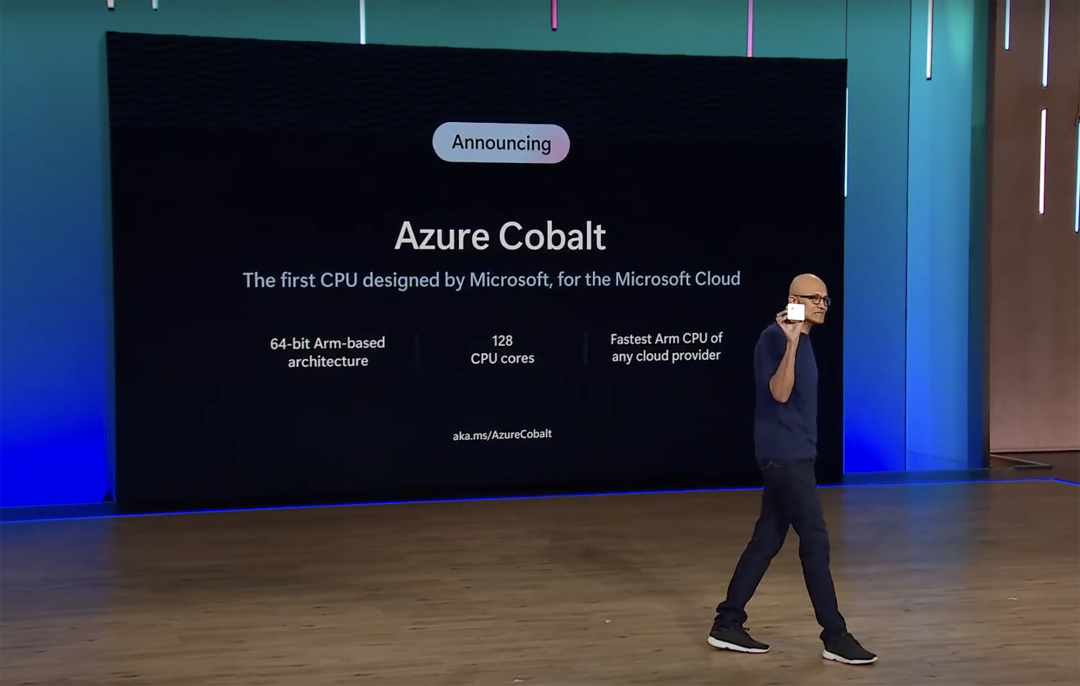

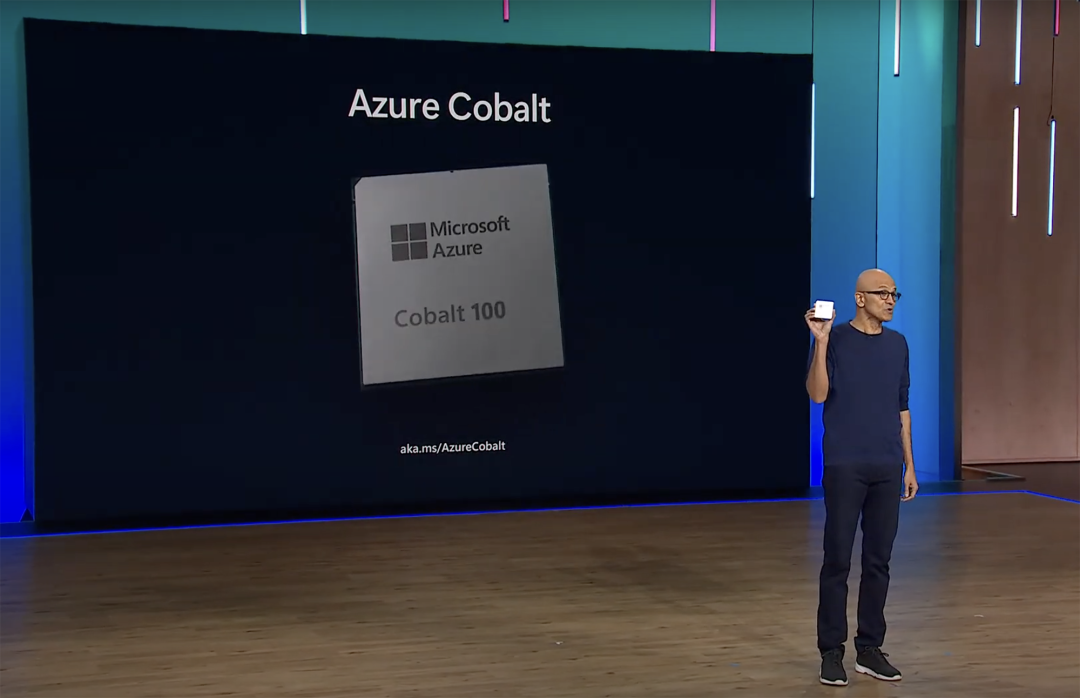

芯東西11月16日報道,今日凌晨,微軟在年度IT專業(yè)人士和開發(fā)者大會Ignite上推出兩款自研芯片——云端AI芯片微軟Azure Maia 100、服務器CPU微軟Azure Cobalt 100。

Maia 100是微軟為微軟云中大語言模型訓練和推理而設計的第一款人工智能(AI)芯片,采用臺積電5nm工藝,擁有1050億顆晶體管,針對AI和生成式AI進行了優(yōu)化,支持微軟首次實現(xiàn)的低于8位數據類型(MX數據類型)。微軟已經在用搜索引擎Bing和Office AI產品測試該芯片。

Cobalt 100是微軟為微軟云定制開發(fā)的第一款CPU,也是微軟打造的第一款完整的液冷服務器CPU,采用Arm Neoverse CSS設計、128核。微軟還定制設計了一個AI端到端機架,并搭配了一個“助手”液冷器,原理類似于汽車散熱器。

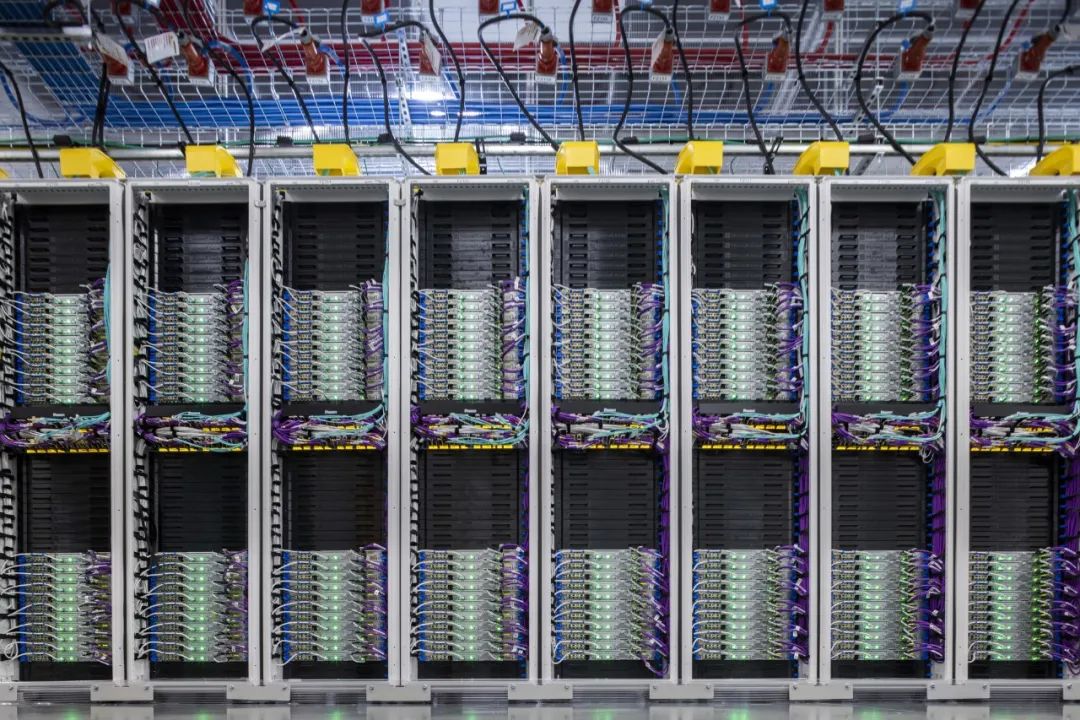

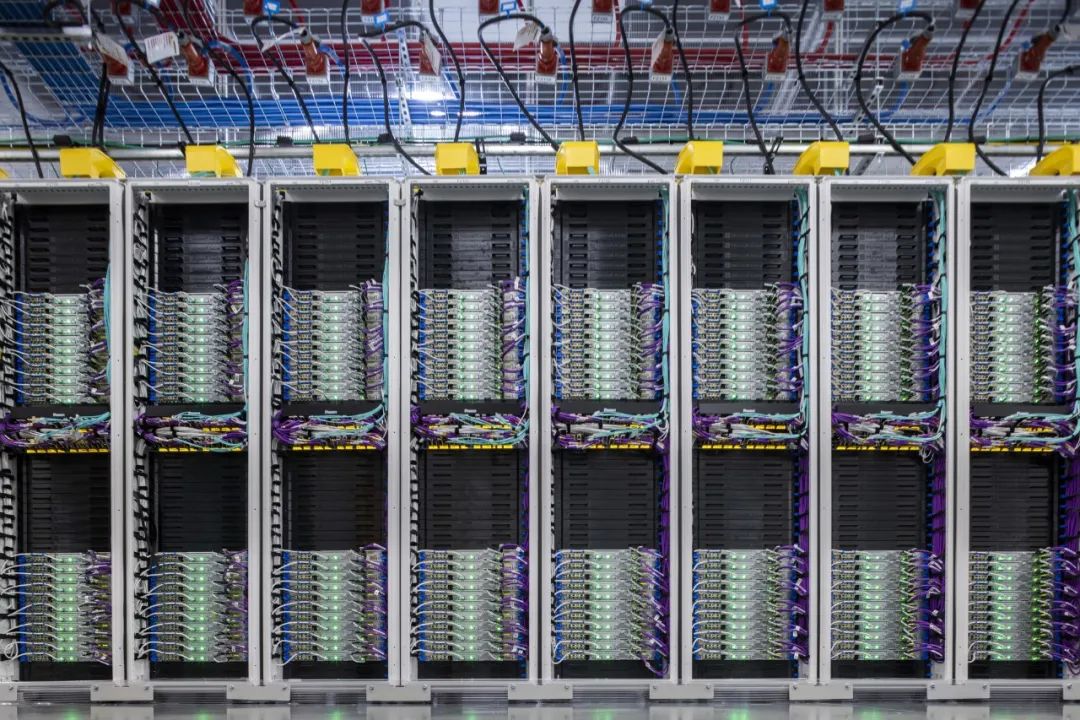

▲微軟現(xiàn)場展示AI端到端機架

兩款芯片明年年初開始在微軟數據中心推出,最初為微軟的Copilot或Azure OpenAI Service等服務提供動力。微軟已經在設計第二代版本的Azure Maia AI芯片和Cobalt CPU系列。

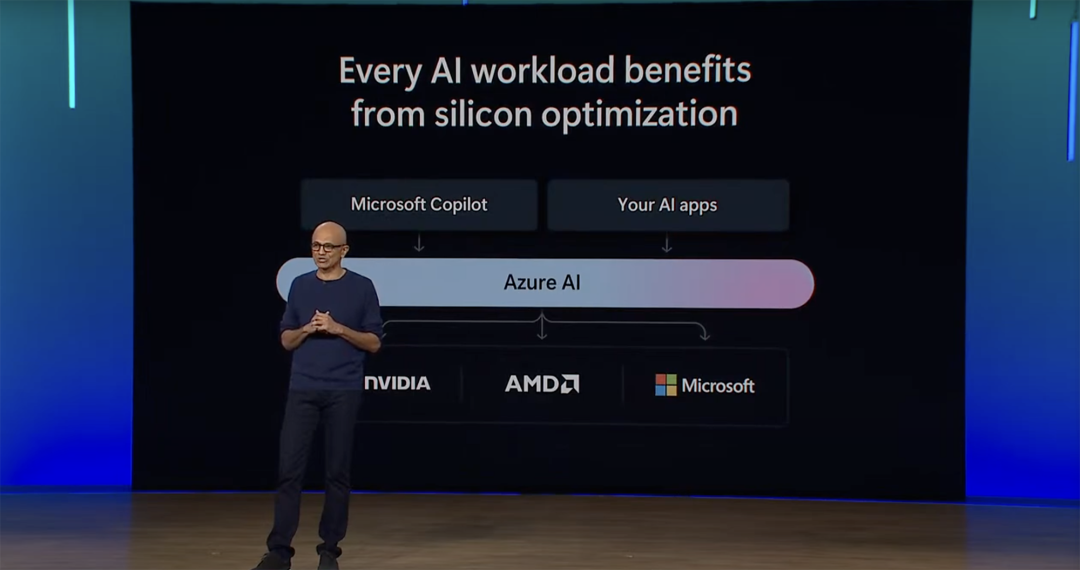

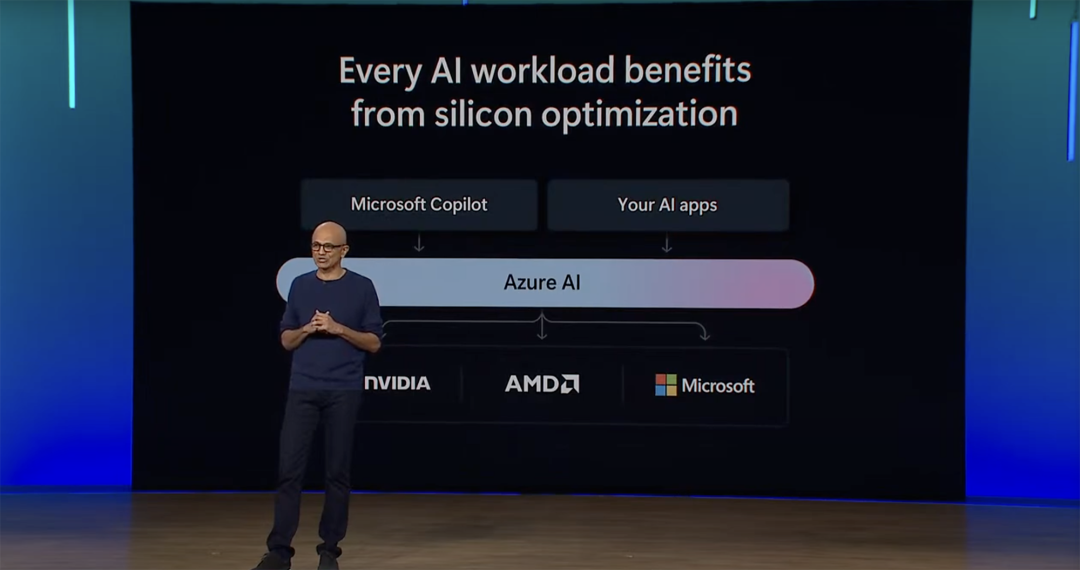

這些芯片代表了微軟交付基礎設施系統(tǒng)的最后一塊拼圖——從芯片、軟件和服務器到機架和冷卻系統(tǒng)的一切,微軟這些系統(tǒng)都是由上到下設計的,可以根據內部和客戶的工作負載進行優(yōu)化。值得一提的是,生成式AI超級獨角獸OpenAI率先試用了Maia 100芯片。該芯片正在GPT-3.5 Turbo上進行測試。OpenAI首席執(zhí)行官Sam Altman說:“當微軟第一次分享他們的Maia芯片設計時,我們很興奮,我們一起努力改進并在我們的模型上測試它。Azure的端到端AI架構現(xiàn)在與Maia一起優(yōu)化到芯片,為訓練更有能力的模型鋪平了道路,并使這些模型對我們的客戶來說更便宜。”除了發(fā)布自研芯片外,微軟宣布將擴大與英偉達、AMD兩家芯片巨頭在AI加速計算方面的合作伙伴關系,為客戶提供更多價格和性能的選擇。

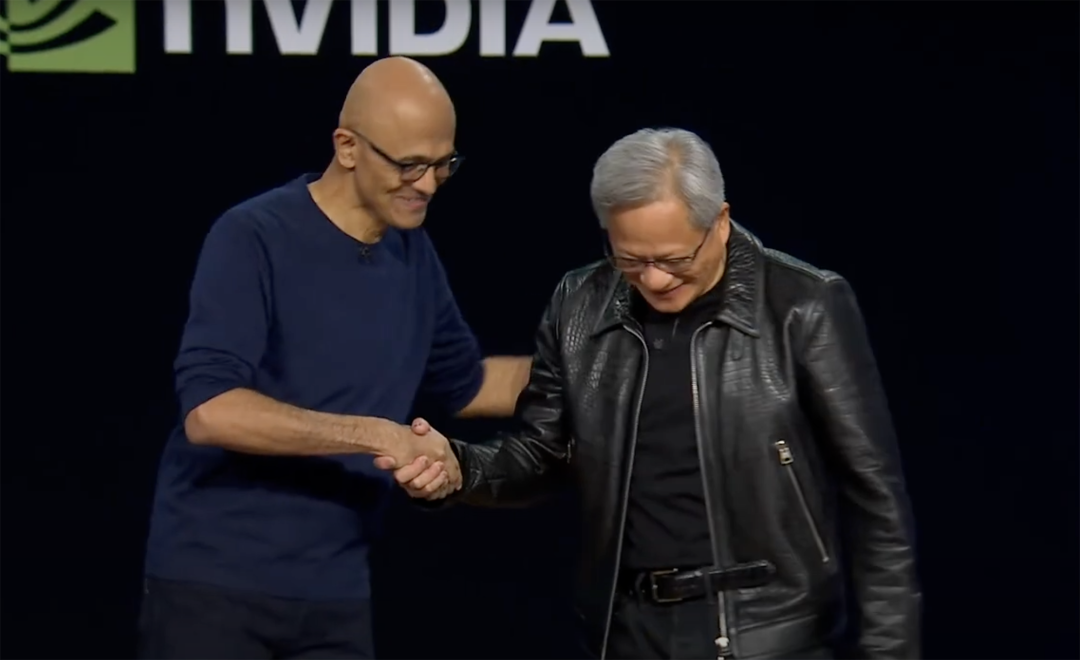

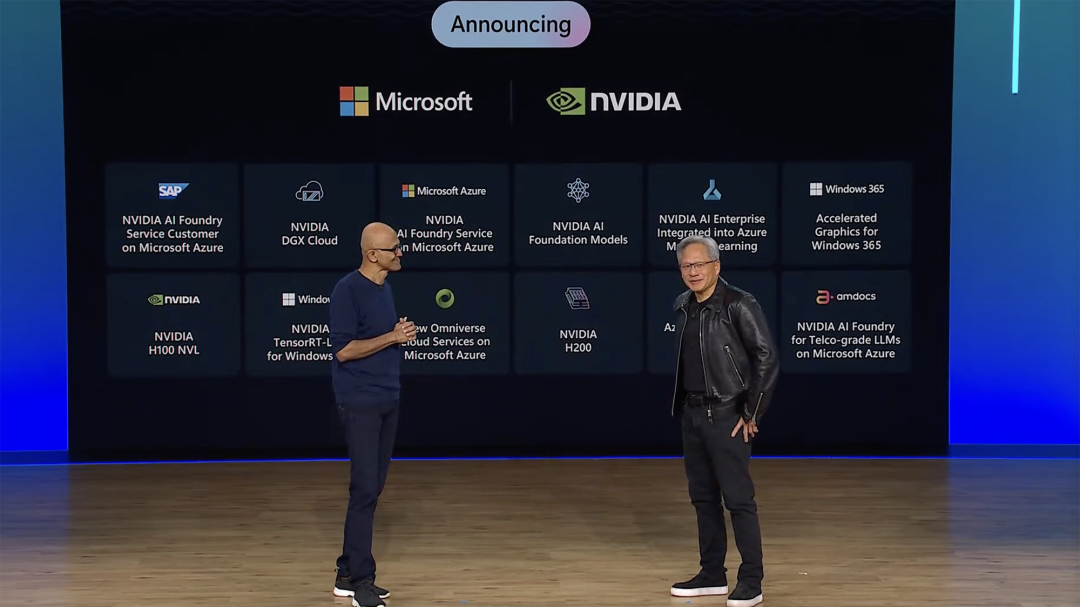

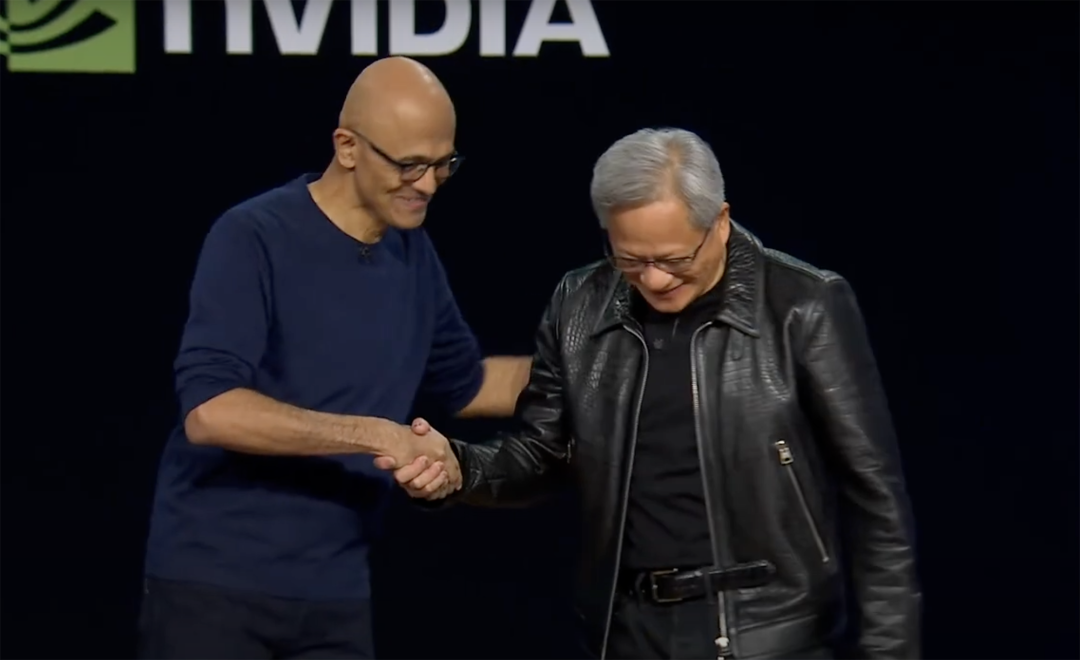

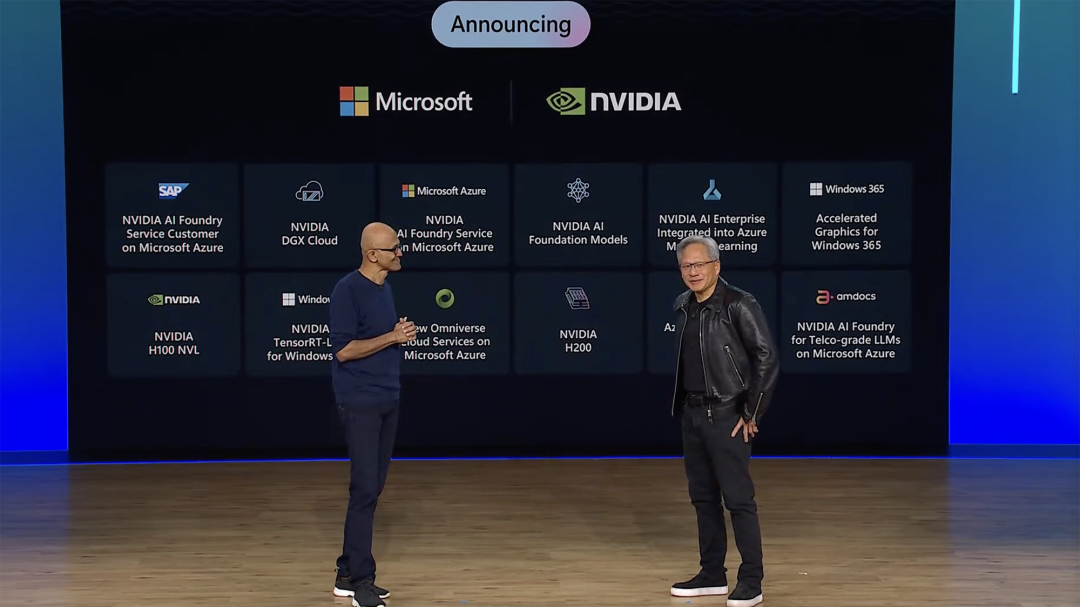

微軟發(fā)布了針對英偉達H100 GPU的全新NC H100 v5虛擬機系列預覽,還將在明年增加最新的英偉達H200 GPU,以支持更大的模型推理;并宣布將在Azure中加入AMD MI300X加速虛擬機,旨在加速AI工作負載處理,用于AI模型訓練和生成式推理。英偉達創(chuàng)始人兼CEO黃仁勛專程來到現(xiàn)場,宣布推出一項AI代工服務,可以幫助部署在微軟Azure上的企業(yè)和初創(chuàng)公司,構建自己的定制大語言模型。

▲納德拉與黃仁勛握手

當微軟CEO納德拉提問未來AI創(chuàng)新的發(fā)展方向是什么,黃仁勛回答說:“生成式AI是計算史上最重要的平臺轉型。在過去40年里,從來沒有發(fā)生過如此大的事情。到目前為止,它比個人電腦更大、比手機更大,而且將比互聯(lián)網更大。”

01.揭秘微軟造芯實驗室:實現(xiàn)最大硬件利用率

微軟的雷德蒙德園區(qū)隱藏著一個實驗室,這里擺滿了探索數字時代的基本組成部分——硅。多年以來,微軟工程師一直通過多步驟過程,對硅進行細致的測試,秘密改進其方法。

▲在微軟雷德蒙德實驗室里,一位系統(tǒng)級測試人員正在模擬芯片在微軟數據中心內的運行情況。這臺機器在真實世界的條件下嚴格評估每個芯片,以確保它符合性能和可靠性標準。(圖源:微軟)

微軟認為增加自研芯片是一種確保每個元素都適合微軟云和AI工作負載的方式。這些芯片將安裝在定制的服務器主板上、放在定制的機架上,隨著機架被安裝到現(xiàn)有的微軟數據中心中。AI芯片微軟Azure Maia 100旨在實現(xiàn)硬件的絕對最大利用率,將為運行在微軟Azure上的一些最大的內部AI工作負載提供動力。

領導Azure Maia團隊的微軟技術人員Brian Harry說,Maia 100專門為Azure硬件堆棧而設計,這種垂直整合——將芯片設計與考慮到微軟工作負載而設計的更大AI基礎設施相結合——可以在性能和效率方面產生巨大的收益。Cobalt 100 CPU是一款128核服務器處理器,采用Arm Neoverse CSS設計構建。據微軟硬件產品開發(fā)副總裁Wes McCulloug分享,這是一種經過優(yōu)化的低功耗芯片設計,可以在云原生產品中提供更高的效率和性能。

選用Arm技術是微軟可持續(xù)發(fā)展目標的一個關鍵因素,其目標是優(yōu)化整個數據中心的“每瓦性能”,這本質上意味著為每單位消耗的能量獲得更多的計算能力。“初步測試表明,我們的性能比現(xiàn)有商用Arm服務器的數據中心性能提高40%。”微軟Azure硬件系統(tǒng)和基礎設施副總裁Rani Borkar說。

▲首批由微軟Azure Cobalt 100 CPU驅動的服務器,位于華盛頓州昆西的一個數據中心內。(圖源:微軟)

“我們正在最有效地利用硅上的晶體管。將我們所有數據中心的服務器的效率提升相乘,這是一個相當大的數字。”McCulloug談道。

02.從2020年開始為云造芯,給AI芯片定制機架和“散熱助手”

雖然微軟為其Xbox和HoloLens設備研發(fā)芯片已有十多年,但它為Azure創(chuàng)建定制芯片的努力從2020年才開始。Azure硬件系統(tǒng)和基礎設施團隊的合作伙伴項目經理Pat Stemen稱,2016年前,微軟云的大多數層都是現(xiàn)成的,隨后微軟開始定制服務器和機架,降低了成本,并為客戶提供了更一致的體驗。隨著時間的推移,硅成了主要的缺失部分。自研定制芯片的測試過程包括確定每個芯片在不同頻率、溫度和功率條件下的峰值性能,更重要的是在微軟真實數據中心的相同條件和配置下測試每個芯片。

▲在微軟雷德蒙德實驗室里,芯片正在進行系統(tǒng)級測試,在安裝到服務器上之前,模擬它們在實際生產條件下的使用情況。(圖源:微軟)

今天公布的芯片架構不僅可以提高冷卻效率,還能優(yōu)化其當前數據中心資產的使用,并在現(xiàn)有范圍內最大限度地提高服務器容量。例如,不存在機架來容納Maia 100服務器主板的獨特需求,所以微軟從零做出更寬的數據中心機架。這種擴展的設計為電源和網絡電纜提供了充足的空間,能滿足AI工作負載的獨特需求。

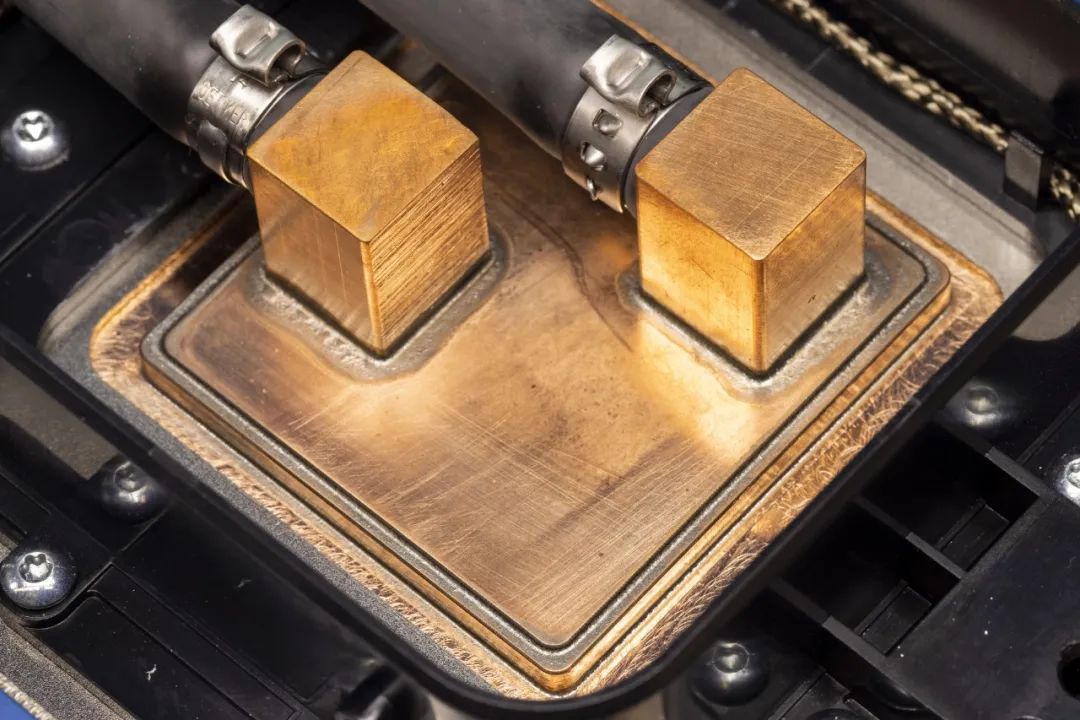

▲在微軟雷德蒙德實驗室的一個熱室里,為Maia 100 AI芯片和它的“伙伴”定制的機架。在處理AI工作負載的計算需求時,新“助手”在機架之間循環(huán)液體來冷卻芯片。(圖源:微軟)

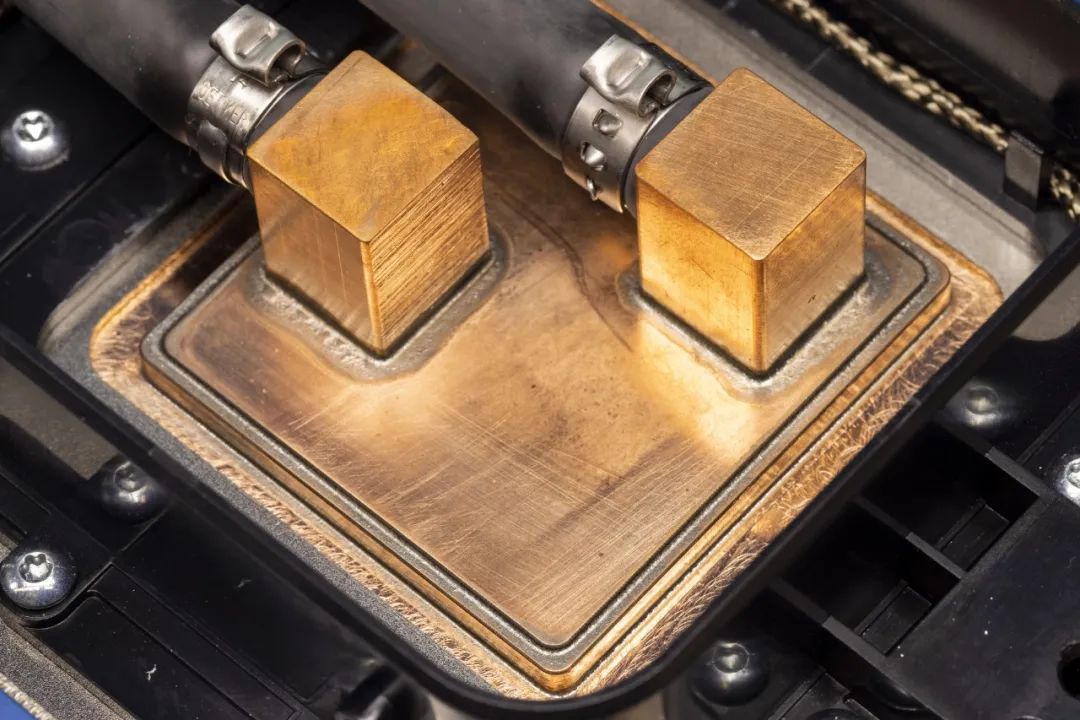

大型AI任務需要大量的計算、消耗更多的電力。傳統(tǒng)空氣冷卻方法無法滿足這些需求,液冷已成為應對這些熱挑戰(zhàn)的首選方案。但微軟目前的數據中心并不是為大型液冷機器設計的。因此它開發(fā)了一個“助手”,放在Maia 100機架旁邊。這些“助手”的工作原理有點像汽車的散熱器。冷液從側板流向附著在Maia 100芯片表面的冷板。每個板都有通道,液體通過這些通道循環(huán)以吸收和輸送熱量。這些熱量會流到副翼,副翼會從液體中去除熱量,并將其送回機架以吸收更多的熱量,以此類推。

▲冷板附著在Maia 100 AI芯片的表面。(圖源:微軟)

McCullough強調說,機架和“助手”的串聯(lián)設計強調了基礎設施系統(tǒng)方法的價值。通過控制每一個方面——從Cobalt 100芯片的低功耗理念到數據中心冷卻的復雜性——微軟可以協(xié)調每個組件之間的和諧相互作用,確保在減少環(huán)境影響方面,整體確實大于各部分的總和。微軟已經與行業(yè)合作伙伴分享了其定制機架的設計經驗,無論內部安裝的是什么芯片,微軟都可以使用這些經驗。“我們建造的所有東西,無論是基礎設施、軟件還是固件,我們都可以利用我們自己的芯片,或是我們行業(yè)合作伙伴的芯片。”McCullough分享道,“這是客戶做出的選擇,我們正努力為他們提供最好的選擇,無論是性能、成本還是他們關心的任何其他方面。”Stemen說,微軟的使命很明確:優(yōu)化其技術堆棧的每一層,從核心芯片到終端服務。“微軟的創(chuàng)新將進一步深入到芯片工作中,以確保我們客戶在Azure上的工作負載的未來,優(yōu)先考慮性能、能效和成本。”他談道,“我們有意選擇這項創(chuàng)新,以便我們的客戶能夠在今天和未來獲得Azure的最佳體驗。”大會期間,微軟還宣布了其中一個關鍵要素的全面可用性——Azure Boost,這是一個將存儲和網絡進程從主機服務器轉移到專用硬件和軟件上的系統(tǒng),有助于加快存儲和網絡的速度。

03.英偉達推出AI代工服務,助攻快速定制生成式AI模型

在微軟Ignite大會上,英偉達也誠意滿滿地公布一項新進展——推出AI代工服務。英偉達創(chuàng)始人兼CEO黃仁勛現(xiàn)場與微軟CEO納德拉進行了11分鐘的對談,分享英偉達與微軟的全面合作。

他談道,生成式AI是計算史上最重要的平臺轉型,由于生成式AI,一切都變了,過去12個月,微軟與英偉達兩個團隊盡一切努力加快速度,聯(lián)手打造了世界上最快的AI超級計算機,這通常需要兩三年,而兩個團隊只用1年就構建了其中的兩個,一個在微軟,一個在英偉達。“我們將為想要構建自己專有大語言模型的人做臺積電為我們做的事情,我們將成為AI模型的代工廠。”黃仁勛說,企業(yè)需要定制模型來執(zhí)行根據公司專有DNA(即數據)進行訓練的專業(yè)技能,該AI代工服務結合了英偉達的生成式AI模型技術、大語言模型訓練專業(yè)知識和巨型AI工廠。AI代工服務能幫助企業(yè)構建跨行業(yè)(包括企業(yè)軟件、電信和媒體)的生成式AI應用定制模型。準備好部署后,企業(yè)可以用檢索增強生成(RAG)技術將其模型與企業(yè)數據連接起來。英偉達在微軟Azure中構建了此功能,以便世界各地的企業(yè)可以將其定制模型與微軟云服務連接起來。

該服務匯集了三要素:英偉達AI基礎模型、英偉達NeMo框架和工具、英偉達DGX Cloud AI超級計算服務的集合,來提供用于創(chuàng)建自定義生成式AI模型的端到端解決方案。然后,企業(yè)可使用英偉達AI Enterprise軟件部署自定義模型,以支持生成式AI應用程序,包括智能搜索、摘要、內容生成。使用英偉達AI代工服務的客戶可以從多個英偉達AI Foundation模型中進行選擇,包括托管在Azure AI模型目錄中的全新英偉達Nemotron-3 8B模型系列。Nemotron-3 8B具有用于構建自定義企業(yè)生成式AI應用的多語言功能。開發(fā)人員還可以訪問英偉達NGC目錄中的Nemotron-3 8B模型以及社區(qū)模型,比如專為英偉達優(yōu)化以加速計算的Meta Llama 2模型。SAP SE、Amdocs、Getty Images等均已使用該服務構建自定義模型。SAP計劃將該服務和優(yōu)化的RAG工作流程與在 Azure上運行的英偉達DGX Cloud和英偉達AI Enterprise發(fā)軟件結合使用,以幫助定制和部署其新的自然語言生成式AI copilot Joule。

04.結語:尚未公布具體芯片參數,如何影響云服務定價有待觀察

可能是因為處于早期部署階段,微軟并沒有發(fā)布具體的芯片參數或性能基準。兩款芯片新品將加入微軟云的底層硬件供應列表中,以幫助滿足對高效、可擴展和可持續(xù)計算能力的爆炸式需求。微軟正在建設持AI創(chuàng)新的基礎設施,并正在重新構想數據中心的各個方面,包括優(yōu)化Azure硬件系統(tǒng)的靈活性、電源、性能、可持續(xù)性、成本,優(yōu)化和整合基礎設施堆棧的每一層,以最大限度地提高性能,使其供應鏈多樣化。自研AI芯片能讓微軟免于過度依賴少數頭部芯片供應商。目前尚存的疑問是微軟將以多快速度將兩款芯片上架,以及這些芯片會如何幫助平衡對生成式AI體驗爆發(fā)的需求,以及將如何影響微軟Azure AI云服務的定價。來源:微軟,The Verge

*博客內容為網友個人發(fā)布,僅代表博主個人觀點,如有侵權請聯(lián)系工作人員刪除。