縱觀整個電子行業,往更高密度的集成電路發展無疑是主流趨勢。相對于邏輯電路追求晶體管密度提升,類似于FLASH NAND這樣的非易失性存儲還需要考慮到電子的穩定保存,單純的提升制造工藝并不能很好的解決所有存儲問題,在穩定保存的前提下追求更高的存儲密度才能確保新技術、新產品可持續發展,存儲單元向上要空間成為順理成章的事情,因此在SLC(Single-Level Cell)之后才有MLC(Multi-Level Cell),TLC(Triple-Level Cell),以及日漸成為主流的QLC(Quad-Lev

關鍵字:

AI推理 QLC NAND Flash

在MWC 25上海期間,英特爾展示了一幅由英特爾銳炫? Pro B系列GPU所驅動的“實時響應、安全高效、成本可控”的邊緣AI圖景。英特爾客戶端計算事業部邊緣計算CTO、高級首席AI工程師張宇博士英特爾客戶端計算事業部邊緣計算CTO、高級首席AI工程師張宇博士在MWC AI終端峰會上指出,邊緣將崛起為AI落地的核心場景,而英特爾精準捕捉和把握這一趨勢,依托包括英特爾銳炫? Pro B系列GPU和英特爾酷睿? Ultra 200H系列處理器在內的創新產品與生態布局,讓AI真正在數據產生之地落地生根。AI的到

關鍵字:

英特爾 銳炫 顯卡 AI推理

AI推論快速成長,QLC NAND Flash成為企業級儲存解決方案的新寵。 相較于傳統的TLC NAND,QLC具備更高存儲密度與更低成本,適合以讀取為主的AI推論工作負載。 法人分析,臺廠如群聯、威剛、宇瞻等存儲器模組廠,有望從中受惠。根據調研機構預測,2025年QLC NAND產能將達250.48億Gb,占NAND總產能的22.2%,滲透率逐步提升。AI推論服務器主要負責分析以及處理大量數據,而這類應用訪問模式以讀取為主,寫入頻率相對較低,正好契合QLC SSD的特性。QLC NAND有更高存儲密度

關鍵字:

AI推理 QLC NAND Flash

根據TrendForce集邦咨詢最新研究,2024年全球AI

服務器(Server)出貨量受惠于CSP、OEM的強勁需求,年增幅度為46%。國際形勢、DeepSeek效應、英偉達GB200/GB300

Rack供應鏈整備進度等將成為影響2025年AI Server出貨量的變量,TrendForce集邦咨詢據此提出三種情境預估。第一種為基礎情境(base

case),研判發生的機率最高。近期Microsoft、Meta、Amazon、Google等主要CSP業者皆宣布,擴大今年對云端或AI基礎設

關鍵字:

AI Server DeepSeek AI推理 TrendForce 集邦咨詢

2024 年秋季,邊緣計算解決方案提供商研華科技推出 AIR-310,這是一款搭載 MXM GPU 卡的緊湊型邊緣人工智能推理系統。AIR-310采用第12/13/14代英特爾酷睿65W處理器,通過NVIDIA Quadro 2000A GPU卡在1.5U高度機箱(215 x 225 x 55毫米)內提供高達12.99 TFLOPS的可擴展AI性能。盡管體積小巧,但它提供了3個 LAN 端口和4個 USB 3.0 端口的多功能連接,可無縫集成用于視覺 AI 應用的傳感器和攝像頭。該系統包括智能風扇管理,工

關鍵字:

研華 AIR-310 AI推理

全球AIoT 平臺與服務供應商研華 (2395, TW) 隆重推出搭載第 13 代 Intel Core 移動處理器的緊湊型邊緣 AI 推理系統 AIR-150。盡管體積小巧(156 x 112 x 60 mm),但它卻擁有 Hailo-8 AI 加速器提供的 26 TOPS AI 計算能力。AIR-150在連接性方面毫不遜色,提供以應用為中心的 I/O,包括 COM、USB、LAN 和 M.2 E-Key,便于無縫擴展和連接外圍設備。它的工作溫度范圍寬達 -20 至 60°C,并符合重工業 IEC 標準

關鍵字:

研華 Hailo-8 AI推理

今日,MLCommons公布針對 60 億參數大語言模型及計算機視覺與自然語言處理模型GPT-J的 MLPerf推理v3.1 性能基準測試結果,其中包括英特爾所提交的基于Habana? Gaudi?2 加速器、第四代英特爾?至強?可擴展處理器,以及英特爾?至強? CPU Max 系列的測試結果。該結果顯示了英特爾在AI推理方面極具競爭力的表現,并進一步加強了其對加速從云到網絡到邊緣再到端的工作負載中大規模部署AI的承諾。英特爾執行副總裁兼數據中心與人工智能事業部總經理Sandra Rivera表示:“正如

關鍵字:

MLCommons 英特爾 AI推理

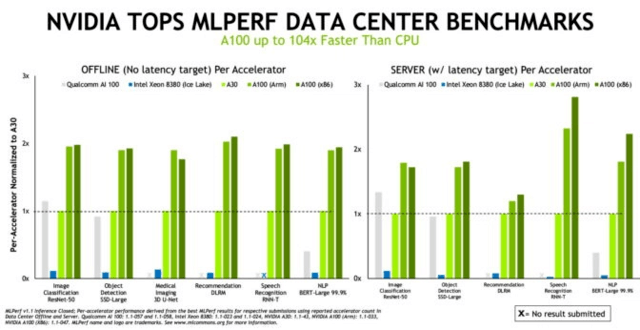

根據近日發布的基準測試結果,NVIDIA在使用x86及Arm CPU進行AI推理時取得了最佳成績。這是NVIDIA連續第三次在MLCommons推理測試中創造性能和能效紀錄。MLCommons是一家成立于2018年5月的行業基準測試組織。 這場測試是第一次在Arm系統上進行數據中心類別的測試,這使用戶在部署AI這一目前最具變革性的技術時有了更多的選擇。 領先的性能 在最新一輪測試中,由N

關鍵字:

NVIDIA AI推理 Arm服務器

研華推出兩款搭載第十代 Intel Core 處理器的創新型工業主板,即AIMB-277和AIMB-287主板,分別采用Mini-ITX和Thin Mini-ITX尺寸設計,可將工廠自動化、醫療和自助服務應用中的AI解決方案的整點運算能力提升31%。NvMEx4出色性能 增強AI性能研華AIMB-277/287工業主板支持10核,最高可達64GB的DDR4-2933 MHz,并運用M.2 M key NVMe x4來適應極高的數據速率和嚴苛要求的密集型AI加速推理運算應用。多種認證滿足不同工業環境要求研華

關鍵字:

研華 工業主板 AI推理 工業自動化 醫療 自助服務 AIMB-277 AIMB-287

ai推理介紹

您好,目前還沒有人創建詞條ai推理!

歡迎您創建該詞條,闡述對ai推理的理解,并與今后在此搜索ai推理的朋友們分享。

創建詞條

關于我們 -

廣告服務 -

企業會員服務 -

網站地圖 -

聯系我們 -

征稿 -

友情鏈接 -

手機EEPW

Copyright ?2000-2015 ELECTRONIC ENGINEERING & PRODUCT WORLD. All rights reserved.

《電子產品世界》雜志社 版權所有 北京東曉國際技術信息咨詢有限公司

京ICP備12027778號-2 北京市公安局備案:1101082052 京公網安備11010802012473