麻省理工最新研究:血虐人類玩家的RL智能體,在紙牌游戲中從最強對手變成“豬隊友”

以下文章來源于AI科技評論 ,作者青暮、眉釘

諸如《星際爭霸》等復雜游戲,是AI模擬現實的絕佳場景。

如果AI在復雜的環境中,學會和人一樣實時感知、分析、理解、推理、決策并行動,那么就可能在多變、復雜的現實環境中發揮更大的作用。

近年來,從國際象棋、德州****到《星際爭霸》,基于強化學習(reinforcement learning )算法的AI智能體早已達到人類頂級玩家水平。如DeepMind出品的AlphaStar早已在國際排位賽中達到宗師水平,完敗99.8%的人類。

但在這些游戲中,AI與人類都表現為”對抗關系”

如果讓AI與人類“配合”打游戲,強化學習智能體能成為一個“好隊友”嗎?

最近,麻省理工林肯實驗室研究團隊在arXiv提交了一篇新論文《Evaluation of Human-AI Teams for Learned and Rule-Based Agents in Hanabi》,論文表明,盡管強化學習智能體在Go、星際爭霸等競爭性游戲表現相當優異,但它們與人類合作玩游戲時,在簡單的紙牌游戲中表現都很“糟糕”。

論文地址:https://arxiv.org/pdf/2107.07630.pdf

在這項研究中,研究團隊評估了基于規則和基于學習的兩類AI智能體,在紙牌游戲(Hanabi)中與人類合作的表現,通過游戲分數、團隊績效、可解釋性、信任度和總體偏好等指標測量,他們發現,在幾乎所有主觀指標中,人類對基于規則的智能體隊友的“好感”明顯高于基于學習的智能體,而且對后者大多持負面評價。

作者表示,雖然強化學習智能體在對抗性游戲中創造了超人AI,但人類不該理所當然地認為RL系統在所有應用中都能表現優越,在目前的技術水平下,基于學習的智能體要想成為人機互動的最佳“隊友”并不那么容易。

同時,論文中也強調雖然最終游戲得分幾乎沒有差別,但我們應該將主觀評價納入智能體的的考核標準,而不是單一地關注客觀任務績效。

1、RL智能在“人機合作”中有多菜?

強化學習(reinforcement learning)是訓練AI智能體最常用的算法,它為智能體在游戲場景中提供了更靈活的動作,接收環境信息的反饋機制以及作戰目標,如今基于強化學習的智能體已經不再需要人類玩家的游戲數據,而是可以在自我游戲模式下從頭開始訓練。

在棋盤游戲、街機游戲、實時戰略游戲、多人作戰以及模擬空中格斗等游戲中,RL智能體的表現已經達到了人類玩家的水平,甚至碾壓頂級職業玩家。一個典型的例子是在AlphaGo與頂級圍棋選手李世石的對戰賽中,智能體憑借一步精絕之棋,扭轉局面首戰人類!

然而,RL智能體在以上游戲中的優勢都是在純粹的對抗性、單人或雙人游戲中進行的。要想將智能體的AI能力擴展到現實世界,還必須能夠展示團隊智能,特別是與人類隊友合作的團隊智能。

論文作者Ross Allen表示,現實世界中的復雜性、不確定性、數據稀缺性以及決策周期和目標定位都是智能體面臨的難題。盡管如此,智能體依然需要與人類協作,解決現實世界中深度學習應用的技術壁壘。

需要強調的是,不同于智能體之間的協作,要想與人類達成有效合作,AI隊友需要表現出適當水平的人類反應,比如信任、精神負荷和風險感知等。考慮本次研究目的是評估在不完全信息博弈中的人工智能團隊的合作,不僅要考慮到人類AI團隊的客觀表現,而且考慮到不同類型的人工智能隊友工作時的主觀人類反應和偏好。

在諸多游戲中,研究人員最終挑選了紙牌游戲Hanabi(花火)用于實驗。紙牌游戲規則簡單,又需要在限信息內充分發揮合作優勢。Allen表示,“在解決現實世界中的問題時,最好從簡單的做法開始做起” 。近年來,很多研究團隊基于Hanabi游戲開發智能體,其中部分智能體是基于符號AI,部分使用強化學習。

Hanabi需要兩到五名玩家按照特定的順序合作玩牌,玩家們向后舉牌,相互不能面對面,但每個隊員都可以看到彼此卡片。玩家可以使用有限數量的令牌來提供卡片線索,但只能利用從隊友手中看到的信息和自己手上的有限線索來制定取勝策略。

作者采取了三種游戲模式:一是自我游戲,即智能體用自己的副本參與游戲 ;二是交叉游戲,智能體需要與其他類型的智能體合作 ;三是與人類合作玩游戲,也就是交叉游戲。Allen表示,與人類的交叉游戲(也稱為人類游戲)尤其重要,它衡量了人機合作,也是論文中實驗的基礎。

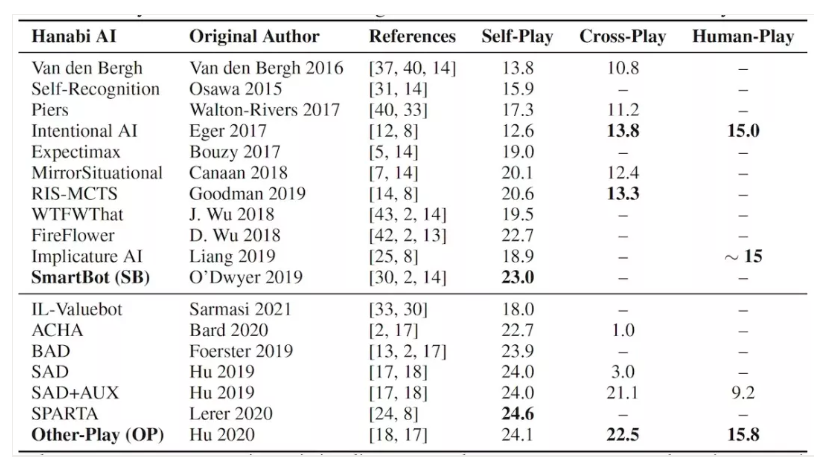

為了測試人類與人工智能合作的效率,作者選擇了目前性能最佳的兩款智能體SmartBot(SB)和Other-Play(OP),前者是在自我游戲中表現最佳且基于規則的人工智能系統,后者是在交叉游戲中排名最高的基于學習的人工智能系統。

在人類與AI隊友的Hanabi游戲中,玩家可以同時接觸到SmartBot和Other-Play,但不會知道是具體是哪種算法在運作。Allen表示結果令我們大吃一驚,“人類對基于學習的智能體合作評價非常負面,可以說他們討厭與它合作”。

根據對人類參與者的調研,與基于規則的SmartBot智能體相比,基于學習的Other-Play在體驗感上更差一些。在紙牌游戲中,向其他玩家提供"微妙暗示"的技巧是團隊取勝的關鍵之一。比如,桌子上有一張“方塊之一”牌,你的隊友手里拿著兩個方塊。通過指著牌說“ 這是一個2 ”或“這是一個正方形”,你隱隱地暗示隊友打出這張牌,但沒有向他提供這張牌的完整信息,如果是有經驗的玩家就會立即頓悟,但如果是向AI隊友提供這樣的信息,不會得到任何反饋。

2、基于“規則”的智能體表現更好

研究人員從客觀和主觀兩方面評價了人工智能的合作水平。客觀指標包括分數、錯誤率等;主觀指標包括人類玩家的體驗:對AI隊友的信任度和適應度,以及AI理解動機和預測行為的能力。

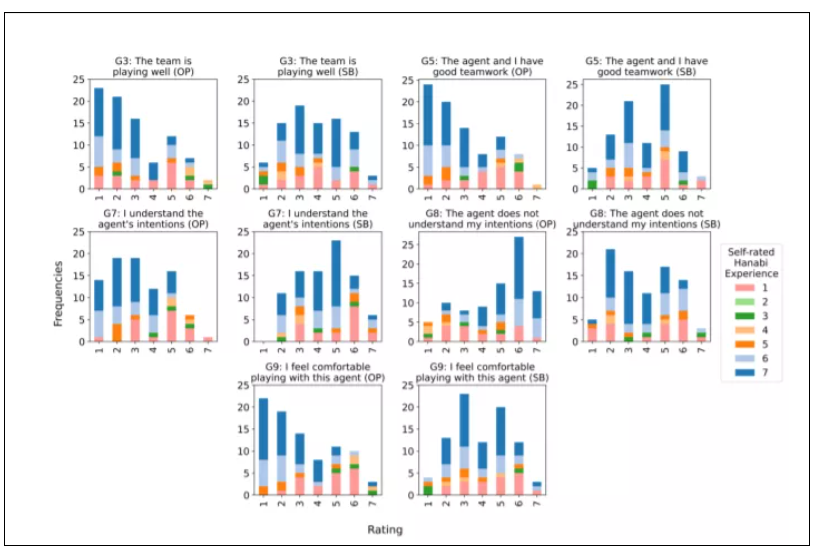

實驗的結果表明,盡管兩個智能體的合作在客觀績效方面沒有顯著差異,但主觀指標顯示,與基于學習的代理相比,人類明顯更喜歡基于規則的智能體。在論文中,作者對大多數圖進行了著色,以顯示與數據相關的參與者的自我評價和體驗水平。

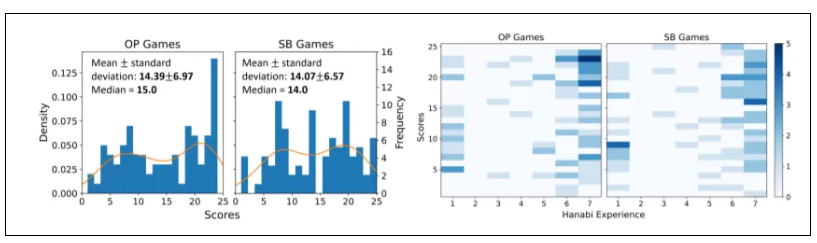

如下圖顯示了智能體類型(左)和自評玩家體驗(右)的游戲分數,可以看出,當與任一智能體合作時,未發現顯著差異,與自評體驗的相關性僅在SmartBot游戲中顯著。

由于分數是紙牌游戲的主要性能指標,也是RL智能體的獎勵函數,因此作者研究了分數與其他一些相關性。結果顯示自評經驗和得分在匯集兩位智能體的游戲時,呈現顯著的正相關(p=0.0053,r=0.214)。SB智能體在游戲子集的相關性仍然顯著(p=0.0023,r=0.247),但OP智能體的游戲相關性不顯著(p=0.0867,r=0.1881),這表明對于該雙變量分析來說,經驗僅與SB的得分相關,而與OP無關。

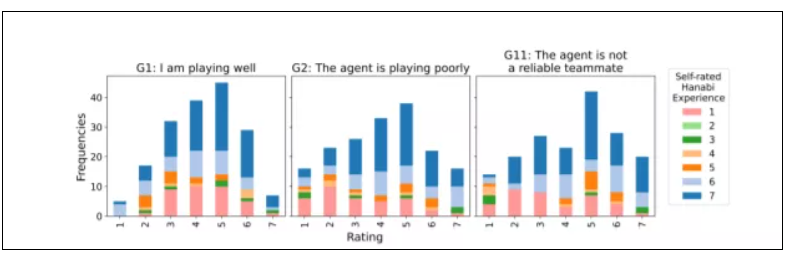

此外,團隊績效(G3、G4)和得分(p=0.0003,r=0.275和p=0.0002,r=0.280)之間也發現了顯著的正相關。但智能體的自我績效(G1、G2)與得分沒有顯著相關性。

下圖為人類玩家賽后對智能體表現的情緒測量,在所有智能體類型與紙牌游戲交互充分的情況下,經驗更豐富的人類玩家對Other-Play智能體的評價要比SmartBot負面得多,而新手玩家對這兩個智能體的評價相似,SmartBot代理的新手和專家評分之間沒有顯著差異。

在實驗分析中,作者將參與者分為“新手”(n=10,自評經驗≤ 5) 和“專家”(n=19,自評經驗>5)兩組,并在交互作用顯著的情況下(G3、G5、G7、G8、G9),對每種參與者的感受指標進行比較。

實驗顯示,兩組對某人的評價沒有顯著差異,但專家們對OP的評價總是比新手差。G3“團隊表現良好”(t(85)=3.551,p<0.001,效應大小d=0.752)的評價差異沒有其他組(t(85)=5.068到5.855,p<0.0001,| d |>1.0)的大,但所有組都很顯著。

可以注意到,有三名參與者在OP中獲得24分,其中一名參與者兩次獲得24分(沒有參與者在OP中獲得25分)。對于問題E1,三人的評價都在Likert量表的最末端回答,并傾向于選擇SB。

有趣的是,他們對OP和SB的累積分數分別為:參與者6(先玩OP,自評經驗為7):57和28;參與者19(SB優先,經驗7):68和48;參與者20(OP優先,體驗6):70和35。其中,累積分數最高的參與者的分數分別為68(OP)和54(SB),并且首選Likert評分為6的SB。

參與者評論指出,與OP合作時的低腦力負荷通常是由于對智能體感到沮喪并放棄與它合作而造成的。例如,在OP智能體未能根據人類發出的幾條提示采取行動(“我給了它信息,它卻把它扔掉了,不知道該如何與智能體合作”)。

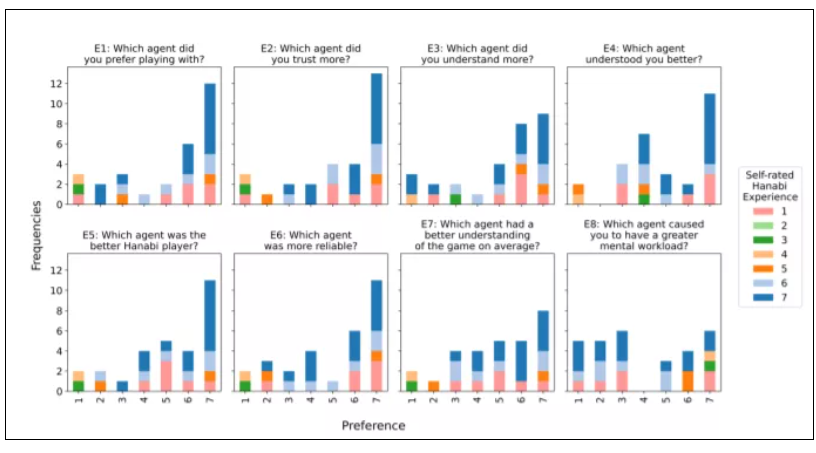

此外,在下圖的實驗后的問題測量圖中,除E8外,所有人對基于規則的智能機器人都表現出統計上的顯著偏好(p<0.05)。

3、強化學習與現實世界的距離

這項研究測量了人類與智能體混合團隊在紙牌游戲Hanabi中的游戲性能和反應,比較了人類與基于規則的智能體協作和與基于強化學習的智能體協作的結果。盡管在這些團隊之間取得了相似的分數,但人類玩家強烈傾向于與基于規則的智能體合作,并且對另一個游戲代理持否定態度,理由是人類玩家對后者的理解、信任、適應度和感知能力體驗較差。

智能體與人類合作的能力是決定它們是否能夠在部署到現實世界的一個重要因素。這些結果表明,即使是最先進的RL智能體在很大程度上也無法讓人類相信它們是”好隊友”。

研究表明,智能體在’自我游戲’和‘交叉游戲’中的任務表現,可能與人類的信任和偏好無關。考慮到訓練基于RL的智能體需要大量數據,作者認為,想要訓練能夠與人類搭檔的RL智能體,需要找到可訓練的目標函數,即符合“人類偏好”,或與人類偏好密切相關的目標。

論文中也強調,這項研究結果無法推演到其他環境、游戲或領域中,實驗不可避免地存在一些局限性,比如受試者數量較少(29名參與者),且傾向于精通紙牌游戲的人——他們對AI隊友有預先設定的行為期望,更有可能因為RL智能體的古怪行為而產生負面體驗。

但作者在論文中也表示, “如果最先進的 RL 智能體都不能在規則簡單的紙牌游戲中成為優秀的協作者,當相同的強化學習技術應用在更復雜、更微妙、后果導向性更強的現實世界又會如何?毫無疑問,如果要在真實世界中采用強化學習智能體,人類對AI的感知在未來AI設計和開發中需要得到更多的考慮。

原文鏈接:

https://bdtechtalks.com/2021/11/01/reinforcement-learning-hanabi/

*博客內容為網友個人發布,僅代表博主個人觀點,如有侵權請聯系工作人員刪除。