機(jī)器學(xué)習(xí)的基礎(chǔ)圖表!(2)

三、機(jī)器學(xué)習(xí)的算法

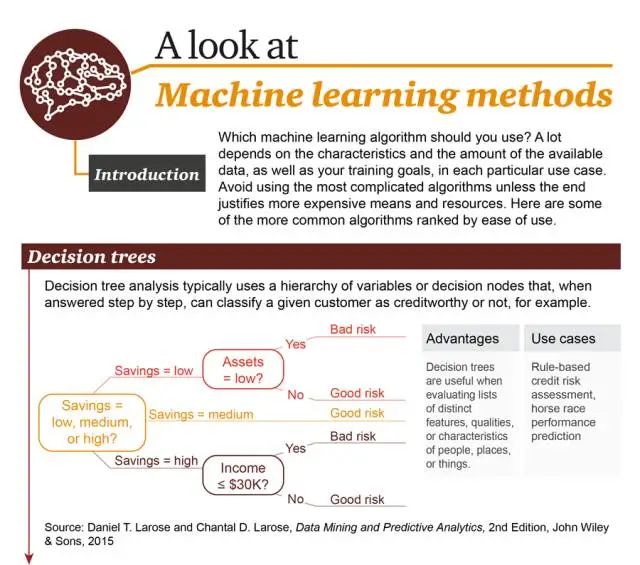

你應(yīng)該使用哪種機(jī)器學(xué)習(xí)算法?這在很大程度上依賴于可用數(shù)據(jù)的性質(zhì)和數(shù)量以及每一個(gè)特定用例中你的訓(xùn)練目標(biāo)。不要使用最復(fù)雜的算法,除非其結(jié)果值得付出昂貴的開銷和資源。這里給出了一些最常見的算法,按使用簡單程度排序。

1. 決策樹(Decision Tree):在進(jìn)行逐步應(yīng)答過程中,典型的決策樹分析會(huì)使用分層變量或決策節(jié)點(diǎn),例如,可將一個(gè)給定用戶分類成信用可靠或不可靠。

優(yōu)點(diǎn):擅長對人、地點(diǎn)、事物的一系列不同特征、品質(zhì)、特性進(jìn)行評估

場景舉例:基于規(guī)則的信用評估、賽馬結(jié)果預(yù)測

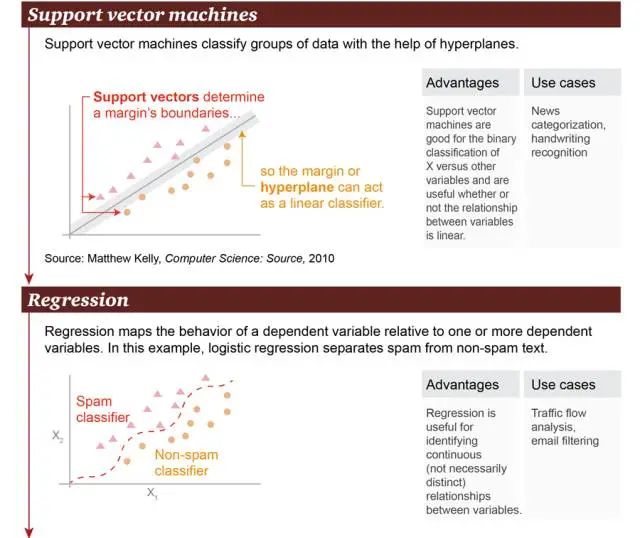

2. 支持向量機(jī)(Support Vector Machine):基于超平面(hyperplane),支持向量機(jī)可以對數(shù)據(jù)群進(jìn)行分類。

優(yōu)點(diǎn):支持向量機(jī)擅長在變量 X 與其它變量之間進(jìn)行二元分類操作,無論其關(guān)系是否是線性的

場景舉例:新聞分類、手寫識別。

3. 回歸(Regression):回歸可以勾畫出因變量與一個(gè)或多個(gè)因變量之間的狀態(tài)關(guān)系。在這個(gè)例子中,將垃圾郵件和非垃圾郵件進(jìn)行了區(qū)分。

優(yōu)點(diǎn):回歸可用于識別變量之間的連續(xù)關(guān)系,即便這個(gè)關(guān)系不是非常明顯

場景舉例:路面交通流量分析、郵件過濾

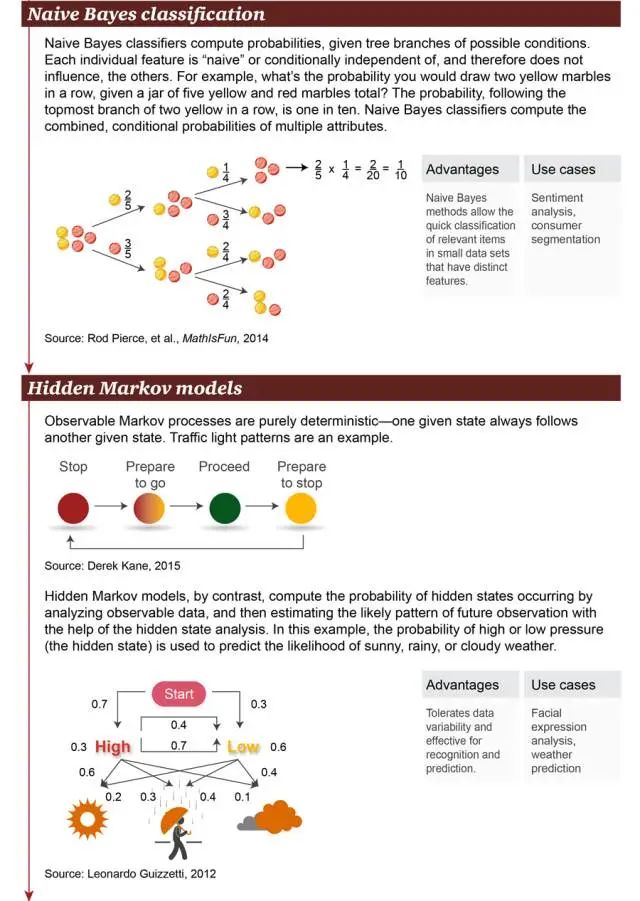

4. 樸素貝葉斯分類(Naive Bayes Classification):樸素貝葉斯分類器用于計(jì)算可能條件的分支概率。每個(gè)獨(dú)立的特征都是「樸素」或條件獨(dú)立的,因此它們不會(huì)影響別的對象。例如,在一個(gè)裝有共 5 個(gè)黃色和紅色小球的罐子里,連續(xù)拿到兩個(gè)黃色小球的概率是多少?從圖中最上方分支可見,前后抓取兩個(gè)黃色小球的概率為 1/10。樸素貝葉斯分類器可以計(jì)算多個(gè)特征的聯(lián)合條件概率。

優(yōu)點(diǎn):對于在小數(shù)據(jù)集上有顯著特征的相關(guān)對象,樸素貝葉斯方法可對其進(jìn)行快速分類

場景舉例:情感分析、消費(fèi)者分類

5. 隱馬爾可夫模型(Hidden Markov model):顯馬爾可夫過程是完全確定性的——一個(gè)給定的狀態(tài)經(jīng)常會(huì)伴隨另一個(gè)狀態(tài)。交通信號燈就是一個(gè)例子。相反,隱馬爾可夫模型通過分析可見數(shù)據(jù)來計(jì)算隱藏狀態(tài)的發(fā)生。隨后,借助隱藏狀態(tài)分析,隱馬爾可夫模型可以估計(jì)可能的未來觀察模式。在本例中,高或低氣壓的概率(這是隱藏狀態(tài))可用于預(yù)測晴天、雨天、多云天的概率。

優(yōu)點(diǎn):容許數(shù)據(jù)的變化性,適用于識別(recognition)和預(yù)測操作

場景舉例:面部表情分析、氣象預(yù)測

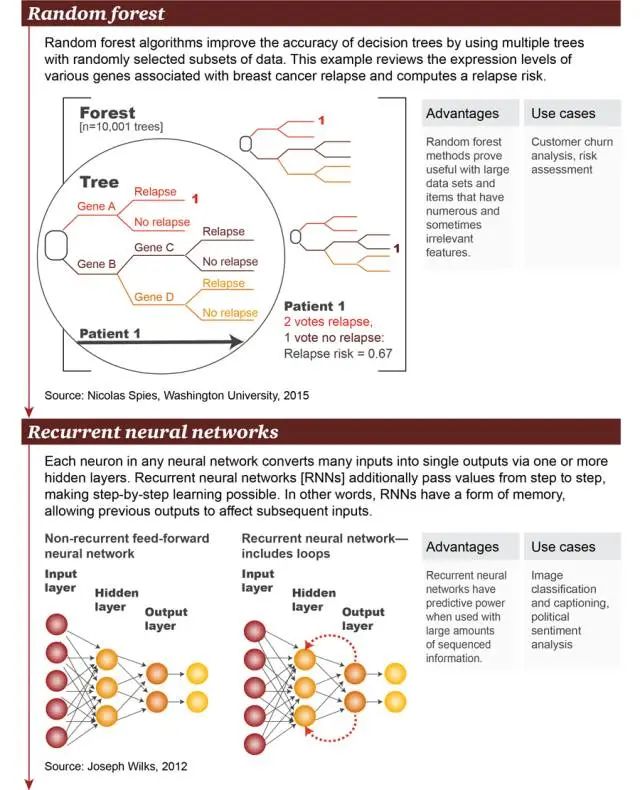

6. 隨機(jī)森林(Random forest):隨機(jī)森林算法通過使用多個(gè)帶有隨機(jī)選取的數(shù)據(jù)子集的樹(tree)改善了決策樹的精確性。本例在基因表達(dá)層面上考察了大量與乳腺癌復(fù)發(fā)相關(guān)的基因,并計(jì)算出復(fù)發(fā)風(fēng)險(xiǎn)。

優(yōu)點(diǎn):隨機(jī)森林方法被證明對大規(guī)模數(shù)據(jù)集和存在大量且有時(shí)不相關(guān)特征的項(xiàng)(item)來說很有用

場景舉例:用戶流失分析、風(fēng)險(xiǎn)評估

7. 循環(huán)神經(jīng)網(wǎng)絡(luò)(Recurrent neural network):在任意神經(jīng)網(wǎng)絡(luò)中,每個(gè)神經(jīng)元都通過 1 個(gè)或多個(gè)隱藏層來將很多輸入轉(zhuǎn)換成單個(gè)輸出。循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)會(huì)將值進(jìn)一步逐層傳遞,讓逐層學(xué)習(xí)成為可能。換句話說,RNN 存在某種形式的記憶,允許先前的輸出去影響后面的輸入。

優(yōu)點(diǎn):循環(huán)神經(jīng)網(wǎng)絡(luò)在存在大量有序信息時(shí)具有預(yù)測能力

場景舉例:圖像分類與字幕添加、政治情感分析

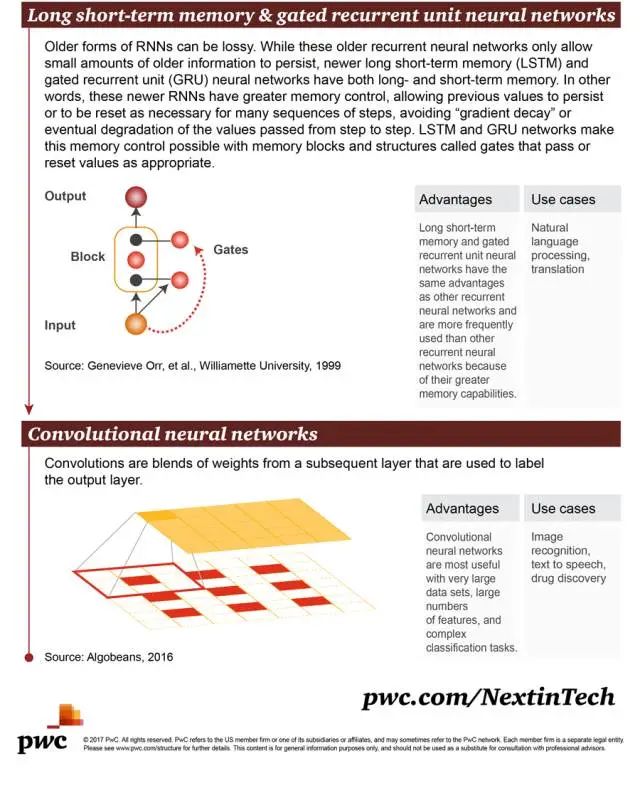

8. 長短期記憶(Long short-term memory,LSTM)與門控循環(huán)單元神經(jīng)網(wǎng)絡(luò)(gated recurrent unit nerual network):早期的 RNN 形式是會(huì)存在損耗的。盡管這些早期循環(huán)神經(jīng)網(wǎng)絡(luò)只允許留存少量的早期信息,新近的長短期記憶(LSTM)與門控循環(huán)單元(GRU)神經(jīng)網(wǎng)絡(luò)都有長期與短期的記憶。換句話說,這些新近的 RNN 擁有更好的控制記憶的能力,允許保留早先的值或是當(dāng)有必要處理很多系列步驟時(shí)重置這些值,這避免了「梯度衰減」或逐層傳遞的值的最終 degradation。LSTM 與 GRU 網(wǎng)絡(luò)使得我們可以使用被稱為「門(gate)」的記憶模塊或結(jié)構(gòu)來控制記憶,這種門可以在合適的時(shí)候傳遞或重置值。

優(yōu)點(diǎn):長短期記憶和門控循環(huán)單元神經(jīng)網(wǎng)絡(luò)具備與其它循環(huán)神經(jīng)網(wǎng)絡(luò)一樣的優(yōu)點(diǎn),但因?yàn)樗鼈冇懈玫挠洃浤芰Γ愿1皇褂?/p>

場景舉例:自然語言處理、翻譯

9. 卷積神經(jīng)網(wǎng)絡(luò)(convolutional neural network):卷積是指來自后續(xù)層的權(quán)重的融合,可用于標(biāo)記輸出層。

優(yōu)點(diǎn):當(dāng)存在非常大型的數(shù)據(jù)集、大量特征和復(fù)雜的分類任務(wù)時(shí),卷積神經(jīng)網(wǎng)絡(luò)是非常有用的

場景舉例:圖像識別、文本轉(zhuǎn)語音、****物發(fā)現(xiàn)

編輯:于騰凱

校對:汪雨晴

*博客內(nèi)容為網(wǎng)友個(gè)人發(fā)布,僅代表博主個(gè)人觀點(diǎn),如有侵權(quán)請聯(lián)系工作人員刪除。